第三十七章:奇珍异宝

最后更新于:2022-04-02 01:46:31

在我们 bash 学习旅程中的最后一站,我们将看一些零星的知识点。当然我们在之前的章节中已经 涵盖了很多方面,但是还有许多 bash 特性我们没有涉及到。其中大部分特性相当晦涩,主要对 那些把 bash 集成到 Linux 发行版的程序有用处。然而还有一些特性,虽然不常用, 但是对某些程序问题是很有帮助的。我们将在这里介绍它们。

## 组命令和子 shell

bash 允许把命令组合在一起。可以通过两种方式完成;要么用一个 group 命令,要么用一个子 shell。 这里是每种方式的语法示例:

组命令:

~~~

{ command1; command2; [command3; ...] }

~~~

子 shell:

~~~

(command1; command2; [command3;...])

~~~

这两种形式的不同之处在于,组命令用花括号把它的命令包裹起来,而子 shell 用括号。值得注意的是,鉴于 bash 实现组命令的方式, 花括号与命令之间必须有一个空格,并且最后一个命令必须用一个分号或者一个换行符终止。

那么组命令和子 shell 命令对什么有好处呢? 尽管它们有一个很重要的差异(我们马上会接触到),但它们都是用来管理重定向的。 让我们考虑一个对多个命令执行重定向的脚本片段。

~~~

ls -l > output.txt

echo "Listing of foo.txt" >> output.txt

cat foo.txt >> output.txt

~~~

这些代码相当简洁明了。三个命令的输出都重定向到一个名为 output.txt 的文件中。 使用一个组命令,我们可以重新编 写这些代码,如下所示:

~~~

{ ls -l; echo "Listing of foo.txt"; cat foo.txt; } > output.txt

~~~

使用一个子 shell 是相似的:

~~~

(ls -l; echo "Listing of foo.txt"; cat foo.txt) > output.txt

~~~

使用这样的技术,我们为我们自己节省了一些打字时间,但是组命令和子 shell 真正闪光的地方是与管道线相结合。 当构建一个管道线命令的时候,通常把几个命令的输出结果合并成一个流是很有用的。 组命令和子 shell 使这种操作变得很简单:

~~~

{ ls -l; echo "Listing of foo.txt"; cat foo.txt; } | lpr

~~~

这里我们已经把我们的三个命令的输出结果合并在一起,并把它们用管道输送给命令 lpr 的输入,以便产生一个打印报告。

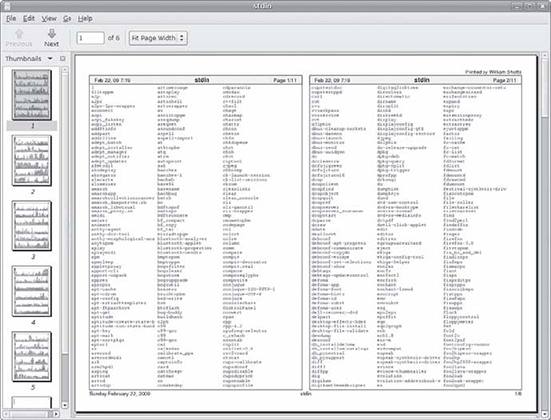

在下面的脚本中,我们将使用组命令,看几个与关联数组结合使用的编程技巧。这个脚本,称为 array-2,当给定一个目录名,打印出目录中的文件列表, 伴随着每个文件的文件所有者和组所有者。在文件列表的末尾,脚本打印出属于每个所有者和组的文件数目。 这里我们看到的结果(缩短的,为简单起见),是给定脚本的目录为 /usr/bin 的时候:

~~~

[me@linuxbox ~]$ array-2 /usr/bin

/usr/bin/2to3-2.6 root root

/usr/bin/2to3 root root

/usr/bin/a2p root root

/usr/bin/abrowser root root

/usr/bin/aconnect root root

/usr/bin/acpi_fakekey root root

/usr/bin/acpi_listen root root

/usr/bin/add-apt-repository root root

.

/usr/bin/zipgrep root root

/usr/bin/zipinfo root root

/usr/bin/zipnote root root

/usr/bin/zip root root

/usr/bin/zipsplit root root

/usr/bin/zjsdecode root root

/usr/bin/zsoelim root root

File owners:

daemon : 1 file(s)

root : 1394 file(s) File group owners:

crontab : 1 file(s)

daemon : 1 file(s)

lpadmin : 1 file(s)

mail : 4 file(s)

mlocate : 1 file(s)

root : 1380 file(s)

shadow : 2 file(s)

ssh : 1 file(s)

tty : 2 file(s)

utmp : 2 file(s)

~~~

这里是脚本代码列表(带有行号):

~~~

#!/bin/bash

# array-2: Use arrays to tally file owners

declare -A files file_group file_owner groups owners

if [[ ! -d "$1" ]]; then

echo "Usage: array-2 dir" >&2

exit 1

fi

for i in "$1"/*; do

owner=$(stat -c %U "$i")

group=$(stat -c %G "$i")

files["$i"]="$i"

file_owner["$i"]=$owner

file_group["$i"]=$group

((++owners[$owner]))

((++groups[$group]))

done

# List the collected files

{ for i in "${files[@]}"; do

printf "%-40s %-10s %-10s\n" \

"$i" ${file_owner["$i"]} ${file_group["$i"]}

done } | sort

echo

# List owners

echo "File owners:"

{ for i in "${!owners[@]}"; do

printf "%-10s: %5d file(s)\n" "$i" ${owners["$i"]}

done } | sort

echo

# List groups

echo "File group owners:"

{ for i in "${!groups[@]}"; do

printf "%-10s: %5d file(s)\n" "$i" ${groups["$i"]}

done } | sort

~~~

让我们看一下这个脚本的运行机制:

行5: 关联数组必须用带有 -A 选项的 declare 命令创建。在这个脚本中我们创建了如下五个数组:

files 包含了目录中文件的名字,按文件名索引

file_group 包含了每个文件的组所有者,按文件名索引

file_owner 包含了每个文件的所有者,按文件名索引

groups 包含了属于索引的组的文件数目

owners 包含了属于索引的所有者的文件数目

行7-10:查看是否一个有效的目录名作为位置参数传递给程序。如果不是,就会显示一条使用信息,并且脚本退出,退出状态为1。

行12-20:循环遍历目录中的所有文件。使用 stat 命令,行13和行14抽取文件所有者和组所有者, 并把值赋给它们各自的数组(行16,17),使用文件名作为数组索引。同样地,文件名自身也赋值给 files 数组。

行18-19:属于文件所有者和组所有者的文件总数各自加1。

行22-27:输出文件列表。为做到这一点,使用了 “${array[@]}” 参数展开,展开成整个的数组元素列表, 并且每个元素被当做是一个单独的词。从而允许文件名包含空格的情况。也要注意到整个循环是包裹在花括号中, 从而形成了一个组命令。这样就允许整个循环输出会被管道输送给 sort 命令的输入。这是必要的,因为 展开的数组元素是无序的。

行29-40:这两个循环与文件列表循环相似,除了它们使用 “${!array[@]}” 展开,展开成数组索引的列表 而不是数组元素的。

## 进程替换

虽然组命令和子 shell 看起来相似,并且它们都能用来在重定向中合并流,但是两者之间有一个很重要的不同。 然而,一个组命令在当前 shell 中执行它的所有命令,而一个子 shell(顾名思义)在当前 shell 的一个 子副本中执行它的命令。这意味着运行环境被复制给了一个新的 shell 实例。当这个子 shell 退出时,环境副本会消失, 所以在子 shell 环境(包括变量赋值)中的任何更改也会消失。因此,在大多数情况下,除非脚本要求一个子 shell, 组命令比子 shell 更受欢迎。组命令运行很快并且占用的内存也少。

我们在第20章中看到过一个子 shell 运行环境问题的例子,当我们发现管道线中的一个 read 命令 不按我们所期望的那样工作的时候。为了重现问题,我们构建一个像这样的管道线:

~~~

echo "foo" | read

echo $REPLY

~~~

该 REPLY 变量的内容总是为空,是因为这个 read 命令在一个子 shell 中执行,所以它的 REPLY 副本会被毁掉, 当该子 shell 终止的时候。因为管道线中的命令总是在子 shell 中执行,任何给变量赋值的命令都会遭遇这样的问题。 幸运地是,shell 提供了一种奇异的展开方式,叫做进程替换,它可以用来解决这种麻烦。进程替换有两种表达方式:

一种适用于产生标准输出的进程:

~~~

<(list)

~~~

另一种适用于接受标准输入的进程:

~~~

>(list)

~~~

这里的 list 是一串命令列表:

为了解决我们的 read 命令问题,我们可以雇佣进程替换,像这样:

~~~

read < <(echo "foo")

echo $REPLY

~~~

进程替换允许我们把一个子 shell 的输出结果当作一个用于重定向的普通文件。事实上,因为它是一种展开形式,我们可以检验它的真实值:

~~~

[me@linuxbox ~]$ echo <(echo "foo")

/dev/fd/63

~~~

通过使用 echo 命令,查看展开结果,我们看到子 shell 的输出结果,由一个名为 /dev/fd/63 的文件提供。

进程替换经常被包含 read 命令的循环用到。这里是一个 read 循环的例子,处理一个目录列表的内容,内容创建于一个子 shell:

~~~

#!/bin/bash

# pro-sub : demo of process substitution

while read attr links owner group size date time filename; do

cat <<- EOF

Filename: $filename

Size: $size

Owner: $owner

Group: $group

Modified: $date $time

Links: $links

Attributes: $attr

EOF

done < <(ls -l | tail -n +2)

~~~

这个循环对目录列表的每一个条目执行 read 命令。列表本身产生于该脚本的最后一行代码。这一行代码把从进程替换得到的输出 重定向到这个循环的标准输入。这个包含在管道线中的 tail 命令,是为了消除列表的第一行文本,这行文本是多余的。

当脚本执行后,脚本产生像这样的输出:

~~~

[me@linuxbox ~]$ pro_sub | head -n 20

Filename: addresses.ldif

Size: 14540

Owner: me

Group: me

Modified: 2009-04-02 11:12

Links:

1

Attributes: -rw-r--r--

Filename: bin

Size: 4096

Owner: me

Group: me

Modified: 2009-07-10 07:31

Links: 2

Attributes: drwxr-xr-x

Filename: bookmarks.html

Size: 394213

Owner: me

Group: me

~~~

## 陷阱

在第10章中,我们看到过程序是怎样响应信号的。我们也可以把这个功能添加到我们的脚本中。然而到目前为止, 我们所编写过的脚本还不需要这种功能(因为它们运行时间非常短暂,并且不创建临时文件),大且更复杂的脚本 可能会受益于一个信息处理程序。

当我们设计一个大的,复杂的脚本的时候,若脚本仍在运行时,用户注销或关闭了电脑,这时候会发生什么,考虑到这一点非常重要。 当像这样的事情发生了,一个信号将会发送给所有受到影响的进程。依次地,代表这些进程的程序会执行相应的动作,来确保程序 合理有序的终止。比方说,例如,我们编写了一个会在执行时创建临时文件的脚本。在一个好的设计流程,我们应该让脚本删除创建的 临时文件,当脚本完成它的任务之后。若脚本接收到一个信号,表明该程序即将提前终止的信号, 此时让脚本删除创建的临时文件,也会是很精巧的设计。

为满足这样需求,bash 提供了一种机制,众所周知的 trap。陷阱由被恰当命令的内部命令 trap 实现。 trap 使用如下语法:

~~~

trap argument signal [signal...]

~~~

这里的 argument 是一个字符串,它被读取并被当作一个命令,signal 是一个信号的说明,它会触发执行所要解释的命令。

这里是一个简单的例子:

~~~

#!/bin/bash

# trap-demo : simple signal handling demo

trap "echo 'I am ignoring you.'" SIGINT SIGTERM

for i in {1..5}; do

echo "Iteration $i of 5"

sleep 5

done

~~~

这个脚本定义一个陷阱,当脚本运行的时候,这个陷阱每当接受到一个 SIGINT 或 SIGTERM 信号时,就会执行一个 echo 命令。 当用户试图通过按下 Ctrl-c 组合键终止脚本运行的时候,该程序的执行结果看起来像这样:

~~~

[me@linuxbox ~]$ trap-demo

Iteration 1 of 5

Iteration 2 of 5

I am ignoring you.

Iteration 3 of 5

I am ignoring you.

Iteration 4 of 5

Iteration 5 of 5

~~~

正如我们所看到的,每次用户试图中断程序时,会打印出这条信息。

构建一个字符串形成一个有用的命令序列是很笨拙的,所以通常的做法是指定一个 shell 函数作为命令。在这个例子中, 为每一个信号指定了一个单独的 shell 函数来处理:

~~~

#!/bin/bash

# trap-demo2 : simple signal handling demo

exit_on_signal_SIGINT () {

echo "Script interrupted." 2>&1

exit 0

}

exit_on_signal_SIGTERM () {

echo "Script terminated." 2>&1

exit 0

}

trap exit_on_signal_SIGINT SIGINT

trap exit_on_signal_SIGTERM SIGTERM

for i in {1..5}; do

echo "Iteration $i of 5"

sleep 5

done

~~~

这个脚本的特色是有两个 trap 命令,每个命令对应一个信号。每个 trap,依次,当接受到相应的特殊信号时, 会执行指定的 shell 函数。注意每个信号处理函数中都包含了一个 exit 命令。没有 exit 命令, 信号处理函数执行完后,该脚本将会继续执行。

当用户在这个脚本执行期间,按下 Ctrl-c 组合键的时候,输出结果看起来像这样:

~~~

[me@linuxbox ~]$ trap-demo2

Iteration 1 of 5

Iteration 2 of 5

Script interrupted.

~~~

> 临时文件

>

> 把信号处理程序包含在脚本中的一个原因是删除临时文件,在脚本执行期间,脚本可能会创建临时文件来存放中间结果。 命名临时文件是一种艺术。传统上,在类似于 unix 系统中的程序会在 /tmp 目录下创建它们的临时文件,/tmp 是 一个服务于临时文件的共享目录。然而,因为这个目录是共享的,这会引起一定的安全顾虑,尤其对那些用 超级用户特权运行的程序。除了为暴露给系统中所有用户的文件设置合适的权限,这一明显步骤之外, 给临时文件一个不可预测的文件名是很重要的。这就避免了一种为大众所知的 temp race 攻击。 一种创建一个不可预测的(但是仍有意义的)临时文件名的方法是,做一些像这样的事情:

>

> tempfile=/tmp/$(basename $0).$.$RANDOM

>

> 这将创建一个由程序名字,程序进程的 ID(PID)文件名,和一个随机整数组成。注意,然而,该 $RANDOM shell 变量 只能返回一个范围在1-32767内的整数值,这在计算机术语中不是一个很大的范围,所以一个单一的该变量实例是不足以克服一个坚定的攻击者的。

>

> 一个比较好的方法是使用 mktemp 程序(不要和 mktemp 标准库函数相混淆)来命名和创建临时文件。 这个 mktemp 程序接受一个用于创建文件名的模板作为参数。这个模板应该包含一系列的 “X” 字符, 随后这些字符会被相应数量的随机字母和数字替换掉。一连串的 “X” 字符越长,则一连串的随机字符也就越长。 这里是一个例子:

>

> tempfile=$(mktemp /tmp/foobar.$.XXXXXXXXXX)

>

> 这里创建了一个临时文件,并把临时文件的名字赋值给变量 tempfile。因为模板中的 “X” 字符会被随机字母和 数字代替,所以最终的文件名(在这个例子中,文件名也包含了特殊参数 $$ 的展开值,进程的 PID)可能像这样:

>

> /tmp/foobar.6593.UOZuvM6654

>

> 对于那些由普通用户操作执行的脚本,避免使用 /tmp 目录,而是在用户家目录下为临时文件创建一个目录, 通过像这样的一行代码:

>

> [[ -d $HOME/tmp ]] || mkdir $HOME/tmp

## 异步执行

有时候需要同时执行多个任务。我们已经知道现在所有的操作系统若不是多用户的但至少是多任务的。 脚本也可以构建成多任务处理的模式。

通常这涉及到启动一个脚本,依次,启动一个或多个子脚本来执行额外的任务,而父脚本继续运行。然而,当一系列脚本 以这种方式运行时,要保持父子脚本之间协调工作,会有一些问题。也就是说,若父脚本或子脚本依赖于另一方,并且 一个脚本必须等待另一个脚本结束任务之后,才能完成它自己的任务,这应该怎么办?

bash 有一个内置命令,能帮助管理诸如此类的异步执行的任务。wait 命令导致一个父脚本暂停运行,直到一个 特定的进程(例如,子脚本)运行结束。

### 等待

首先我们将演示一下 wait 命令的用法。为此,我们需要两个脚本,一个父脚本:

~~~

#!/bin/bash

# async-parent : Asynchronous execution demo (parent)

echo "Parent: starting..."

echo "Parent: launching child script..."

async-child &

pid=$!

echo "Parent: child (PID= $pid) launched."

echo "Parent: continuing..."

sleep 2

echo "Parent: pausing to wait for child to finish..."

wait $pid

echo "Parent: child is finished. Continuing..."

echo "Parent: parent is done. Exiting."

~~~

和一个子脚本:

~~~

#!/bin/bash

# async-child : Asynchronous execution demo (child)

echo "Child: child is running..."

sleep 5

echo "Child: child is done. Exiting."

~~~

在这个例子中,我们看到该子脚本是非常简单的。真正的操作通过父脚本完成。在父脚本中,子脚本被启动, 并被放置到后台运行。子脚本的进程 ID 记录在 pid 变量中,这个变量的值是 $! shell 参数的值,它总是 包含放到后台执行的最后一个任务的进程 ID 号。

父脚本继续,然后执行一个以子进程 PID 为参数的 wait 命令。这就导致父脚本暂停运行,直到子脚本退出, 意味着父脚本结束。

当执行后,父子脚本产生如下输出:

~~~

[me@linuxbox ~]$ async-parent

Parent: starting...

Parent: launching child script...

Parent: child (PID= 6741) launched.

Parent: continuing...

Child: child is running...

Parent: pausing to wait for child to finish...

Child: child is done. Exiting.

Parent: child is finished. Continuing...

Parent: parent is done. Exiting.

~~~

## 命名管道

在大多数类似也 Unix 的操作系统中,有可能创建一种特殊类型的饿文件,叫做命名管道。命名管道用来在 两个进程之间建立连接,也可以像其它类型的文件一样使用。虽然它们不是那么流行,但是它们值得我们去了解。

有一种常见的编程架构,叫做客户端-服务器,它可以利用像命名管道这样的通信方式, 也可以使用其它类型的进程间通信方式,比如网络连接。

最为广泛使用的客户端-服务器系统类型是,当然,一个 web 浏览器与一个 web 服务器之间进行通信。 web 浏览器作为客户端,向服务器发出请求,服务器响应请求,并把对应的网页发送给浏览器。

命令管道的行为类似于文件,但实际上形成了先入先出(FIFO)的缓冲。和普通(未命令的)管道一样, 数据从一端进入,然后从另一端出现。通过命令管道,有可能像这样设置一些东西:

~~~

process1 > named_pipe

~~~

和

~~~

process2 < named_pipe

~~~

表现出来就像这样:

~~~

process1 | process2

~~~

### 设置一个命名管道

首先,我们必须创建一个命名管道。使用 mkfifo 命令能够创建命令管道:

~~~

[me@linuxbox ~]$ mkfifo pipe1

[me@linuxbox ~]$ ls -l pipe1

prw-r--r-- 1 me

me

0 2009-07-17 06:41 pipe1

~~~

这里我们使用 mkfifo 创建了一个名为 pipe1 的命名管道。使用 ls 命令,我们查看这个文件, 看到位于属性字段的第一个字母是 “p”,表明它是一个命名管道。

### 使用命名管道

为了演示命名管道是如何工作的,我们将需要两个终端窗口(或用两个虚拟控制台代替)。 在第一个终端中,我们输入一个简单命令,并把命令的输出重定向到命名管道:

~~~

[me@linuxbox ~]$ ls -l > pipe1

~~~

我们按下 Enter 按键之后,命令将会挂起。这是因为在管道的另一端没有任何接受数据。当这种现象发生的时候, 据说是管道阻塞了。一旦我们绑定一个进程到管道的另一端,该进程开始从管道中读取输入的时候,这种情况会消失。 使用第二个终端窗口,我们输入这个命令:

~~~

[me@linuxbox ~]$ cat < pipe1

~~~

然后产自第一个终端窗口的目录列表出现在第二个终端中,并作为来自 cat 命令的输出。在第一个终端 窗口中的 ls 命令一旦它不再阻塞,会成功地结束。

## 总结

嗯,我们已经完成了我们的旅程。现在剩下的唯一要做的事就是练习,练习,再练习。 纵然在我们的长途跋涉中,我们涉及了很多命令,但是就命令行而言,我们只是触及了它的表面。 仍留有成千上万的命令行程序,需要去发现和享受。开始挖掘 /usr/bin 目录吧,你将会看到!

## 拓展阅读

* bash 手册页的 “复合命令” 部分包含了对组命令和子 shell 表示法的详尽描述。

* bash 手册也的 EXPANSION 部分包含了一小部分进程替换的内容:

* 《高级 Bash 脚本指南》也有对进程替换的讨论:

[http://tldp.org/LDP/abs/html/process-sub.html](http://tldp.org/LDP/abs/html/process-sub.html)

* 《Linux 杂志》有两篇关于命令管道的好文章。第一篇,源于1997年9月:

[http://www.linuxjournal.com/article/2156](http://www.linuxjournal.com/article/2156)

* 和第二篇,源于2009年3月:

[http://www.linuxjournal.com/content/using-named-pipes-fifos-bash](http://www.linuxjournal.com/content/using-named-pipes-fifos-bash)

';

第三十六章:数组

最后更新于:2022-04-02 01:46:29

在上一章中,我们查看了 shell 怎样操作字符串和数字的。目前我们所见到的数据类型在计算机科学圈里被 成为标量变量;也就是说,只能包含一个值的变量。

在本章中,我们将看看另一种数据结构叫做数组,数组能存放多个值。数组几乎是所有编程语言的一个特性。 shell 也支持它们,尽管以一个相当有限的形式。即便如此,为解决编程问题,它们是非常有用的。

## 什么是数组?

数组是一次能存放多个数据的变量。数组的组织结构就像一张表。我们拿电子表格举例。一张电子表格就像是一个 二维数组。它既有行也有列,并且电子表格中的一个单元格,可以通过单元格所在的行和列的地址定位它的位置。 数组行为也是如此。数组有单元格,被称为元素,而且每个元素会包含数据。 使用一个称为索引或下标的地址可以访问一个单独的数组元素。

大多数编程语言支持多维数组。一个电子表格就是一个多维数组的例子,它有两个维度,宽度和高度。 许多语言支持任意维度的数组,虽然二维和三维数组可能是最常用的。

Bash 中的数组仅限制为单一维度。我们可以把它们看作是只有一列的电子表格。尽管有这种局限,但是有许多应用使用它们。 对数组的支持第一次出现在 bash 版本2中。原来的 Unix shell 程序,sh,根本就不支持数组。

## 创建一个数组

数组变量就像其它 bash 变量一样命名,当被访问的时候,它们会被自动地创建。这里是一个例子:

~~~

[me@linuxbox ~]$ a[1]=foo

[me@linuxbox ~]$ echo ${a[1]}

foo

~~~

这里我们看到一个赋值并访问数组元素的例子。通过第一个命令,把数组 a 的元素1赋值为 “foo”。 第二个命令显示存储在元素1中的值。在第二个命令中使用花括号是必需的, 以便防止 shell 试图对数组元素名执行路径名展开操作。

也可以用 declare 命令创建一个数组:

~~~

[me@linuxbox ~]$ declare -a a

~~~

使用 -a 选项,declare 命令的这个例子创建了数组 a。

## 数组赋值

有两种方式可以给数组赋值。单个值赋值使用以下语法:

~~~

name[subscript]=value

~~~

这里的 name 是数组的名字,subscript 是一个大于或等于零的整数(或算术表达式)。注意数组第一个元素的下标是0, 而不是1。数组元素的值可以是一个字符串或整数。

多个值赋值使用下面的语法:

~~~

name=(value1 value2 ...)

~~~

这里的 name 是数组的名字,value… 是要按照顺序赋给数组的值,从元素0开始。例如,如果我们希望 把星期几的英文简写赋值给数组 days,我们可以这样做:

~~~

[me@linuxbox ~]$ days=(Sun Mon Tue Wed Thu Fri Sat)

~~~

还可以通过指定下标,把值赋给数组中的特定元素:

~~~

[me@linuxbox ~]$ days=([0]=Sun [1]=Mon [2]=Tue [3]=Wed [4]=Thu [5]=Fri [6]=Sat)

~~~

## 访问数组元素

那么数组对什么有好处呢? 就像许多数据管理任务一样,可以用电子表格程序来完成,许多编程任务则可以用数组完成。

让我们考虑一个简单的数据收集和展示的例子。我们将构建一个脚本,用来检查一个特定目录中文件的修改次数。 从这些数据中,我们的脚本将输出一张表,显示这些文件最后是在一天中的哪个小时被修改的。这样一个脚本 可以被用来确定什么时段一个系统最活跃。这个脚本,称为 hours,输出这样的结果:

~~~

[me@linuxbox ~]$ hours .

Hour Files Hour Files

---- ----- ---- ----

00 0 12 11

01 1 13 7

02 0 14 1

03 0 15 7

04 1 16 6

04 1 17 5

06 6 18 4

07 3 19 4

08 1 20 1

09 14 21 0

10 2 22 0

11 5 23 0

Total files = 80

~~~

当执行该 hours 程序时,指定当前目录作为目标目录。它打印出一张表显示一天(0-23小时)每小时内, 有多少文件做了最后修改。程序代码如下所示:

~~~

#!/bin/bash

# hours : script to count files by modification time

usage () {

echo "usage: $(basename $0) directory" >&2

}

# Check that argument is a directory

if [[ ! -d $1 ]]; then

usage

exit 1

fi

# Initialize array

for i in {0..23}; do hours[i]=0; done

# Collect data

for i in $(stat -c %y "$1"/* | cut -c 12-13); do

j=${i/#0}

((++hours[j]))

((++count))

done

# Display data

echo -e "Hour\tFiles\tHour\tFiles"

echo -e "----\t-----\t----\t-----"

for i in {0..11}; do

j=$((i + 12))

printf "%02d\t%d\t%02d\t%d\n" $i ${hours[i]} $j ${hours[j]}

done

printf "\nTotal files = %d\n" $count

~~~

这个脚本由一个函数(名为 usage),和一个分为四个区块的主体组成。在第一部分,我们检查是否有一个命令行参数, 且该参数为目录。如果不是目录,会显示脚本使用信息并退出。

第二部分初始化一个名为 hours 的数组。给每一个数组元素赋值一个0。虽然没有特殊需要在使用之前准备数组,但是 我们的脚本需要确保没有元素是空值。注意这个循环构建方式很有趣。通过使用花括号展开({0..23}),我们能 很容易为 for 命令产生一系列的数据(words)。

接下来的一部分收集数据,对目录中的每一个文件运行 stat 程序。我们使用 cut 命令从结果中抽取两位数字的小时字段。 在循环里面,我们需要把小时字段开头的零清除掉,因为 shell 将试图(最终会失败)把从 “00” 到 “09” 的数值解释为八进制(见表35-1)。 下一步,我们以小时为数组索引,来增加其对应的数组元素的值。最后,我们增加一个计数器的值(count),记录目录中总共的文件数目。

脚本的最后一部分显示数组中的内容。我们首先输出两行标题,然后进入一个循环产生两栏输出。最后,输出总共的文件数目。

## 数组操作

有许多常见的数组操作。比方说删除数组,确定数组大小,排序,等等。有许多脚本应用程序。

### 输出整个数组的内容

下标 * 和 @ 可以被用来访问数组中的每一个元素。与位置参数一样,@ 表示法在两者之中更有用处。 这里是一个演示:

~~~

[me@linuxbox ~]$ animals=("a dog" "a cat" "a fish")

[me@linuxbox ~]$ for i in ${animals[*]}; do echo $i; done

a

dog

a

cat

a

fish

[me@linuxbox ~]$ for i in ${animals[@]}; do echo $i; done

a

dog

a

cat

a

fish

[me@linuxbox ~]$ for i in "${animals[*]}"; do echo $i; done

a dog a cat a fish

[me@linuxbox ~]$ for i in "${animals[@]}"; do echo $i; done

a dog

a cat

a fish

~~~

我们创建了数组 animals,并把三个含有两个字的字符串赋值给数组。然后我们执行四个循环看一下对数组内容进行分词的效果。 表示法 ${animals[*]} 和 ${animals[@]}的行为是一致的直到它们被用引号引起来。

### 确定数组元素个数

使用参数展开,我们能够确定数组元素的个数,与计算字符串长度的方式几乎相同。这里是一个例子:

~~~

[me@linuxbox ~]$ a[100]=foo

[me@linuxbox ~]$ echo ${#a[@]} # number of array elements

1

[me@linuxbox ~]$ echo ${#a[100]} # length of element 100

3

~~~

我们创建了数组 a,并把字符串 “foo” 赋值给数组元素100。下一步,我们使用参数展开来检查数组的长度,使用 @ 表示法。 最后,我们查看了包含字符串 “foo” 的数组元素 100 的长度。有趣的是,尽管我们把字符串赋值给数组元素100, bash 仅仅报告数组中有一个元素。这不同于一些其它语言的行为,数组中未使用的元素(元素0-99)会初始化为空值, 并把它们计入数组长度。

### 找到数组使用的下标

因为 bash 允许赋值的数组下标包含 “间隔”,有时候确定哪个元素真正存在是很有用的。为做到这一点, 可以使用以下形式的参数展开:

${!array[*]}

${!array[@]}

这里的 array 是一个数组变量的名字。和其它使用符号 * 和 @ 的展开一样,用引号引起来的 @ 格式是最有用的, 因为它能展开成分离的词。

~~~

[me@linuxbox ~]$ foo=([2]=a [4]=b [6]=c)

[me@linuxbox ~]$ for i in "${foo[@]}"; do echo $i; done

a

b

c

[me@linuxbox ~]$ for i in "${!foo[@]}"; do echo $i; done

2

4

6

~~~

### 在数组末尾添加元素

如果我们需要在数组末尾附加数据,那么知道数组中元素的个数是没用的,因为通过 * 和 @ 表示法返回的数值不能 告诉我们使用的最大数组索引。幸运地是,shell 为我们提供了一种解决方案。通过使用 += 赋值运算符, 我们能够自动地把值附加到数组末尾。这里,我们把三个值赋给数组 foo,然后附加另外三个。

~~~

[me@linuxbox~]$ foo=(a b c)

[me@linuxbox~]$ echo ${foo[@]}

a b c

[me@linuxbox~]$ foo+=(d e f)

[me@linuxbox~]$ echo ${foo[@]}

a b c d e f

~~~

### 数组排序

就像电子表格,经常有必要对一列数据进行排序。Shell 没有这样做的直接方法,但是通过一点儿代码,并不难实现。

~~~

#!/bin/bash

# array-sort : Sort an array

a=(f e d c b a)

echo "Original array: ${a[@]}"

a_sorted=($(for i in "${a[@]}"; do echo $i; done | sort))

echo "Sorted array: ${a_sorted[@]}"

~~~

当执行之后,脚本产生这样的结果:

~~~

[me@linuxbox ~]$ array-sort

Original array: f e d c b a

Sorted array:

a b c d e f

~~~

脚本运行成功,通过使用一个复杂的命令替换把原来的数组(a)中的内容复制到第二个数组(a_sorted)中。 通过修改管道线的设计,这个基本技巧可以用来对数组执行各种各样的操作。

### 删除数组

删除一个数组,使用 unset 命令:

~~~

[me@linuxbox ~]$ foo=(a b c d e f)

[me@linuxbox ~]$ echo ${foo[@]}

a b c d e f

[me@linuxbox ~]$ unset foo

[me@linuxbox ~]$ echo ${foo[@]}

[me@linuxbox ~]$

~~~

也可以使用 unset 命令删除单个的数组元素:

~~~

[me@linuxbox~]$ foo=(a b c d e f)

[me@linuxbox~]$ echo ${foo[@]}

a b c d e f

[me@linuxbox~]$ unset 'foo[2]'

[me@linuxbox~]$ echo ${foo[@]}

a b d e f

~~~

在这个例子中,我们删除了数组中的第三个元素,下标为2。记住,数组下标开始于0,而不是1!也要注意数组元素必须 用引号引起来为的是防止 shell 执行路径名展开操作。

有趣地是,给一个数组赋空值不会清空数组内容:

~~~

[me@linuxbox ~]$ foo=(a b c d e f)

[me@linuxbox ~]$ foo=

[me@linuxbox ~]$ echo ${foo[@]}

b c d e f

~~~

任何引用一个不带下标的数组变量,则指的是数组元素0:

~~~

[me@linuxbox~]$ foo=(a b c d e f)

[me@linuxbox~]$ echo ${foo[@]}

a b c d e f

[me@linuxbox~]$ foo=A

[me@linuxbox~]$ echo ${foo[@]}

A b c d e f

~~~

## 关联数组

现在最新的 bash 版本支持关联数组了。关联数组使用字符串而不是整数作为数组索引。 这种功能给出了一种有趣的新方法来管理数据。例如,我们可以创建一个叫做 “colors” 的数组,并用颜色名字作为索引。

~~~

declare -A colors

colors["red"]="#ff0000"

colors["green"]="#00ff00"

colors["blue"]="#0000ff"

~~~

不同于整数索引的数组,仅仅引用它们就能创建数组,关联数组必须用带有 -A 选项的 declare 命令创建。

访问关联数组元素的方式几乎与整数索引数组相同:

~~~

echo ${colors["blue"]}

~~~

在下一章中,我们将看一个脚本,很好地利用关联数组,生产出了一个有意思的报告。

## 总结

如果我们在 bash 手册页中搜索单词 “array”的话,我们能找到许多 bash 在哪里会使用数组变量的实例。其中大部分相当晦涩难懂, 但是它们可能在一些特殊场合提供临时的工具。事实上,在 shell 编程中,整套数组规则利用率相当低,很大程度上归咎于这样的事实, 传统 Unix shell 程序(比如说 sh)缺乏对数组的支持。这样缺乏人气是不幸的,因为数组广泛应用于其它编程语言, 并为解决各种各样的编程问题,提供了一个强大的工具。

数组和循环有一种天然的姻亲关系,它们经常被一起使用。该

~~~

for ((expr; expr; expr))

~~~

形式的循环尤其适合计算数组下标。

## 拓展阅读

* Wikipedia 上面有两篇关于在本章提到的数据结构的文章:

[http://en.wikipedia.org/wiki/Scalar_(computing)](http://en.wikipedia.org/wiki/Scalar_(computing))

[http://en.wikipedia.org/wiki/Associative_array](http://en.wikipedia.org/wiki/Associative_array)

';

第三十五章:字符串和数字

最后更新于:2022-04-02 01:46:27

所有的计算机程序都是用来和数据打交道的。在过去的章节中,我们专注于处理文件级别的数据。 然而,许多程序问题需要使用更小的数据单位来解决,比方说字符串和数字。

在这一章中,我们将查看几个用来操作字符串和数字的 shell 功能。shell 提供了各种执行字符串操作的参数展开功能。 除了算术展开(在第七章中接触过),还有一个常见的命令行程序叫做 bc,能执行更高级别的数学运算。

## 参数展开

尽管参数展开在第七章中出现过,但我们并没有详尽地介绍它,因为大多数的参数展开会用在脚本中,而不是命令行中。 我们已经使用了一些形式的参数展开;例如,shell 变量。shell 提供了更多方式。

### 基本参数

最简单的参数展开形式反映在平常使用的变量上。

例如:

**$a**

当 $a 展开后,会变成变量 a 所包含的值。简单参数也可能用花括号引起来:

**${a}**

虽然这对展开没有影响,但若该变量 a 与其它的文本相邻,可能会把 shell 搞糊涂了。在这个例子中,我们试图 创建一个文件名,通过把字符串 “_file” 附加到变量 a 的值的后面。

~~~

[me@linuxbox ~]$ a="foo"

[me@linuxbox ~]$ echo "$a_file"

~~~

如果我们执行这个序列,没有任何输出结果,因为 shell 会试着展开一个称为 a_file 的变量,而不是 a。通过 添加花括号可以解决这个问题:

~~~

[me@linuxbox ~]$ echo "${a}_file"

foo_file

~~~

我们已经知道通过把数字包裹在花括号中,可以访问大于9的位置参数。例如,访问第十一个位置参数,我们可以这样做:

**${11}**

### 管理空变量的展开

几种用来处理不存在和空变量的参数展开形式。这些展开形式对于解决丢失的位置参数和给参数指定默认值的情况很方便。

**${parameter:-word}**

若 parameter 没有设置(例如,不存在)或者为空,展开结果是 word 的值。若 parameter 不为空,则展开结果是 parameter 的值。

~~~

[me@linuxbox ~]$ foo=

[me@linuxbox ~]$ echo ${foo:-"substitute value if unset"}

if unset

substitute value

[me@linuxbox ~]$ echo $foo

[me@linuxbox ~]$ foo=bar

[me@linuxbox ~]$ echo ${foo:-"substitute value if unset"}

bar

[me@linuxbox ~]$ echo $foo

bar

~~~

**${parameter:=word}**

若 parameter 没有设置或为空,展开结果是 word 的值。另外,word 的值会赋值给 parameter。 若 parameter 不为空,展开结果是 parameter 的值。

~~~

[me@linuxbox ~]$ foo=

[me@linuxbox ~]$ echo ${foo:="default value if unset"}

default value if unset

[me@linuxbox ~]$ echo $foo

default value if unset

[me@linuxbox ~]$ foo=bar

[me@linuxbox ~]$ echo ${foo:="default value if unset"}

bar

[me@linuxbox ~]$ echo $foo

bar

~~~

* * *

注意: 位置参数或其它的特殊参数不能以这种方式赋值。

* * *

**${parameter:?word}**

若 parameter 没有设置或为空,这种展开导致脚本带有错误退出,并且 word 的内容会发送到标准错误。若 parameter 不为空, 展开结果是 parameter 的值。

~~~

[me@linuxbox ~]$ foo=

[me@linuxbox ~]$ echo ${foo:?"parameter is empty"}

bash: foo: parameter is empty

[me@linuxbox ~]$ echo $?

1

[me@linuxbox ~]$ foo=bar

[me@linuxbox ~]$ echo ${foo:?"parameter is empty"}

bar

[me@linuxbox ~]$ echo $?

0

~~~

**${parameter:+word}**

若 parameter 没有设置或为空,展开结果为空。若 parameter 不为空, 展开结果是 word 的值会替换掉 parameter 的值;然而,parameter 的值不会改变。

~~~

[me@linuxbox ~]$ foo=

[me@linuxbox ~]$ echo ${foo:+"substitute value if set"}

[me@linuxbox ~]$ foo=bar

[me@linuxbox ~]$ echo ${foo:+"substitute value if set"}

substitute value if set

~~~

## 返回变量名的参数展开

shell 具有返回变量名的能力。这会用在一些相当独特的情况下。

~~~

${!prefix*}

${!prefix@}

~~~

这种展开会返回以 prefix 开头的已有变量名。根据 bash 文档,这两种展开形式的执行结果相同。 这里,我们列出了所有以 BASH 开头的环境变量名:

~~~

[me@linuxbox ~]$ echo ${!BASH*}

BASH BASH_ARGC BASH_ARGV BASH_COMMAND BASH_COMPLETION

BASH_COMPLETION_DIR BASH_LINENO BASH_SOURCE BASH_SUBSHELL

BASH_VERSINFO BASH_VERSION

~~~

### 字符串展开

有大量的展开形式可用于操作字符串。其中许多展开形式尤其适用于路径名的展开。

**${#parameter}**

展开成由 parameter 所包含的字符串的长度。通常,parameter 是一个字符串;然而,如果 parameter 是 @ 或者是 * 的话, 则展开结果是位置参数的个数。

~~~

[me@linuxbox ~]$ foo="This string is long."

[me@linuxbox ~]$ echo "'$foo' is ${#foo} characters long."

'This string is long.' is 20 characters long.

~~~

**${parameter:offset}**

**${parameter:offset:length}**

这些展开用来从 parameter 所包含的字符串中提取一部分字符。提取的字符始于 第 offset 个字符(从字符串开头算起)直到字符串的末尾,除非指定提取的长度。

~~~

[me@linuxbox ~]$ foo="This string is long."

[me@linuxbox ~]$ echo ${foo:5}

string is long.

[me@linuxbox ~]$ echo ${foo:5:6}

string

~~~

若 offset 的值为负数,则认为 offset 值是从字符串的末尾开始算起,而不是从开头。注意负数前面必须有一个空格, 为防止与 ${parameter:-word} 展开形式混淆。length,若出现,则必须不能小于零。

如果 parameter 是 @,展开结果是 length 个位置参数,从第 offset 个位置参数开始。

~~~

[me@linuxbox ~]$ foo="This string is long."

[me@linuxbox ~]$ echo ${foo: -5}

long.

[me@linuxbox ~]$ echo ${foo: -5:2}

lo

~~~

**${parameter#pattern}**

**${parameter##pattern}**

这些展开会从 paramter 所包含的字符串中清除开头一部分文本,这些字符要匹配定义的 patten。pattern 是 通配符模式,就如那些用在路径名展开中的模式。这两种形式的差异之处是该 # 形式清除最短的匹配结果, 而该 ## 模式清除最长的匹配结果。

~~~

[me@linuxbox ~]$ foo=file.txt.zip

[me@linuxbox ~]$ echo ${foo#*.}

txt.zip

[me@linuxbox ~]$ echo ${foo##*.}

zip

~~~

**${parameter%pattern}**

**${parameter%%pattern}**

这些展开和上面的 # 和 ## 展开一样,除了它们清除的文本从 parameter 所包含字符串的末尾开始,而不是开头。

~~~

[me@linuxbox ~]$ foo=file.txt.zip

[me@linuxbox ~]$ echo ${foo%.*}

file.txt

[me@linuxbox ~]$ echo ${foo%%.*}

file

~~~

**${parameter/pattern/string}**

**${parameter//pattern/string}**

**${parameter/#pattern/string}**

**${parameter/%pattern/string}**

这种形式的展开对 parameter 的内容执行查找和替换操作。如果找到了匹配通配符 pattern 的文本, 则用 string 的内容替换它。在正常形式下,只有第一个匹配项会被替换掉。在该 // 形式下,所有的匹配项都会被替换掉。 该 /# 要求匹配项出现在字符串的开头,而 /% 要求匹配项出现在字符串的末尾。/string 可能会省略掉,这样会 导致删除匹配的文本。

~~~

[me@linuxbox~]$ foo=JPG.JPG

[me@linuxbox ~]$ echo ${foo/JPG/jpg}

jpg.JPG

[me@linuxbox~]$ echo ${foo//JPG/jpg}

jpg.jpg

[me@linuxbox~]$ echo ${foo/#JPG/jpg}

jpg.JPG

[me@linuxbox~]$ echo ${foo/%JPG/jpg}

JPG.jpg

~~~

知道参数展开是件很好的事情。字符串操作展开可以用来替换其它常见命令比方说 sed 和 cut。 通过减少使用外部程序,展开提高了脚本的效率。举例说明,我们将修改在之前章节中讨论的 longest-word 程序, 用参数展开 ${#j} 取代命令 $(echo $j | wc -c) 及其 subshell ,像这样:

~~~

#!/bin/bash

# longest-word3 : find longest string in a file

for i; do

if [[ -r $i ]]; then

max_word=

max_len=

for j in $(strings $i); do

len=${#j}

if (( len > max_len )); then

max_len=$len

max_word=$j

fi

done

echo "$i: '$max_word' ($max_len characters)"

fi

shift

done

~~~

下一步,我们将使用 time 命令来比较这两个脚本版本的效率:

~~~

[me@linuxbox ~]$ time longest-word2 dirlist-usr-bin.txt

dirlist-usr-bin.txt: 'scrollkeeper-get-extended-content-list' (38

characters)

real 0m3.618s

user 0m1.544s

sys 0m1.768s

[me@linuxbox ~]$ time longest-word3 dirlist-usr-bin.txt

dirlist-usr-bin.txt: 'scrollkeeper-get-extended-content-list' (38

characters)

real 0m0.060s

user 0m0.056s

sys 0m0.008s

~~~

原来的脚本扫描整个文本文件需耗时3.168秒,而该新版本,使用参数展开,仅仅花费了0.06秒 —— 一个非常巨大的提高。

### 大小写转换

最新的 bash 版本已经支持字符串的大小写转换了。bash 有四个参数展开和 declare 命令的两个选项来支持大小写转换。

那么大小写转换对什么有好处呢? 除了明显的审美价值,它在编程领域还有一个重要的角色。 让我们考虑一个数据库查询的案例。假设一个用户已经敲写了一个字符串到数据输入框中, 而我们想要在一个数据库中查找这个字符串。该用户输入的字符串有可能全是大写字母或全是小写或是两者的结合。 我们当然不希望把每个可能的大小写拼写排列填充到我们的数据库中。那怎么办?

解决这个问题的常见方法是规范化用户输入。也就是,在我们试图查询数据库之前,把用户的输入转换成标准化。 我们能做到这一点,通过把用户输入的字符全部转换成小写字母或大写字母,并且确保数据库中的条目 按同样的方式规范化。

这个 declare 命令可以用来把字符串规范成大写或小写字符。使用 declare 命令,我们能强制一个 变量总是包含所需的格式,无论如何赋值给它。

~~~

#!/bin/bash

# ul-declare: demonstrate case conversion via declare

declare -u upper

declare -l lower

if [[ $1 ]]; then

upper="$1"

lower="$1"

echo $upper

echo $lower

fi

~~~

在上面的脚本中,我们使用 declare 命令来创建两个变量,upper 和 lower。我们把第一个命令行参数的值(位置参数1)赋给 每一个变量,然后把变量值在屏幕上显示出来:

~~~

[me@linuxbox ~]$ ul-declare aBc

ABC

abc

~~~

正如我们所看到的,命令行参数(“aBc”)已经规范化了。

有四个参数展开,可以执行大小写转换操作:

表 35-1: 大小写转换参数展开

| 格式 | 结果 |

|------|-------|

| ${parameter,,} | 把 parameter 的值全部展开成小写字母。 |

| ${parameter,} | 仅仅把 parameter 的第一个字符展开成小写字母。 |

| ${parameter^^} | 把 parameter 的值全部转换成大写字母。 |

| ${parameter^} | 仅仅把 parameter 的第一个字符转换成大写字母(首字母大写)。 |

这里是一个脚本,演示了这些展开格式:

~~~

#!/bin/bash

# ul-param - demonstrate case conversion via parameter expansion

if [[ $1 ]]; then

echo ${1,,}

echo ${1,}

echo ${1^^}

echo ${1^}

fi

~~~

这里是脚本运行后的结果:

~~~

[me@linuxbox ~]$ ul-param aBc

abc

aBc

ABC

ABc

~~~

再次,我们处理了第一个命令行参数,输出了由参数展开支持的四种变体。尽管这个脚本使用了第一个位置参数, 但参数可以是任意字符串,变量,或字符串表达式。

## 算术求值和展开

我们在第七章中已经接触过算术展开了。它被用来对整数执行各种算术运算。它的基本格式是:

~~~

$((expression))

~~~

这里的 expression 是一个有效的算术表达式。

这个与复合命令 (( )) 有关,此命令用做算术求值(真测试),我们在第27章中遇到过。

在之前的章节中,我们看到过一些类型的表达式和运算符。这里,我们将看到一个更完整的列表。

### 数基

回到第9章,我们看过八进制(以8为底)和十六进制(以16为底)的数字。在算术表达式中,shell 支持任意进制的整形常量。

表 35-2: 指定不同的数基

| 表示法 | 描述 |

|------|-------|

| number | 默认情况下,没有任何表示法的数字被看做是十进制数(以10为底)。 |

| 0number | 在算术表达式中,以零开头的数字被认为是八进制数。 |

| 0xnumber | 十六进制表示法 |

| base#number | number 以 base 为底 |

一些例子:

~~~

[me@linuxbox ~]$ echo $((0xff))

255

[me@linuxbox ~]$ echo $((2#11111111))

255

~~~

在上面的示例中,我们打印出十六进制数 ff(最大的两位数)的值和最大的八位二进制数(以2为底)。

### 一元运算符

有两个二元运算符,+ 和 -,它们被分别用来表示一个数字是正数还是负数。例如,-5。

### 简单算术

下表中列出了普通算术运算符:

表 35-3: 算术运算符

| 运算符 | 描述 |

|------|-------|

| + | 加 |

| - | 减 |

| * | 乘 |

| / | 整除 |

| ** | 乘方 |

| % | 取模(余数) |

其中大部分运算符是不言自明的,但是整除和取模运算符需要进一步解释一下。

因为 shell 算术只操作整形,所以除法运算的结果总是整数:

~~~

[me@linuxbox ~]$ echo $(( 5 / 2 ))

2

~~~

这使得确定除法运算的余数更为重要:

~~~

[me@linuxbox ~]$ echo $(( 5 % 2 ))

1

~~~

通过使用除法和取模运算符,我们能够确定5除以2得数是2,余数是1。

在循环中计算余数是很有用处的。在循环执行期间,它允许某一个操作在指定的间隔内执行。在下面的例子中, 我们显示一行数字,并高亮显示5的倍数:

~~~

#!/bin/bash

# modulo : demonstrate the modulo operator

for ((i = 0; i <= 20; i = i + 1)); do

remainder=$((i % 5))

if (( remainder == 0 )); then

printf "<%d> " $i

else

printf "%d " $i

fi

done

printf "\n"

~~~

当脚本执行后,输出结果看起来像这样:

~~~

[me@linuxbox ~]$ modulo

<0> 1 2 3 4 <5> 6 7 8 9 <10> 11 12 13 14 <15> 16 17 18 19 <20>

~~~

### 赋值运算符

尽管它的使用不是那么明显,算术表达式可能执行赋值运算。虽然在不同的上下文中,我们已经执行了许多次赋值运算。 每次我们给变量一个值,我们就执行了一次赋值运算。我们也能在算术表达式中执行赋值运算:

~~~

[me@linuxbox ~]$ foo=

[me@linuxbox ~]$ echo $foo

[me@linuxbox ~]$ if (( foo = 5 ));then echo "It is true."; fi

It is true.

[me@linuxbox ~]$ echo $foo

5

~~~

在上面的例子中,首先我们给变量 foo 赋了一个空值,然后验证 foo 的确为空。下一步,我们执行一个 if 复合命令 (( foo = 5 ))。 这个过程完成两件有意思的事情:1)它把5赋值给变量 foo,2)它计算测试条件为真,因为 foo 的值非零。

* * *

注意: 记住上面表达式中 = 符号的真正含义非常重要。单个 = 运算符执行赋值运算。foo = 5 是说“使得 foo 等于5”, 而 == 运算符计算等价性。foo == 5 是说“是否 foo 等于5?”。这会让人感到非常迷惑,因为 test 命令接受单个 = 运算符 来测试字符串等价性。这也是使用更现代的 [[ ]] 和 (( )) 复合命令来代替 test 命令的另一个原因。

* * *

除了 = 运算符,shell 也提供了其它一些表示法,来执行一些非常有用的赋值运算:

表35-4: 赋值运算符

| 表示法 | 描述 |

|------|-------|

| parameter = value | 简单赋值。给 parameter 赋值。 |

| parameter += value | 加。等价于 parameter = parameter + value。 |

| parameter -= value | 减。等价于 parameter = parameter – value。 |

| parameter *= value | 乘。等价于 parameter = parameter * value。 |

| parameter /= value | 整除。等价于 parameter = parameter / value。 |

| parameter %= value | 取模。等价于 parameter = parameter % value。 |

| parameter++ | 后缀自增变量。等价于 parameter = parameter + 1 (但,要看下面的讨论)。 |

| parameter-- | 后缀自减变量。等价于 parameter = parameter - 1。 |

| ++parameter | 前缀自增变量。等价于 parameter = parameter + 1。 |

| --parameter | 前缀自减变量。等价于 parameter = parameter - 1。 |

这些赋值运算符为许多常见算术任务提供了快捷方式。特别关注一下自增(++)和自减(--)运算符,它们会把它们的参数值加1或减1。 这种风格的表示法取自C 编程语言并且被其它几种编程语言吸收,包括 bash。

自增和自减运算符可能会出现在参数的前面或者后面。然而它们都是把参数值加1或减1,这两个位置有个微小的差异。 若运算符放置在参数的前面,参数值会在参数返回之前增加(或减少)。若放置在后面,则运算会在参数返回之后执行。 这相当奇怪,但这是它预期的行为。这里是个演示的例子:

~~~

[me@linuxbox ~]$ foo=1

[me@linuxbox ~]$ echo $((foo++))

1

[me@linuxbox ~]$ echo $foo

2

~~~

如果我们把1赋值给变量 foo,然后通过把自增运算符 ++ 放到参数名 foo 之后来增加它,foo 返回1。 然而,如果我们第二次查看变量 foo 的值,我们看到它的值增加了1。若我们把 ++ 运算符放到参数 foo 之前, 我们得到更期望的行为:

~~~

[me@linuxbox ~]$ foo=1

[me@linuxbox ~]$ echo $((++foo))

2

[me@linuxbox ~]$ echo $foo

2

~~~

对于大多数 shell 应用来说,前缀运算符最有用。

自增 ++ 和 自减 -- 运算符经常和循环操作结合使用。我们将改进我们的 modulo 脚本,让代码更紧凑些:

~~~

#!/bin/bash

# modulo2 : demonstrate the modulo operator

for ((i = 0; i <= 20; ++i )); do

if (((i % 5) == 0 )); then

printf "<%d> " $i

else

printf "%d " $i

fi

done

printf "\n"

~~~

### 位运算符

位运算符是一类以不寻常的方式操作数字的运算符。这些运算符工作在位级别的数字。它们被用在某类底层的任务中, 经常涉及到设置或读取位标志。

表35-5: 位运算符

| 运算符 | 描述 |

|------|-------|

| ~ | 按位取反。对一个数字所有位取反。 |

| << | 位左移. 把一个数字的所有位向左移动。 |

| >> | 位右移. 把一个数字的所有位向右移动。 |

| & | 位与。对两个数字的所有位执行一个 AND 操作。 |

| | | 位或。对两个数字的所有位执行一个 OR 操作。 |

| ^ | 位异或。对两个数字的所有位执行一个异或操作。 |

注意除了按位取反运算符之外,其它所有位运算符都有相对应的赋值运算符(例如,<<=)。

这里我们将演示产生2的幂列表的操作,使用位左移运算符:

~~~

[me@linuxbox ~]$ for ((i=0;i<8;++i)); do echo $((1<= | 大于或相等 |

| < | 小于 |

| > | 大于 |

| == | 相等 |

| != | 不相等 |

| && | 逻辑与 |

| || | 逻辑或 |

| expr1?expr2:expr3 | 条件(三元)运算符。若表达式 expr1 的计算结果为非零值(算术真),则 执行表达式 expr2,否则执行表达式 expr3。 |

当表达式用于逻辑运算时,表达式遵循算术逻辑规则;也就是,表达式的计算结果是零,则认为假,而非零表达式认为真。 该 (( )) 复合命令把结果映射成 shell 正常的退出码:

~~~

[me@linuxbox ~]$ if ((1)); then echo "true"; else echo "false"; fi

true

[me@linuxbox ~]$ if ((0)); then echo "true"; else echo "false"; fi

false

~~~

最陌生的逻辑运算符就是这个三元运算符了。这个运算符(仿照于 C 编程语言里的三元运算符)执行一个单独的逻辑测试。 它用起来类似于 if/then/else 语句。它操作三个算术表达式(字符串不会起作用),并且若第一个表达式为真(或非零), 则执行第二个表达式。否则,执行第三个表达式。我们可以在命令行中实验一下:

~~~

[me@linuxbox~]$ a=0

[me@linuxbox~]$ ((a<1?++a:--a))

[me@linuxbox~]$ echo $a

1

[me@linuxbox~]$ ((a<1?++a:--a))

[me@linuxbox~]$ echo $a

0

~~~

这里我们看到一个实际使用的三元运算符。这个例子实现了一个切换。每次运算符执行的时候,变量 a 的值从零变为1,或反之亦然。

请注意在表达式内执行赋值却并非易事。

当企图这样做时,bash 会声明一个错误:

~~~

[me@linuxbox ~]$ a=0

[me@linuxbox ~]$ ((a<1?a+=1:a-=1))

bash: ((: a<1?a+=1:a-=1: attempted assignment to non-variable (error token is "-=1")

~~~

通过把赋值表达式用括号括起来,可以解决这个错误:

~~~

[me@linuxbox ~]$ ((a<1?(a+=1):(a-=1)))

~~~

下一步,我们看一个使用算术运算符更完备的例子,该示例产生一个简单的数字表格:

~~~

#!/bin/bash

# arith-loop: script to demonstrate arithmetic operators

finished=0

a=0

printf "a\ta**2\ta**3\n"

printf "=\t====\t====\n"

until ((finished)); do

b=$((a**2))

c=$((a**3))

printf "%d\t%d\t%d\n" $a $b $c

((a<10?++a:(finished=1)))

done

~~~

在这个脚本中,我们基于变量 finished 的值实现了一个 until 循环。首先,把变量 finished 的值设为零(算术假), 继续执行循环之道它的值变为非零。在循环体内,我们计算计数器 a 的平方和立方。在循环末尾,计算计数器变量 a 的值。 若它小于10(最大迭代次数),则 a 的值加1,否则给变量 finished 赋值为1,使得变量 finished 算术为真, 从而终止循环。运行该脚本得到这样的结果:

~~~

[me@linuxbox ~]$ arith-loop

a a**2 a**3

= ==== ====

0 0 0

1 1 1

2 4 8

3 9 27

4 16 64

5 25 125

6 36 216

7 49 343

8 64 512

9 81 729

10 100 1000

~~~

## bc - 一种高精度计算器语言

我们已经看到 shell 是可以处理所有类型的整形算术的,但是如果我们需要执行更高级的数学运算或仅使用浮点数,该怎么办? 答案是,我们不能这样做。至少不能直接用 shell 完成此类运算。为此,我们需要使用外部程序。 有几种途径可供我们采用。嵌入的 Perl 或者 AWK 程序是一种可能的方案,但是不幸的是,超出了本书的内容大纲。 另一种方式就是使用一种专业的计算器程序。这样一个程序叫做 bc,在大多数 Linux 系统中都可以找到。

该 bc 程序读取一个用它自己的类似于 C 语言的语法编写的脚本文件。一个 bc 脚本可能是一个分离的文件或者是读取 标准输入。bc 语言支持相当少的功能,包括变量,循环和程序员定义的函数。这里我们不会讨论整个 bc 语言, 仅仅体验一下。查看 bc 的手册页,其文档整理非常好。

让我们从一个简单的例子开始。我们将编写一个 bc 脚本来执行2加2运算:

~~~

/* A very simple bc script */

2 + 2

~~~

脚本的第一行是一行注释。bc 使用和 C 编程语言一样的注释语法。注释,可能会跨越多行,开始于 `/*` 结束于`*/`。

### 使用 bc

如果我们把上面的 bc 脚本保存为 foo.bc,然后我们就能这样运行它:

~~~

[me@linuxbox ~]$ bc foo.bc

bc 1.06.94

Copyright 1991-1994, 1997, 1998, 2000, 2004, 2006 Free Software

Foundation, Inc.

This is free software with ABSOLUTELY NO WARRANTY.

For details type `warranty'.

4

~~~

如果我们仔细观察,我们看到算术结果在最底部,版权信息之后。可以通过 -q(quiet)选项禁止这些版权信息。 bc 也能够交互使用:

~~~

[me@linuxbox ~]$ bc -q

2 + 2

4

quit

~~~

当使用 bc 交互模式时,我们简单地输入我们希望执行的运算,结果就立即显示出来。bc 的 quit 命令结束交互会话。

也可能通过标准输入把一个脚本传递给 bc 程序:

~~~

[me@linuxbox ~]$ bc < foo.bc

4

~~~

这种接受标准输入的能力,意味着我们可以使用 here 文档,here字符串,和管道来传递脚本。这里是一个使用 here 字符串的例子:

~~~

[me@linuxbox ~]$ bc <<< "2+2"

4

~~~

### 一个脚本实例

作为一个真实世界的例子,我们将构建一个脚本,用于计算每月的还贷金额。在下面的脚本中, 我们使用了 here 文档把一个脚本传递给 bc:

~~~

#!/bin/bash

# loan-calc : script to calculate monthly loan payments

PROGNAME=$(basename $0)

usage () {

cat <<- EOF

Usage: $PROGNAME PRINCIPAL INTEREST MONTHS

Where:

PRINCIPAL is the amount of the loan.

INTEREST is the APR as a number (7% = 0.07).

MONTHS is the length of the loan's term.

EOF

}

if (($# != 3)); then

usage

exit 1

fi

principal=$1

interest=$2

months=$3

bc <<- EOF

scale = 10

i = $interest / 12

p = $principal

n = $months

a = p * ((i * ((1 + i) ^ n)) / (((1 + i) ^ n) - 1))

print a, "\n"

EOF

~~~

当脚本执行后,输出结果像这样:

~~~

[me@linuxbox ~]$ loan-calc 135000 0.0775 180

475

1270.7222490000

~~~

若贷款 135,000 美金,年利率为 7.75%,借贷180个月(15年),这个例子计算出每月需要还贷的金额。 注意这个答案的精确度。这是由脚本中变量 scale 的值决定的。bc 的手册页提供了对 bc 脚本语言的详尽描述。 虽然 bc 的数学符号与 shell 的略有差异(bc 与 C 更相近),但是基于目前我们所学的内容, 大多数符号是我们相当熟悉的。

## 总结

在这一章中,我们学习了很多小东西,在脚本中这些小零碎可以完成“真正的工作”。随着我们编写脚本经验的增加, 能够有效地操作字符串和数字的能力将具有极为重要的价值。我们的 loan-calc 脚本表明, 甚至可以创建简单的脚本来完成一些真正有用的事情。

## 额外加分

虽然该 loan-calc 脚本的基本功能已经很到位了,但脚本还远远不够完善。为了额外加分,试着 给脚本 loan-calc 添加以下功能:

* 完整的命令行参数验证

* 用一个命令行选项来实现“交互”模式,提示用户输入本金、利率和贷款期限

* 输出格式美化

## 拓展阅读

* 《Bash Hackers Wiki》对参数展开有一个很好的论述:

[http://wiki.bash-hackers.org/syntax/pe](http://wiki.bash-hackers.org/syntax/pe)

* 《Bash 参考手册》也介绍了这个:

[http://www.gnu.org/software/bash/manual/bashref.html#Shell-Parameter-Expansion](http://www.gnu.org/software/bash/manual/bashref.html#Shell-Parameter-Expansion)

* Wikipedia 上面有一篇很好的文章描述了位运算:

[http://en.wikipedia.org/wiki/Bit_operation](http://en.wikipedia.org/wiki/Bit_operation)

* 和一篇关于三元运算的文章:

[http://en.wikipedia.org/wiki/Ternary_operation](http://en.wikipedia.org/wiki/Ternary_operation)

* 还有一个对计算还贷金额公式的描述,我们的 loan-calc 脚本中用到了这个公式:

[http://en.wikipedia.org/wiki/Amortization_calculator](http://en.wikipedia.org/wiki/Amortization_calculator)

';

第三十四章:流程控制 for循环

最后更新于:2022-04-02 01:46:24

在这关于流程控制的最后一章中,我们将看看另一种 shell 循环构造。for 循环不同于 while 和 until 循环,因为 在循环中,它提供了一种处理序列的方式。这证明在编程时非常有用。因此在 bash 脚本中,for 循环是非常流行的构造。

实现一个 for 循环,很自然的,要用 for 命令。在现代版的 bash 中,有两种可用的 for 循环格式。

## for: 传统 shell 格式

原来的 for 命令语法是:

~~~

for variable [in words]; do

commands

done

~~~

这里的 variable 是一个变量的名字,这个变量在循环执行期间会增加,words 是一个可选的条目列表, 其值会按顺序赋值给 variable,commands 是在每次循环迭代中要执行的命令。

在命令行中 for 命令是很有用的。我们可以很容易的说明它是如何工作的:

~~~

[me@linuxbox ~]$ for i in A B C D; do echo $i; done

A

B

C

D

~~~

在这个例子中,for 循环有一个四个单词的列表:“A”,“B”,“C”,和 “D”。由于这四个单词的列表,for 循环会执行四次。 每次循环执行的时候,就会有一个单词赋值给变量 i。在循环体内,我们有一个 echo 命令会显示 i 变量的值,来演示赋值结果。 正如 while 和 until 循环,done 关键字会关闭循环。

for 命令真正强大的功能是我们可以通过许多有趣的方式创建 words 列表。例如,通过花括号展开:

~~~

[me@linuxbox ~]$ for i in {A..D}; do echo $i; done

A

B

C

D

~~~

或者路径名展开:

~~~

[me@linuxbox ~]$ for i in distros*.txt; do echo $i; done

distros-by-date.txt

distros-dates.txt

distros-key-names.txt

distros-key-vernums.txt

distros-names.txt

distros.txt

distros-vernums.txt

distros-versions.txt

~~~

或者命令替换:

~~~

#!/bin/bash

# longest-word : find longest string in a file

while [[ -n $1 ]]; do

if [[ -r $1 ]]; then

max_word=

max_len=0

for i in $(strings $1); do

len=$(echo $i | wc -c)

if (( len > max_len )); then

max_len=$len

max_word=$i

fi

done

echo "$1: '$max_word' ($max_len characters)"

fi

shift

done

~~~

在这个示例中,我们要在一个文件中查找最长的字符串。当在命令行中给出一个或多个文件名的时候, 该程序会使用 strings 程序(其包含在 GNU binutils 包中),为每一个文件产生一个可读的文本格式的 “words” 列表。 然后这个 for 循环依次处理每个单词,判断当前这个单词是否为目前为止找到的最长的一个。当循环结束的时候,显示出最长的单词。

如果省略掉 for 命令的可选项 words 部分,for 命令会默认处理位置参数。 我们将修改 longest-word 脚本,来使用这种方式:

~~~

#!/bin/bash

# longest-word2 : find longest string in a file

for i; do

if [[ -r $i ]]; then

max_word=

max_len=0

for j in $(strings $i); do

len=$(echo $j | wc -c)

if (( len > max_len )); then

max_len=$len

max_word=$j

fi

done

echo "$i: '$max_word' ($max_len characters)"

fi

done

~~~

正如我们所看到的,我们已经更改了最外围的循环,用 for 循环来代替 while 循环。通过省略 for 命令的 words 列表, 用位置参数替而代之。在循环体内,之前的变量 i 已经改为变量 j。同时 shift 命令也被淘汰掉了。

> 为什么是 i?

>

> 你可能已经注意到上面所列举的 for 循环的实例都选择 i 作为变量。为什么呢? 实际上没有具体原因,除了传统习惯。 for 循环使用的变量可以是任意有效的变量,但是 i 是最常用的一个,其次是 j 和 k。

>

> 这一传统的基础源于 Fortran 编程语言。在 Fortran 语言中,以字母 I,J,K,L 和 M 开头的未声明变量的类型 自动设为整形,而以其它字母开头的变量则为实数类型(带有小数的数字)。这种行为导致程序员使用变量 I,J,和 K 作为循环变量, 因为当需要一个临时变量(正如循环变量)的时候,使用它们工作量比较少。这也引出了如下基于 fortran 的俏皮话:

>

> “神是真实的,除非是声明的整数。”

## for: C 语言格式

最新版本的 bash 已经添加了第二种格式的 for 命令语法,该语法相似于 C 语言中的 for 语法格式。 其它许多编程语言也支持这种格式:

~~~

for (( expression1; expression2; expression3 )); do

commands

done

~~~

这里的 expression1,expression2,和 expression3 都是算术表达式,commands 是每次循环迭代时要执行的命令。 在行为方面,这相当于以下构造形式:

~~~

(( expression1 ))

while (( expression2 )); do

commands

(( expression3 ))

done

~~~

expression1 用来初始化循环条件,expression2 用来决定循环结束的时间,还有在每次循环迭代的末尾会执行 expression3。

这里是一个典型应用:

~~~

#!/bin/bash

# simple_counter : demo of C style for command

for (( i=0; i<5; i=i+1 )); do

echo $i

done

~~~

脚本执行之后,产生如下输出:

~~~

[me@linuxbox ~]$ simple_counter

0

1

2

3

4

~~~

在这个示例中,expression1 初始化变量 i 的值为0,expression2 允许循环继续执行只要变量 i 的值小于5, 还有每次循环迭代时,expression3 会把变量 i 的值加1。

C 语言格式的 for 循环对于需要一个数字序列的情况是很有用处的。我们将在接下来的两章中看到几个这样的应用实例。

## 总结

学习了 for 命令的知识,现在我们将对我们的 sys_info_page 脚本做最后的改进。 目前,这个 report_home_space 函数看起来像这样:

~~~

report_home_space () {

if [[ $(id -u) -eq 0 ]]; then

cat <<- _EOF_

Home Space Utilization (All Users)

$(du -sh /home/*)

_EOF_

else

cat <<- _EOF_

Home Space Utilization ($USER)

$(du -sh $HOME)

_EOF_

fi

return

}

~~~

下一步,我们将重写它,以便提供每个用户家目录的更详尽信息,并且包含用户家目录中文件和目录的总个数:

~~~

report_home_space () {

local format="%8s%10s%10s\n"

local i dir_list total_files total_dirs total_size user_name

if [[ $(id -u) -eq 0 ]]; then

dir_list=/home/*

user_name="All Users"

else

dir_list=$HOME

user_name=$USER

fi

echo "

Home Space Utilization ($user_name)

"

for i in $dir_list; do

total_files=$(find $i -type f | wc -l)

total_dirs=$(find $i -type d | wc -l)

total_size=$(du -sh $i | cut -f 1)

echo "

$i

"

echo "

"

printf "$format" "Dirs" "Files" "Size"

printf "$format" "----" "-----" "----"

printf "$format" $total_dirs $total_files $total_size

echo ""

done

return

}

~~~

这次重写应用了目前为止我们学过的许多知识。我们仍然测试超级用户(superuser),但是我们在 if 语句块内 设置了一些随后会在 for 循环中用到的变量,来取代在 if 语句块内执行完备的动作集合。我们添加了给 函数添加了几个本地变量,并且使用 printf 来格式化输出。

## 拓展阅读

* 《高级 Bash 脚本指南》有一章关于循环的内容,其中列举了各种各样的 for 循环实例:

[http://tldp.org/LDP/abs/html/loops1.html](http://tldp.org/LDP/abs/html/loops1.html)

* 《Bash 参考手册》描述了循环复合命令,包括了 for 循环:

[http://www.gnu.org/software/bash/manual/bashref.html#Looping-Constructs](http://www.gnu.org/software/bash/manual/bashref.html#Looping-Constructs)

第三十三章:位置参数

最后更新于:2022-04-02 01:46:22

现在我们的程序还缺少一种本领,就是接收和处理命令行选项和参数的能力。在这一章中,我们将探究一些能 让程序访问命令行内容的 shell 性能。

## 访问命令行

shell 提供了一个称为位置参数的变量集合,这个集合包含了命令行中所有独立的单词。这些变量按照从0到9给予命名。 可以以这种方式讲明白:

~~~

#!/bin/bash

# posit-param: script to view command line parameters

echo "

\$0 = $0

\$1 = $1

\$2 = $2

\$3 = $3

\$4 = $4

\$5 = $5

\$6 = $6

\$7 = $7

\$8 = $8

\$9 = $9

"

~~~

一个非常简单的脚本,显示从 $0 到 $9 所有变量的值。当不带命令行参数执行该脚本时,输出结果如下:

~~~

[me@linuxbox ~]$ posit-param

$0 = /home/me/bin/posit-param

$1 =

$2 =

$3 =

$4 =

$5 =

$6 =

$7 =

$8 =

$9 =

~~~

即使不带命令行参数,位置参数 $0 总会包含命令行中出现的第一个单词,也就是已执行程序的路径名。 当带参数执行脚本时,我们看看输出结果:

~~~

[me@linuxbox ~]$ posit-param a b c d

$0 = /home/me/bin/posit-param

$1 = a

$2 = b

$3 = c

$4 = d

$5 =

$6 =

$7 =

$8 =

$9 =

~~~

注意: 实际上通过参数展开方式你可以访问的参数个数多于9个。只要指定一个大于9的数字,用花括号把该数字括起来就可以。 例如 ${10}, ${55}, ${211},等等。

### 确定参数个数

另外 shell 还提供了一个名为 $#,可以得到命令行参数个数的变量:

~~~

#!/bin/bash

# posit-param: script to view command line parameters

echo "

Number of arguments: $#

\$0 = $0

\$1 = $1

\$2 = $2

\$3 = $3

\$4 = $4

\$5 = $5

\$6 = $6

\$7 = $7

\$8 = $8

\$9 = $9

"

~~~

结果是:

~~~

[me@linuxbox ~]$ posit-param a b c d

Number of arguments: 4

$0 = /home/me/bin/posit-param

$1 = a

$2 = b

$3 = c

$4 = d

$5 =

$6 =

$7 =

$8 =

$9 =

~~~

### shift - 访问多个参数的利器

但是如果我们给一个程序添加大量的命令行参数,会怎么样呢? 正如下面的例子:

~~~

[me@linuxbox ~]$ posit-param *

Number of arguments: 82

$0 = /home/me/bin/posit-param

$1 = addresses.ldif

$2 = bin

$3 = bookmarks.html

$4 = debian-500-i386-netinst.iso

$5 = debian-500-i386-netinst.jigdo

$6 = debian-500-i386-netinst.template

$7 = debian-cd_info.tar.gz

$8 = Desktop

$9 = dirlist-bin.txt

~~~

在这个例子运行的环境下,通配符 * 展开成82个参数。我们如何处理那么多的参数? 为此,shell 提供了一种方法,尽管笨拙,但可以解决这个问题。执行一次 shift 命令, 就会导致所有的位置参数 “向下移动一个位置”。事实上,用 shift 命令也可以 处理只有一个参数的情况(除了其值永远不会改变的变量 $0):

~~~

#!/bin/bash

# posit-param2: script to display all arguments

count=1

while [[ $# -gt 0 ]]; do

echo "Argument $count = $1"

count=$((count + 1))

shift

done

~~~

每次 shift 命令执行的时候,变量 $2 的值会移动到变量 $1 中,变量 $3 的值会移动到变量 $2 中,依次类推。 变量 $# 的值也会相应的减1。

在该 posit-param2 程序中,我们编写了一个计算剩余参数数量,只要参数个数不为零就会继续执行的 while 循环。 我们显示当前的位置参数,每次循环迭代变量 count 的值都会加1,用来计数处理的参数数量, 最后,执行 shift 命令加载 $1,其值为下一个位置参数的值。这里是程序运行后的输出结果:

~~~

[me@linuxbox ~]$ posit-param2 a b c d

Argument 1 = a

Argument 2 = b

Argument 3 = c

Argument 4 = d

~~~

### 简单应用

即使没有 shift 命令,也可以用位置参数编写一个有用的应用。举例说明,这里是一个简单的输出文件信息的程序:

~~~

#!/bin/bash

# file_info: simple file information program

PROGNAME=$(basename $0)

if [[ -e $1 ]]; then

echo -e "\nFile Type:"

file $1

echo -e "\nFile Status:"

stat $1

else

echo "$PROGNAME: usage: $PROGNAME file" >&2

exit 1

fi

~~~

这个程序显示一个具体文件的文件类型(由 file 命令确定)和文件状态(来自 stat 命令)。该程序一个有意思 的特点是 PROGNAME 变量。它的值就是 basename $0 命令的执行结果。这个 basename 命令清除 一个路径名的开头部分,只留下一个文件的基本名称。在我们的程序中,basename 命令清除了包含在 $0 位置参数 中的路径名的开头部分,$0 中包含着我们示例程序的完整路径名。当构建提示信息正如程序结尾的使用信息的时候, basename $0 的执行结果就很有用处。按照这种方式编码,可以重命名该脚本,且程序信息会自动调整为 包含相应的程序名称。

### Shell 函数中使用位置参数

正如位置参数被用来给 shell 脚本传递参数一样,它们也能够被用来给 shell 函数传递参数。为了说明这一点, 我们将把 file_info 脚本转变成一个 shell 函数:

~~~

file_info () {

# file_info: function to display file information

if [[ -e $1 ]]; then

echo -e "\nFile Type:"

file $1

echo -e "\nFile Status:"

stat $1

else

echo "$FUNCNAME: usage: $FUNCNAME file" >&2

return 1

fi

}

~~~

现在,如果一个包含 shell 函数 file_info 的脚本调用该函数,且带有一个文件名参数,那这个参数会传递给 file_info 函数。

通过此功能,我们可以写出许多有用的 shell 函数,这些函数不仅能在脚本中使用,也可以用在 .bashrc 文件中。

注意那个 PROGNAME 变量已经改成 shell 变量 FUNCNAME 了。shell 会自动更新 FUNCNAME 变量,以便 跟踪当前执行的 shell 函数。注意位置参数 $0 总是包含命令行中第一项的完整路径名(例如,该程序的名字), 但不会包含这个我们可能期望的 shell 函数的名字。

## 处理集体位置参数

有时候把所有的位置参数作为一个集体来管理是很有用的。例如,我们可能想为另一个程序编写一个 “包裹程序”。 这意味着我们会创建一个脚本或 shell 函数,来简化另一个程序的执行。包裹程序提供了一个神秘的命令行选项 列表,然后把这个参数列表传递给下一级的程序。

为此 shell 提供了两种特殊的参数。他们二者都能扩展成完整的位置参数列表,但以相当微妙的方式略有不同。它们是:

表 32-1: * 和 @ 特殊参数

| 参数 | 描述 |

| $* | 展开成一个从1开始的位置参数列表。当它被用双引号引起来的时候,展开成一个由双引号引起来 的字符串,包含了所有的位置参数,每个位置参数由 shell 变量 IFS 的第一个字符(默认为一个空格)分隔开。 |

| $@ | 展开成一个从1开始的位置参数列表。当它被用双引号引起来的时候, 它把每一个位置参数展开成一个由双引号引起来的分开的字符串。 |

下面这个脚本用程序中展示了这些特殊参数:

~~~

#!/bin/bash

# posit-params3 : script to demonstrate $* and $@

print_params () {

echo "\$1 = $1"

echo "\$2 = $2"

echo "\$3 = $3"

echo "\$4 = $4"

}

pass_params () {

echo -e "\n" '$* :'; print_params $*

echo -e "\n" '"$*" :'; print_params "$*"

echo -e "\n" '$@ :'; print_params $@

echo -e "\n" '"$@" :'; print_params "$@"

}

pass_params "word" "words with spaces"

~~~

在这个相当复杂的程序中,我们创建了两个参数: “word” 和 “words with spaces”,然后把它们 传递给 pass_params 函数。这个函数,依次,再把两个参数传递给 print_params 函数, 使用了特殊参数 $* 和 $@ 提供的四种可用方法。脚本运行后,揭示了这两个特殊参数存在的差异:

~~~

[me@linuxbox ~]$ posit-param3

$* :

$1 = word

$2 = words

$3 = with

$4 = spaces

"$*" :

$1 = word words with spaces

$2 =

$3 =

$4 =

$@ :

$1 = word

$2 = words

$3 = with

$4 = spaces

"$@" :

$1 = word

$2 = words with spaces

$3 =

$4 =

~~~

通过我们的参数,$* 和 $@ 两个都产生了一个有四个词的结果:

~~~

word words with spaces

"$*" produces a one word result:

"word words with spaces"

"$@" produces a two word result:

"word" "words with spaces"

~~~

这个结果符合我们实际的期望。我们从中得到的教训是尽管 shell 提供了四种不同的得到位置参数列表的方法, 但到目前为止, “$@” 在大多数情况下是最有用的方法,因为它保留了每一个位置参数的完整性。

## 一个更复杂的应用

经过长时间的间断,我们将恢复程序 sys_info_page 的工作。我们下一步要给程序添加如下几个命令行选项:

* **输出文件**。 我们将添加一个选项,以便指定一个文件名,来包含程序的输出结果。 选项格式要么是 -f file,要么是 --file file

* **交互模式**。这个选项将提示用户输入一个输出文件名,然后判断是否指定的文件已经存在了。如果文件存在, 在覆盖这个存在的文件之前会提示用户。这个选项可以通过 -i 或者 --interactive 来指定。

* **帮助**。指定 -h 选项 或者是 --help 选项,可导致程序输出提示性的使用信息。

这里是处理命令行选项所需的代码:

~~~

usage () {

echo "$PROGNAME: usage: $PROGNAME [-f file | -i]"

return

}

# process command line options

interactive=

filename=

while [[ -n $1 ]]; do

case $1 in

-f | --file) shift

filename=$1

;;

-i | --interactive) interactive=1

;;

-h | --help) usage

exit

;;

*) usage >&2

exit 1

;;

esac

shift

done

~~~

首先,我们添加了一个叫做 usage 的 shell 函数,以便显示帮助信息,当启用帮助选项或敲写了一个未知选项的时候。

下一步,我们开始处理循环。当位置参数 $1 不为空的时候,这个循环会持续运行。在循环的底部,有一个 shift 命令, 用来提升位置参数,以便确保该循环最终会终止。在循环体内,我们使用了一个 case 语句来检查当前位置参数的值, 看看它是否匹配某个支持的选项。若找到了匹配项,就会执行与之对应的代码。若没有,就会打印出程序使用信息, 该脚本终止且执行错误。

处理 -f 参数的方式很有意思。当监测到 -f 参数的时候,会执行一次 shift 命令,从而提升位置参数 $1 为 伴随着 -f 选项的 filename 参数。

我们下一步添加代码来实现交互模式:

~~~

# interactive mode

if [[ -n $interactive ]]; then

while true; do

read -p "Enter name of output file: " filename

if [[ -e $filename ]]; then

read -p "'$filename' exists. Overwrite? [y/n/q] > "

case $REPLY in

Y|y) break

;;

Q|q) echo "Program terminated."

exit

;;

*) continue

;;

esac

elif [[ -z $filename ]]; then

continue

else

break

fi

done

fi

~~~

若 interactive 变量不为空,就会启动一个无休止的循环,该循环包含文件名提示和随后存在的文件处理代码。 如果所需要的输出文件已经存在,则提示用户覆盖,选择另一个文件名,或者退出程序。如果用户选择覆盖一个 已经存在的文件,则会执行 break 命令终止循环。注意 case 语句是怎样只检测用户选择了覆盖还是退出选项。 其它任何选择都会导致循环继续并提示用户再次选择。

为了实现这个输出文件名的功能,首先我们必须把现有的这个写页面(page-writing)的代码转变成一个 shell 函数, 一会儿就会明白这样做的原因:

~~~

write_html_page () {

cat <<- _EOF_

$TITLE

$TITLE

$TIMESTAMP

$(report_uptime)

$(report_disk_space)

$(report_home_space)

_EOF_

return

}

# output html page

if [[ -n $filename ]]; then

if touch $filename && [[ -f $filename ]]; then

write_html_page > $filename

else

echo "$PROGNAME: Cannot write file '$filename'" >&2

exit 1

fi

else

write_html_page

fi

~~~

解决 -f 选项逻辑的代码出现在以上程序片段的末尾。在这段代码中,我们测试一个文件名是否存在,若文件名存在, 则执行另一个测试看看该文件是不是可写文件。为此,会运行 touch 命令,紧随其后执行一个测试,来决定 touch 命令 创建的文件是否是个普通文件。这两个测试考虑到了输入是无效路径名(touch 命令执行失败),和一个普通文件已经存在的情况。

正如我们所看到的,程序调用 write_html_page 函数来生成实际的网页。函数输出要么直接定向到 标准输出(若 filename 变量为空的话)要么重定向到具体的文件中。

## 总结

伴随着位置参数的加入,现在我们能编写相当具有功能性的脚本。例如,重复性的任务,位置参数使得编写 非常有用的,可以放置在一个用户的 .bashrc 文件中的 shell 函数成为可能。

我们的 sys_info_page 程序日渐精进。这里是一个完整的程序清单,最新的更改用高亮显示:

~~~

#!/bin/bash

# sys_info_page: program to output a system information page

PROGNAME=$(basename $0)

TITLE="System Information Report For $HOSTNAME"

CURRENT_TIME=$(date +"%x %r %Z")

TIMESTAMP="Generated $CURRENT_TIME, by $USER"

report_uptime () {

cat <<- _EOF_

System Uptime

$(uptime)

_EOF_

return

}

report_disk_space () {

cat <<- _EOF_

Disk Space Utilization

$(df -h)

_EOF_

return

}

report_home_space () {

if [[ $(id -u) -eq 0 ]]; then

cat <<- _EOF_

Home Space Utilization (All Users)

$(du -sh /home/*)

_EOF_

else

cat <<- _EOF_

Home Space Utilization ($USER)

$(du -sh $HOME)

_EOF_

fi

return

}

usage () {

echo "$PROGNAME: usage: $PROGNAME [-f file | -i]"

return

}

write_html_page () {

cat <<- _EOF_

$TITLE

$TITLE

$TIMESTAMP

$(report_uptime)

$(report_disk_space)

$(report_home_space)

_EOF_

return

}

# process command line options

interactive=

filename=

while [[ -n $1 ]]; do

case $1 in

-f | --file) shift

filename=$1

;;

-i | --interactive) interactive=1

;;

-h | --help) usage

exit

;;

*) usage >&2

exit 1

;;

esac

shift

done

# interactive mode

if [[ -n $interactive ]]; then

while true; do

read -p "Enter name of output file: " filename

if [[ -e $filename ]]; then

read -p "'$filename' exists. Overwrite? [y/n/q] > "

case $REPLY in

Y|y) break

;;

Q|q) echo "Program terminated."

exit

;;

*) continue

;;

esac

fi

done

fi

# output html page

if [[ -n $filename ]]; then

if touch $filename && [[ -f $filename ]]; then

write_html_page > $filename

else

echo "$PROGNAME: Cannot write file '$filename'" >&2

exit 1

fi

else

write_html_page

fi

~~~

我们还没有完成。仍然还有许多事情我们可以做,可以改进。

## 拓展阅读

* Bash Hackers Wiki 上有一篇不错的关于位置参数的文章:

[http://wiki.bash-hackers.org/scripting/posparams](http://wiki.bash-hackers.org/scripting/posparams)

* Bash 的参考手册有一篇关于特殊参数的文章,包括 $* 和 $@:

[http://www.gnu.org/software/bash/manual/bashref.html#Special-Parameters](http://www.gnu.org/software/bash/manual/bashref.html#Special-Parameters)

* 除了本章讨论的技术之外,bash 还包含一个叫做 getopts 的内部命令,此命令也可以用来处理命令行参数。 bash 参考页面的 SHELL BUILTIN COMMANDS 一节介绍了这个命令,Bash Hackers Wiki 上也有对它的描述:

[http://wiki.bash-hackers.org/howto/getopts_tutorial](http://wiki.bash-hackers.org/howto/getopts_tutorial)

第三十二章:流程控制 case分支

最后更新于:2022-04-02 01:46:20

在这一章中,我们将继续看一下程序的流程控制。在第28章中,我们构建了一些简单的菜单并创建了用来 应对各种用户选择的程序逻辑。为此,我们使用了一系列的 if 命令来识别哪一个可能的选项已经被选中。 这种类型的构造经常出现在程序中,出现频率如此之多,以至于许多编程语言(包括 shell) 专门为多选决策提供了一种流程控制机制。

## case

Bash 的多选复合命令称为 case。它的语法规则如下所示:

~~~

case word in

[pattern [| pattern]...) commands ;;]...

esac

~~~

如果我们看一下第28章中的读菜单程序,我们就知道了用来应对一个用户选项的逻辑流程:

~~~

#!/bin/bash

# read-menu: a menu driven system information program

clear

echo "

Please Select:

1\. Display System Information

2\. Display Disk Space

3\. Display Home Space Utilization

0\. Quit

"

read -p "Enter selection [0-3] > "

if [[ $REPLY =~ ^[0-3]$ ]]; then

if [[ $REPLY == 0 ]]; then

echo "Program terminated."

exit

fi

if [[ $REPLY == 1 ]]; then

echo "Hostname: $HOSTNAME"

uptime

exit

fi

if [[ $REPLY == 2 ]]; then

df -h

exit

fi

if [[ $REPLY == 3 ]]; then

if [[ $(id -u) -eq 0 ]]; then

echo "Home Space Utilization (All Users)"

du -sh /home/*

else

echo "Home Space Utilization ($USER)"

du -sh $HOME

fi

exit

fi

else

echo "Invalid entry." >&2

exit 1

fi

~~~

使用 case 语句,我们可以用更简单的代码替换这种逻辑:

~~~

#!/bin/bash

# case-menu: a menu driven system information program

clear

echo "

Please Select:

1\. Display System Information

2\. Display Disk Space

3\. Display Home Space Utilization

0\. Quit

"

read -p "Enter selection [0-3] > "

case $REPLY in

0) echo "Program terminated."

exit

;;

1) echo "Hostname: $HOSTNAME"

uptime

;;

2) df -h

;;

3) if [[ $(id -u) -eq 0 ]]; then

echo "Home Space Utilization (All Users)"

du -sh /home/*

else

echo "Home Space Utilization ($USER)"

du -sh $HOME

fi

;;

*) echo "Invalid entry" >&2

exit 1

;;

esac

~~~

case 命令检查一个变量值,在我们这个例子中,就是 REPLY 变量的变量值,然后试图去匹配其中一个具体的模式。 当与之相匹配的模式找到之后,就会执行与该模式相关联的命令。若找到一个模式之后,就不会再继续寻找。

## 模式

这里 case 语句使用的模式和路径展开中使用的那些是一样的。模式以一个 “)” 为终止符。这里是一些有效的模式。

表32-1: case 模式实例

| 模式 | 描述 |

|------|-------|

| a) | 若单词为 “a”,则匹配 |

| [[:alpha:]]) | 若单词是一个字母字符,则匹配 |

| ???) | 若单词只有3个字符,则匹配 |

| *.txt) | 若单词以 “.txt” 字符结尾,则匹配 |

| *) | 匹配任意单词。把这个模式做为 case 命令的最后一个模式,是一个很好的做法, 可以捕捉到任意一个与先前模式不匹配的数值;也就是说,捕捉到任何可能的无效值。 |

这里是一个模式使用实例:

~~~

#!/bin/bash

read -p "enter word > "

case $REPLY in

[[:alpha:]]) echo "is a single alphabetic character." ;;

[ABC][0-9]) echo "is A, B, or C followed by a digit." ;;

???) echo "is three characters long." ;;

*.txt) echo "is a word ending in '.txt'" ;;

*) echo "is something else." ;;

esac

~~~

还可以使用竖线字符作为分隔符,把多个模式结合起来。这就创建了一个 “或” 条件模式。这对于处理诸如大小写字符很有用处。例如:

~~~

#!/bin/bash

# case-menu: a menu driven system information program

clear

echo "

Please Select:

A. Display System Information

B. Display Disk Space

C. Display Home Space Utilization

Q. Quit

"

read -p "Enter selection [A, B, C or Q] > "

case $REPLY in

q|Q) echo "Program terminated."

exit

;;

a|A) echo "Hostname: $HOSTNAME"

uptime

;;

b|B) df -h

;;

c|C) if [[ $(id -u) -eq 0 ]]; then

echo "Home Space Utilization (All Users)"

du -sh /home/*

else

echo "Home Space Utilization ($USER)"

du -sh $HOME

fi

;;

*) echo "Invalid entry" >&2

exit 1

;;

esac

~~~

这里,我们更改了 case-menu 程序的代码,用字母来代替数字做为菜单选项。注意新模式如何使得大小写字母都是有效的输入选项。

## 执行多个动作

早于版本号4.0的 bash,case 语法只允许执行与一个成功匹配的模式相关联的动作。 匹配成功之后,命令将会终止。这里我们看一个测试一个字符的脚本:

~~~

#!/bin/bash

# case4-1: test a character

read -n 1 -p "Type a character > "

echo

case $REPLY in

[[:upper:]]) echo "'$REPLY' is upper case." ;;

[[:lower:]]) echo "'$REPLY' is lower case." ;;

[[:alpha:]]) echo "'$REPLY' is alphabetic." ;;

[[:digit:]]) echo "'$REPLY' is a digit." ;;

[[:graph:]]) echo "'$REPLY' is a visible character." ;;

[[:punct:]]) echo "'$REPLY' is a punctuation symbol." ;;

[[:space:]]) echo "'$REPLY' is a whitespace character." ;;

[[:xdigit:]]) echo "'$REPLY' is a hexadecimal digit." ;;

esac

~~~

运行这个脚本,输出这些内容:

~~~

[me@linuxbox ~]$ case4-1

Type a character > a

'a' is lower case.

~~~

大多数情况下这个脚本工作是正常的,但若输入的字符不止与一个 POSIX 字符集匹配的话,这时脚本就会出错。 例如,字符 “a” 既是小写字母,也是一个十六进制的数字。早于4.0的 bash,对于 case 语法绝不能匹配 多个测试条件。现在的 bash 版本,添加 “;;&” 表达式来终止每个行动,所以现在我们可以做到这一点:

~~~

#!/bin/bash

# case4-2: test a character

read -n 1 -p "Type a character > "

echo

case $REPLY in

[[:upper:]]) echo "'$REPLY' is upper case." ;;&

[[:lower:]]) echo "'$REPLY' is lower case." ;;&

[[:alpha:]]) echo "'$REPLY' is alphabetic." ;;&

[[:digit:]]) echo "'$REPLY' is a digit." ;;&

[[:graph:]]) echo "'$REPLY' is a visible character." ;;&

[[:punct:]]) echo "'$REPLY' is a punctuation symbol." ;;&

[[:space:]]) echo "'$REPLY' is a whitespace character." ;;&

[[:xdigit:]]) echo "'$REPLY' is a hexadecimal digit." ;;&

esac

~~~

当我们运行这个脚本的时候,我们得到这些:

~~~

[me@linuxbox ~]$ case4-2

Type a character > a

'a' is lower case.

'a' is alphabetic.

'a' is a visible character.

'a' is a hexadecimal digit.

~~~

添加的 “;;&” 的语法允许 case 语句继续执行下一条测试,而不是简单地终止运行。

## 总结

case 命令是我们编程技巧口袋中的一个便捷工具。在下一章中我们将看到, 对于处理某些类型的问题来说,case 命令是一个完美的工具。

## 拓展阅读

* Bash 参考手册的条件构造一节详尽的介绍了 case 命令:

[http://tiswww.case.edu/php/chet/bash/bashref.html#SEC21](http://tiswww.case.edu/php/chet/bash/bashref.html#SEC21)

* 高级 Bash 脚本指南提供了更深一层的 case 应用实例:

[http://tldp.org/LDP/abs/html/testbranch.html](http://tldp.org/LDP/abs/html/testbranch.html)

';

第三十一章:疑难排解

最后更新于:2022-04-02 01:46:18

随着我们的脚本变得越来越复杂,当脚本运行错误,执行结果出人意料的时候, 我们就应该查看一下原因了。 在这一章中,我们将会看一些脚本中出现地常见错误类型,同时还会介绍几个可以跟踪和消除问题的有用技巧。

## 语法错误

一个普通的错误类型是语法。语法错误涉及到一些 shell 语法元素的拼写错误。大多数情况下,这类错误 会导致 shell 拒绝执行此脚本。

在以下讨论中,我们将使用下面这个脚本,来说明常见的错误类型:

~~~

#!/bin/bash

# trouble: script to demonstrate common errors

number=1

if [ $number = 1 ]; then

echo "Number is equal to 1."

else

echo "Number is not equal to 1."

fi

~~~

参看脚本内容,我们知道这个脚本执行成功了:

~~~

[me@linuxbox ~]$ trouble

Number is equal to 1.

~~~

### 丢失引号

如果我们编辑我们的脚本,并从跟随第一个 echo 命令的参数中,删除其末尾的双引号:

~~~

#!/bin/bash

# trouble: script to demonstrate common errors

number=1

if [ $number = 1 ]; then

echo "Number is equal to 1.

else

echo "Number is not equal to 1."

fi

~~~

观察发生了什么:

~~~

[me@linuxbox ~]$ trouble

/home/me/bin/trouble: line 10: unexpected EOF while looking for

matching `"'

/home/me/bin/trouble: line 13: syntax error: unexpected end of file

~~~

这个脚本产生了两个错误。有趣地是,所报告的行号不是引号被删除的地方,而是程序中后面的文本行。 我们能知道为什么,如果我们跟随丢失引号文本行之后的程序。bash 会继续寻找右引号,直到它找到一个, 其就是这个紧随第二个 echo 命令之后的引号。找到这个引号之后,bash 变得很困惑,并且 if 命令的语法 被破坏了,因为现在这个 fi 语句在一个用引号引起来的(但是开放的)字符串里面。

在冗长的脚本中,此类错误很难找到。使用带有语法高亮的编辑器将会帮助查找错误。如果安装了 vim 的完整版, 通过输入下面的命令,可以使语法高亮生效:

~~~

:syntax on

~~~

### 丢失或意外的标记

另一个常见错误是忘记补全一个复合命令,比如说 if 或者是 while。让我们看一下,如果 我们删除 if 命令中测试之后的分号,会出现什么情况:

~~~

#!/bin/bash

# trouble: script to demonstrate common errors

number=1

if [ $number = 1 ] then

echo "Number is equal to 1."

else

echo "Number is not equal to 1."

fi

~~~

结果是这样的:

~~~

[me@linuxbox ~]$ trouble

/home/me/bin/trouble: line 9: syntax error near unexpected token

`else'

/home/me/bin/trouble: line 9: `else'

~~~

再次,错误信息指向一个错误,其出现的位置靠后于实际问题所在的文本行。所发生的事情真是相当有意思。我们记得, if 能够接受一系列命令,并且会计算列表中最后一个命令的退出代码。在我们的程序中,我们打算这个列表由 单个命令组成,即 [,测试的同义词。这个 [ 命令把它后面的东西看作是一个参数列表。在我们这种情况下, 有三个参数: $number,=,和 ]。由于删除了分号,单词 then 被添加到参数列表中,从语法上讲, 这是合法的。随后的 echo 命令也是合法的。它被解释为命令列表中的另一个命令,if 将会计算命令的 退出代码。接下来遇到单词 else,但是它出局了,因为 shell 把它认定为一个 保留字(对于 shell 有特殊含义的单词),而不是一个命令名,因此报告错误信息。

### 预料不到的展开

可能有这样的错误,它们仅会间歇性地出现在一个脚本中。有时候这个脚本执行正常,其它时间会失败, 这是因为展开结果造成的。如果我们归还我们丢掉的分号,并把 number 的数值更改为一个空变量,我们 可以示范一下:

~~~

#!/bin/bash

# trouble: script to demonstrate common errors

number=

if [ $number = 1 ]; then

echo "Number is equal to 1."

else

echo "Number is not equal to 1."

fi

~~~

运行这个做了修改的脚本,得到以下输出:

~~~

[me@linuxbox ~]$ trouble

/home/me/bin/trouble: line 7: [: =: unary operator expected

Number is not equal to 1.

~~~

我们得到一个相当神秘的错误信息,其后是第二个 echo 命令的输出结果。这问题是由于 test 命令中 number 变量的展开结果造成的。当此命令:

~~~

[ $number = 1 ]

~~~

经过展开之后,number 变为空值,结果就是这样:

~~~

[ = 1 ]

~~~

这是无效的,所以就产生了错误。这个 = 操作符是一个二元操作符(它要求每边都有一个数值),但是第一个数值是缺失的, 这样 test 命令就期望用一个一元操作符(比如 -z)来代替。进一步说,因为 test 命令运行失败了(由于错误), 这个 if 命令接收到一个非零退出代码,因此执行第二个 echo 命令。

通过为 test 命令中的第一个参数添加双引号,可以更正这个问题:

~~~

[ "$number" = 1 ]

~~~

然后当展开操作发生地时候,执行结果将会是这样:

~~~

[ "" = 1 ]

~~~

其得到了正确的参数个数。除了代表空字符串之外,引号应该被用于这样的场合,一个要展开 成多单词字符串的数值,及其包含嵌入式空格的文件名。

## 逻辑错误

不同于语法错误,逻辑错误不会阻止脚本执行。虽然脚本会正常运行,但是它不会产生期望的结果, 归咎于脚本的逻辑问题。虽然有不计其数的可能的逻辑错误,但下面是一些在脚本中找到的最常见的 逻辑错误类型:

1. 不正确的条件表达式。很容易编写一个错误的 if/then/else 语句,并且执行错误的逻辑。 有时候逻辑会被颠倒,或者是逻辑结构不完整。

2. “超出一个值”错误。当编写带有计数器的循环语句的时候,为了计数在恰当的点结束,循环语句 可能要求从 0 开始计数,而不是从 1 开始,这有可能会被忽视。这些类型的错误要不导致循环计数太多,而“超出范围”, 要不就是过早的结束了一次迭代,从而错过了最后一次迭代循环。

3. 意外情况。大多数逻辑错误来自于程序碰到了程序员没有预见到的数据或者情况。这也 可以包括出乎意料的展开,比如说一个包含嵌入式空格的文件名展开成多个命令参数而不是单个的文件名。

### 防错编程

当编程的时候,验证假设非常重要。这意味着要仔细得计算脚本所使用的程序和命令的退出状态。 这里有个实例,基于一个真实的故事。为了在一台重要的服务器中执行维护任务,一位不幸的系统管理员写了一个脚本。 这个脚本包含下面两行代码:

~~~

cd $dir_name

rm *

~~~

从本质上来说,这两行代码没有任何问题,只要是变量 dir_name 中存储的目录名字存在就可以。但是如果不是这样会发生什么事情呢?在那种情况下,cd 命令会运行失败, 脚本会继续执行下一行代码,将会删除当前工作目录中的所有文件。完成不是期望的结果! 由于这种设计策略,这个倒霉的管理员销毁了服务器中的一个重要部分。

让我们看一些能够提高这个设计的方法。首先,在 cd 命令执行成功之后,再运行 rm 命令,可能是明智的选择。

~~~

cd $dir_name && rm *

~~~

这样,如果 cd 命令运行失败后,rm 命令将不会执行。这样比较好,但是仍然有可能未设置变量 dir_name 或其变量值为空,从而导致删除了用户家目录下面的所有文件。这个问题也能够避免,通过检验变量 dir_name 中包含的目录名是否真正地存在:

~~~

[[ -d $dir_name ]] && cd $dir_name && rm *

~~~

通常,当某种情况(比如上述问题)发生的时候,最好是终止脚本执行,并对这种情况提示错误信息:

~~~

if [[ -d $dir_name ]]; then

if cd $dir_name; then

rm *

else

echo "cannot cd to '$dir_name'" >&2

exit 1

fi

else

echo "no such directory: '$dir_name'" >&2

exit 1

fi

~~~

这里,我们检验了两种情况,一个名字,看看它是否为一个真正存在的目录,另一个是 cd 命令是否执行成功。 如果任一种情况失败,就会发送一个错误说明信息到标准错误,然后脚本终止执行,并用退出状态 1 表明脚本执行失败。

### 验证输入

一个良好的编程习惯是如果一个程序可以接受输入数据,那么这个程序必须能够应对它所接受的任意数据。这 通常意味着必须非常仔细地筛选输入数据,以确保只有有效的输入数据才能被程序用来做进一步地处理。在前面章节 中我们学习 read 命令的时候,我们遇到过一个这样的例子。一个脚本中包含了下面一条测试语句, 用来验证一个选择菜单:

~~~

[[ $REPLY =~ ^[0-3]$ ]]

~~~

这条测试语句非常明确。只有当用户输入是一个位于 0 到 3 范围内(包括 0 和 3)的数字的时候, 这条语句才返回一个 0 退出状态。而其它任何输入概不接受。有时候编写这类测试条件非常具有挑战性, 但是为了能产出一个高质量的脚本,付出还是必要的。

> 设计是时间的函数

>

> 当我还是一名大学生,在学习工业设计的时候,一位明智的教授说过一个项目的设计程度是由 给定设计师的时间量来决定的。如果给你五分钟来设计一款能够 “杀死苍蝇” 的产品,你会设计出一个苍蝇拍。如果给你五个月的时间,你可能会制作出激光制导的 “反苍蝇系统”。

>

> 同样的原理适用于编程。有时候一个 “快速但粗糙” 的脚本就可以解决问题, 但这个脚本只能被其作者使用一次。这类脚本很常见,为了节省气力也应该被快速地开发出来。 所以这些脚本不需要太多的注释和防错检查。相反,如果一个脚本打算用于生产使用,也就是说, 某个重要任务或者多个客户会不断地用到它,此时这个脚本就需要非常谨慎小心地开发了。

## 测试

在各类软件开发中(包括脚本),测试是一个重要的环节。在开源世界中有一句谚语,“早发布,常发布”,这句谚语就反映出这个事实(测试的重要性)。 通过提早和经常发布,软件能够得到更多曝光去使用和测试。经验表明如果在开发周期的早期发现 bug,那么这些 bug 就越容易定位,而且越能低成本 的修复。

在之前的讨论中,我们知道了如何使用 stubs 来验证程序流程。在脚本开发的最初阶段,它们是一项有价值的技术 来检测我们的工作进度。

让我们看一下上面的文件删除问题,为了轻松测试,看看如何修改这些代码。测试原本那个代码片段将是危险的,因为它的目的是要删除文件, 但是我们可以修改代码,让测试安全:

~~~

if [[ -d $dir_name ]]; then

if cd $dir_name; then

echo rm * # TESTING

else

echo "cannot cd to '$dir_name'" >&2

exit 1

fi

else

echo "no such directory: '$dir_name'" >&2

exit 1

fi

exit # TESTING

~~~

因为在满足出错条件的情况下代码可以打印出有用信息,所以我们没有必要再添加任何额外信息了。 最重要的改动是仅在 rm 命令之前放置了一个 echo 命令, 为的是把 rm 命令及其展开的参数列表打印出来,而不是执行实际的 rm 命令语句。这个改动可以安全的执行代码。 在这段代码的末尾,我们放置了一个 exit 命令来结束测试,从而防止执行脚本其它部分的代码。 这个需求会因脚本的设计不同而变化。

我们也在代码中添加了一些注释,用来标记与测试相关的改动。当测试完成之后,这些注释可以帮助我们找到并删除所有的更改。

### 测试案例

为了执行有用的测试,开发和使用好的测试案例是很重要的。这个要求可以通过谨慎地选择输入数据或者运行边缘案例和极端案例来完成。 在我们的代码片段中(是非常简单的代码),我们想要知道在下面的三种具体情况下这段代码是怎样执行的:

1. dir_name 包含一个已经存在的目录的名字

2. dir_name 包含一个不存在的目录的名字

3. dir_name 为空

通过执行以上每一个测试条件,就达到了一个良好的测试覆盖率。

正如设计,测试也是一个时间的函数。不是每一个脚本功能都需要做大量的测试。问题关键是确定什么功能是最重要的。因为 测试若发生故障会存在如此潜在的破坏性,所以我们的代码片在设计和测试段期间都应值得仔细推敲。

## 调试

如果测试暴露了脚本中的一个问题,那下一步就是调试了。“一个问题”通常意味着在某种情况下,这个脚本的执行 结果不是程序员所期望的结果。若是这种情况,我们需要仔细确认这个脚本实际到底要完成什么任务,和为什么要这样做。 有时候查找 bug 要牵涉到许多监测工作。一个设计良好的脚本会对查找错误有帮助。设计良好的脚本应该具备防卫能力, 能够监测异常条件,并能为用户提供有用的反馈信息。 然而有时候,出现的问题相当稀奇,出人意料,这时候就需要更多的调试技巧了。

### 找到问题区域

在一些脚本中,尤其是一些代码比较长的脚本,有时候隔离脚本中与出现的问题相关的代码区域对查找问题很有效。 隔离的代码区域并不总是真正的错误所在,但是隔离往往可以深入了解实际的错误原因。可以用来隔离代码的一项 技巧是“添加注释”。例如,我们的文件删除代码可以修改成这样,从而决定注释掉的这部分代码是否导致了一个错误:

~~~

if [[ -d $dir_name ]]; then

if cd $dir_name; then

rm *

else

echo "cannot cd to '$dir_name'" >&2

exit 1

fi

# else

#

echo "no such directory: '$dir_name'" >&2

#

exit 1

fi

~~~

通过给脚本中的一个逻辑区块内的每条语句的开头添加一个注释符号,我们就阻止了这部分代码的执行。然后可以再次执行测试, 来看看清除的代码是否影响了错误的行为。

### 追踪

在一个脚本中,错误往往是由意想不到的逻辑流导致的。也就是说,脚本中的一部分代码或者从未执行,或是以错误的顺序, 或在错误的时间给执行了。为了查看真实的程序流,我们使用一项叫做追踪(tracing)的技术。

一种追踪方法涉及到在脚本中添加可以显示程序执行位置的提示性信息。我们可以添加提示信息到我们的代码片段中:

~~~

echo "preparing to delete files" >&2

if [[ -d $dir_name ]]; then

if cd $dir_name; then

echo "deleting files" >&2

rm *

else

echo "cannot cd to '$dir_name'" >&2

exit 1

fi

else

echo "no such directory: '$dir_name'" >&2

exit 1

fi

echo "file deletion complete" >&2

~~~

我们把提示信息输出到标准错误输出,让其从标准输出中分离出来。我们也没有缩进包含提示信息的语句,这样 想要删除它们的时候,能比较容易找到它们。

当这个脚本执行的时候,就可能看到文件删除操作已经完成了:

~~~

[me@linuxbox ~]$ deletion-script

preparing to delete files

deleting files

file deletion complete

[me@linuxbox ~]$

~~~

bash 还提供了一种名为追踪的方法,这种方法可通过 -x 选项和 set 命令加上 -x 选项两种途径实现。 拿我们之前的 trouble 脚本为例,给该脚本的第一行语句添加 -x 选项,我们就能追踪整个脚本。

~~~

#!/bin/bash -x

# trouble: script to demonstrate common errors

number=1

if [ $number = 1 ]; then

echo "Number is equal to 1."

else

echo "Number is not equal to 1."

fi

~~~

当脚本执行后,输出结果看起来像这样:

~~~

[me@linuxbox ~]$ trouble

+ number=1

+ '[' 1 = 1 ']'

+ echo 'Number is equal to 1.'

Number is equal to 1.

~~~

追踪生效后,我们看到脚本命令展开后才执行。行首的加号表明追踪的迹象,使其与常规输出结果区分开来。 加号是追踪输出的默认字符。它包含在 PS4(提示符4)shell 变量中。可以调整这个变量值让提示信息更有意义。 这里,我们修改该变量的内容,让其包含脚本中追踪执行到的当前行的行号。注意这里必须使用单引号是为了防止变量展开,直到 提示符真正使用的时候,就不需要了。

~~~

[me@linuxbox ~]$ export PS4='$LINENO + '

[me@linuxbox ~]$ trouble

5 + number=1

7 + '[' 1 = 1 ']'

8 + echo 'Number is equal to 1.'

Number is equal to 1.

~~~

我们可以使用 set 命令加上 -x 选项,为脚本中的一块选择区域,而不是整个脚本启用追踪。

~~~

#!/bin/bash

# trouble: script to demonstrate common errors

number=1

set -x # Turn on tracing

if [ $number = 1 ]; then

echo "Number is equal to 1."

else

echo "Number is not equal to 1."

fi

set +x # Turn off tracing

~~~

我们使用 set 命令加上 -x 选项来启动追踪,+x 选项关闭追踪。这种技术可以用来检查一个有错误的脚本的多个部分。

### 执行时检查数值

伴随着追踪,在脚本执行的时候显示变量的内容,以此知道脚本内部的工作状态,往往是很用的。 使用额外的 echo 语句通常会奏效。

~~~

#!/bin/bash

# trouble: script to demonstrate common errors

number=1

echo "number=$number" # DEBUG

set -x # Turn on tracing

if [ $number = 1 ]; then

echo "Number is equal to 1."

else

echo "Number is not equal to 1."

fi

set +x # Turn off tracing

~~~

在这个简单的示例中,我们只是显示变量 number 的数值,并为其添加注释,随后利于其识别和清除。 当查看脚本中的循环和算术语句的时候,这种技术特别有用。

## 总结

在这一章中,我们仅仅看了几个在脚本开发期间会出现的问题。当然,还有很多。这章中描述的技术对查找 大多数的常见错误是有效的。调试是一种艺术,可以通过开发经验,在知道如何避免错误(整个开发过程中不断测试) 以及在查找 bug(有效利用追踪)两方面都会得到提升。

## 拓展阅读

* Wikipedia 上面有两篇关于语法和逻辑错误的短文:

[http://en.wikipedia.org/wiki/Syntax_error](http://en.wikipedia.org/wiki/Syntax_error)

[http://en.wikipedia.org/wiki/logic_error](http://en.wikipedia.org/wiki/logic_error)

* 网上有很多关于技术层面的 bash 编程的资源:

[http://mywiki.wooledge.org/BashPitfalls](http://mywiki.wooledge.org/BashPitfalls)

[http://tldp.org/LDP/abs/html/gotchas.html](http://tldp.org/LDP/abs/html/gotchas.html)

[http://www.gnu.org/software/bash/manual/html_node/Reserved-Word-Index.html](http://www.gnu.org/software/bash/manual/html_node/Reserved-Word-Index.html)

* 想要学习从编写良好的 Unix 程序中得知的基本概念,可以参考 Eric Raymond 的《Unix 编程的艺术》这本 伟大的著作。书中的许多想法都能适用于 shell 脚本:

[http://www.faqs.org/docs/artu/](http://www.faqs.org/docs/artu/)

[http://www.faqs.org/docs/artu/ch01s06.html](http://www.faqs.org/docs/artu/ch01s06.html)

* 对于真正的高强度的调试,参考这个 Bash Debugger:

[http://bashdb.sourceforge.net/](http://bashdb.sourceforge.net/)

';

第三十章:流程控制 while/until 循环

最后更新于:2022-04-02 01:46:15

在前面的章节中,我们开发了菜单驱动程序,来产生各种各样的系统信息。虽然程序能够运行, 但它仍然存在重大的可用问题。它只能执行单一的选择,然后终止。更糟糕地是,如果做了一个 无效的选择,程序会以错误终止,而没有给用户提供再试一次的机会。如果我们能构建程序, 以致于程序能够重复显示菜单,而且能一次由一次的选择,直到用户选择退出程序,这样的程序会更好一些。

在这一章中,我们将看一个叫做循环的程序概念,其可用来使程序的某些部分重复。shell 为循环提供了三个复合命令。 本章我们将查看其中的两个命令,随后章节介绍第三个命令。

## 循环

日常生活中充满了重复性的活动。每天去散步,遛狗,切胡萝卜,所有任务都要重复一系列的步骤。 让我们以切胡萝卜为例。如果我们用伪码表达这种活动,它可能看起来像这样:

1. 准备切菜板

2. 准备菜刀

3. 把胡萝卜放到切菜板上

4. 提起菜刀

5. 向前推进胡萝卜

6. 切胡萝卜

7. 如果切完整个胡萝卜,就退出,要不然回到第四步继续执行

从第四步到第七步形成一个循环。重复执行循环内的动作直到满足条件“切完整个胡萝卜”。

### while

bash 能够表达相似的想法。比方说我们想要按照顺序从1到5显示五个数字。可如下构造一个 bash 脚本:

~~~

#!/bin/bash

# while-count: display a series of numbers

count=1

while [ $count -le 5 ]; do

echo $count

count=$((count + 1))

done

echo "Finished."

~~~

当执行的时候,这个脚本显示如下信息:

~~~

[me@linuxbox ~]$ while-count

1

2

3

4

5

Finished.

~~~

while 命令的语法是:

~~~

while commands; do commands; done

~~~

和 if 一样, while 计算一系列命令的退出状态。只要退出状态为零,它就执行循环内的命令。 在上面的脚本中,创建了变量 count ,并初始化为1。 while 命令将会计算 test 命令的退出状态。 只要 test 命令返回退出状态零,循环内的所有命令就会执行。每次循环结束之后,会重复执行 test 命令。 第六次循环之后, count 的数值增加到6, test 命令不再返回退出状态零,且循环终止。 程序继续执行循环之后的语句。

我们可以使用一个 while 循环,来提高前面章节的 read-menu 程序:

~~~

#!/bin/bash

# while-menu: a menu driven system information program

DELAY=3 # Number of seconds to display results

while [[ $REPLY != 0 ]]; do

clear

cat <<- _EOF_

Please Select:

1\. Display System Information

2\. Display Disk Space

3\. Display Home Space Utilization

0\. Quit

_EOF_

read -p "Enter selection [0-3] > "

if [[ $REPLY =~ ^[0-3]$ ]]; then

if [[ $REPLY == 1 ]]; then

echo "Hostname: $HOSTNAME"

uptime

sleep $DELAY

fi

if [[ $REPLY == 2 ]]; then

df -h

sleep $DELAY

fi

if [[ $REPLY == 3 ]]; then

if [[ $(id -u) -eq 0 ]]; then

echo "Home Space Utilization (All Users)"

du -sh /home/*

else

echo "Home Space Utilization ($USER)"

du -sh $HOME

fi

sleep $DELAY

fi

else

echo "Invalid entry."

sleep $DELAY

fi

done

echo "Program terminated."

~~~

通过把菜单包含在 while 循环中,每次用户选择之后,我们能够让程序重复显示菜单。只要 REPLY 不 等于”0”,循环就会继续,菜单就能显示,从而用户有机会重新选择。每次动作完成之后,会执行一个 sleep 命令,所以在清空屏幕和重新显示菜单之前,程序将会停顿几秒钟,为的是能够看到选项输出结果。 一旦 REPLY 等于“0”,则表示选择了“退出”选项,循环就会终止,程序继续执行 done 语句之后的代码。

## 跳出循环

bash 提供了两个内部命令,它们可以用来在循环内部控制程序流程。这个 break 命令立即终止一个循环, 且程序继续执行循环之后的语句。这个 continue 命令导致程序跳过循环中剩余的语句,且程序继续执行 下一次循环。这里我们看看采用了 break 和 continue 两个命令的 while-menu 程序版本:

~~~

#!/bin/bash

# while-menu2: a menu driven system information program

DELAY=3 # Number of seconds to display results

while true; do

clear

cat <<- _EOF_

Please Select:

1\. Display System Information

2\. Display Disk Space

3\. Display Home Space Utilization

0\. Quit

_EOF_

read -p "Enter selection [0-3] > "

if [[ $REPLY =~ ^[0-3]$ ]]; then

if [[ $REPLY == 1 ]]; then

echo "Hostname: $HOSTNAME"

uptime

sleep $DELAY

continue

fi

if [[ $REPLY == 2 ]]; then

df -h

sleep $DELAY

continue

fi

if [[ $REPLY == 3 ]]; then

if [[ $(id -u) -eq 0 ]]; then

echo "Home Space Utilization (All Users)"

du -sh /home/*

else

echo "Home Space Utilization ($USER)"

du -sh $HOME