3.6 scikit-learn:Python中的机器学习

最后更新于:2022-04-01 11:22:08

# 3.6 scikit-learn:Python中的机器学习

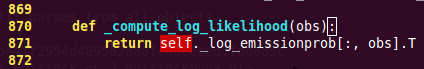

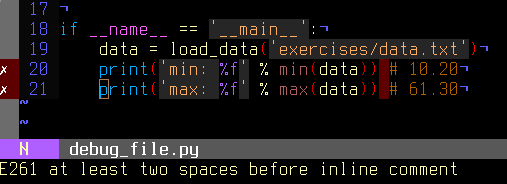

In [5]:

```

%matplotlib inline

import numpy as np

```

> 作者: Fabian Pedregosa, Gael Varoquaux

**先决条件**

Numpy, Scipy

IPython

matplotlib

scikit-learn ([http://scikit-learn.org](http://scikit-learn.org))

**章节内容**

```

加载样例数据集

- 学习与预测

分类

- KNN分类器

- 分类的支持向量机(SVMs)

聚类:将观察值聚集在一起

- K-means聚类

使用主成分分析的降维

把所有都放在一起:面孔识别

线性模型:从回归到简约

- 简约模型

模型选择:选择预测器和参数

- 网格搜索和交叉验证预测器

```

**警告**:从版本0.9(在2011年9月发布)起,scikit-learn导入路径从scikits.learn 改为 sklearn

## 3.5.1 加载样例数据集

首先,我们将加载一些数据来玩玩。我们将使用的数据是知名的非常简单的花数据鸢尾花数据集。

我们有150个鸢尾花观察值指定了一些测量:花萼宽带、花萼长度、花瓣宽度和花瓣长度,以及对应的子类:Iris setosa、Iris versicolor和Iris virginica。

将数据集加载为Python对象:

In [1]:

```

from sklearn import datasets

iris = datasets.load_iris()

```

这个数据存储在`.data`成员中,是一个 (n_samples, n_features) 数组。

In [2]:

```

iris.data.shape

```

Out[2]:

```

(150, 4)

```

每个观察的类别存储在数据集的`.target`属性中。这是长度是n_samples的1D整型数组 :

In [3]:

```

iris.target.shape

```

Out[3]:

```

(150,)

```

In [4]:

```

import numpy as np

np.unique(iris.target)

```

Out[4]:

```

array([0, 1, 2])

```

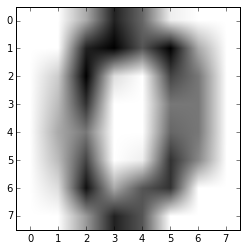

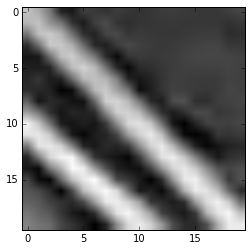

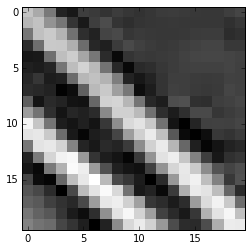

数据重排的例子:digits 数据集

digits 数据集包含1797 图像,每一个是8X8像素的图片,代表一个手写的数字

In [15]:

```

digits = datasets.load_digits()

digits.images.shape

```

Out[15]:

```

(1797, 8, 8)

```

In [8]:

```

import pylab as pl

pl.imshow(digits.images[0], cmap=pl.cm.gray_r)

```

Out[8]:

```

<matplotlib.image.AxesImage at 0x109abd990>

```

要在scikit使用这个数据集,我们将每个8X8图片转化为一个长度为64的向量

In [9]:

```

data = digits.images.reshape((digits.images.shape[0], -1))

```

### 3.5.1.1 学习和预测

现在我们有了一些数据,我们想要从上面学习并且在新的数据做预测。在scikit-learn中,我们通过创建一个预测器,并调用他的 fit(X, Y) 方法从现有数据上学习。

In [11]:

```

from sklearn import svm

clf = svm.LinearSVC()

clf.fit(iris.data, iris.target) # 从数据学习

```

Out[11]:

```

LinearSVC(C=1.0, class_weight=None, dual=True, fit_intercept=True,

intercept_scaling=1, loss='squared_hinge', max_iter=1000,

multi_class='ovr', penalty='l2', random_state=None, tol=0.0001,

verbose=0)

```

一旦我们从数据中学习,我们可以用我们的模型来预测未见过的数据的最可能输出:

In [12]:

```

clf.predict([[ 5.0, 3.6, 1.3, 0.25]])

```

Out[12]:

```

array([0])

```

**注意**:我们可以通过由下滑线结尾的属性来访问模型的参数:

In [13]:

```

clf.coef_

```

Out[13]:

```

array([[ 0.18424728, 0.45122657, -0.80794162, -0.45070597],

[ 0.05691797, -0.89245895, 0.39682582, -0.92882381],

[-0.85072494, -0.98678239, 1.38091241, 1.86550868]])

```

## 3.5.2 分类

### 3.5.2.1 KNN分类器

可能最简单的分类器是最接近的邻居: 给定一个观察,使用在N维空间中训练样例中最接近它标签,这里N是每个样例的特征数。

K个最临近的邻居分类器内部使用基于ball tree的算法,用来代表训练的样例。

**KNN (K个最临近邻居) 分类的例子:**

In [14]:

```

# 创建并拟合一个最临近邻居分类器

from sklearn import neighbors

knn = neighbors.KNeighborsClassifier()

knn.fit(iris.data, iris.target)

```

Out[14]:

```

KNeighborsClassifier(algorithm='auto', leaf_size=30, metric='minkowski',

metric_params=None, n_neighbors=5, p=2, weights='uniform')

```

In [15]:

```

knn.predict([[0.1, 0.2, 0.3, 0.4]])

```

Out[15]:

```

array([0])

```

**训练集和测试集**

当用学习算法进行实验时,重要的一点是不要用拟合预测器的数据来测试预测器的预测力。实际上,我们通常会在测试集上得到准确的预测。

In [16]:

```

perm = np.random.permutation(iris.target.size)

iris.data = iris.data[perm]

iris.target = iris.target[perm]

knn.fit(iris.data[:100], iris.target[:100])

```

Out[16]:

```

KNeighborsClassifier(algorithm='auto', leaf_size=30, metric='minkowski',

metric_params=None, n_neighbors=5, p=2, weights='uniform')

```

In [17]:

```

knn.score(iris.data[100:], iris.target[100:])

```

Out[17]:

```

0.95999999999999996

```

额外的问题: 为什么我们使用随机排列?

### 3.5.2.2 分类的支持向量机 (SVMs))

#### 3.5.2.2.1 线性支持向量机

SVMs试图构建一个最大化两个类的间距的超平面。它选取输入的一个子集,称为支持向量,这个子集中的观察距离分隔超平面最近。

In [18]:

```

from sklearn import svm

svc = svm.SVC(kernel='linear')

svc.fit(iris.data, iris.target)

```

Out[18]:

```

SVC(C=1.0, cache_size=200, class_weight=None, coef0=0.0, degree=3, gamma=0.0,

kernel='linear', max_iter=-1, probability=False, random_state=None,

shrinking=True, tol=0.001, verbose=False)

```

在scikit-learn实现了几种支持向量机。最常用的是`svm.SVC`、`svm.NuSVC` 和 `svm.LinearSVC`; “SVC” 代表支持向量分类器 (也存在用于回归的SVMs, 在scikit-learn被称为“SVR”)。

**练习**

在digits数据集上训练`svm.SVC`。留下最后的10%,在这些观察上测试预测的效果。

#### 3.5.2.2.2 使用核 (kernel))

类通常并不是都能用超平面分隔,因此,有一个不仅仅是线性也可能是多项式或者幂的决策函数是明智的 :

**线性核 (kernel)**

In [19]:

```

svc = svm.SVC(kernel='linear')

```

**多项式核 (kernel)**

In [20]:

```

svc = svm.SVC(kernel='poly', degree=3)

# degree: 多项式的阶

```

**RBF核 (kernel) (径向基核函数)**

In [21]:

```

svc = svm.SVC(kernel='rbf')

# gamma: 径向基核大小的倒数

```

**练习** 以上列出的核哪一个在digits数据集上有较好的预测表现?

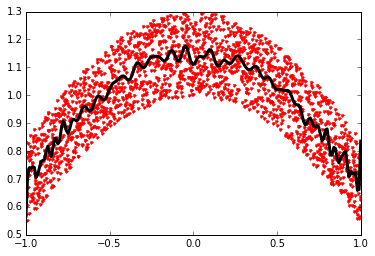

## 3.5.3 聚类 : 将观察值分组

以鸢尾花 (iris) 数据集为例,如果有三类鸢尾花,但是并不能访问他们标签,我们可以尝试**非观察学习** : 通过一些标准将观察**聚类**分入一些组。

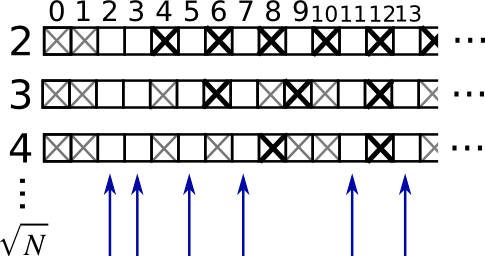

### 3.5.3.1 K-means 聚类

最简单的聚类算法是k-means。这个算法将集合分成k个组,将每个观察值分配给一个组,以便使观察值 (在n维空间) 到组平均值的距离最小;然后重新计算平均数。循环进行这个操作直到组收敛,比如达到最大的`max_iter`循环次数。

(k-means的另一个实现在SciPy的`cluster`包中。`scikit-learn`实现的不同在于提供了一个对象API和一些额外的功能,包括智能初始化。)

In [2]:

```

from sklearn import cluster, datasets

iris = datasets.load_iris()

k_means = cluster.KMeans(n_clusters=3)

k_means.fit(iris.data)

```

Out[2]:

```

KMeans(copy_x=True, init='k-means++', max_iter=300, n_clusters=3, n_init=10,

n_jobs=1, precompute_distances='auto', random_state=None, tol=0.0001,

verbose=0)

```

In [25]:

```

print k_means.labels_[::10]

```

```

[0 0 0 0 0 1 1 1 1 1 2 2 2 2 2]

```

In [26]:

```

print iris.target[::10]

```

```

[0 0 0 0 0 1 1 1 1 1 2 2 2 2 2]

```

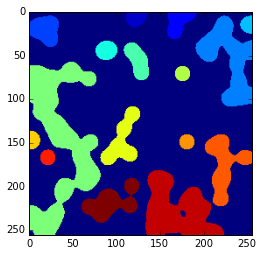

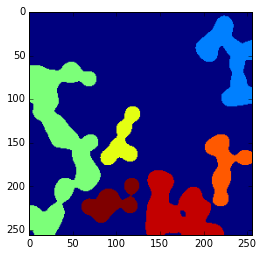

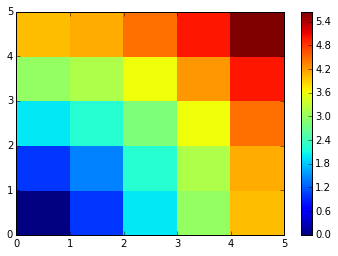

**真实情况**

**K-means (3 组)**

**K-means (8 组)**

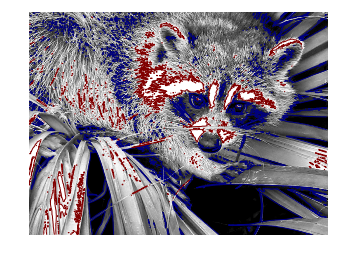

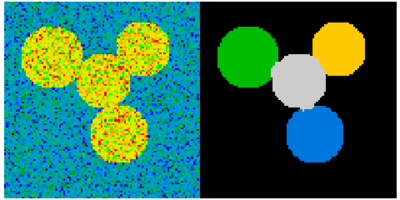

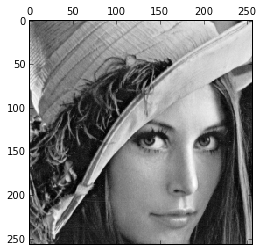

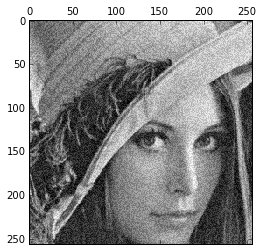

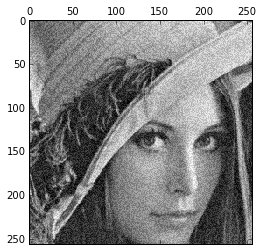

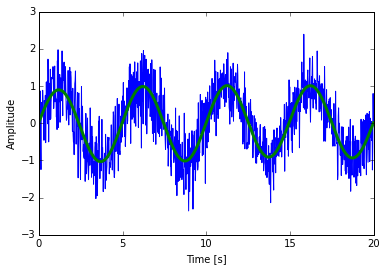

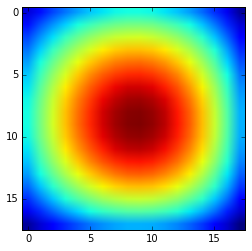

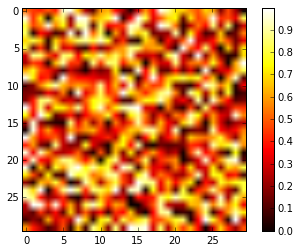

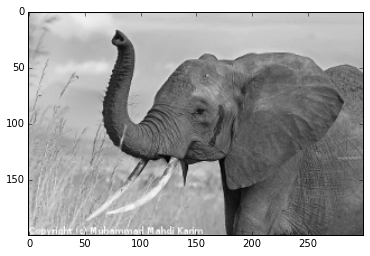

**在图像压缩中的应用**

聚类可以看做从信息中选取一组观察的方式。例如,这个技术可以被用来posterize一个图像 (将连续渐变色调转换为更少色调的一些区域):

In [5]:

```

from scipy import misc

lena = misc.lena().astype(np.float32)

X = lena.reshape((-1, 1)) # We need an (n_sample, n_feature) array

k_means = cluster.KMeans(n_clusters=5)

k_means.fit(X)

```

Out[5]:

```

KMeans(copy_x=True, init='k-means++', max_iter=300, n_clusters=5, n_init=10,

n_jobs=1, precompute_distances='auto', random_state=None, tol=0.0001,

verbose=0)

```

In [6]:

```

values = k_means.cluster_centers_.squeeze()

labels = k_means.labels_

lena_compressed = np.choose(labels, values)

lena_compressed.shape = lena.shape

```

源图片

K-means quantization

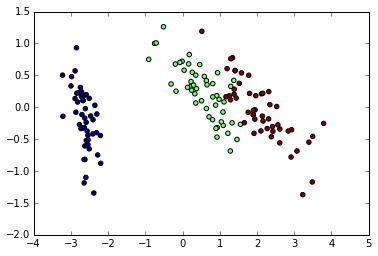

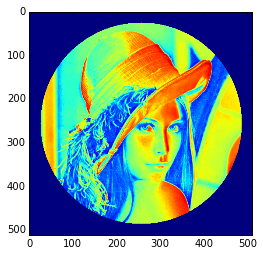

## 3.5.4 使用主成分分析的降维

上面观察展开的云点在一个方向非常平坦,因此,一个特征几乎可以准确用另两个特征来计算。PCA找到数据并不平坦的方向,并且可以通过投影到一个子空间中来减少维度。

**警告**: 根据你的scikit-learn版本,PCA将在模块`decomposition`或`pca`中。

In [3]:

```

from sklearn import decomposition

pca = decomposition.PCA(n_components=2)

pca.fit(iris.data)

```

Out[3]:

```

PCA(copy=True, n_components=2, whiten=False)

```

In [4]:

```

X = pca.transform(iris.data)

```

现在我们可视化(转换的)鸢尾花数据集:

In [6]:

```

import pylab as pl

pl.scatter(X[:, 0], X[:, 1], c=iris.target)

```

Out[6]:

```

<matplotlib.collections.PathCollection at 0x107502b90>

```

PCA并不仅仅在高纬度数据集的可视化上有用。它也可以用于帮助加速对高维不太高效的有监督方法的预处理步骤。

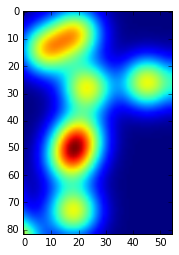

## 3.5.5 把所有的东西放在一起: 面孔识别

展示使用主成分分析来降维和用执行向量机分类的面孔识别的例子。

In [ ]:

```

"""

Stripped-down version of the face recognition example by Olivier Grisel

http://scikit-learn.org/dev/auto_examples/applications/face_recognition.html

## original shape of images: 50, 37

"""

import numpy as np

import pylab as pl

from sklearn import cross_val, datasets, decomposition, svm

# ..

# .. load data ..

lfw_people = datasets.fetch_lfw_people(min_faces_per_person=70, resize=0.4)

perm = np.random.permutation(lfw_people.target.size)

lfw_people.data = lfw_people.data[perm]

lfw_people.target = lfw_people.target[perm]

faces = np.reshape(lfw_people.data, (lfw_people.target.shape[0], -1))

train, test = iter(cross_val.StratifiedKFold(lfw_people.target, k=4)).next()

X_train, X_test = faces[train], faces[test]

y_train, y_test = lfw_people.target[train], lfw_people.target[test]

# ..

# .. dimension reduction ..

pca = decomposition.RandomizedPCA(n_components=150, whiten=True)

pca.fit(X_train)

X_train_pca = pca.transform(X_train)

X_test_pca = pca.transform(X_test)

# ..

# .. classification ..

clf = svm.SVC(C=5., gamma=0.001)

clf.fit(X_train_pca, y_train)

# ..

# .. predict on new images ..

for i in range(10):

print lfw_people.target_names[clf.predict(X_test_pca[i])[0]]

_ = pl.imshow(X_test[i].reshape(50, 37), cmap=pl.cm.gray)

_ = raw_input()

```

完整代码: [faces.py](http://scipy-lectures.github.io/_downloads/faces.py)

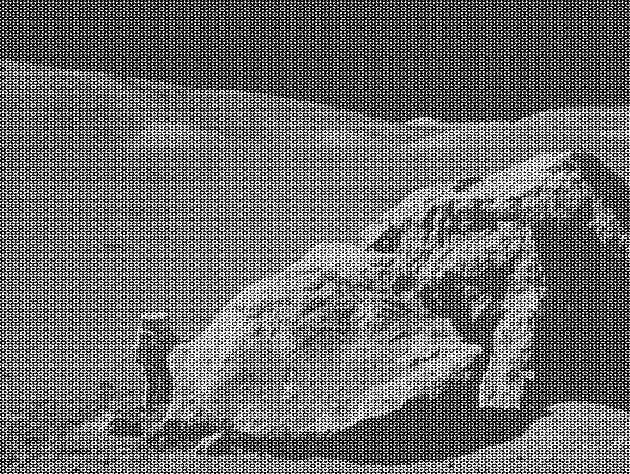

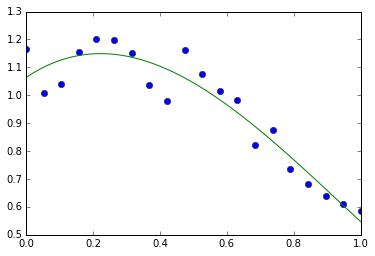

## 3.5.6 线性模型: 从回归到简约

**糖尿病数据集** 糖尿病数据集包含442个病人测量的10个生理学变量 (年龄、性别、体重、血压),以及一个一年后病情发展的标记:

In [8]:

```

diabetes = datasets.load_diabetes()

diabetes_X_train = diabetes.data[:-20]

diabetes_X_test = diabetes.data[-20:]

diabetes_y_train = diabetes.target[:-20]

diabetes_y_test = diabetes.target[-20:]

```

目前的任务是从生理学变量中预测疾病发生。

### 3.5.6.1 简约模型

要改善问题的条件 (信息量小的变量、减少高纬度的诅咒、作为一个特征预处理等等), 仅选择信息量大的特征,并且将没有信息量的特征设置为0将非常有趣。这种惩罚手段,称为**Lasso**, 可以将一些系数设置为0。这个方法称为**简约方法**,简约性可以看做是Occam剃刀的一个应用: 相比于复杂的模型更偏好简单的模型。

In [9]:

```

from sklearn import linear_model

regr = linear_model.Lasso(alpha=.3)

regr.fit(diabetes_X_train, diabetes_y_train)

```

Out[9]:

```

Lasso(alpha=0.3, copy_X=True, fit_intercept=True, max_iter=1000,

normalize=False, positive=False, precompute=False, random_state=None,

selection='cyclic', tol=0.0001, warm_start=False)

```

In [10]:

```

regr.coef_ # 非常简约的系数

```

Out[10]:

```

array([ 0\. , -0\. , 497.34075682, 199.17441034,

-0\. , -0\. , -118.89291545, 0\. ,

430.9379595 , 0\. ])

```

In [11]:

```

regr.score(diabetes_X_test, diabetes_y_test)

```

Out[11]:

```

0.55108354530029779

```

分数与线性回归 (最小二乘) 很相似:

In [12]:

```

lin = linear_model.LinearRegression()

lin.fit(diabetes_X_train, diabetes_y_train)

```

Out[12]:

```

LinearRegression(copy_X=True, fit_intercept=True, n_jobs=1, normalize=False)

```

In [13]:

```

lin.score(diabetes_X_test, diabetes_y_test)

```

Out[13]:

```

0.58507530226905713

```

**相同问题的不同算法** 不同的算法可以用于解决相同的数学问题。例如,_sklearn_中的Lasso对象用_坐标下降法_来解lasso回归,这种方法在大数据集上有效。但是,_sklearn_也提供了_LassoLARS_对象,使用_LARS_,一种在权重向量估计非常稀疏的问题上非常高效的方法,即有很少观察值的问题。

## 3.5.7 模型选择: 选择预测器及其参数

### 3.5.7.1 网格搜索和交叉验证预测器

#### 3.5.7.1.1 网格搜索

scikit-learn提供了一个对象,给定数据,计算预测器在一个参数网格的分数,并且选择可以最大化交叉验证分数的参数。这个对象用一个构建中的预测器并且暴露了一个预测器的探索集API:

In [16]:

```

from sklearn import svm, grid_search

gammas = np.logspace(-6, -1, 10)

svc = svm.SVC()

clf = grid_search.GridSearchCV(estimator=svc, param_grid=dict(gamma=gammas), n_jobs=-1)

clf.fit(digits.data[:1000], digits.target[:1000])

```

Out[16]:

```

GridSearchCV(cv=None, error_score='raise',

estimator=SVC(C=1.0, cache_size=200, class_weight=None, coef0=0.0, degree=3, gamma=0.0,

kernel='rbf', max_iter=-1, probability=False, random_state=None,

shrinking=True, tol=0.001, verbose=False),

fit_params={}, iid=True, loss_func=None, n_jobs=-1,

param_grid={'gamma': array([ 1.00000e-06, 3.59381e-06, 1.29155e-05, 4.64159e-05,

1.66810e-04, 5.99484e-04, 2.15443e-03, 7.74264e-03,

2.78256e-02, 1.00000e-01])},

pre_dispatch='2*n_jobs', refit=True, score_func=None, scoring=None,

verbose=0)

```

In [20]:

```

clf.best_score_

```

Out[20]:

```

0.93200000000000005

```

In [22]:

```

clf.best_estimator_.gamma

```

Out[22]:

```

0.00059948425031894088

```

默认,_GridSearchCV_使用三折交叉验证。但是,如果识别传递了一个分类器都不是一个回归器,它将使用一个分层三折。

#### 3.5.7.1.2 交叉验证预测器

一个算法一个算法为基础的设置参数来进行交叉验证更有效。这也就是为什么,对于一些预测器,scikit-learn暴露一个“CV”预测器, 这个预测器通过交叉验证自动设置他们的参数:

In [23]:

```

from sklearn import linear_model, datasets

lasso = linear_model.LassoCV()

diabetes = datasets.load_diabetes()

X_diabetes = diabetes.data

y_diabetes = diabetes.target

lasso.fit(X_diabetes, y_diabetes)

```

Out[23]:

```

LassoCV(alphas=None, copy_X=True, cv=None, eps=0.001, fit_intercept=True,

max_iter=1000, n_alphas=100, n_jobs=1, normalize=False, positive=False,

precompute='auto', random_state=None, selection='cyclic', tol=0.0001,

verbose=False)

```

In [26]:

```

# 预测器自动选择他的lambda:

lasso.alpha_

```

Out[26]:

```

0.012291895087486173

```

这些预测器与他们的对等物调用方式类似,只是在名字后面增加了‘CV’。

**练习** 在糖尿病数据集中,找到最优化的正则化参数alpha。

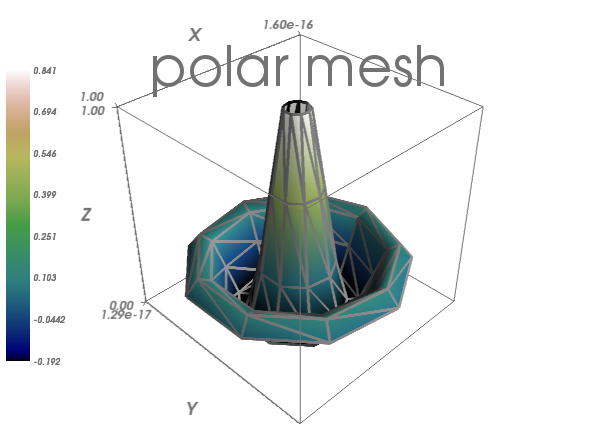

3.5 使用Mayavi进行3D作图

最后更新于:2022-04-01 11:22:05

# 3.5 使用Mayavi进行3D作图

3.4 Traits:创建交互对话

最后更新于:2022-04-01 11:22:03

# 3.4 Traits:创建交互对话

In [10]:

```

%matplotlib inline

import numpy as np

```

> 作者 : _Didrik Pinte_

Traits项目允许你可以向Python项目属性方便的添加验证、初始化、委托、通知和图形化界面。

在这个教程中,我们将研究Traits工具包并且学习如何动态减少你所写的锅炉片代码,进行快速的GUI应用开发,以及理解Enthought工具箱中其他部分的想法。

Traits和Enthought工具箱是基于BSD-style证书的开源项目。

**目标受众**

## Python中高级程序员

**要求**

* [wxPython](http://www.wxpython.org/)、[PyQt](https://riverbankcomputing.com/software/pyqt/intro)或[PySide](https://pyside.github.io/docs/pyside/)之一

* Numpy和Scipy

* [Enthought工具箱](http://code.enthought.com/projects)

* 所有需要的软件都可以通过安装[EPD免费版](https://store.enthought.com/)来获得

**教程内容**

* 介绍

* 例子

* Traits是什么

* 初始化

* 验证

* 文档

* 可视化: 打开一个对话框

* 推迟

* 通知

* 一些更高级的特征

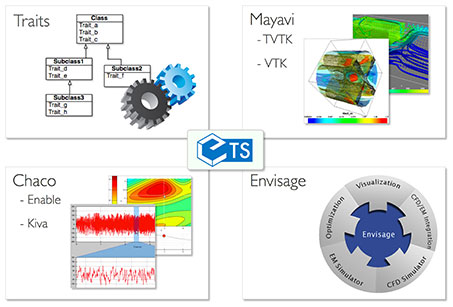

## 3.4.1 介绍

Enthought工具箱可以构建用于数据分析、2D绘图和3D可视化的精密应用框架。这些强力可重用的组块是在BSD-style证书下发布的。

Enthought工具箱主要的包是:

* Traits - 基于组块的方式构建我们的应用。

* Kiva - 2D原生支持基于路径的rendering、affine转化、alpha混合及其它。

* Enable - 基于对象的2D绘图画布。

* Chaco - 绘图工具箱,用于构建复杂的交互2D图像。

* Mayavi -基于VTK的3D科学数据可视化

* Envisage - 应用插件框架,用于构建脚本化可扩展的应用

在这篇教程中,我们将关注Traits。

## 3.4.2 例子

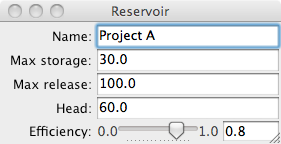

在整个这篇教程中,我们将使用基于水资源管理简单案例的一个样例。我们将试着建模一个水坝和水库系统。水库和水坝有下列参数:

* 名称

* 水库的最小和最大容量 [$hm^3$]

* 水坝的高度和宽度[$m$]

* 蓄水面积[$km^2$]

* 水压头[$m$]

* 涡轮的动力[$MW$]

* 最小和最大放水量[$m^3/s$]

* 涡轮的效率

水库有一个已知的运转情况。一部分是与基于放水量有关的能量产生。估算水力发电机电力生产的简单公式是$P = \rho hrgk$, 其中

* P 以瓦特为单位的功率,

* \rho 是水的密度 ($~1000 kg/m^3$),

* h 是水的高度,

* r 是以每秒立方米为单位的流动率,

* g 重力加速度,9.8 $m/s^2$,

* k 是效率系数,范围从0到1。

年度的电能生产取决于可用的水供给。在一些设施中,水流率在一年中可能差10倍。

运行状态的第二个部分是蓄水量,蓄水量(storage)依赖于控制和非控制参数:

$storage_{t+1} = storage_t + inflows - release - spillage - irrigation$

本教程中使用的数据不是真实的,可能甚至在现实中没有意义。

## 3.4.3 Traits是什么

trait是可以用于常规Python对象属性的类型定义,给出属性的一些额外特性:

* 标准化:

* 初始化

* 验证

* 推迟

* 通知

* 可视化

* 文档

类可以自由混合基于trait的属性与通用Python属性,或者选择允许在这个类中只使用固定的或开放的trait属性集。类定义的Trait属性自动继承自由这个类衍生的其他子类。

创建一个traits类的常用方式是通过扩展**HasTraits**基础类,并且定义类的traits :

In [1]:

```

from traits.api import HasTraits, Str, Float

class Reservoir(HasTraits):

name = Str

max_storage = Float

```

对Traits 3.x用户来说

如果使用Traits 3.x, 你需要调整traits包的命名空间:

* traits.api应该为enthought.traits.api

* traitsui.api应该为enthought.traits.ui.api

像这样使用traits类和使用其他Python类一样简单。注意,trait值通过关键词参数传递:

In [2]:

```

reservoir = Reservoir(name='Lac de Vouglans', max_storage=605)

```

### 3.4.3.1 初始化

所有的traits都有一个默认值来初始化变量。例如,基础python类型有如下的trait等价物:

| Trait | Python类型 | 内置默认值 |

| --- | --- | --- |

| Bool | Boolean | False |

| Complex | Complex number | 0+0j |

| Float | Floating point number | 0.0 |

| Int | Plain integer | 0 |

| Long | Long integer | 0L |

| Str | String | '' |

| Unicode | Unicode | u'' |

存在很多其他预定义的trait类型: Array, Enum, Range, Event, Dict, List, Color, Set, Expression, Code, Callable, Type, Tuple, etc。

自定义默认值可以在代码中定义:

In [3]:

```

from traits.api import HasTraits, Str, Float

class Reservoir(HasTraits):

name = Str

max_storage = Float(100)

reservoir = Reservoir(name='Lac de Vouglans')

```

复杂初始化

当一个trait需要复杂的初始化时,可以实施_XXX_默认魔法方法。当调用XXX trait时,它会被懒惰的调用。例如:

In [4]:

```

def _name_default(self):

""" Complex initialisation of the reservoir name. """

return 'Undefined'

```

### 3.4.3.2 验证

当用户试图设置trait的内容时,每一个trait都会被验证:

In [5]:

```

reservoir = Reservoir(name='Lac de Vouglans', max_storage=605)

reservoir.max_storage = '230'

```

```

---------------------------------------------------------------------------

TraitError Traceback (most recent call last)

<ipython-input-5-cbed071af0b9> in <module>()

1 reservoir = Reservoir(name='Lac de Vouglans', max_storage=605)

2

----> 3 reservoir.max_storage = '230'

/Library/Python/2.7/site-packages/traits/trait_handlers.pyc in error(self, object, name, value)

170 """

171 raise TraitError( object, name, self.full_info( object, name, value ),

--> 172 value ) 173

174 def full_info ( self, object, name, value ):

TraitError: The 'max_storage' trait of a Reservoir instance must be a float, but a value of '230' <type 'str'> was specified.

```

### 3.4.3.3 文档

从本质上说,所有的traits都提供关于模型自身的文档。创建类的声明方式使它是自解释的:

In [6]:

```

from traits.api import HasTraits, Str, Float

class Reservoir(HasTraits):

name = Str

max_storage = Float(100)

```

trait的**desc**元数据可以用来提供关于trait更多的描述信息:

In [7]:

```

from traits.api import HasTraits, Str, Float

class Reservoir(HasTraits):

name = Str

max_storage = Float(100, desc='Maximal storage [hm3]')

```

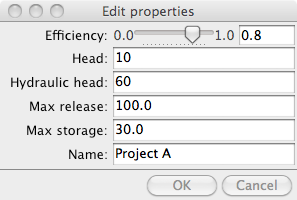

现在让我们来定义完整的reservoir类:

In [8]:

```

from traits.api import HasTraits, Str, Float, Range

class Reservoir(HasTraits):

name = Str

max_storage = Float(1e6, desc='Maximal storage [hm3]')

max_release = Float(10, desc='Maximal release [m3/s]')

head = Float(10, desc='Hydraulic head [m]')

efficiency = Range(0, 1.)

def energy_production(self, release):

''' Returns the energy production [Wh] for the given release [m3/s]

'''

power = 1000 * 9.81 * self.head * release * self.efficiency

return power * 3600

if __name__ == '__main__':

reservoir = Reservoir(

name = 'Project A',

max_storage = 30,

max_release = 100.0,

head = 60,

efficiency = 0.8

)

release = 80

print 'Releasing {} m3/s produces {} kWh'.format(

release, reservoir.energy_production(release)

)

```

```

Releasing 80 m3/s produces 1.3561344e+11 kWh

```

### 3.4.3.4 可视化: 打开一个对话框

Traits库也关注用户界面,可以弹出一个Reservoir类的默认视图:

In [ ]:

```

reservoir1 = Reservoir()

reservoir1.edit_traits()

```

TraitsUI简化了创建用户界面的方式。HasTraits类上的每一个trait都有一个默认的编辑器,将管理trait在屏幕上显示的方式 (即Range trait显示为一个滑块等)。

与Traits声明方式来创建类的相同渠道,TraitsUI提供了声明的界面来构建用户界面代码:

In [ ]:

```

from traits.api import HasTraits, Str, Float, Range

from traitsui.api import View

class Reservoir(HasTraits):

name = Str

max_storage = Float(1e6, desc='Maximal storage [hm3]')

max_release = Float(10, desc='Maximal release [m3/s]')

head = Float(10, desc='Hydraulic head [m]')

efficiency = Range(0, 1.)

traits_view = View(

'name', 'max_storage', 'max_release', 'head', 'efficiency',

title = 'Reservoir',

resizable = True,

)

def energy_production(self, release):

''' Returns the energy production [Wh] for the given release [m3/s]

'''

power = 1000 * 9.81 * self.head * release * self.efficiency

return power * 3600

if __name__ == '__main__':

reservoir = Reservoir(

name = 'Project A',

max_storage = 30,

max_release = 100.0,

head = 60,

efficiency = 0.8

)

reservoir.configure_traits()

```

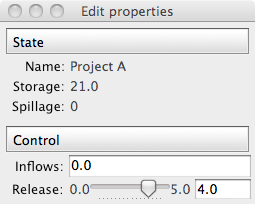

### 3.4.3.5 推迟

可以将trait定义和它的值推送给另一个对象是Traits的有用的功能。

In [ ]:

```

from traits.api import HasTraits, Instance, DelegatesTo, Float, Range

from reservoir import Reservoir

class ReservoirState(HasTraits):

"""Keeps track of the reservoir state given the initial storage.

"""

reservoir = Instance(Reservoir, ())

min_storage = Float

max_storage = DelegatesTo('reservoir')

min_release = Float

max_release = DelegatesTo('reservoir')

# state attributes

storage = Range(low='min_storage', high='max_storage')

# control attributes

inflows = Float(desc='Inflows [hm3]')

release = Range(low='min_release', high='max_release')

spillage = Float(desc='Spillage [hm3]')

def print_state(self):

print 'Storage\tRelease\tInflows\tSpillage'

str_format = '\t'.join(['{:7.2f}'for i in range(4)])

print str_format.format(self.storage, self.release, self.inflows,

self.spillage)

print '-' * 79

if __name__ == '__main__':

projectA = Reservoir(

name = 'Project A',

max_storage = 30,

max_release = 100.0,

hydraulic_head = 60,

efficiency = 0.8

)

state = ReservoirState(reservoir=projectA, storage=10)

state.release = 90

state.inflows = 0

state.print_state()

print 'How do we update the current storage ?'

```

特殊的trait允许用魔法_xxxx_fired方法管理事件和触发器函数:

In [ ]:

```

from traits.api import HasTraits, Instance, DelegatesTo, Float, Range, Event

from reservoir import Reservoir

class ReservoirState(HasTraits):

"""Keeps track of the reservoir state given the initial storage.

For the simplicity of the example, the release is considered in

hm3/timestep and not in m3/s.

"""

reservoir = Instance(Reservoir, ())

min_storage = Float

max_storage = DelegatesTo('reservoir')

min_release = Float

max_release = DelegatesTo('reservoir')

# state attributes

storage = Range(low='min_storage', high='max_storage')

# control attributes

inflows = Float(desc='Inflows [hm3]')

release = Range(low='min_release', high='max_release')

spillage = Float(desc='Spillage [hm3]')

update_storage = Event(desc='Updates the storage to the next time step')

def _update_storage_fired(self):

# update storage state

new_storage = self.storage - self.release + self.inflows

self.storage = min(new_storage, self.max_storage)

overflow = new_storage - self.max_storage

self.spillage = max(overflow, 0)

def print_state(self):

print 'Storage\tRelease\tInflows\tSpillage'

str_format = '\t'.join(['{:7.2f}'for i in range(4)])

print str_format.format(self.storage, self.release, self.inflows,

self.spillage)

print '-' * 79

if __name__ == '__main__':

projectA = Reservoir(

name = 'Project A',

max_storage = 30,

max_release = 5.0,

hydraulic_head = 60,

efficiency = 0.8

)

state = ReservoirState(reservoir=projectA, storage=15)

state.release = 5

state.inflows = 0

# release the maximum amount of water during 3 time steps

state.update_storage = True

state.print_state()

state.update_storage = True

state.print_state()

state.update_storage = True

state.print_state()

```

对象间的依赖可以自动使用trait**Property**完成。**depends_on**属性表示property其他traits的依赖性。当其他traits改变了,property是无效的。此外,Traits为属性使用魔法函数的名字:

* _get_XXX 来获得XXX属性的trait

* _set_XXX 来设置XXX属性的trait

In [ ]:

```

from traits.api import HasTraits, Instance, DelegatesTo, Float, Range

from traits.api import Property

from reservoir import Reservoir

class ReservoirState(HasTraits):

"""Keeps track of the reservoir state given the initial storage.

For the simplicity of the example, the release is considered in

hm3/timestep and not in m3/s.

"""

reservoir = Instance(Reservoir, ())

max_storage = DelegatesTo('reservoir')

min_release = Float

max_release = DelegatesTo('reservoir')

# state attributes

storage = Property(depends_on='inflows, release')

# control attributes

inflows = Float(desc='Inflows [hm3]')

release = Range(low='min_release', high='max_release')

spillage = Property(

desc='Spillage [hm3]', depends_on=['storage', 'inflows', 'release']

)

### Private traits.

_storage = Float

### Traits property implementation.

def _get_storage(self):

new_storage = self._storage - self.release + self.inflows

return min(new_storage, self.max_storage)

def _set_storage(self, storage_value):

self._storage = storage_value

def _get_spillage(self):

new_storage = self._storage - self.release + self.inflows

overflow = new_storage - self.max_storage

return max(overflow, 0)

def print_state(self):

print 'Storage\tRelease\tInflows\tSpillage'

str_format = '\t'.join(['{:7.2f}'for i in range(4)])

print str_format.format(self.storage, self.release, self.inflows,

self.spillage)

print '-' * 79

if __name__ == '__main__':

projectA = Reservoir(

name = 'Project A',

max_storage = 30,

max_release = 5,

hydraulic_head = 60,

efficiency = 0.8

)

state = ReservoirState(reservoir=projectA, storage=25)

state.release = 4

state.inflows = 0

state.print_state()

```

**注意** 缓存属性 当访问一个输入没有改变的属性时,[[email protected]](/cdn-cgi/l/email-protection)_property修饰器可以用来缓存这个值,并且只有在失效时才会重新计算一次他们。

让我们用ReservoirState的例子来扩展TraitsUI介绍:

In [ ]:

```

from traits.api import HasTraits, Instance, DelegatesTo, Float, Range, Property

from traitsui.api import View, Item, Group, VGroup

from reservoir import Reservoir

class ReservoirState(HasTraits):

"""Keeps track of the reservoir state given the initial storage.

For the simplicity of the example, the release is considered in

hm3/timestep and not in m3/s.

"""

reservoir = Instance(Reservoir, ())

name = DelegatesTo('reservoir')

max_storage = DelegatesTo('reservoir')

max_release = DelegatesTo('reservoir')

min_release = Float

# state attributes

storage = Property(depends_on='inflows, release')

# control attributes

inflows = Float(desc='Inflows [hm3]')

release = Range(low='min_release', high='max_release')

spillage = Property(

desc='Spillage [hm3]', depends_on=['storage', 'inflows', 'release']

)

### Traits view

traits_view = View(

Group(

VGroup(Item('name'), Item('storage'), Item('spillage'),

label = 'State', style = 'readonly'

),

VGroup(Item('inflows'), Item('release'), label='Control'),

)

)

### Private traits.

_storage = Float

### Traits property implementation.

def _get_storage(self):

new_storage = self._storage - self.release + self.inflows

return min(new_storage, self.max_storage)

def _set_storage(self, storage_value):

self._storage = storage_value

def _get_spillage(self):

new_storage = self._storage - self.release + self.inflows

overflow = new_storage - self.max_storage

return max(overflow, 0)

def print_state(self):

print 'Storage\tRelease\tInflows\tSpillage'

str_format = '\t'.join(['{:7.2f}'for i in range(4)])

print str_format.format(self.storage, self.release, self.inflows,

self.spillage)

print '-' * 79

if __name__ == '__main__':

projectA = Reservoir(

name = 'Project A',

max_storage = 30,

max_release = 5,

hydraulic_head = 60,

efficiency = 0.8

)

state = ReservoirState(reservoir=projectA, storage=25)

state.release = 4

state.inflows = 0

state.print_state()

state.configure_traits()

```

Some use cases need the delegation mechanism to be broken by the user when setting the value of the trait. The PrototypeFrom trait implements this behaviour.

In [ ]:

```

TraitsUI simplifies the way user interfaces are created. Every trait on a HasTraits class has a default editor that will manage the way the trait is rendered to the screen (e.g. the Range trait is displayed as a slider, etc.).

In the very same vein as the Traits declarative way of creating classes, TraitsUI provides a declarative interface to build user interfaces code:

```

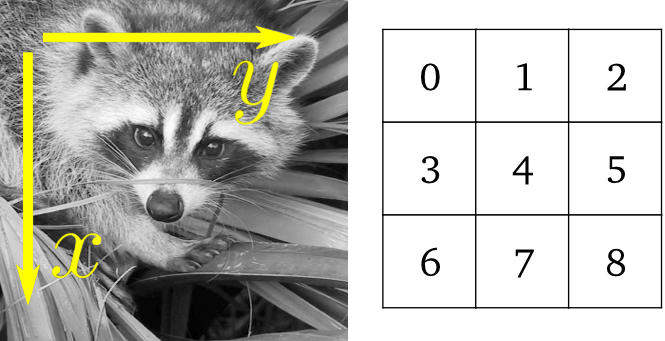

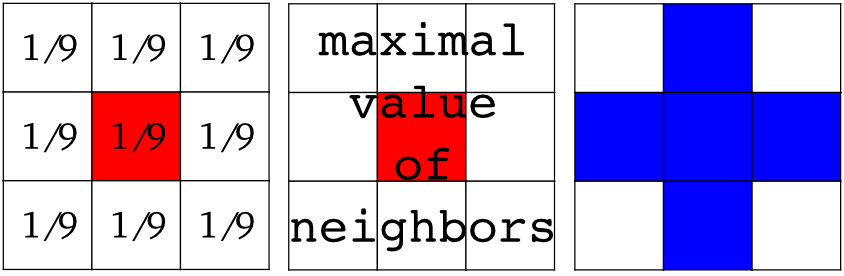

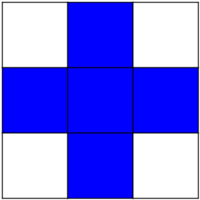

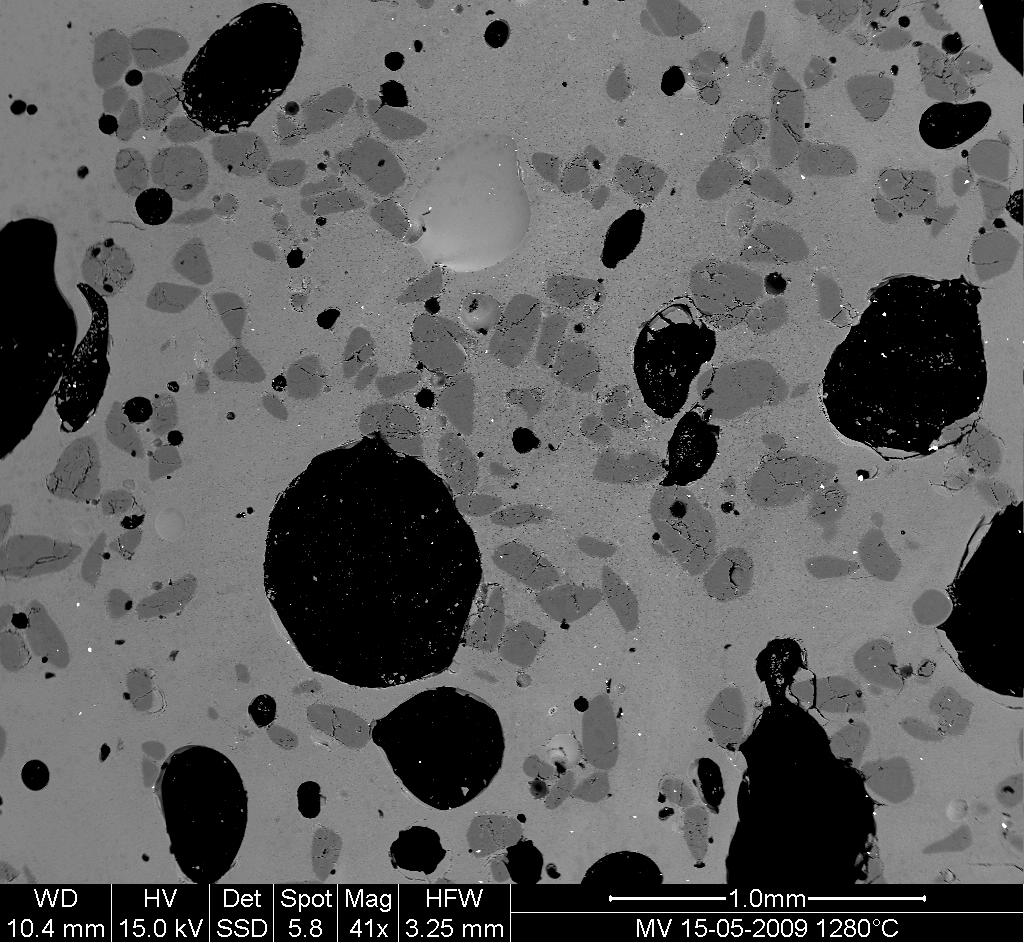

3.3 Scikit-image:图像处理

最后更新于:2022-04-01 11:22:01

# 3.3 Scikit-image:图像处理

> **作者**: Emmanuelle Gouillart

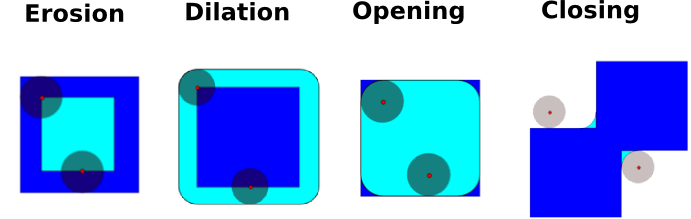

[scikit-image](http://scikit-image.org/)是专注于图像处理的Python包,并且使用原生的Numpy数组作为图像对象。本章描述如何在不同图像处理任务上使用`scikit-image`,并且保留了其他科学Python模块比如Numpy和Scipy的链接。

**也可以看一下:**对于基本图像处理,比如图像剪切或者简单过滤,大量简单操作可以用Numpy和SciPy来实现。看一下[使用Numpy和Scipy图像操作和处理部分](http://www.scipy-lectures.org/advanced/image_processing/index.html#basic-image)。

注意,在阅读本章之前你应该熟悉前面章节的内容,比如基础操作,比如面具和标签作为先决条件。

**章节内容**

* **介绍和观点**

* `scikit-image` 和 `SciPy`生态系统

* `scikit-image`能发现什么

* **输入/输出, 数据类型和 颜色空间**

* 数据类型

* 颜色空间

* **图像预处理/增强**

* 本地过滤器

* 非-本地过滤器

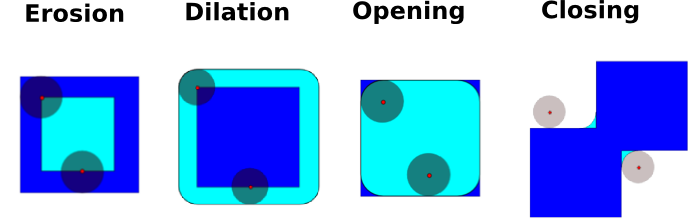

* 数学形态学

* **图像细分**

* 二元细分: 前景 + 背景

* 基于标记的方法

* **测量区域的属性**

* **数据可视化和交互**

## 3.3.1 介绍和观点

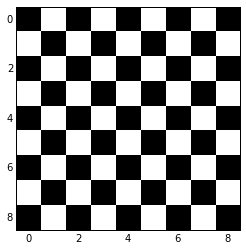

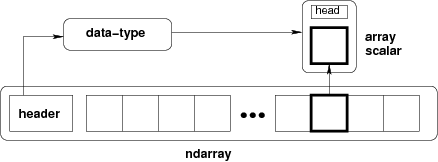

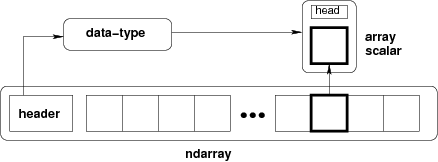

图像是NumPy的数组`np.ndarray`

| 图像: | np.ndarray |

| --- | --- |

| 像素: | array values: a[2, 3] |

| 渠道: | array dimensions |

| 图像编码: | dtype (np.uint8, np.uint16, np.float) |

| 过滤器: | functions (numpy, skimage, scipy) |

In [1]:

```

%matplotlib inline

import numpy as np

check = np.zeros((9, 9))

check[::2, 1::2] = 1

check[1::2, ::2] = 1

import matplotlib.pyplot as plt

plt.imshow(check, cmap='gray', interpolation='nearest')

```

Out[1]:

```

<matplotlib.image.AxesImage at 0x105717610>

```

### 3.3.1.1 scikit-image 和 SciPy 生态系统

最新版的`scikit-image`包含在大多数的科学Python发行版中,比如,Anaconda或Enthought Canopy。它也包含在 Ubuntu/Debian。

In [6]:

```

import skimage

from skimage import data # 大多数函数在子包中

```

大多数`scikit-image`函数用NumPy ndarrays作为参数

In [6]:

```

camera = data.camera()

camera.dtype

```

Out[6]:

```

dtype('uint8')

```

In [7]:

```

camera.shape

```

Out[7]:

```

(512, 512)

```

In [8]:

```

from skimage import restoration

filtered_camera = restoration.denoise_bilateral(camera)

type(filtered_camera)

```

Out[8]:

```

numpy.ndarray

```

其他Python包也可以用于图像处理,并且使用Numpy数组:

* [scipy.ndimage](http://docs.scipy.org/doc/scipy/reference/ndimage.html#module-scipy.ndimage) : 对于 nd-arrays。基础过滤、数学形态学和区域属性

* [Mahotas](http://luispedro.org/software/mahotas) 同时,强大的图形处理库有Python封装:

* [OpenCV](https://opencv-python-tutroals.readthedocs.org/en/latest/) (计算机视觉)

* [ITK](http://www.itk.org/itkindex.html) (3D图像和注册)

* 其他 (但是,他们没有那么Pythonic也没有Numpy友好,在一定范围)。

### 3.3.1.2 scikit-image能发现什么

* 网站: [http://scikit-image.org/](http://scikit-image.org/)

* 例子库 (就像在 [matplotlib](http://matplotlib.org/gallery.html) 或 [scikit-learn](http://scikit-learn.org/)): [http://scikit-image.org/docs/stable/auto_examples/](http://scikit-image.org/docs/stable/auto_examples/) 不同类的函数,从基本的使用函数到高级最新算法。

* 过滤器: 函数将图像转化为其他图像。

* NumPy组件

* 通用过滤器算法

* 数据简化函数: 计算图像直方图、局部极值位置、角。

* 其他动作: I/O, 可视化,等。

## 3.3.2 输入/输出, 数据类型和颜色空间

I/O: [skimage.io](http://scikit-image.org/docs/stable/api/skimage.io.html#module-skimage.io)

In [4]:

```

from skimage import io

```

读取文件: [skimage.io.imread()](http://scikit-image.org/docs/stable/api/skimage.io.html#skimage.io.imread)

In [7]:

```

import os

filename = os.path.join(skimage.data_dir, 'camera.png')

camera = io.imread(filename)

```

支持所有被Python Imaging Library(或者`imread` `plugin`关键词提供的任何I/O插件)的数据格式。 也支持URL图片路径:

In [3]:

```

logo = io.imread('http://scikit-image.org/_static/img/logo.png')

```

存储文件:

In [4]:

```

io.imsave('local_logo.png', logo)

```

(`imsave`也用外部插件比如PIL)

### 3.3.2.1 数据类型

图像ndarrays可以用整数(有符号或无符号)或浮点来代表。

小心整数类型的溢出

In [8]:

```

camera = data.camera()

camera.dtype

```

Out[8]:

```

dtype('uint8')

```

In [8]:

```

camera_multiply = 3 * camera

```

可用不同的整型大小: 8-, 16- 或 32-字节, 有符号或无符号。

一个重要的 (如果有疑问的话) `skimage` **惯例**: 图像浮点支持在[-1, 1] (与所以浮点图像相对)

In [9]:

```

from skimage import img_as_float

camera_float = img_as_float(camera)

camera.max(), camera_float.max()

```

Out[9]:

```

(255, 1.0)

```

一些图像处理程序需要应用在浮点数组上,因此,输出的数组可能类型和数据范围都与输入数组不同

In [9]:

```

try:

from skimage import filters

except ImportError:

from skimage import filter as filters

camera_sobel = filters.sobel(camera)

camera_sobel.max()

```

Out[9]:

```

0.5915023652179584

```

在上面的例子中,我们使用`scikit-image`的子模块`filters`,在0.11到0.10版本间,`filter`被重命名为`filters`,为了避免与Python内置的`filter`冲突。

在[skimage](http://scikit-image.org/docs/stable/api/skimage.html#module-skimage)提供了下列skimage实用的函数来转化dtype和data range: `util.img_as_float`、 `util.img_as_ubyte`等。

看一下[用户手册](http://scikit-image.org/docs/stable/user_guide/data_types.html)来了解细节。

In [ ]:

```

An important (if questionable) skimage convention: float images are supposed to lie in [-1, 1] (in order to have comparable contrast for all float images)

```

In [ ]:

```

3.3.1. Introduction and concepts

Images are NumPy’s arrays np.ndarray

```

3.2 Sympy:Python中的符号数学

最后更新于:2022-04-01 11:21:59

# 3.2 Sympy:Python中的符号数学

> **作者** : Fabian Pedregosa

**目的**

* 从任意的精度评估表达式。

* 在符号表达式上进行代数运算。

* 用符号表达式进行基本的微积分任务 (极限、微分法和积分法)。

* 求解多项式和超越方程。

* 求解一些微分方程。

为什么是SymPy? SymPy是符号数学的Python库。它的目的是成为Mathematica或Maple等系统的替代品,同时让代码尽可能简单并且可扩展。SymPy完全是用Python写的,并不需要外部的库。

Sympy文档及库安装见[http://www.sympy.org/](http://www.sympy.org/)

**章节内容**

* SymPy第一步

* 使用SymPy作为计算器

* 练习

* 符号

* 代数运算

* 展开

* 化简

* 微积分

* 极限

* 微分法

* 序列扩展

* 积分法

* 练习

* 方程求解

* 练习

* 线性代数

* 矩阵

* 微分方程

## 3.2.1 SymPy第一步

### 3.2.1.1 使用SymPy作为计算器

SymPy定义了三种数字类型:实数、有理数和整数。

有理数类将有理数表征为两个整数对: 分子和分母,因此Rational(1,2)代表1/2, Rational(5,2)代表5/2等等:

In [2]:

```

from sympy import *

a = Rational(1,2)

```

In [2]:

```

a

```

Out[2]:

```

1/2

```

In [3]:

```

a*2

```

Out[3]:

```

1

```

SymPy在底层使用mpmath, 这使它可以用任意精度的算术进行计算。这样,一些特殊的常数,比如e, pi, oo (无限), 可以被作为符号处理并且可以以任意精度来评估:

In [4]:

```

pi**2

```

Out[4]:

```

pi**2

```

In [5]:

```

pi.evalf()

```

Out[5]:

```

3.14159265358979

```

In [6]:

```

(pi + exp(1)).evalf()

```

Out[6]:

```

5.85987448204884

```

如你所见,将表达式评估为浮点数。

也有一个类代表数学的无限, 称为 oo:

In [7]:

```

oo > 99999

```

Out[7]:

```

True

```

In [8]:

```

oo + 1

```

Out[8]:

```

oo

```

### 3.2.1.2 练习

* 计算 $\sqrt{2}$ 小数点后一百位。

* 用有理数算术计算1/2 + 1/3 in rational arithmetic.

### 3.2.1.3 符号

与其他计算机代数系统不同,在SymPy你需要显性声明符号变量:

In [4]:

```

from sympy import *

x = Symbol('x')

y = Symbol('y')

```

然后你可以计算他们:

In [10]:

```

x + y + x - y

```

Out[10]:

```

2*x

```

In [11]:

```

(x + y)**2

```

Out[11]:

```

(x + y)**2

```

符号可以使用一些Python操作符操作: +, -, *, ** (算术), &, |, ~ , >>, << (布尔逻辑).

**打印** 这里我们使用下列设置打印

In [ ]:

```

sympy.init_printing(use_unicode=False, wrap_line=True)

```

## 3.2.2 代数运算

SymPy可以进行强大的代数运算。我们将看一下最常使用的:展开和化简。

### 3.2.2.1 展开

使用这个模块展开代数表达式。它将试着密集的乘方和相乘:

In [13]:

```

expand((x + y)**3)

```

Out[13]:

```

x**3 + 3*x**2*y + 3*x*y**2 + y**3

```

In [14]:

```

3*x*y**2 + 3*y*x**2 + x**3 + y**3

```

Out[14]:

```

x**3 + 3*x**2*y + 3*x*y**2 + y**3

```

可以通过关键词的形式使用更多的选项:

In [15]:

```

expand(x + y, complex=True)

```

Out[15]:

```

re(x) + re(y) + I*im(x) + I*im(y)

```

In [16]:

```

I*im(x) + I*im(y) + re(x) + re(y)

```

Out[16]:

```

re(x) + re(y) + I*im(x) + I*im(y)

```

In [17]:

```

expand(cos(x + y), trig=True)

```

Out[17]:

```

-sin(x)*sin(y) + cos(x)*cos(y)

```

In [18]:

```

cos(x)*cos(y) - sin(x)*sin(y)

```

Out[18]:

```

-sin(x)*sin(y) + cos(x)*cos(y)

```

## 3.2.2.2 化简

如果可以将表达式转化为更简单的形式,可以使用化简:

In [19]:

```

simplify((x + x*y) / x)

```

Out[19]:

```

y + 1

```

化简是一个模糊的术语,更准确的词应该是:powsimp (指数化简)、 trigsimp (三角表达式)、logcombine、radsimp一起。

**练习**

* 计算$(x+y)^6$的展开。

* 化简三角表达式$ \sin(x) / \cos(x)$

## 3.2.3 微积分

### 3.2.3.1 极限

在SymPy中使用极限很简单,允许语法limit(function, variable, point), 因此要计算f(x)类似$x \rightarrow 0$, 你应该使用limit(f, x, 0):

In [5]:

```

limit(sin(x)/x, x, 0)

```

Out[5]:

```

1

```

你也可以计算一下在无限时候的极限:

In [6]:

```

limit(x, x, oo)

```

Out[6]:

```

oo

```

In [7]:

```

limit(1/x, x, oo)

```

Out[7]:

```

0

```

In [8]:

```

limit(x**x, x, 0)

```

Out[8]:

```

1

```

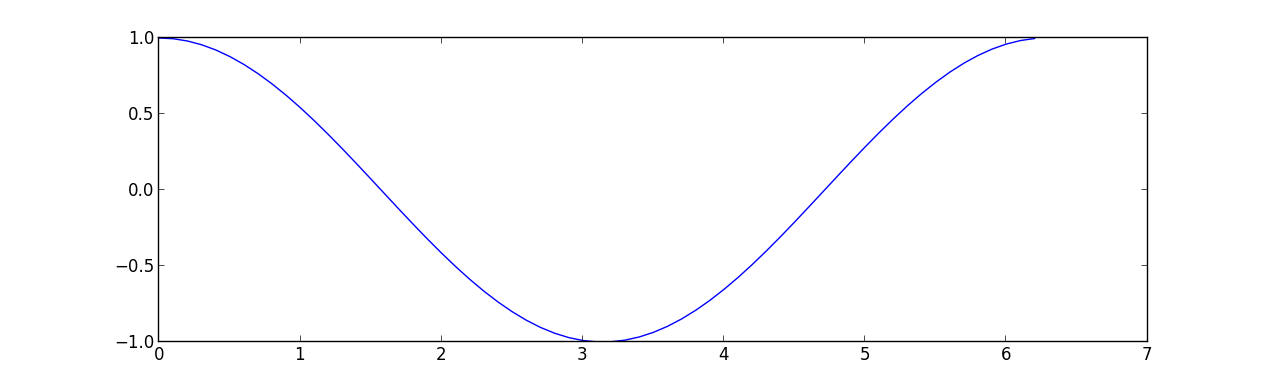

### 3.2.3.2 微分法

你可以使用`diff(func, var)`微分任何SymPy表达式。例如:

In [9]:

```

diff(sin(x), x)

```

Out[9]:

```

cos(x)

```

In [10]:

```

diff(sin(2*x), x)

```

Out[10]:

```

2*cos(2*x)

```

In [11]:

```

diff(tan(x), x)

```

Out[11]:

```

tan(x)**2 + 1

```

你可以用下列方法检查是否正确:

In [12]:

```

limit((tan(x+y) - tan(x))/y, y, 0)

```

Out[12]:

```

tan(x)**2 + 1

```

可以用`diff(func, var, n)`方法来计算更高的导数:

In [13]:

```

diff(sin(2*x), x, 1)

```

Out[13]:

```

2*cos(2*x)

```

In [14]:

```

diff(sin(2*x), x, 2)

```

Out[14]:

```

-4*sin(2*x)

```

In [15]:

```

diff(sin(2*x), x, 3)

```

Out[15]:

```

-8*cos(2*x)

```

### 3.2.3.3 序列展开

SymPy也知道如何计算一个表达式在一个点的Taylor序列。使用`series(expr, var)`:

In [16]:

```

series(cos(x), x)

```

Out[16]:

```

1 - x**2/2 + x**4/24 + O(x**6)

```

In [17]:

```

series(1/cos(x), x)

```

Out[17]:

```

1 + x**2/2 + 5*x**4/24 + O(x**6)

```

**练习**

计算$\lim_{x\rightarrow 0} \sin(x)/x$

计算`log(x)`对于x的导数。

### 3.2.3.4 积分法

SymPy支持超验基础和特殊函数的无限和有限积分,通过`integrate()` 功能, 使用了强大的扩展的Risch-Norman算法和启发式和模式匹配。你可以积分基本函数:

In [18]:

```

integrate(6*x**5, x)

```

Out[18]:

```

x**6

```

In [19]:

```

integrate(sin(x), x)

```

Out[19]:

```

-cos(x)

```

In [20]:

```

integrate(log(x), x)

```

Out[20]:

```

x*log(x) - x

```

In [21]:

```

integrate(2*x + sinh(x), x)

```

Out[21]:

```

x**2 + cosh(x)

```

也可以很简单的处理特殊函数:

In [22]:

```

integrate(exp(-x**2)*erf(x), x)

```

Out[22]:

```

sqrt(pi)*erf(x)**2/4

```

也可以计算一下有限积分:

In [23]:

```

integrate(x**3, (x, -1, 1))

```

Out[23]:

```

0

```

In [24]:

```

integrate(sin(x), (x, 0, pi/2))

```

Out[24]:

```

1

```

In [25]:

```

integrate(cos(x), (x, -pi/2, pi/2))

```

Out[25]:

```

2

```

不标准积分也支持:

In [26]:

```

integrate(exp(-x), (x, 0, oo))

```

Out[26]:

```

1

```

In [27]:

```

integrate(exp(-x**2), (x, -oo, oo))

```

Out[27]:

```

sqrt(pi)

```

#### 3.2.3.5 练习

### 3.2.4 方程求解

SymPy可以求解线性代数方程,一个或多个变量:

In [28]:

```

solve(x**4 - 1, x)

```

Out[28]:

```

[-1, 1, -I, I]

```

如你所见,第一个参数是假设等于0的表达式。它可以解一个很大的多项式方程,也可以有能力求解多个方程,可以将各自的多个变量作为元组以第二个参数给出:

In [29]:

```

solve([x + 5*y - 2, -3*x + 6*y - 15], [x, y])

```

Out[29]:

```

{x: -3, y: 1}

```

也直接求解超越方程(有限的):

In [30]:

```

solve(exp(x) + 1, x)

```

Out[30]:

```

[I*pi]

```

多项式方程的另一个应用是`factor`。`factor`将多项式因式分解为可化简的项,并且可以计算不同域的因式:

In [31]:

```

f = x**4 - 3*x**2 + 1

factor(f)

```

Out[31]:

```

(x**2 - x - 1)*(x**2 + x - 1)

```

In [32]:

```

factor(f, modulus=5)

```

Out[32]:

```

(x - 2)**2*(x + 2)**2

```

SymPy也可以解布尔方程,即,判断一个布尔表达式是否满足。对于这个情况,我们可以使用`satisfiable`函数:

In [33]:

```

satisfiable(x & y)

```

Out[33]:

```

{x: True, y: True}

```

这告诉我们`(x & y)`是真,当x和y都是True的时候。如果一个表达式不是True,即它的任何参数值都无法使表达式为真,那么它将返回False:

In [34]:

```

satisfiable(x & ~x)

```

Out[34]:

```

False

```

### 3.2.4.1 练习

* 求解系统方程$x + y = 2$, $2\cdot x + y = 0$

* 是否存在布尔值,使$(~x | y) & (~y | x)$为真?

### 3.2.5 线性代数

#### 3.2.5.1 矩阵

矩阵通过Matrix类的一个实例来创建:

In [35]:

```

from sympy import Matrix

Matrix([[1,0], [0,1]])

```

Out[35]:

```

Matrix([

[1, 0],

[0, 1]])

```

与NumPy数组不同,你也可以在里面放入符号:

In [36]:

```

x = Symbol('x')

y = Symbol('y')

A = Matrix([[1,x], [y,1]])

A

```

Out[36]:

```

Matrix([

[1, x],

[y, 1]])

```

In [37]:

```

A**2

```

Out[37]:

```

Matrix([

[x*y + 1, 2*x],

[ 2*y, x*y + 1]])

```

### 3.2.5.2 微分方程

SymPy可以解 (一些) 常规微分。要求解一个微分方程,使用`dsolve`。首先,通过传递cls=Function来创建一个未定义的符号函数:

In [38]:

```

f, g = symbols('f g', cls=Function)

```

f 和 g是未定义函数。我们可以调用f(x), 并且它可以代表未知的函数:

In [39]:

```

f(x)

```

Out[39]:

```

f(x)

```

In [40]:

```

f(x).diff(x, x) + f(x)

```

Out[40]:

```

f(x) + Derivative(f(x), x, x)

```

In [41]:

```

dsolve(f(x).diff(x, x) + f(x), f(x))

```

Out[41]:

```

f(x) == C1*sin(x) + C2*cos(x)

```

关键词参数可以向这个函数传递,以便帮助确认是否找到最适合的解决系统。例如,你知道它是独立的方程,你可以使用关键词hint=’separable’来强制`dsolve`来将它作为独立方程来求解:

In [42]:

```

dsolve(sin(x)*cos(f(x)) + cos(x)*sin(f(x))*f(x).diff(x), f(x), hint='separable')

```

Out[42]:

```

[f(x) == -asin(sqrt(C1/cos(x)**2 + 1)) + pi,

f(x) == asin(sqrt(C1/cos(x)**2 + 1)) + pi,

f(x) == -asin(sqrt(C1/cos(x)**2 + 1)),

f(x) == asin(sqrt(C1/cos(x)**2 + 1))]

```

**练习**

* 求解Bernoulli微分方程

$x \frac{d f(x)}{x} + f(x) - f(x)^2=0$

* 使用hint=’Bernoulli’求解相同的公式。可以观察到什么?

3.1 Python中的统计学

最后更新于:2022-04-01 11:21:56

# 3.1 Python中的统计学

In [1]:

```

%matplotlib inline

import numpy as np

```

> **作者** : Gaël Varoquaux

**必要条件**

* 标准Python科学计算环境 (numpy, scipy, matplotlib)

* [Pandas](http://pandas.pydata.org/)

* [Statsmodels](http://statsmodels.sourceforge.net/)

* [Seaborn](http://stanford.edu/~mwaskom/software/seaborn/)

要安装Python及这些依赖,推荐下载[Anaconda Python](http://continuum.io/downloads) 或 [Enthought Canopy](https://store.enthought.com/), 如果你使用Ubuntu或其他linux更应该使用包管理器。

**也可以看一下: Python中的贝叶斯统计**

本章并不会涉及贝叶斯统计工具。适用于贝叶斯模型的是[PyMC](http://pymc-devs.github.io/pymc), 在Python中实现了概率编程语言。

**为什么统计学要用Python?**

R是一门专注于统计学的语言。Python是带有统计学模块的通用编程语言。R比Python有更多的统计分析功能,以及专用的语法。但是,当面对构建复杂的分析管道,混合统计学以及例如图像分析、文本挖掘或者物理实验控制,Python的富有就是物价的优势。

**内容**

* 数据表征和交互

* 数据作为表格

* panda data-frame

* 假设检验: 对比两个组

* Student’s t-test: 最简单的统计检验

* 配对实验: 对同一个体的重复测量

* 线性模型、多因素和方差分析

* 用“公式” 来在Python中指定统计模型

* 多元回归: 包含多元素

* 事后假设检验: 方差分析 (ANOVA)

* 更多的可视化: 用seaborn来进行统计学探索

* 配对图: 散点矩阵

* lmplot: 绘制一个单变量回归

* 交互作用检验

**免责声明: 性别问题**

本教程中的一些实例选自性别问题。其原因是在这种问题上这种控制的声明实际上影响了很多人。

## 3.1.1 数据表征和交互

### 3.1.1.1 数据作为表格

统计分析中我们关注的设定是通过一组不同的属性或特征来描述多个观察或样本。然后这个数据可以被视为2D表格,或矩阵,列是数据的不同属性,行是观察。例如包含在[examples/brain_size.csv](http://www.scipy-lectures.org/_downloads/brain_size.csv)的数据:

`"";"Gender";"FSIQ";"VIQ";"PIQ";"Weight";"Height";"MRI_Count" "1";"Female";133;132;124;"118";"64.5";816932 "2";"Male";140;150;124;".";"72.5";1001121 "3";"Male";139;123;150;"143";"73.3";1038437 "4";"Male";133;129;128;"172";"68.8";965353 "5";"Female";137;132;134;"147";"65.0";951545`

### 3.1.1.2 panda data-frame

我们将会在来自[pandas](http://pandas.pydata.org/)模块的[pandas.DataFrame](http://pandas.pydata.org/pandas-docs/stable/generated/pandas.DataFrame.html#pandas.DataFrame)中存储和操作这个数据。它是电子表格程序在Python中的一个等价物。它与2D `numpy`数据的区别在于列带有名字,可以在列中存储混合的数据类型,并且有精妙的选择和透视表机制。

#### 3.1.1.2.1 创建dataframes: 读取数据文件或转化数组

**从CSV文件读取**: 使用上面的CSV文件,给出了大脑大小重量和IQ (Willerman et al. 1991) 的观察值 , 数据混合了数量值和类型值:

In [3]:

```

import pandas

data = pandas.read_csv('examples/brain_size.csv', sep=';', na_values=".")

data

```

Out[3]:

| | Unnamed: 0 | Gender | FSIQ | VIQ | PIQ | Weight | Height | MRI_Count |

| --- | --- | --- | --- | --- | --- | --- | --- | --- |

| 0 | 1 | Female | 133 | 132 | 124 | 118 | 64.5 | 816932 |

| 1 | 2 | Male | 140 | 150 | 124 | NaN | 72.5 | 1001121 |

| 2 | 3 | Male | 139 | 123 | 150 | 143 | 73.3 | 1038437 |

| 3 | 4 | Male | 133 | 129 | 128 | 172 | 68.8 | 965353 |

| 4 | 5 | Female | 137 | 132 | 134 | 147 | 65.0 | 951545 |

| 5 | 6 | Female | 99 | 90 | 110 | 146 | 69.0 | 928799 |

| 6 | 7 | Female | 138 | 136 | 131 | 138 | 64.5 | 991305 |

| 7 | 8 | Female | 92 | 90 | 98 | 175 | 66.0 | 854258 |

| 8 | 9 | Male | 89 | 93 | 84 | 134 | 66.3 | 904858 |

| 9 | 10 | Male | 133 | 114 | 147 | 172 | 68.8 | 955466 |

| 10 | 11 | Female | 132 | 129 | 124 | 118 | 64.5 | 833868 |

| 11 | 12 | Male | 141 | 150 | 128 | 151 | 70.0 | 1079549 |

| 12 | 13 | Male | 135 | 129 | 124 | 155 | 69.0 | 924059 |

| 13 | 14 | Female | 140 | 120 | 147 | 155 | 70.5 | 856472 |

| 14 | 15 | Female | 96 | 100 | 90 | 146 | 66.0 | 878897 |

| 15 | 16 | Female | 83 | 71 | 96 | 135 | 68.0 | 865363 |

| 16 | 17 | Female | 132 | 132 | 120 | 127 | 68.5 | 852244 |

| 17 | 18 | Male | 100 | 96 | 102 | 178 | 73.5 | 945088 |

| 18 | 19 | Female | 101 | 112 | 84 | 136 | 66.3 | 808020 |

| 19 | 20 | Male | 80 | 77 | 86 | 180 | 70.0 | 889083 |

| 20 | 21 | Male | 83 | 83 | 86 | NaN | NaN | 892420 |

| 21 | 22 | Male | 97 | 107 | 84 | 186 | 76.5 | 905940 |

| 22 | 23 | Female | 135 | 129 | 134 | 122 | 62.0 | 790619 |

| 23 | 24 | Male | 139 | 145 | 128 | 132 | 68.0 | 955003 |

| 24 | 25 | Female | 91 | 86 | 102 | 114 | 63.0 | 831772 |

| 25 | 26 | Male | 141 | 145 | 131 | 171 | 72.0 | 935494 |

| 26 | 27 | Female | 85 | 90 | 84 | 140 | 68.0 | 798612 |

| 27 | 28 | Male | 103 | 96 | 110 | 187 | 77.0 | 1062462 |

| 28 | 29 | Female | 77 | 83 | 72 | 106 | 63.0 | 793549 |

| 29 | 30 | Female | 130 | 126 | 124 | 159 | 66.5 | 866662 |

| 30 | 31 | Female | 133 | 126 | 132 | 127 | 62.5 | 857782 |

| 31 | 32 | Male | 144 | 145 | 137 | 191 | 67.0 | 949589 |

| 32 | 33 | Male | 103 | 96 | 110 | 192 | 75.5 | 997925 |

| 33 | 34 | Male | 90 | 96 | 86 | 181 | 69.0 | 879987 |

| 34 | 35 | Female | 83 | 90 | 81 | 143 | 66.5 | 834344 |

| 35 | 36 | Female | 133 | 129 | 128 | 153 | 66.5 | 948066 |

| 36 | 37 | Male | 140 | 150 | 124 | 144 | 70.5 | 949395 |

| 37 | 38 | Female | 88 | 86 | 94 | 139 | 64.5 | 893983 |

| 38 | 39 | Male | 81 | 90 | 74 | 148 | 74.0 | 930016 |

| 39 | 40 | Male | 89 | 91 | 89 | 179 | 75.5 | 935863 |

> **分割符** 它是CSV文件,但是分割符是”;”

>

> **缺失值** CSV中的第二个个体的weight是缺失的。如果我们没有指定缺失值 (NA = not available) 标记符, 我们将无法进行统计分析。

**从数组中创建**: [pandas.DataFrame](http://pandas.pydata.org/pandas-docs/stable/generated/pandas.DataFrame.html#pandas.DataFrame) 也可以视为1D序列, 例如数组或列表的字典,如果我们有3个`numpy`数组:

In [4]:

```

import numpy as np

t = np.linspace(-6, 6, 20)

sin_t = np.sin(t)

cos_t = np.cos(t)

```

我们可以将他们暴露为[pandas.DataFrame](http://pandas.pydata.org/pandas-docs/stable/generated/pandas.DataFrame.html#pandas.DataFrame):

In [5]:

```

pandas.DataFrame({'t': t, 'sin': sin_t, 'cos': cos_t})

```

Out[5]:

| | cos | sin | t |

| --- | --- | --- | --- |

| 0 | 0.960170 | 0.279415 | -6.000000 |

| 1 | 0.609977 | 0.792419 | -5.368421 |

| 2 | 0.024451 | 0.999701 | -4.736842 |

| 3 | -0.570509 | 0.821291 | -4.105263 |

| 4 | -0.945363 | 0.326021 | -3.473684 |

| 5 | -0.955488 | -0.295030 | -2.842105 |

| 6 | -0.596979 | -0.802257 | -2.210526 |

| 7 | -0.008151 | -0.999967 | -1.578947 |

| 8 | 0.583822 | -0.811882 | -0.947368 |

| 9 | 0.950551 | -0.310567 | -0.315789 |

| 10 | 0.950551 | 0.310567 | 0.315789 |

| 11 | 0.583822 | 0.811882 | 0.947368 |

| 12 | -0.008151 | 0.999967 | 1.578947 |

| 13 | -0.596979 | 0.802257 | 2.210526 |

| 14 | -0.955488 | 0.295030 | 2.842105 |

| 15 | -0.945363 | -0.326021 | 3.473684 |

| 16 | -0.570509 | -0.821291 | 4.105263 |

| 17 | 0.024451 | -0.999701 | 4.736842 |

| 18 | 0.609977 | -0.792419 | 5.368421 |

| 19 | 0.960170 | -0.279415 | 6.000000 |

**其他输入**: [pandas](http://pandas.pydata.org/) 可以从SQL、excel文件或者其他格式输入数。见[pandas文档](http://pandas.pydata.org/)。

#### 3.1.1.2.2 操作数据

`data`是[pandas.DataFrame](http://pandas.pydata.org/pandas-docs/stable/generated/pandas.DataFrame.html#pandas.DataFrame), 与R的dataframe类似:

In [6]:

```

data.shape # 40行8列

```

Out[6]:

```

(40, 8)

```

In [7]:

```

data.columns # 有列

```

Out[7]:

```

Index([u'Unnamed: 0', u'Gender', u'FSIQ', u'VIQ', u'PIQ', u'Weight', u'Height',

u'MRI_Count'],

dtype='object')

```

In [8]:

```

print(data['Gender']) # 列可以用名字访问

```

```

0 Female

1 Male

2 Male

3 Male

4 Female

5 Female

6 Female

7 Female

8 Male

9 Male

10 Female

11 Male

12 Male

13 Female

14 Female

15 Female

16 Female

17 Male

18 Female

19 Male

20 Male

21 Male

22 Female

23 Male

24 Female

25 Male

26 Female

27 Male

28 Female

29 Female

30 Female

31 Male

32 Male

33 Male

34 Female

35 Female

36 Male

37 Female

38 Male

39 Male

Name: Gender, dtype: object

```

In [9]:

```

# 简单选择器

data[data['Gender'] == 'Female']['VIQ'].mean()

```

Out[9]:

```

109.45

```

> **注意**: 对于一个大dataframe的快速预览,用它的`describe`方法: [pandas.DataFrame.describe()](http://pandas.pydata.org/pandas-docs/stable/generated/pandas.DataFrame.describe.html#pandas.DataFrame.describe)。

**groupby**: 根据类别变量的值拆分dataframe:

In [10]:

```

groupby_gender = data.groupby('Gender')

for gender, value in groupby_gender['VIQ']:

print((gender, value.mean()))

```

```

('Female', 109.45)

('Male', 115.25)

```

**groupby_gender**是一个强力的对象,暴露了结果dataframes组的许多操作:

In [11]:

```

groupby_gender.mean()

```

Out[11]:

| | Unnamed: 0 | FSIQ | VIQ | PIQ | Weight | Height | MRI_Count |

| --- | --- | --- | --- | --- | --- | --- | --- |

| Gender |

| Female | 19.65 | 111.9 | 109.45 | 110.45 | 137.200000 | 65.765000 | 862654.6 |

| Male | 21.35 | 115.0 | 115.25 | 111.60 | 166.444444 | 71.431579 | 954855.4 |

在`groupby_gender`上使用tab-完成来查找更多。其他的常见分组函数是median, count (对于检查不同子集的缺失值数量很有用) 或sum。Groupby评估是懒惰模式,因为在应用聚合函数之前不会进行什么工作。

> **练习**

>

> * 完整人口VIO的平均值是多少?

> * 这项研究中包含了多少男性 / 女性?

> * **提示** 使用‘tab完成’来寻找可以调用的方法, 替换在上面例子中的‘mean’。

> * 对于男性和女性来说,以log为单位显示的MRI count平均值是多少?

> **注意**: 上面的绘图中使用了`groupby_gender.boxplot` (见[这个例子](http://www.scipy-lectures.org/packages/statistics/auto_examples/plot_pandas.html#example-plot-pandas-py))。

#### 3.1.1.2.3 绘制数据

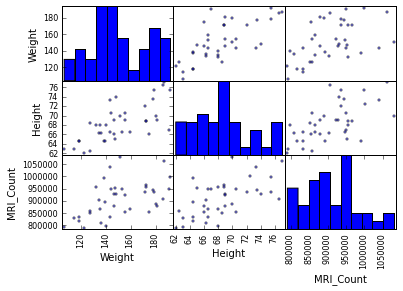

Pandas提供一些绘图工具 (`pandas.tools.plotting`, 后面使用的是matplotlib) 来显示在dataframes数据的统计值:

**散点图矩阵**:

In [15]:

```

from pandas.tools import plotting

plotting.scatter_matrix(data[['Weight', 'Height', 'MRI_Count']])

```

Out[15]:

```

array([[<matplotlib.axes._subplots.AxesSubplot object at 0x105c34810>,

<matplotlib.axes._subplots.AxesSubplot object at 0x10a0ade10>,

<matplotlib.axes._subplots.AxesSubplot object at 0x10a2d80d0>],

[<matplotlib.axes._subplots.AxesSubplot object at 0x10a33b210>,

<matplotlib.axes._subplots.AxesSubplot object at 0x10a3be450>,

<matplotlib.axes._subplots.AxesSubplot object at 0x10a40d9d0>],

[<matplotlib.axes._subplots.AxesSubplot object at 0x10a49dc10>,

<matplotlib.axes._subplots.AxesSubplot object at 0x10a51f850>,

<matplotlib.axes._subplots.AxesSubplot object at 0x10a5902d0>]], dtype=object)

```

```

/Library/Frameworks/Python.framework/Versions/2.7/lib/python2.7/site-packages/matplotlib/collections.py:590: FutureWarning: elementwise comparison failed; returning scalar instead, but in the future will perform elementwise comparison

if self._edgecolors == str('face'):

```

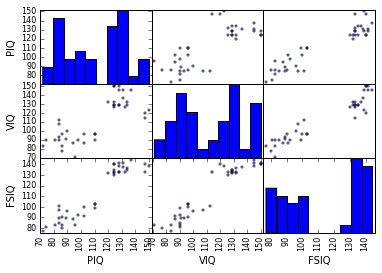

In [16]:

```

plotting.scatter_matrix(data[['PIQ', 'VIQ', 'FSIQ']])

```

Out[16]:

```

array([[<matplotlib.axes._subplots.AxesSubplot object at 0x10a918b50>,

<matplotlib.axes._subplots.AxesSubplot object at 0x10aa38710>,

<matplotlib.axes._subplots.AxesSubplot object at 0x10ab29910>],

[<matplotlib.axes._subplots.AxesSubplot object at 0x10ab8e790>,

<matplotlib.axes._subplots.AxesSubplot object at 0x10ae207d0>,

<matplotlib.axes._subplots.AxesSubplot object at 0x10abbd090>],

[<matplotlib.axes._subplots.AxesSubplot object at 0x10af140d0>,

<matplotlib.axes._subplots.AxesSubplot object at 0x10af89cd0>,

<matplotlib.axes._subplots.AxesSubplot object at 0x10affa410>]], dtype=object)

```

> **两个总体**

>

> IQ指标是双峰的, 似乎有两个子总体。

>

> **练习**

>

> 只绘制男性的散点图矩阵,然后是只有女性的。你是否认为2个子总体与性别相关?

## 3.1.2 假设检验: 比较两个组

对于简单的[统计检验](https://en.wikipedia.org/wiki/Statistical_hypothesis_testing),我们将可以使用[scipy](http://docs.scipy.org/doc/)的子摸块[scipy.stats](http://docs.scipy.org/doc/scipy/reference/stats.html#module-scipy.stats):

In [17]:

```

from scipy import stats

```

> **也看一下**: Scipy是一个很大的库。关于整个库的快速预览,可以看一下[scipy](http://nbviewer.ipython.org/github/cloga/scipy-lecture-notes_cn/blob/master/1.5.%20Scipy%EF%BC%9A%E9%AB%98%E7%BA%A7%E7%A7%91%E5%AD%A6%E8%AE%A1%E7%AE%97.ipynb) 章节。

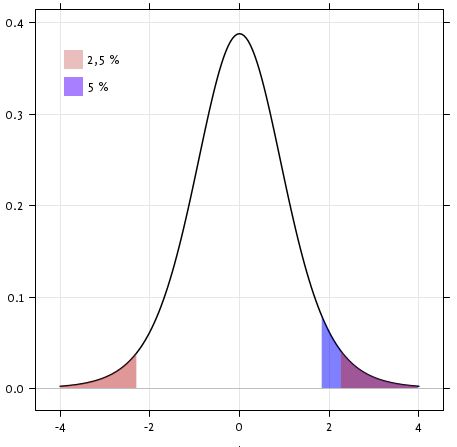

### 3.1.2.1 Student’s t检验: 最简单的统计检验

#### 3.1.2.1.1 单样本 t-检验: 检验总体平均数的值

[scipy.stats.ttest_1samp()](http://docs.scipy.org/doc/scipy/reference/generated/scipy.stats.ttest_1samp.html#scipy.stats.ttest_1samp)检验数据总体的平均数是否可能等于给定值 (严格来说是否观察值来自于给定总体平均数的正态分布)。它返回一个[T统计值](https://en.wikipedia.org/wiki/Student%27s_t-test)以及[p-值](https://en.wikipedia.org/wiki/P-value) (见函数的帮助):

In [18]:

```

stats.ttest_1samp(data['VIQ'], 0)

```

Out[18]:

```

(30.088099970849328, 1.3289196468728067e-28)

```

根据$10^-28$的p-值,我们可以声称IQ(VIQ的测量值)总体平均数不是0。

#### 3.1.2.1.2 双样本 t-检验: 检验不同总体的差异

我们已经看到男性和女性总体VIQ平均数是不同的。要检验这个差异是否是显著的,我们可以用[scipy.stats.ttest_ind()](http://docs.scipy.org/doc/scipy/reference/generated/scipy.stats.ttest_ind.html#scipy.stats.ttest_ind)进行双样本检验:

In [19]:

```

female_viq = data[data['Gender'] == 'Female']['VIQ']

male_viq = data[data['Gender'] == 'Male']['VIQ']

stats.ttest_ind(female_viq, male_viq)

```

Out[19]:

```

(-0.77261617232750113, 0.44452876778583217)

```

### 3.1.2.2 配对实验: 同一个体的重复测量

PIQ、VIQ和FSIQ给出了IQ的3种测量值。让我检验一下FISQ和PIQ是否有显著差异。我们可以使用双样本检验:

In [20]:

```

stats.ttest_ind(data['FSIQ'], data['PIQ'])

```

Out[20]:

```

(0.46563759638096403, 0.64277250094148408)

```

使用这种方法的问题是忘记了两个观察之间有联系: FSIQ 和 PIQ 是在相同的个体上进行的测量。因此被试之间的差异是混淆的,并且可以使用"配对实验"或"[重复测量实验](https://en.wikipedia.org/wiki/Repeated_measures_design)"来消除。

In [21]:

```

stats.ttest_rel(data['FSIQ'], data['PIQ'])

```

Out[21]:

```

(1.7842019405859857, 0.082172638183642358)

```

这等价于单样本的差异检验:

In [22]:

```

stats.ttest_1samp(data['FSIQ'] - data['PIQ'], 0)

```

Out[22]:

```

(1.7842019405859857, 0.082172638183642358)

```

T-tests假定高斯误差。我们可以使用[威尔科克森符号秩检验](https://en.wikipedia.org/wiki/Wilcoxon_signed-rank_test), 放松了这个假设:

In [23]:

```

stats.wilcoxon(data['FSIQ'], data['PIQ'])

```

Out[23]:

```

(274.5, 0.10659492713506856)

```

> **注意:** 非配对实验对应的非参数检验是[曼惠特尼U检验](https://en.wikipedia.org/wiki/Mann%E2%80%93Whitney_U), [scipy.stats.mannwhitneyu()](http://docs.scipy.org/doc/scipy/reference/generated/scipy.stats.mannwhitneyu.html#scipy.stats.mannwhitneyu)。

>

> **练习**

>

> * 检验男性和女性重量的差异。

> * 使用非参数检验来检验男性和女性VIQ的差异。

>

> **结论**: 我们发现数据并不支持男性和女性VIQ不同的假设。

## 3.1.3 线性模型、多因素和因素分析

### 3.1.3.1 用“公式” 来在Python中指定统计模型

#### 3.1.3.1.1 简单线性回归

给定两组观察值,x和y, 我们想要检验假设y是x的线性函数,换句话说:

$y = x * coef + intercept + e$

其中$e$是观察噪音。我们将使用[statmodels module](http://statsmodels.sourceforge.net/):

* 拟合一个线性模型。我们将使用简单的策略,[普通最小二乘](https://en.wikipedia.org/wiki/Ordinary_least_squares) (OLS)。

* 检验系数是否是非0。

首先,我们生成模型的虚拟数据:

In [9]:

```

import numpy as np

x = np.linspace(-5, 5, 20)

np.random.seed(1)

# normal distributed noise

y = -5 + 3*x + 4 * np.random.normal(size=x.shape)

# Create a data frame containing all the relevant variables

data = pandas.DataFrame({'x': x, 'y': y})

```

> **Python中的统计公式**

>

> [见statsmodels文档](http://statsmodels.sourceforge.net/stable/example_formulas.html)

然后我们指定一个OLS模型并且拟合它:

In [10]:

```

from statsmodels.formula.api import ols

model = ols("y ~ x", data).fit()

```

我们可以检查fit产生的各种统计量:

In [26]:

```

print(model.summary())

```

```

OLS Regression Results

==============================================================================

Dep. Variable: y R-squared: 0.804

Model: OLS Adj. R-squared: 0.794

Method: Least Squares F-statistic: 74.03

Date: Wed, 18 Nov 2015 Prob (F-statistic): 8.56e-08

Time: 17:10:03 Log-Likelihood: -57.988

No. Observations: 20 AIC: 120.0

Df Residuals: 18 BIC: 122.0

Df Model: 1

Covariance Type: nonrobust

==============================================================================

coef std err t P>|t| [95.0% Conf. Int.]

------------------------------------------------------------------------------

Intercept -5.5335 1.036 -5.342 0.000 -7.710 -3.357

x 2.9369 0.341 8.604 0.000 2.220 3.654

==============================================================================

Omnibus: 0.100 Durbin-Watson: 2.956

Prob(Omnibus): 0.951 Jarque-Bera (JB): 0.322

Skew: -0.058 Prob(JB): 0.851

Kurtosis: 2.390 Cond. No. 3.03

==============================================================================

Warnings:

[1] Standard Errors assume that the covariance matrix of the errors is correctly specified.

```

> **术语**:

>

> Statsmodels使用统计术语: statsmodel的y变量被称为‘endogenous’而x变量被称为exogenous。更详细的讨论见[这里](http://statsmodels.sourceforge.net/devel/endog_exog.html)。

>

> 为了简化,y (endogenous) 是你要尝试预测的值,而 x (exogenous) 代表用来进行这个预测的特征。

>

> **练习**

>

> 从以上模型中取回估计参数。**提示**: 使用tab-完成来找到相关的属性。

#### 3.1.3.1.2 类别变量: 比较组或多个类别

让我们回到大脑大小的数据:

In [27]:

```

data = pandas.read_csv('examples/brain_size.csv', sep=';', na_values=".")

```

我们可以写一个比较,用线性模型比较男女IQ:

In [28]:

```

model = ols("VIQ ~ Gender + 1", data).fit()

print(model.summary())

```

```

OLS Regression Results

==============================================================================

Dep. Variable: VIQ R-squared: 0.015

Model: OLS Adj. R-squared: -0.010

Method: Least Squares F-statistic: 0.5969

Date: Wed, 18 Nov 2015 Prob (F-statistic): 0.445

Time: 17:34:10 Log-Likelihood: -182.42

No. Observations: 40 AIC: 368.8

Df Residuals: 38 BIC: 372.2

Df Model: 1

Covariance Type: nonrobust

==================================================================================

coef std err t P>|t| [95.0% Conf. Int.]

----------------------------------------------------------------------------------

Intercept 109.4500 5.308 20.619 0.000 98.704 120.196

Gender[T.Male] 5.8000 7.507 0.773 0.445 -9.397 20.997

==============================================================================

Omnibus: 26.188 Durbin-Watson: 1.709

Prob(Omnibus): 0.000 Jarque-Bera (JB): 3.703

Skew: 0.010 Prob(JB): 0.157

Kurtosis: 1.510 Cond. No. 2.62

==============================================================================

Warnings:

[1] Standard Errors assume that the covariance matrix of the errors is correctly specified.

```

**特定模型的提示**

**强制类别**: ‘Gender’ 被自动识别为类别变量,因此,它的每一个不同值都被处理为不同的实体。 使用:

In [29]:

```

model = ols('VIQ ~ C(Gender)', data).fit()

```

可以将一个整数列强制作为类别处理。

**截距**: 我们可以在公式中用-1删除截距,或者用+1强制使用截距。

默认,statsmodel将带有K和可能值的类别变量处理为K-1'虚拟变量' (最后一个水平被吸收到截距项中)。在绝大多数情况下,这都是很好的默认选择 - 但是,为类别变量指定不同的编码方式也是可以的 ([http://statsmodels.sourceforge.net/devel/contrasts.html)。](http://statsmodels.sourceforge.net/devel/contrasts.html)。)

**FSIQ和PIQ差异的t-检验**

要比较不同类型的IQ,我们需要创建一个"长形式"的表格,用一个类别变量来标识IQ类型:

In [30]:

```

data_fisq = pandas.DataFrame({'iq': data['FSIQ'], 'type': 'fsiq'})

data_piq = pandas.DataFrame({'iq': data['PIQ'], 'type': 'piq'})

data_long = pandas.concat((data_fisq, data_piq))

print(data_long)

```

```

iq type

0 133 fsiq

1 140 fsiq

2 139 fsiq

3 133 fsiq

4 137 fsiq

5 99 fsiq

6 138 fsiq

7 92 fsiq

8 89 fsiq

9 133 fsiq

10 132 fsiq

11 141 fsiq

12 135 fsiq

13 140 fsiq

14 96 fsiq

15 83 fsiq

16 132 fsiq

17 100 fsiq

18 101 fsiq

19 80 fsiq

20 83 fsiq

21 97 fsiq

22 135 fsiq

23 139 fsiq

24 91 fsiq

25 141 fsiq

26 85 fsiq

27 103 fsiq

28 77 fsiq

29 130 fsiq

.. ... ...

10 124 piq

11 128 piq

12 124 piq

13 147 piq

14 90 piq

15 96 piq

16 120 piq

17 102 piq

18 84 piq

19 86 piq

20 86 piq

21 84 piq

22 134 piq

23 128 piq

24 102 piq

25 131 piq

26 84 piq

27 110 piq

28 72 piq

29 124 piq

30 132 piq

31 137 piq

32 110 piq

33 86 piq

34 81 piq

35 128 piq

36 124 piq

37 94 piq

38 74 piq

39 89 piq

[80 rows x 2 columns]

```

In [31]:

```

model = ols("iq ~ type", data_long).fit()

print(model.summary())

```

```

OLS Regression Results

==============================================================================

Dep. Variable: iq R-squared: 0.003

Model: OLS Adj. R-squared: -0.010

Method: Least Squares F-statistic: 0.2168

Date: Wed, 18 Nov 2015 Prob (F-statistic): 0.643

Time: 18:16:40 Log-Likelihood: -364.35

No. Observations: 80 AIC: 732.7

Df Residuals: 78 BIC: 737.5

Df Model: 1

Covariance Type: nonrobust

===============================================================================

coef std err t P>|t| [95.0% Conf. Int.]

-------------------------------------------------------------------------------

Intercept 113.4500 3.683 30.807 0.000 106.119 120.781

type[T.piq] -2.4250 5.208 -0.466 0.643 -12.793 7.943

==============================================================================

Omnibus: 164.598 Durbin-Watson: 1.531

Prob(Omnibus): 0.000 Jarque-Bera (JB): 8.062

Skew: -0.110 Prob(JB): 0.0178

Kurtosis: 1.461 Cond. No. 2.62

==============================================================================

Warnings:

[1] Standard Errors assume that the covariance matrix of the errors is correctly specified.

```

我们可以看到我们获得了与前面t-检验相同的值,以及相同的对应iq type的p-值:

In [32]:

```

stats.ttest_ind(data['FSIQ'], data['PIQ'])

```

Out[32]:

```

(0.46563759638096403, 0.64277250094148408)

```

### 3.1.3.2 多元回归: 包含多因素

考虑用2个变量x和y来解释变量z的线性模型:

$z = x \, c_1 + y \, c_2 + i + e$

这个模型可以被视为在3D世界中用一个平面去拟合 (x, y, z) 的点云。

**实例: 鸢尾花数据 ([examples/iris.csv](examples/iris.csv))**

萼片和花瓣的大小似乎是相关的: 越大的花越大! 但是,在不同的种之间是否有额外的系统效应?

In [33]:

```

data = pandas.read_csv('examples/iris.csv')

model = ols('sepal_width ~ name + petal_length', data).fit()

print(model.summary())

```

```

OLS Regression Results

==============================================================================

Dep. Variable: sepal_width R-squared: 0.478

Model: OLS Adj. R-squared: 0.468

Method: Least Squares F-statistic: 44.63

Date: Thu, 19 Nov 2015 Prob (F-statistic): 1.58e-20

Time: 09:56:04 Log-Likelihood: -38.185

No. Observations: 150 AIC: 84.37

Df Residuals: 146 BIC: 96.41

Df Model: 3

Covariance Type: nonrobust

======================================================================================

coef std err t P>|t| [95.0% Conf. Int.]

--------------------------------------------------------------------------------------

Intercept 2.9813 0.099 29.989 0.000 2.785 3.178

name[T.versicolor] -1.4821 0.181 -8.190 0.000 -1.840 -1.124

name[T.virginica] -1.6635 0.256 -6.502 0.000 -2.169 -1.158

petal_length 0.2983 0.061 4.920 0.000 0.178 0.418

==============================================================================

Omnibus: 2.868 Durbin-Watson: 1.753

Prob(Omnibus): 0.238 Jarque-Bera (JB): 2.885

Skew: -0.082 Prob(JB): 0.236

Kurtosis: 3.659 Cond. No. 54.0

==============================================================================

Warnings:

[1] Standard Errors assume that the covariance matrix of the errors is correctly specified.

```

### 3.1.3.3 事后假设检验: 方差分析 (ANOVA))

在上面的鸢尾花例子中,在排除了萼片的影响之后,我们想要检验versicolor和virginica的花瓣长度是否有差异。这可以被公式化为检验在上面的线性模型中versicolor和virginica系数的差异 (方差分析, ANOVA)。我们写了"差异"向量的参数来估计: 我们想要用[F-检验](https://en.wikipedia.org/wiki/F-test)检验 "`name[T.versicolor] - name[T.virginica]`":

In [36]:

```

print(model.f_test([0, 1, -1, 0]))

```

```

<F test: F=array([[ 3.24533535]]), p=0.073690587817, df_denom=146, df_num=1>

```

是否差异显著?

> **练习** 回到大脑大小 + IQ 数据, 排除了大脑大小、高度和重量的影响后,检验男女的VIQ差异。

## 3.1.4 更多可视化: 用seaborn来进行统计学探索

[Seaborn](http://stanford.edu/~mwaskom/software/seaborn/) 集成了简单的统计学拟合与pandas dataframes绘图。

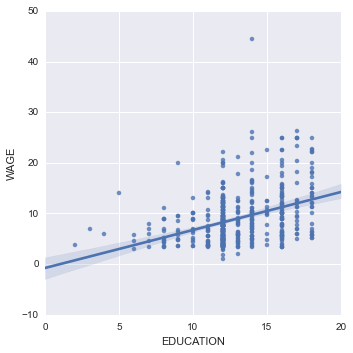

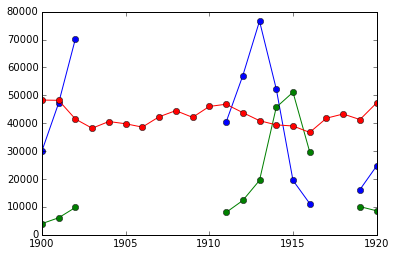

让我们考虑一个500个个体的工资及其它个人信息的数据 ([Berndt, ER. The Practice of Econometrics. 1991\. NY: Addison-Wesley](http://lib.stat.cmu.edu/datasets/CPS_85_Wages))。

加载并绘制工资数据的完整代码可以在[对应的例子](http://www.scipy-lectures.org/packages/statistics/auto_examples/plot_wage_data.html#example-plot-wage-data-py)中找到。

In [3]:

```

print data

```

```

EDUCATION SOUTH SEX EXPERIENCE UNION WAGE AGE RACE OCCUPATION \

0 8 0 1 21 0 5.10 35 2 6

1 9 0 1 42 0 4.95 57 3 6

2 12 0 0 1 0 6.67 19 3 6

3 12 0 0 4 0 4.00 22 3 6

4 12 0 0 17 0 7.50 35 3 6

5 13 0 0 9 1 13.07 28 3 6

6 10 1 0 27 0 4.45 43 3 6

7 12 0 0 9 0 19.47 27 3 6

8 16 0 0 11 0 13.28 33 3 6

9 12 0 0 9 0 8.75 27 3 6

10 12 0 0 17 1 11.35 35 3 6

11 12 0 0 19 1 11.50 37 3 6

12 8 1 0 27 0 6.50 41 3 6

13 9 1 0 30 1 6.25 45 3 6

14 9 1 0 29 0 19.98 44 3 6

15 12 0 0 37 0 7.30 55 3 6

16 7 1 0 44 0 8.00 57 3 6

17 12 0 0 26 1 22.20 44 3 6

18 11 0 0 16 0 3.65 33 3 6

19 12 0 0 33 0 20.55 51 3 6

20 12 0 1 16 1 5.71 34 3 6

21 7 0 0 42 1 7.00 55 1 6

22 12 0 0 9 0 3.75 27 3 6

23 11 1 0 14 0 4.50 31 1 6

24 12 0 0 23 0 9.56 41 3 6

25 6 1 0 45 0 5.75 57 3 6

26 12 0 0 8 0 9.36 26 3 6

27 10 0 0 30 0 6.50 46 3 6

28 12 0 1 8 0 3.35 26 3 6

29 12 0 0 8 0 4.75 26 3 6

.. ... ... ... ... ... ... ... ... ...

504 17 0 1 10 0 11.25 33 3 5

505 16 0 1 10 1 6.67 32 3 5

506 16 0 1 17 0 8.00 39 2 5

507 18 0 0 7 0 18.16 31 3 5

508 16 0 1 14 0 12.00 36 3 5

509 16 0 1 22 1 8.89 44 3 5

510 17 0 1 14 0 9.50 37 3 5

511 16 0 0 11 0 13.65 33 3 5

512 18 0 0 23 1 12.00 47 3 5

513 12 0 0 39 1 15.00 57 3 5

514 16 0 0 15 0 12.67 37 3 5

515 14 0 1 15 0 7.38 35 2 5

516 16 0 0 10 0 15.56 32 3 5

517 12 1 1 25 0 7.45 43 3 5

518 14 0 1 12 0 6.25 32 3 5

519 16 1 1 7 0 6.25 29 2 5

520 17 0 0 7 1 9.37 30 3 5

521 16 0 0 17 0 22.50 39 3 5

522 16 0 0 10 1 7.50 32 3 5

523 17 1 0 2 0 7.00 25 3 5

524 9 1 1 34 1 5.75 49 1 5

525 15 0 1 11 0 7.67 32 3 5

526 15 0 0 10 0 12.50 31 3 5

527 12 1 0 12 0 16.00 30 3 5

528 16 0 1 6 1 11.79 28 3 5

529 18 0 0 5 0 11.36 29 3 5

530 12 0 1 33 0 6.10 51 1 5

531 17 0 1 25 1 23.25 48 1 5

532 12 1 0 13 1 19.88 31 3 5

533 16 0 0 33 0 15.38 55 3 5

SECTOR MARR

0 1 1

1 1 1

2 1 0

3 0 0

4 0 1

5 0 0

6 0 0

7 0 0

8 1 1

9 0 0

10 0 1

11 1 0

12 0 1

13 0 0

14 0 1

15 2 1

16 0 1

17 1 1

18 0 0

19 0 1

20 1 1

21 1 1

22 0 0

23 0 1

24 0 1

25 1 1

26 1 1

27 0 1

28 1 1

29 0 1

.. ... ...

504 0 0

505 0 0

506 0 1

507 0 1

508 0 1

509 0 1

510 0 1

511 0 1

512 0 1

513 0 1

514 0 1

515 0 0

516 0 0

517 0 0

518 0 1

519 0 1

520 0 1

521 1 1

522 0 1

523 0 1

524 0 1

525 0 1

526 0 0

527 0 1

528 0 0

529 0 0

530 0 1

531 0 1

532 0 1

533 1 1

[534 rows x 11 columns]

```

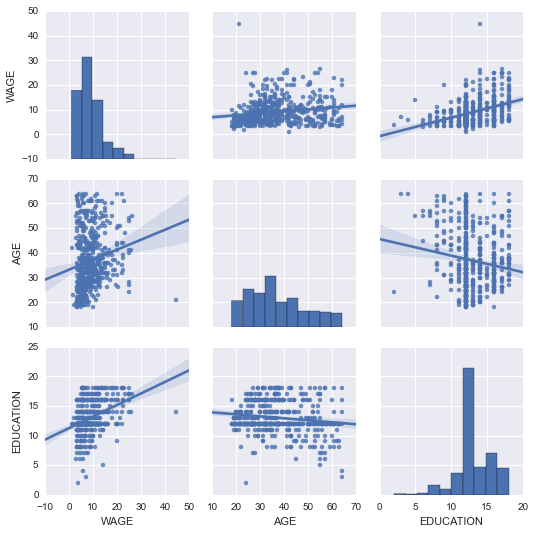

### 3.1.4.1 配对图: 散点矩阵

使用[seaborn.pairplot()](http://stanford.edu/~mwaskom/software/seaborn/generated/seaborn.pairplot.html#seaborn.pairplot)来显示散点矩阵我们可以很轻松的对连续变量之间的交互有一个直觉:

In [4]:

```

import seaborn

seaborn.pairplot(data, vars=['WAGE', 'AGE', 'EDUCATION'], kind='reg')

```

Out[4]:

```

<seaborn.axisgrid.PairGrid at 0x107feb850>

```

```

/Library/Frameworks/Python.framework/Versions/2.7/lib/python2.7/site-packages/matplotlib/collections.py:590: FutureWarning: elementwise comparison failed; returning scalar instead, but in the future will perform elementwise comparison

if self._edgecolors == str('face'):

```

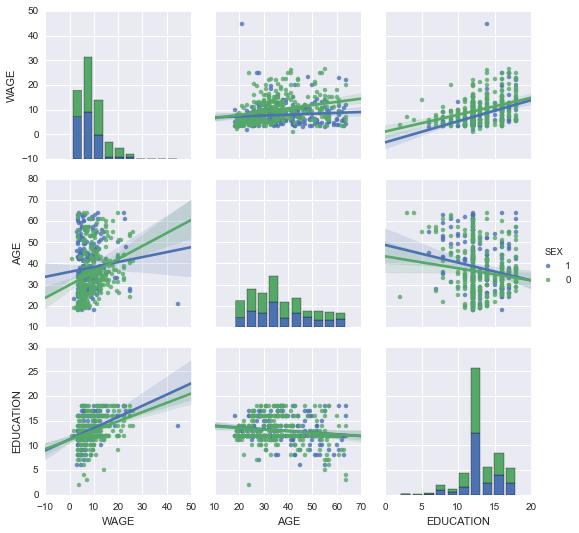

可以用颜色来绘制类别变量:

In [5]:

```

seaborn.pairplot(data, vars=['WAGE', 'AGE', 'EDUCATION'], kind='reg', hue='SEX')

```

Out[5]:

```

<seaborn.axisgrid.PairGrid at 0x107feb650>

```

**看一下并感受一些matplotlib设置**

Seaborn改变了matplotlib的默认图案以便获得更"现代"、更"类似Excel"的外观。它是通过import来实现的。重置默认设置可以使用:

In [8]:

```

from matplotlib import pyplot as plt

plt.rcdefaults()

```

要切换回seaborn设置, 或者更好理解seaborn中的样式, 见[seaborn文档中的相关部分](http://stanford.edu/~mwaskom/software/seaborn/tutorial/aesthetics.html)。

### 3.1.4.2\. lmplot: 绘制一个单变量回归

回归捕捉了一个变量与另一个变量的关系,例如薪水和教育,可以用[seaborn.lmplot()](http://stanford.edu/~mwaskom/software/seaborn/generated/seaborn.lmplot.html#seaborn.lmplot)来绘制:

In [6]:

```

seaborn.lmplot(y='WAGE', x='EDUCATION', data=data)

```

Out[6]:

```

<seaborn.axisgrid.FacetGrid at 0x108db6050>

```

**稳健回归**

在上图中,有一些数据点偏离了右侧的主要云,他们可能是异常值,对总体没有代表性,但是,推动了回归。

要计算对异常值不敏感的回归,必须使用[稳健模型](https://en.wikipedia.org/wiki/Robust_statistics)。在seaborn的绘图函数中可以使用`robust=True`,或者在statsmodels用"稳健线性回归"`statsmodels.formula.api.rlm()`来替换OLS。

## 3.1.5 交互作用检验

是否教育对工资的提升在男性中比女性中更多?

上图来自两个不同的拟合。我们需要公式化一个简单的模型来检验总体倾斜的差异。这通过"交互作用"来完成。

In [22]:

```

result = ols(formula='WAGE ~ EDUCATION + C(SEX) + EDUCATION * C(SEX)', data=data).fit()

print(result.summary())

```

```

OLS Regression Results

==============================================================================

Dep. Variable: WAGE R-squared: 0.190

Model: OLS Adj. R-squared: 0.186

Method: Least Squares F-statistic: 41.50

Date: Thu, 19 Nov 2015 Prob (F-statistic): 4.24e-24

Time: 12:06:38 Log-Likelihood: -1575.0

No. Observations: 534 AIC: 3158.

Df Residuals: 530 BIC: 3175.

Df Model: 3

Covariance Type: nonrobust

=========================================================================================

coef std err t P>|t| [95.0% Conf. Int.]

-----------------------------------------------------------------------------------------

Intercept 1.1046 1.314 0.841 0.401 -1.476 3.685

C(SEX)[T.1] -4.3704 2.085 -2.096 0.037 -8.466 -0.274

EDUCATION 0.6831 0.099 6.918 0.000 0.489 0.877

EDUCATION:C(SEX)[T.1] 0.1725 0.157 1.098 0.273 -0.136 0.481

==============================================================================

Omnibus: 208.151 Durbin-Watson: 1.863

Prob(Omnibus): 0.000 Jarque-Bera (JB): 1278.081

Skew: 1.587 Prob(JB): 2.94e-278

Kurtosis: 9.883 Cond. No. 170.

==============================================================================

Warnings:

[1] Standard Errors assume that the covariance matrix of the errors is correctly specified.

```

我们可以得出结论教育对男性的益处大于女性吗?

**带回家的信息**

* 假设检验和p-值告诉你影响 / 差异的**显著性**

* **公式** (带有类别变量) 让你可以表达你数据中的丰富联系

* **可视化**数据和简单模型拟合很重要!

* **条件化** (添加可以解释所有或部分方差的因素) 在改变交互作用建模方面非常重要。

## 3.1.6 完整例子

### [3.1.6.1 例子](http://www.scipy-lectures.org/packages/statistics/auto_examples/index.html)

#### [3.1.6.1.1 代码例子](http://www.scipy-lectures.org/packages/statistics/auto_examples/index.html#code-examples)

#### [3.1.6.1.2 课程练习的答案](http://www.scipy-lectures.org/packages/statistics/auto_examples/index.html#solutions-to-the-exercises-of-the-course)

2.8 与C进行交互

最后更新于:2022-04-01 11:21:54

# 2.8 与C进行交互

In [1]:

```

%matplotlib inline

import numpy as np

```