OpenCV2学习笔记(二十二)

最后更新于:2022-04-01 06:36:35

##ORB特征提取

ORB(ORiented Brief)特征提取算法,其前身Brief,是由EPFL的Calonder在ECCV2010上提出了一种可以快速计算且表达方式为二进制编码的描述子,主要思路就是在特征点附近随机选取若干点对,将这些点对的灰度值的大小,组合成一个二进制串,并将这个二进制串作为该特征点的特征描述子。BRIEF最大的优点在于速度快,然而其缺点也相当明显,主要有以下几方面:

1. 不具有旋转不变性;

2. 不具有尺度不变性;

3. 对抗噪声性能差。

ORB就是试图解决上述缺点中的1和3,即具有旋转不变性的同时具有较好的抗噪能力。运算速度方面,ORB算法是SIFT算法的100倍,是SURF算法的10倍。

**ORB算法解决旋转不变性问题的思想:**

ORB算法中采用了FAST作为特征点检测算子。在SIFT算法中,梯度直方图的把第一峰值的方向设置为特征点的主方向;如果次峰值的量度达到峰值的80%,则把第二个峰值的方向也设定为主方向,该算法相对更耗时。而在ORB的方案中,特征点的主方向是通过矩(moment)计算得来。有了主方向之后,就可以依据该主方向提取Brief描述子。

**ORB算法解决对噪声敏感问题的方法:**

由于ORB算法不直接使用像素点与点之间进行比较,而是选择以该像素为中心的一个区域作为整一个比较对象,因此提高了抗噪声的能力。

**关于尺度不变性问题:**

ORB没有解决尺度不变性的问题(因为FAST本身就不具有尺度不变性)而且这类快速的特征描述子,通常都是应用在实时的视频处理中的,可以通过跟踪还有一些启发式的策略来解决尺度不变性的问题。

**相关论文下载:**

Calonder M., Lepetit V., Strecha C., Fua P.: BRIEF:Binary Robust Independent Elementary Features. ECCV 2010

[ORB: an efficient alternative to SIFT or SURF](http://www.willowgarage.com/sites/default/files/orb_final.pdf)

作为Brief的改进,ORB早在OpenCV 2.4.2版本就已经被实现出来了。在OpenCV中,ORB类继承自Feature2D类,另外有两个类:OrbFeatureDetector和OrbDescriptorExtractor,与ORB类是等价的。

**一个简单的实验:**

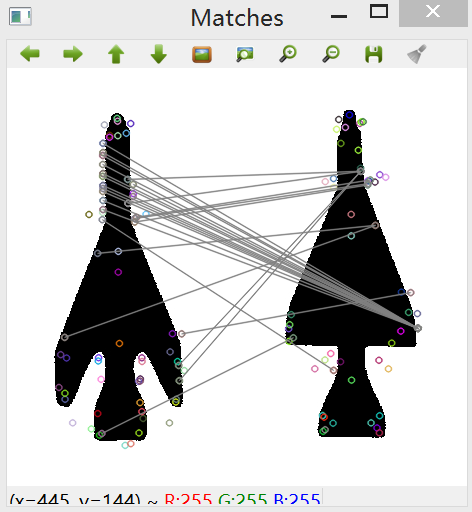

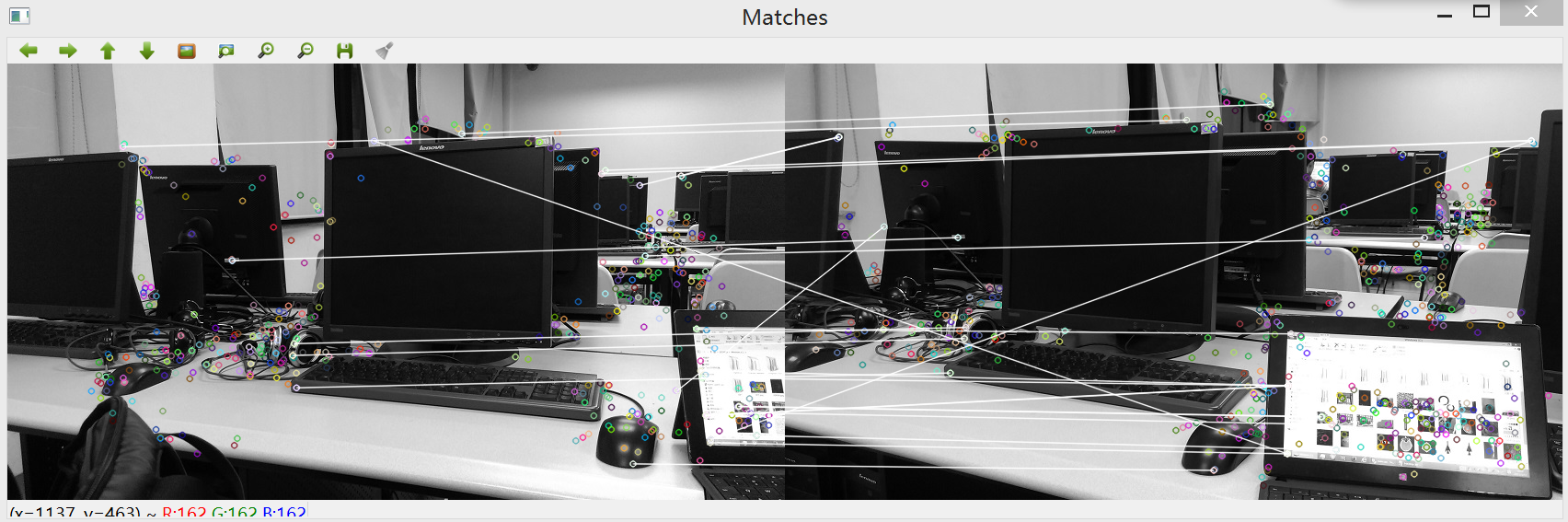

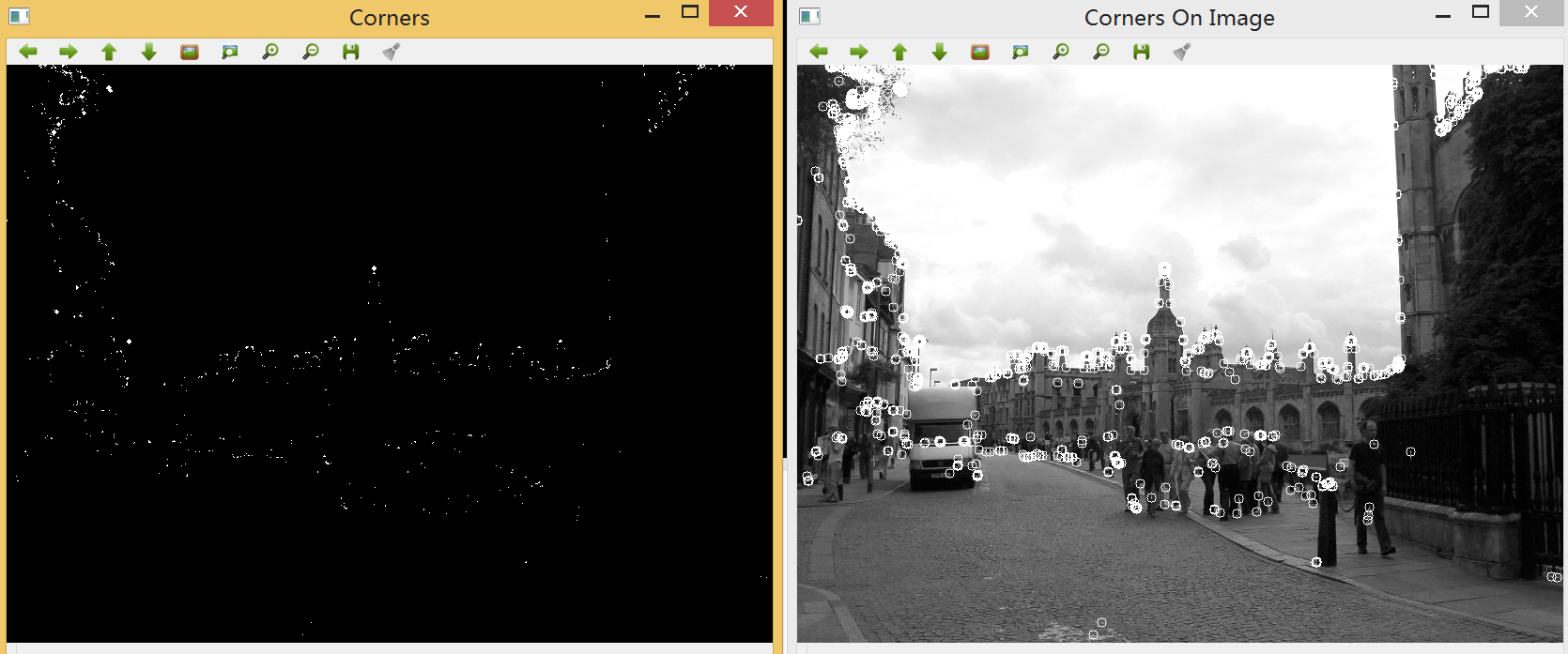

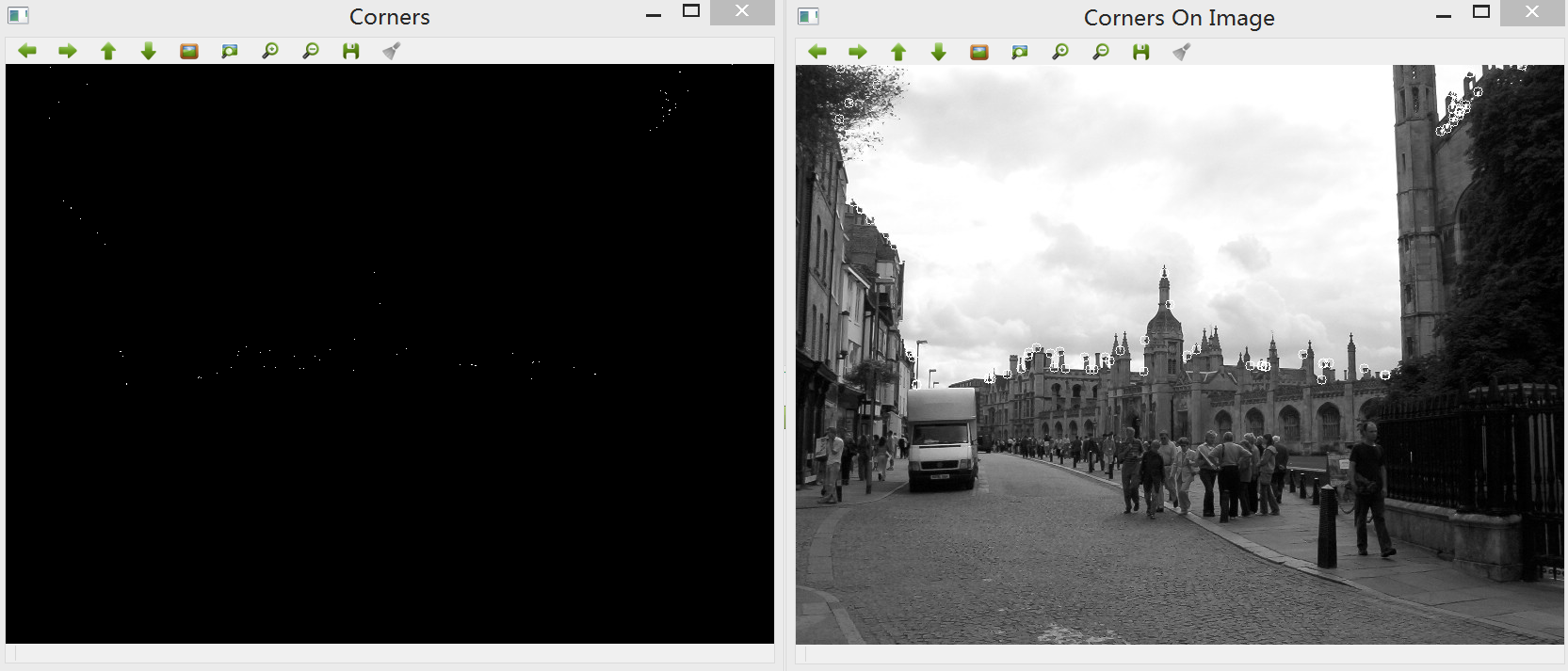

**ORB特征提取与匹配结果(未筛选特征点):**

**ORB特征提取与匹配结果(已筛选特征点):**

实验代码参照《OpenCV 3 编程入门》一书的例程编写。

OpenCV2学习笔记(二十一)

最后更新于:2022-04-01 06:36:33

##GPU模块小记

接触一下OpenCV里一个之前没有接触的模块:GPU。这里只是根据教程和网上一些文章进行简单的记叙,欢迎大家批评指正。

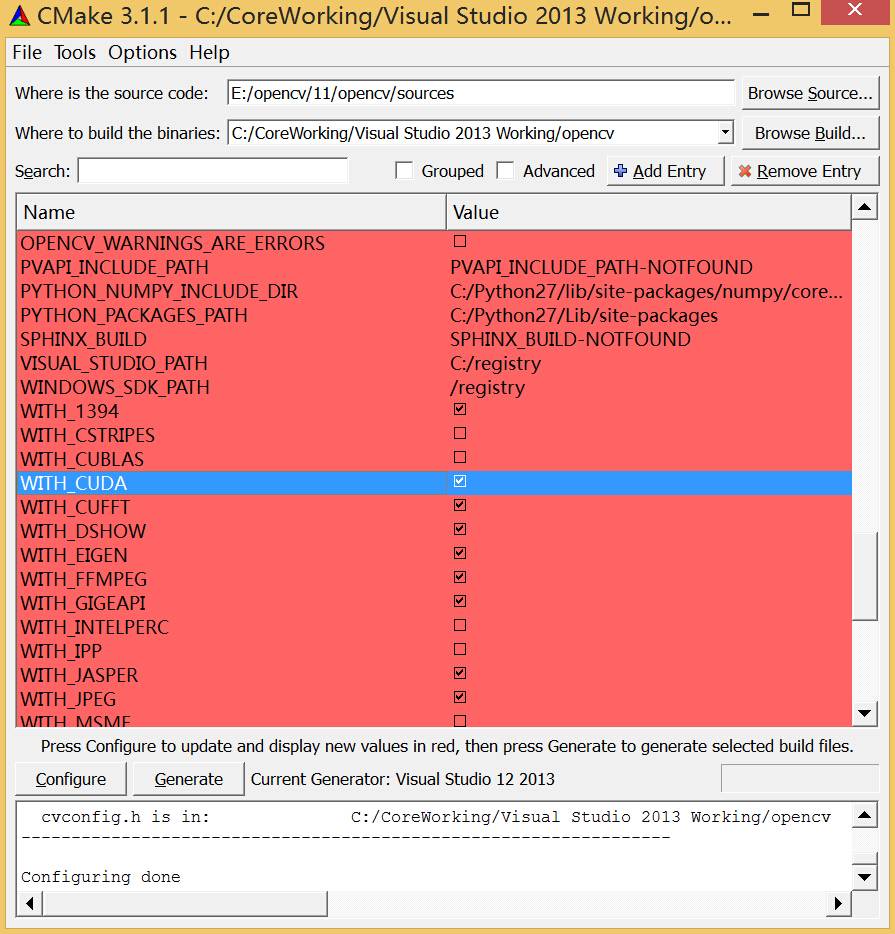

注:在使用GPU模块之前,需要确认在使用CMake编译OpenCV时,勾选了选项WITH_CUDA和WITH_TBB使其生效生效。

若以上配置已经完成,在使用GPU模块的函数之前,还做一下检查:调用函数gpu::getCudaEnabledDeviceCount,如果你在使用的OpenCV模块编译时不支持GPU,这个函数返回值为0;否则返回值为已安装的CUDA设备的数量。

OpenCV的GPU模块只支持NVIDIA的显卡,原因是该部分是基于NVIDIA的CUDA和NVIDIA的NPP模块实现的。而该模块的好处在于使用GPU模块无需安装CUDA工具,也无需学习GPU编程,因为不需要编写GPU相关的代码。但如果你想重新编译OpenCV的GPU模块的话,还是需要CUDA的toolkit。

由于GPU模块的发展,使大部分函数使用起来和之前在CPU下开发非常类似。首先,就是把GPU模块链接到你的工程中,并包含必要的头文件gpu.hpp。其次,就是GPU模块下的数据结构,原本在cv名字空间中的现在都在gpu名字空间中,使用时可以gpu::和cv::来防止混淆。

在GPU模块中,矩阵的类型为:GpuMat而不是OpenCV中使用的cv::Mat,其他的函数命名和CPU模块中相同。OpenCV中GPU模块函数的使用步骤如下:

~~~

1.验证OpenCV是否已启用GPU模块。

2.上传待处理数据到GPU (Mat --> GpuMat)。

3.调用OpenCV支持的GPU的处理函数。

4.下载处理结果到CPU (GpuMat ---> Mat)。

~~~

根据[http://blog.csdn.net/yang_xian521/article/details/7249532](http://blog.csdn.net/yang_xian521/article/details/7249532) 所提到的,一个问题是对于2.0的GPU模块,多通道的函数支持的并不好,推荐使用GPU模块处理灰度的图像。有些情况下,使用GPU模块的运行速度还不及CPU模块下的性能,所以可以认为,GPU模块相对而言还不够成熟,需要进一步优化。很重要的一个原因就是内存管理部分和数据转换部分对于GPU模块而言消耗了大量的时间。

一段自带的示例代码如下,实现求矩阵转置的功能:

~~~

#include <iostream>

#include "cvconfig.h"

#include "opencv2/core/core.hpp"

#include "opencv2/gpu/gpu.hpp"

#include "opencv2/core/internal.hpp" // For TBB wrappers

using namespace std;

using namespace cv;

using namespace cv::gpu;

struct Worker { void operator()(int device_id) const; };

int main()

{

int num_devices = getCudaEnabledDeviceCount();

if (num_devices < 2)

{

std::cout << "Two or more GPUs are required\n";

return -1;

}

for (int i = 0; i < num_devices; ++i)

{

DeviceInfo dev_info(i);

if (!dev_info.isCompatible())

{

std::cout << "GPU module isn't built for GPU #" << i << " ("

<< dev_info.name() << ", CC " << dev_info.majorVersion()

<< dev_info.minorVersion() << "\n";

return -1;

}

}

// Execute calculation in two threads using two GPUs

int devices[] = {0, 1};

parallel_do(devices, devices + 2, Worker());

return 0;

}

void Worker::operator()(int device_id) const

{

setDevice(device_id);

Mat src(1000, 1000, CV_32F);

Mat dst;

RNG rng(0);

rng.fill(src, RNG::UNIFORM, 0, 1);

// CPU works

transpose(src, dst);

// GPU works

GpuMat d_src(src);

GpuMat d_dst;

transpose(d_src, d_dst);

// Check results

bool passed = norm(dst - Mat(d_dst), NORM_INF) < 1e-3;

std::cout << "GPU #" << device_id << " (" << DeviceInfo().name() << "): "

<< (passed ? "passed" : "FAILED") << endl;

// Deallocate data here, otherwise deallocation will be performed

// after context is extracted from the stack

d_src.release();

d_dst.release();

}

~~~

CUDA的基本使用方法:[http://www.cnblogs.com/dwdxdy/archive/2013/08/07/3244508.html](http://www.cnblogs.com/dwdxdy/archive/2013/08/07/3244508.html)

OpenCV2学习笔记(二十)

最后更新于:2022-04-01 06:36:31

##Win8.1 64位+OpenCV 2.4.9+Python2.7.9配置

OpenCV提供了Python接口,主要特性包括:

* 提供与OpenCV 2.x中最新的C++接口极为相似的Python接口,并且包括C++中不包括的C接口

* 提供对OpenCV 2.x中所有主要部件的绑定:CxCORE (almost complete), CxFLANN (complete), Cv (complete), CvAux (C++ part almost complete, C part in progress), CvVidSurv (complete), HighGui (complete), and ML (complete)

* 在Python中访问C++中的数据结构

* 完善的内存管理,使用者无须担心内存的问题

* 可以在 OpenCV 的 Mat 与 wxWidgets, PyGTK, and PIL 中使用的 arrays 互相转换

比起C++,Python适合做原型。这里介绍如何配置OpenCV 2.4.9+Python2.7.9,以便在Python中使用OpenCV图形库。

**需要下载的东西如下**(注意版本问题):

一.opencv 2.4.9 下载链接: [http://opencv.org/](http://opencv.org/) ,关于opencv的编译与配置可参考:[http://blog.csdn.net/liyuefeilong/article/details/43526975](http://blog.csdn.net/liyuefeilong/article/details/43526975)

[http://blog.csdn.net/liyuefeilong/article/details/44872809](http://blog.csdn.net/liyuefeilong/article/details/44872809)

二.python 下载链接: [https://www.python.org/](https://www.python.org/). (版本选择python2.7.9)

三.NumPy(opencv的python版需要该模块,NumPy的版本要和Python版本相同),这里提供两种安装方法:

1.此处下载链接: [http://www.lfd.uci.edu/~gohlke/pythonlibs/](http://www.lfd.uci.edu/~gohlke/pythonlibs/) 选择最新版本numpy-1.9.2+mkl-cp27-none-win_amd64.whl,请留意不要下载成cp27对应python 2.7版本,若python选择64位,则NumPy也必须选择64版本。whl文件的安装步骤如下:

* 将下载的NumPy包移动到python安装位置(笔者的路径为C:\Python27)下的Scripts文件夹

* Shift+右键打开命令窗口cmd,输入:`pip install wheel` 安装wheel模块。

* wheel安装成功后,在命令窗口中键入以下命令即安装成功:

~~~

cd c:/Python27/Scripts

pip install numpy-1.9.2rc1+mkl-cp27-none-win_amd64.whl

~~~

2.下载链接: [http://download.csdn.net/detail/liyuefeilong/8647101](http://download.csdn.net/detail/liyuefeilong/8647101)

下载完成后,运行文件numpy-MKL-1.8.0.win-amd64-py2.7.exe,一步一步安装即可。

**简单的配置**

在opencv文件夹中,找到build->python->2.7,其中包含x86和x64两个文件夹,由于这里安装的python和NumPy均为64位版本,因此复制x64文件夹中的cv2.pyd文件到C:\Python27\Lib\site-packages 中即可。

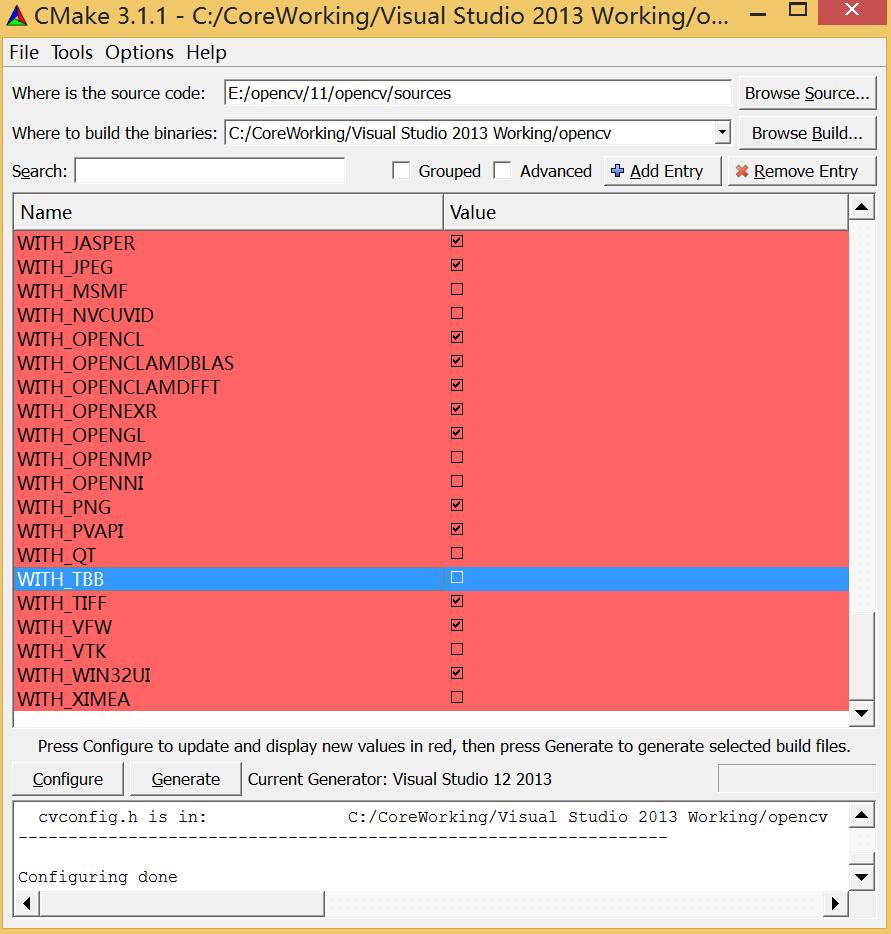

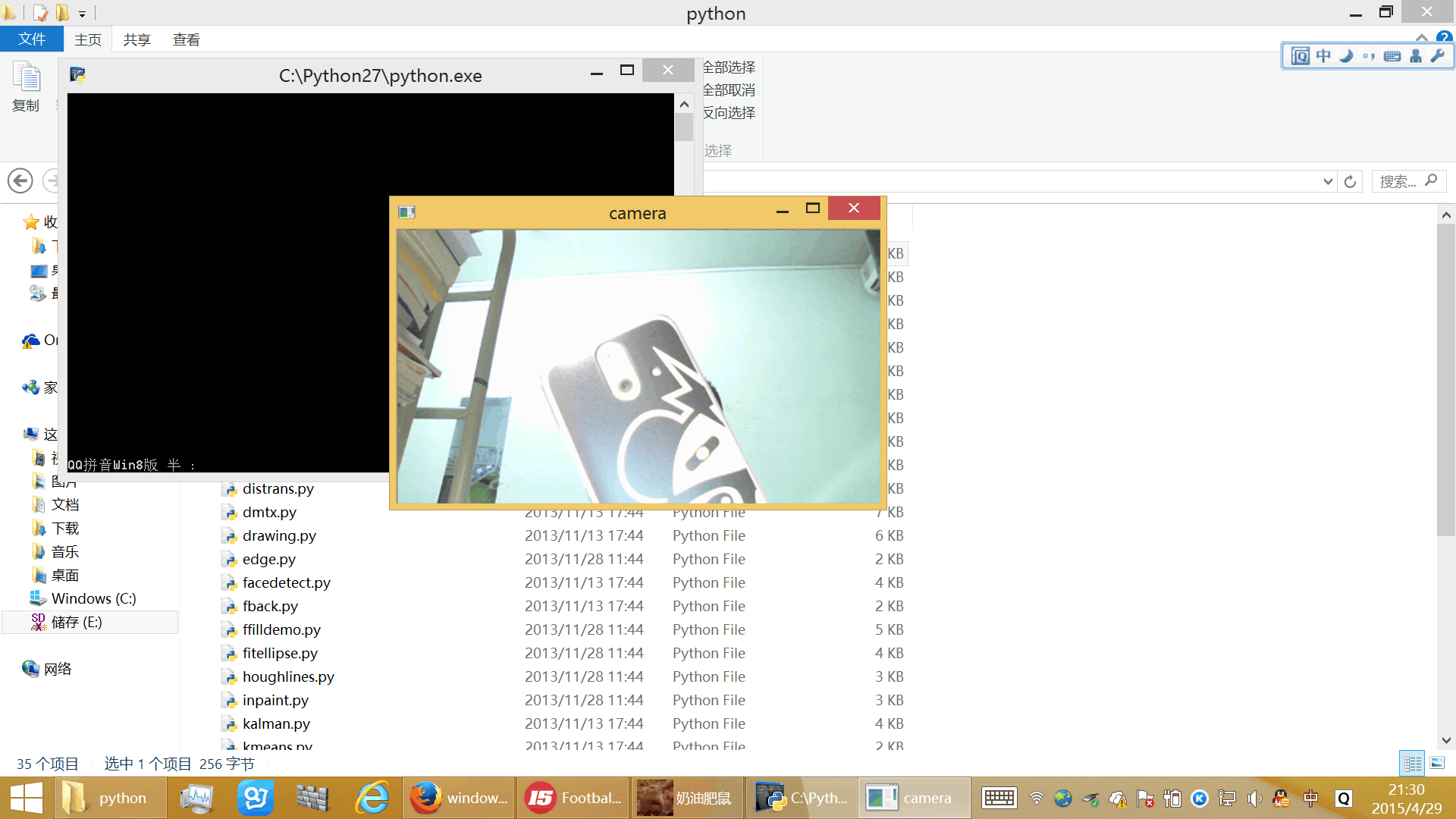

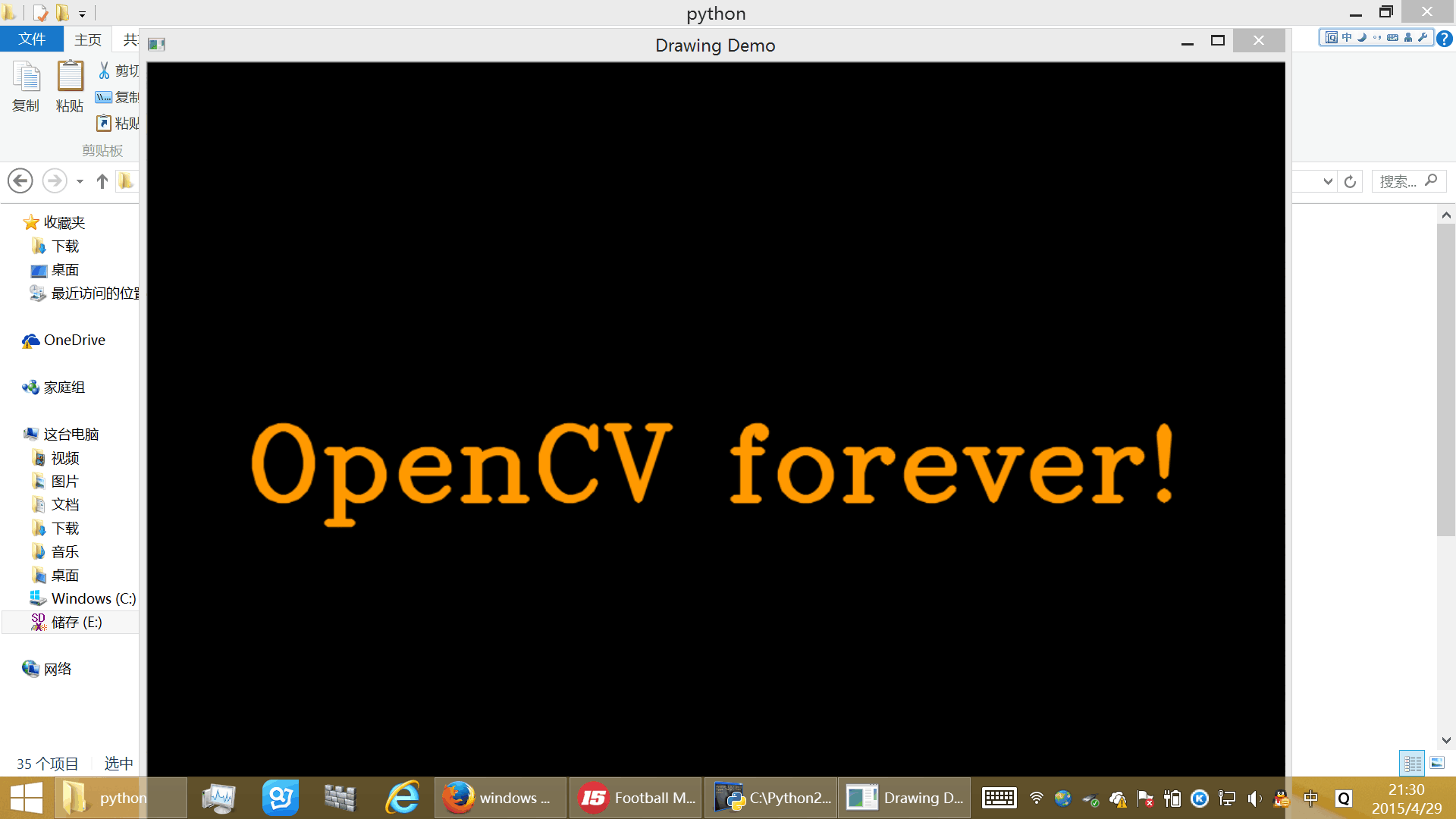

为了测试安装和配置是否成功,可以打开opencv\sources\samples\python中的例程,如:camera.py,正常情况下即可调用电脑的默认摄像头:

或者双击运行drawing.py,如果没有问题应该看到彩色条纹。

文件夹包含许多例程,其中一些在打开后只是一闪而过,一种原因是程序需要若干参数,这里只是验证配置是否正确,若要跑通所有例程,还是要打开代码看看。事实上,opencv里的很多宏在python里需要加上cv2.cv前缀即可生效。

参考链接:[http://blog.csdn.net/nwpulei/article/details/7277511](http://blog.csdn.net/nwpulei/article/details/7277511)

[http://blog.csdn.net/gxf1027/article/details/9324671](http://blog.csdn.net/gxf1027/article/details/9324671)

[http://www.open-open.com/lib/view/open1355657468166.html](http://www.open-open.com/lib/view/open1355657468166.html)

OpenCV2学习笔记(十九)

最后更新于:2022-04-01 06:36:28

##Kalman滤波算法

在视频跟踪处理中,预测目标运动轨迹是一项基本任务。目标运动状态估计的目的有三个:一是对目标过去的状态进行平滑;二是对目标现在的运动状态进行滤波;三是对目标未来的运动状态进行预测。物体的运动状态一般包括目标位置、速度、加速度等。著名的Kalman滤波技术就是其中一种,这是一种线性系统估计技术。

OpenCV中自带了kalman滤波的代码和例程,可参照kalman.cpp,它存在于类KalmanFilter中。kalman滤波算法的调用比较方便,主要的难点是了解多个参数和矩阵计算公式。一个总体的思路是,需要了解前一时刻的状态估计值x和当前的观测值y,然后建立状态方程和观测方程。经过一些运算后即可预测下一步的状态。

**一、离散时间线性动态系统的状态方程**

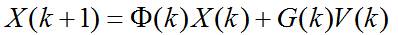

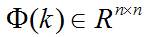

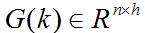

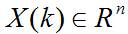

Kalman滤波利用线性系统状态方程,通过系统输入输出观测数据,对系统状态进行最优估计的算法。由于观测数据中包括系统中的噪声和干扰的影响,所以最优估计也可看作是滤波过程。一个**线性系统**是采用状态方程、观测方程及其初始条件来描述。线性离散时间系统的一般状态方程可描述为:

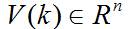

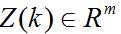

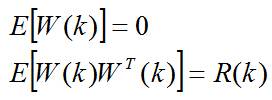

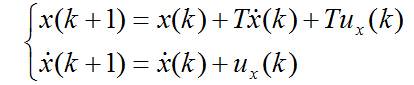

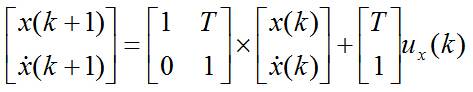

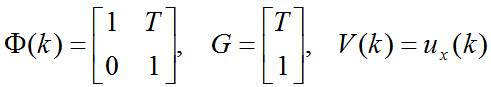

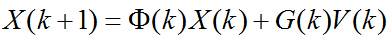

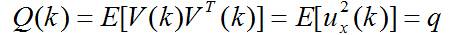

其中, 是状态转移矩阵, 是过程噪声增益矩阵。是k时刻目标的状态向量, 是过程噪声,它是具有均值为零、方差矩阵为Q(k)的高斯噪声向量,即:

**二、传感器的观测方程**

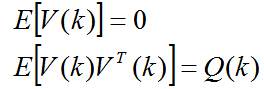

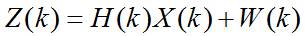

传感器的通用观测方程为:

这里, 是传感器在 时刻的观测向量,观测噪声 是具有零均值和正定协方差矩阵R(k)的高斯分布测量噪声向量,即:

**三、初始状态的描述**

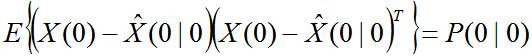

初始状态 是高斯的,具有均值 和协方差 ,即:

以上的描述比较抽象,因此记录一个例子加以说明:

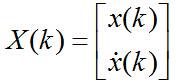

例:目标沿x轴作匀速直线运动,过程噪声为速度噪声,试写出目标的状态方程。

解:由题意知,目标的状态为:

用T表示时间间隔,ux表速度噪声,则有:

写成矩阵形式为:

令:

则有:

其中:

为均值等于0,方差为q的高斯噪声。

在OpenCV中自带的例程里面描述了一个一维的运动跟踪,该点在一个圆弧上运动,只有一个自由度即角度。因此只需建立匀速运动模型即可。

例程的路径:C:\opencv\sources\samples\cpp\kalman.cpp

~~~

在代码中各变量的对应情况如下:

状态估计值X对应:state

当前观测值Z对应:measurement

KalmanFilter类内成员变量transitionMatrix即为状态转移方程中的矩阵A

KalmanFilter类内成员变量measurementMatrix即为量测方程中矩阵C

Mat statePre; //!< predicted state (x'(k)): x(k)=A*x(k-1)+B*u(k)

Mat statePost; //!< corrected state (x(k)): x(k)=x'(k)+K(k)*(z(k)-H*x'(k))

Mat transitionMatrix; //!< state transition matrix (A)

Mat controlMatrix; //!< control matrix (B) (not used if there is no control)

Mat measurementMatrix; //!< measurement matrix (H)

Mat processNoiseCov; //!< process noise covariance matrix (Q)

Mat measurementNoiseCov;//!< measurement noise covariance matrix (R)

Mat errorCovPre; //!< priori error estimate covariance matrix (P'(k)): P'(k)=A*P(k-1)*At + Q)*/

Mat gain; //!< Kalman gain matrix (K(k)): K(k)=P'(k)*Ht*inv(H*P'(k)*Ht+R)

Mat errorCovPost; //!< posteriori error estimate covariance matrix (P(k)): P(k)=(I-K(k)*H)*P'(k)

~~~

以下是OpenCV/modules/video/src/Kalman.cpp的源代码,后续需继续分析这些代码:

~~~

/*M///////////////////////////////////////////////////////////////////////////////////////

//

// IMPORTANT: READ BEFORE DOWNLOADING, COPYING, INSTALLING OR USING.

//

// By downloading, copying, installing or using the software you agree to this license.

// If you do not agree to this license, do not download, install,

// copy or use the software.

//

//

// Intel License Agreement

// For Open Source Computer Vision Library

//

// Copyright (C) 2000, Intel Corporation, all rights reserved.

// Third party copyrights are property of their respective owners.

//

// Redistribution and use in source and binary forms, with or without modification,

// are permitted provided that the following conditions are met:

//

// * Redistribution's of source code must retain the above copyright notice,

// this list of conditions and the following disclaimer.

//

// * Redistribution's in binary form must reproduce the above copyright notice,

// this list of conditions and the following disclaimer in the documentation

// and/or other materials provided with the distribution.

//

// * The name of Intel Corporation may not be used to endorse or promote products

// derived from this software without specific prior written permission.

//

// This software is provided by the copyright holders and contributors "as is" and

// any express or implied warranties, including, but not limited to, the implied

// warranties of merchantability and fitness for a particular purpose are disclaimed.

// In no event shall the Intel Corporation or contributors be liable for any direct,

// indirect, incidental, special, exemplary, or consequential damages

// (including, but not limited to, procurement of substitute goods or services;

// loss of use, data, or profits; or business interruption) however caused

// and on any theory of liability, whether in contract, strict liability,

// or tort (including negligence or otherwise) arising in any way out of

// the use of this software, even if advised of the possibility of such damage.

//

//M*/

#include "precomp.hpp"

CV_IMPL CvKalman*

cvCreateKalman( int DP, int MP, int CP )

{

CvKalman *kalman = 0;

if( DP <= 0 || MP <= 0 )

CV_Error( CV_StsOutOfRange,

"state and measurement vectors must have positive number of dimensions" );

if( CP < 0 )

CP = DP;

/* allocating memory for the structure */

kalman = (CvKalman *)cvAlloc( sizeof( CvKalman ));

memset( kalman, 0, sizeof(*kalman));

kalman->DP = DP;

kalman->MP = MP;

kalman->CP = CP;

kalman->state_pre = cvCreateMat( DP, 1, CV_32FC1 );

cvZero( kalman->state_pre );

kalman->state_post = cvCreateMat( DP, 1, CV_32FC1 );

cvZero( kalman->state_post );

kalman->transition_matrix = cvCreateMat( DP, DP, CV_32FC1 );

cvSetIdentity( kalman->transition_matrix );

kalman->process_noise_cov = cvCreateMat( DP, DP, CV_32FC1 );

cvSetIdentity( kalman->process_noise_cov );

kalman->measurement_matrix = cvCreateMat( MP, DP, CV_32FC1 );

cvZero( kalman->measurement_matrix );

kalman->measurement_noise_cov = cvCreateMat( MP, MP, CV_32FC1 );

cvSetIdentity( kalman->measurement_noise_cov );

kalman->error_cov_pre = cvCreateMat( DP, DP, CV_32FC1 );

kalman->error_cov_post = cvCreateMat( DP, DP, CV_32FC1 );

cvZero( kalman->error_cov_post );

kalman->gain = cvCreateMat( DP, MP, CV_32FC1 );

if( CP > 0 )

{

kalman->control_matrix = cvCreateMat( DP, CP, CV_32FC1 );

cvZero( kalman->control_matrix );

}

kalman->temp1 = cvCreateMat( DP, DP, CV_32FC1 );

kalman->temp2 = cvCreateMat( MP, DP, CV_32FC1 );

kalman->temp3 = cvCreateMat( MP, MP, CV_32FC1 );

kalman->temp4 = cvCreateMat( MP, DP, CV_32FC1 );

kalman->temp5 = cvCreateMat( MP, 1, CV_32FC1 );

#if 1

kalman->PosterState = kalman->state_pre->data.fl;

kalman->PriorState = kalman->state_post->data.fl;

kalman->DynamMatr = kalman->transition_matrix->data.fl;

kalman->MeasurementMatr = kalman->measurement_matrix->data.fl;

kalman->MNCovariance = kalman->measurement_noise_cov->data.fl;

kalman->PNCovariance = kalman->process_noise_cov->data.fl;

kalman->KalmGainMatr = kalman->gain->data.fl;

kalman->PriorErrorCovariance = kalman->error_cov_pre->data.fl;

kalman->PosterErrorCovariance = kalman->error_cov_post->data.fl;

#endif

return kalman;

}

CV_IMPL void

cvReleaseKalman( CvKalman** _kalman )

{

CvKalman *kalman;

if( !_kalman )

CV_Error( CV_StsNullPtr, "" );

kalman = *_kalman;

if( !kalman )

return;

/* freeing the memory */

cvReleaseMat( &kalman->state_pre );

cvReleaseMat( &kalman->state_post );

cvReleaseMat( &kalman->transition_matrix );

cvReleaseMat( &kalman->control_matrix );

cvReleaseMat( &kalman->measurement_matrix );

cvReleaseMat( &kalman->process_noise_cov );

cvReleaseMat( &kalman->measurement_noise_cov );

cvReleaseMat( &kalman->error_cov_pre );

cvReleaseMat( &kalman->gain );

cvReleaseMat( &kalman->error_cov_post );

cvReleaseMat( &kalman->temp1 );

cvReleaseMat( &kalman->temp2 );

cvReleaseMat( &kalman->temp3 );

cvReleaseMat( &kalman->temp4 );

cvReleaseMat( &kalman->temp5 );

memset( kalman, 0, sizeof(*kalman));

/* deallocating the structure */

cvFree( _kalman );

}

CV_IMPL const CvMat*

cvKalmanPredict( CvKalman* kalman, const CvMat* control )

{

if( !kalman )

CV_Error( CV_StsNullPtr, "" );

/* update the state */

/* x'(k) = A*x(k) */

cvMatMulAdd( kalman->transition_matrix, kalman->state_post, 0, kalman->state_pre );

if( control && kalman->CP > 0 )

/* x'(k) = x'(k) + B*u(k) */

cvMatMulAdd( kalman->control_matrix, control, kalman->state_pre, kalman->state_pre );

/* update error covariance matrices */

/* temp1 = A*P(k) */

cvMatMulAdd( kalman->transition_matrix, kalman->error_cov_post, 0, kalman->temp1 );

/* P'(k) = temp1*At + Q */

cvGEMM( kalman->temp1, kalman->transition_matrix, 1, kalman->process_noise_cov, 1,

kalman->error_cov_pre, CV_GEMM_B_T );

/* handle the case when there will be measurement before the next predict */

cvCopy(kalman->state_pre, kalman->state_post);

return kalman->state_pre;

}

CV_IMPL const CvMat*

cvKalmanCorrect( CvKalman* kalman, const CvMat* measurement )

{

if( !kalman || !measurement )

CV_Error( CV_StsNullPtr, "" );

/* temp2 = H*P'(k) */

cvMatMulAdd( kalman->measurement_matrix, kalman->error_cov_pre, 0, kalman->temp2 );

/* temp3 = temp2*Ht + R */

cvGEMM( kalman->temp2, kalman->measurement_matrix, 1,

kalman->measurement_noise_cov, 1, kalman->temp3, CV_GEMM_B_T );

/* temp4 = inv(temp3)*temp2 = Kt(k) */

cvSolve( kalman->temp3, kalman->temp2, kalman->temp4, CV_SVD );

/* K(k) */

cvTranspose( kalman->temp4, kalman->gain );

/* temp5 = z(k) - H*x'(k) */

cvGEMM( kalman->measurement_matrix, kalman->state_pre, -1, measurement, 1, kalman->temp5 );

/* x(k) = x'(k) + K(k)*temp5 */

cvMatMulAdd( kalman->gain, kalman->temp5, kalman->state_pre, kalman->state_post );

/* P(k) = P'(k) - K(k)*temp2 */

cvGEMM( kalman->gain, kalman->temp2, -1, kalman->error_cov_pre, 1,

kalman->error_cov_post, 0 );

return kalman->state_post;

}

namespace cv

{

KalmanFilter::KalmanFilter() {}

KalmanFilter::KalmanFilter(int dynamParams, int measureParams, int controlParams, int type)

{

init(dynamParams, measureParams, controlParams, type);

}

void KalmanFilter::init(int DP, int MP, int CP, int type)

{

CV_Assert( DP > 0 && MP > 0 );

CV_Assert( type == CV_32F || type == CV_64F );

CP = std::max(CP, 0);

statePre = Mat::zeros(DP, 1, type);

statePost = Mat::zeros(DP, 1, type);

transitionMatrix = Mat::eye(DP, DP, type);

processNoiseCov = Mat::eye(DP, DP, type);

measurementMatrix = Mat::zeros(MP, DP, type);

measurementNoiseCov = Mat::eye(MP, MP, type);

errorCovPre = Mat::zeros(DP, DP, type);

errorCovPost = Mat::zeros(DP, DP, type);

gain = Mat::zeros(DP, MP, type);

if( CP > 0 )

controlMatrix = Mat::zeros(DP, CP, type);

else

controlMatrix.release();

temp1.create(DP, DP, type);

temp2.create(MP, DP, type);

temp3.create(MP, MP, type);

temp4.create(MP, DP, type);

temp5.create(MP, 1, type);

}

const Mat& KalmanFilter::predict(const Mat& control)

{

// update the state: x'(k) = A*x(k)

statePre = transitionMatrix*statePost;

if( control.data )

// x'(k) = x'(k) + B*u(k)

statePre += controlMatrix*control;

// update error covariance matrices: temp1 = A*P(k)

temp1 = transitionMatrix*errorCovPost;

// P'(k) = temp1*At + Q

gemm(temp1, transitionMatrix, 1, processNoiseCov, 1, errorCovPre, GEMM_2_T);

// handle the case when there will be measurement before the next predict.

statePre.copyTo(statePost);

errorCovPre.copyTo(errorCovPost);

return statePre;

}

const Mat& KalmanFilter::correct(const Mat& measurement)

{

// temp2 = H*P'(k)

temp2 = measurementMatrix * errorCovPre;

// temp3 = temp2*Ht + R

gemm(temp2, measurementMatrix, 1, measurementNoiseCov, 1, temp3, GEMM_2_T);

// temp4 = inv(temp3)*temp2 = Kt(k)

solve(temp3, temp2, temp4, DECOMP_SVD);

// K(k)

gain = temp4.t();

// temp5 = z(k) - H*x'(k)

temp5 = measurement - measurementMatrix*statePre;

// x(k) = x'(k) + K(k)*temp5

statePost = statePre + gain*temp5;

// P(k) = P'(k) - K(k)*temp2

errorCovPost = errorCovPre - gain*temp2;

return statePost;

}

}

~~~

参考链接:[http://blog.csdn.net/yang_xian521/article/details/7050398](http://blog.csdn.net/yang_xian521/article/details/7050398)

OpenCV2学习笔记(十八)

最后更新于:2022-04-01 06:36:26

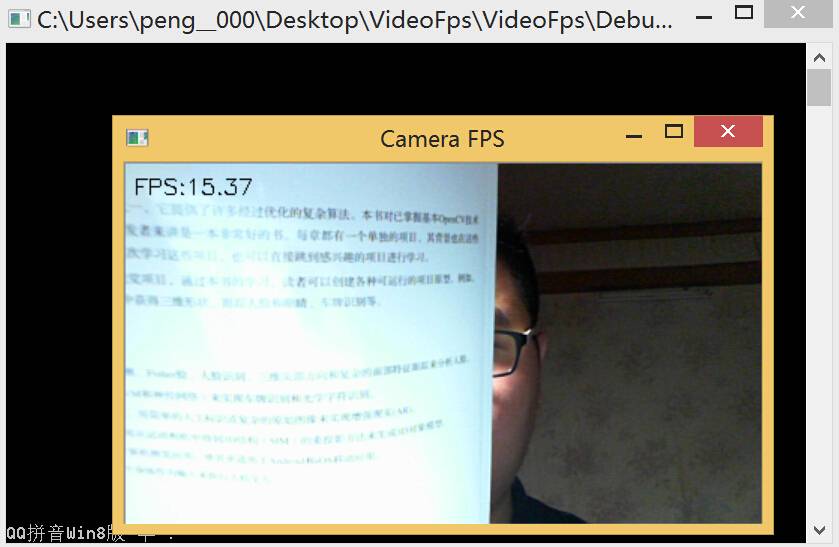

##显示视频流的帧率

最近做一个东西,需要在视频上实时显示帧速,即FPS。FPS是Frame Per Second的缩写,中文意思是每秒帧数。开发平台为VS2013+OpenCV2.4.9。

FPS是测量用于保存、显示动态视频的信息数量。通俗来讲就是指每秒变化的画面数。

在计算FPS时,需要使用的主要函数有getTickCount、getTickFrequency。而在输出图像上显示FPS水印则是使用函数putText,他们的简单声明如下:

~~~

GetTickCount(void);

在Debug版本中,设备启动后便从计时器中减去180秒。这样方便测试使用该函数的代码的正确溢出处理。

在Release版本中,该函数从0开始计时,返回自设备启动后的毫秒数(不含系统暂停时间)。

~~~

~~~

getTickFrequency函数:返回每秒的计时周期数,GetTickCount / getTickFrequency就得到一个周期的时间。

~~~

~~~

void putText(Mat& img, // 图像矩阵

const string& text, // string型内容

Point org, // 字符串的坐标,以左下角为原点

int fontFace, // 字体类型

double fontScale, // 字体大小

Scalar color, // 字体颜色

int thickness = 1, // 字体粗细

int lineType = 8, // 直线类型

bool bottomLeftOrigin = false) // 尚不知是什么功能

~~~

如果想得到一段程序的运行时间,可以套用下面的例子:

~~~

t = (double)cv::getTickCount();

if (capture.isOpened())

{

capture >> frame;

// getTickcount函数:返回从操作系统启动到当前所经过的毫秒数

// getTickFrequency函数:返回每秒的计时周期数

// t为该处代码执行所耗的时间,单位为秒,fps为其倒数

t = ((double)cv::getTickCount() - t) / cv::getTickFrequency();

fps = 1.0 / t;

~~~

**实现显示视频帧率的简单代码:**

~~~

#include <stdlib.h>

#include <iostream>

#include <opencv2/core/core.hpp>

#include <opencv2/highgui/highgui.hpp>

void main()

{

cv::Mat frame;

// 可从摄像头输入视频流或直接播放视频文件

//cv::VideoCapture capture(0);

cv::VideoCapture capture("e:/VIDEO0002.mp4");

double fps;

char string[10]; // 用于存放帧率的字符串

cv::namedWindow("Camera FPS");

double t = 0;

while (1)

{

t = (double)cv::getTickCount();

if (cv::waitKey(50) == 30){ break; }

if (capture.isOpened())

{

capture >> frame;

// getTickcount函数:返回从操作系统启动到当前所经过的毫秒数

// getTickFrequency函数:返回每秒的计时周期数

// t为该处代码执行所耗的时间,单位为秒,fps为其倒数

t = ((double)cv::getTickCount() - t) / cv::getTickFrequency();

fps = 1.0 / t;

sprintf(string, "%.2f", fps); // 帧率保留两位小数

std::string fpsString("FPS:");

fpsString += string; // 在"FPS:"后加入帧率数值字符串

// 将帧率信息写在输出帧上

putText(frame, // 图像矩阵

fpsString, // string型文字内容

cv::Point(5, 20), // 文字坐标,以左下角为原点

cv::FONT_HERSHEY_SIMPLEX, // 字体类型

0.5, // 字体大小

cv::Scalar(0, 0, 0)); // 字体颜色

cv::imshow("Camera FPS", frame);

}

else

{

std::cout << "No Camera Input!" << std::endl;

break;

}

}

}

~~~

以上这段程序可以大致测试出视频处理算法的时间消耗。主要过程是使用以上两个主要函数得到每帧之间的时间,再用putText把FPS的数值显示到屏幕上。

参考资料:[http://www.cnblogs.com/jxsoft/archive/2011/10/17/2215366.html](http://www.cnblogs.com/jxsoft/archive/2011/10/17/2215366.html)

[http://blog.csdn.net/boksic/article/details/7017837](http://blog.csdn.net/boksic/article/details/7017837)

OpenCV2学习笔记(十七)

最后更新于:2022-04-01 06:36:24

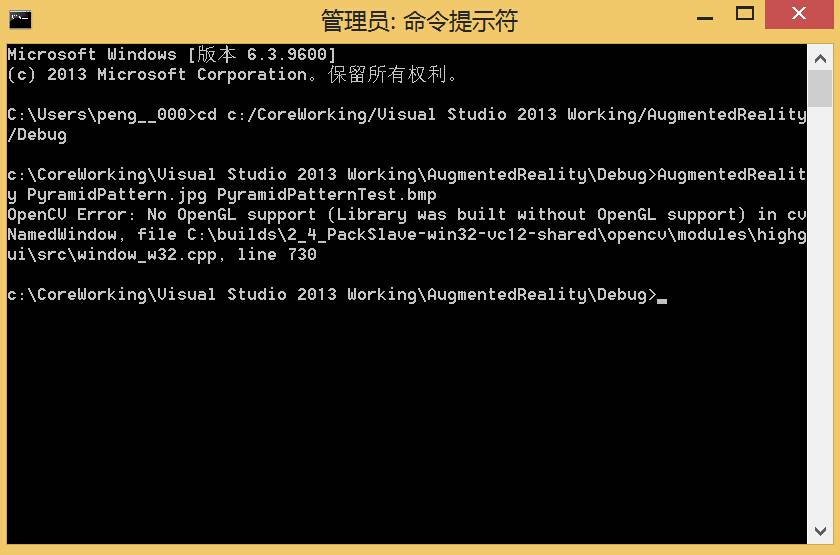

##VS2013中运行支持OpenGL的OpenCV工程

之前一直用Qt+OpenCV开发项目,而在VS中直接偷懒使用预编译的OpenCV进行开发,结果在使用OpenGL时提示”No OpenGL support”:

上网查了一下,原因很明显,是因为预编译好的library不支持OpenGL,因此需要使用cmake重新build工程。我的开发环境是:Win 8.1+VS2013+OpenCV 2.4.9。

> 从OpenCV2.4.2版本开始,OpenCV在可视化窗口中支持OpenGL,在highgui的模块中可找到接口。这使得OpenCV可以轻松渲染任何3D内容。但是OpenCV默认不启用OpenGL支持,因此需设置标志ENABLE_OPENGL=

> YES,(默认ENABLE_OPENGL = NO)。

在本次配置成功后,将演示在OpenCV的显示输出中嵌入OpenGL的3D物体。整个流程如下:

**一、生成OpenCV解决方案**

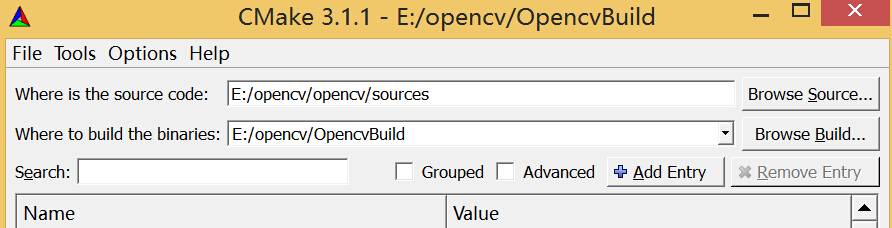

安装CMake并打开,在第一行“Where is the source code”后面的那个“Browse Source…”按钮,选择OpenCV的安装路径。我的Opencv2.0安装路径为E:/opencv/opencv/,这里需要选择source文件夹;点击第二行的“Browse Build…”按钮并选择生成的解决方案的路径。这里放置在E:/opencv/OpencvBuild文件夹中,设定完成后点击左下方的configure。

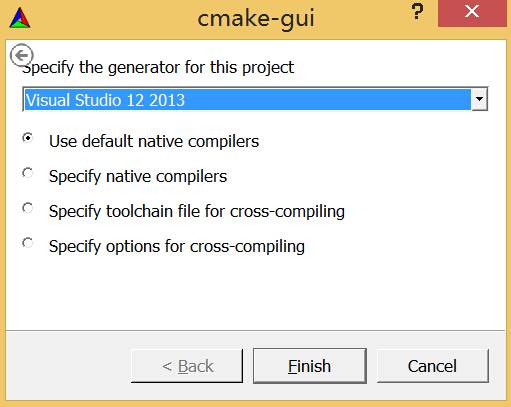

在弹出的对话框中选择编译器版本Visual Studio 12(即Visual Studio 2013),点击Finish。

在下面的编译参数设置中找到WITH_OPENGL,打上勾,再次点击Configure。

再次点击Configure,完成后点击Generate,关闭CMake。至此编译前的配置工作全部完成。

**二、在VS中编译OpenCV**

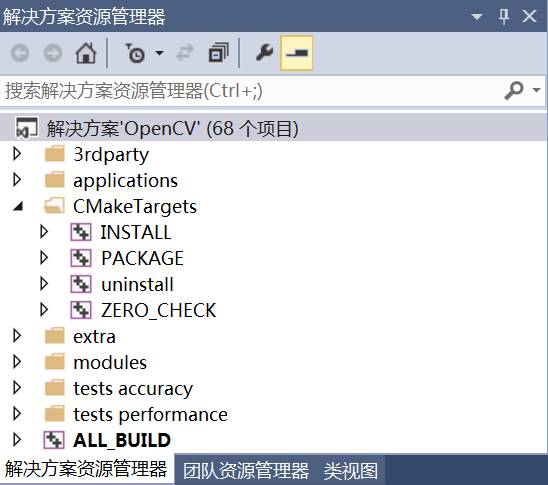

用VS2013打开E:\opencv\OpencvBuild下的OpenCV.sln。在编译之前,确认解决方案平台为Debug|Win 32。右键点击项目ALL_BUILD,选择生成;完成之后找到CMakeTargets->INSTALL,再次选择生成。

等待生成完毕。若第一次选择的解决方案平台选择的是Debug 32位,则将解决方案配置改为Release,然后等待再次依次生成ALL_BUILD和INSTALL,至此OpenCV的编译工作完成。

(这里可能会出现编译的错误。根据网上的介绍,OpenGL在VS中是支持的,不需要安装,但若出现编译不通过的情况,可尝试在所有使用`<gl\gl.h>`头文件的地方前都添加`#include <windows.h>`)

**三、在VS中配置OpenCV**

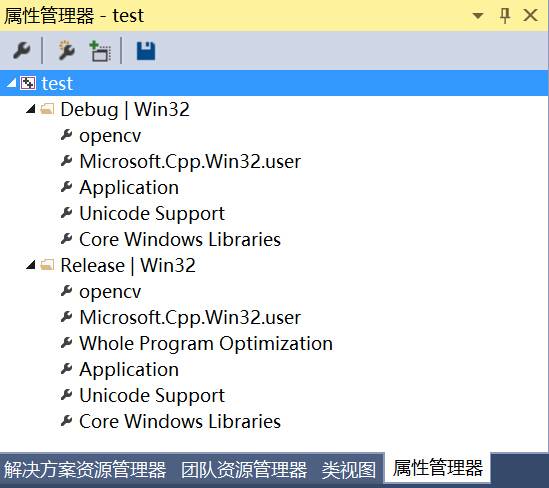

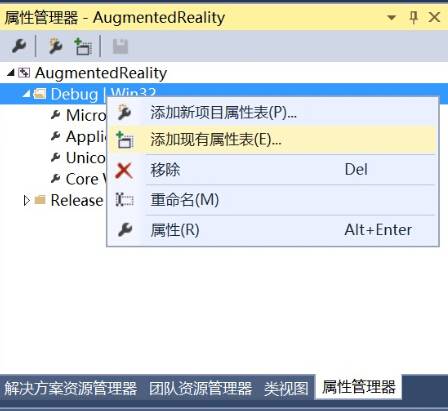

这里用VS属性表的方式配置OpenCV工程,每次只需要添加属性表即可完成配置,比手工界面配置方便很多。 属性管理器 -> 右键 “test”(工程名) -> 添加现有属性。

修改项目属性表的名字后点击“添加”,即可在属性管理器中见到我们新建的属性表(这里取名为opencv)。

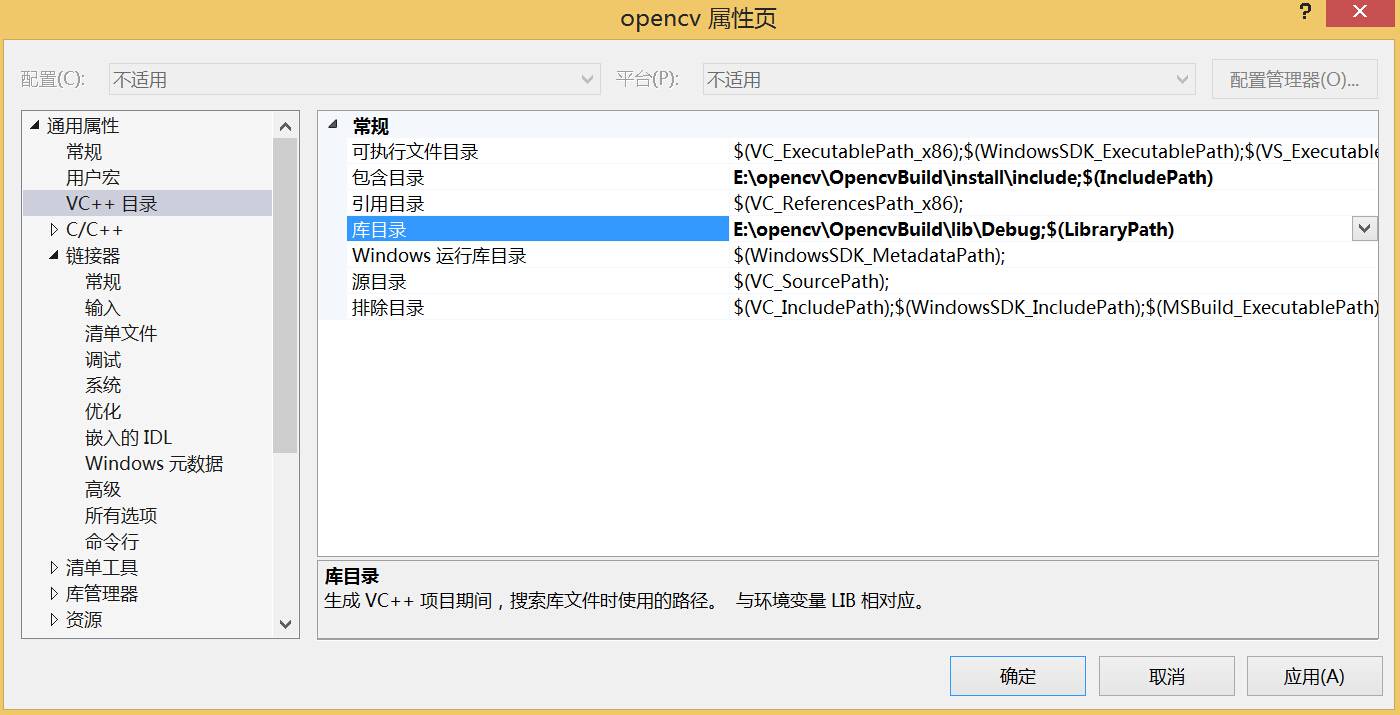

右键点击我们刚建立的属性表并点击“属性”,在弹出的窗口中点击“VC++目录”,点击右侧的“包含目录”,添加:E:\opencv\OpencvBuild\install\include

同样地,在“库目录”添加:E:\opencv\OpencvBuild\lib\Debug

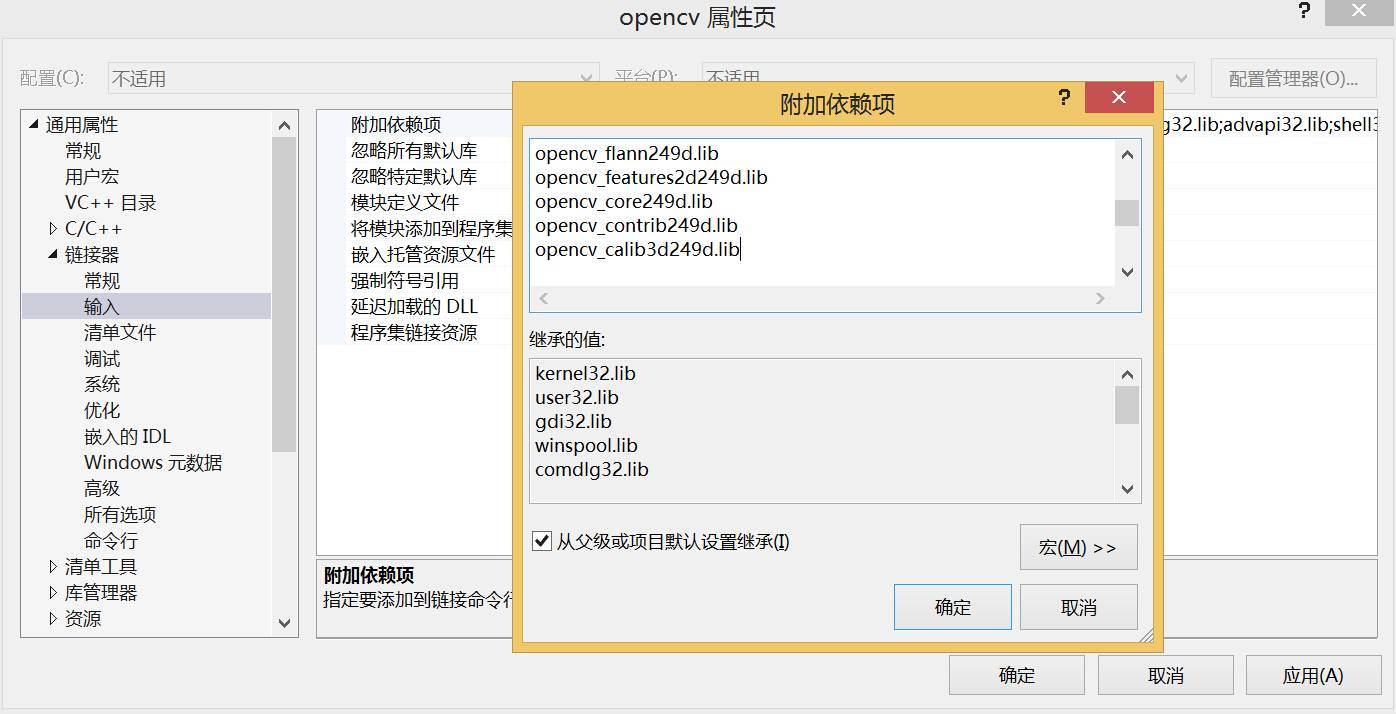

点开“链接器”->输入->附加依赖项,按照需要添加相应的库文件:

用同样的方式,向“Release | Win32”属性中添加属性表,并对属性表进行以下配置:

在“包含目录”添加:E:\opencv\OpencvBuild\install\include

在“库目录”添加:E:\opencv\OpencvBuild\lib\Release

向“附加依赖项”添加:E:\opencv\OpencvBuild\install\include\Release下的库文件。

在VS完成以上配置后,剩下的最后一步是添加系统变量Path:E:\opencv\OpencvBuild\install\x86\vc12\bin;

**四、简单的演示**

至此所有关于OpenCV和OpenGL的配置均已完成,接下来就是试验以下用OpenCV建立OpenGL窗口,这里打开一个现实增强的工程,在属性管理器中Debug|Win32处右击,选择“添加现有属性表”,选择之前生成的opencv属性表(把属性表文件事先放到该工程文件夹中):

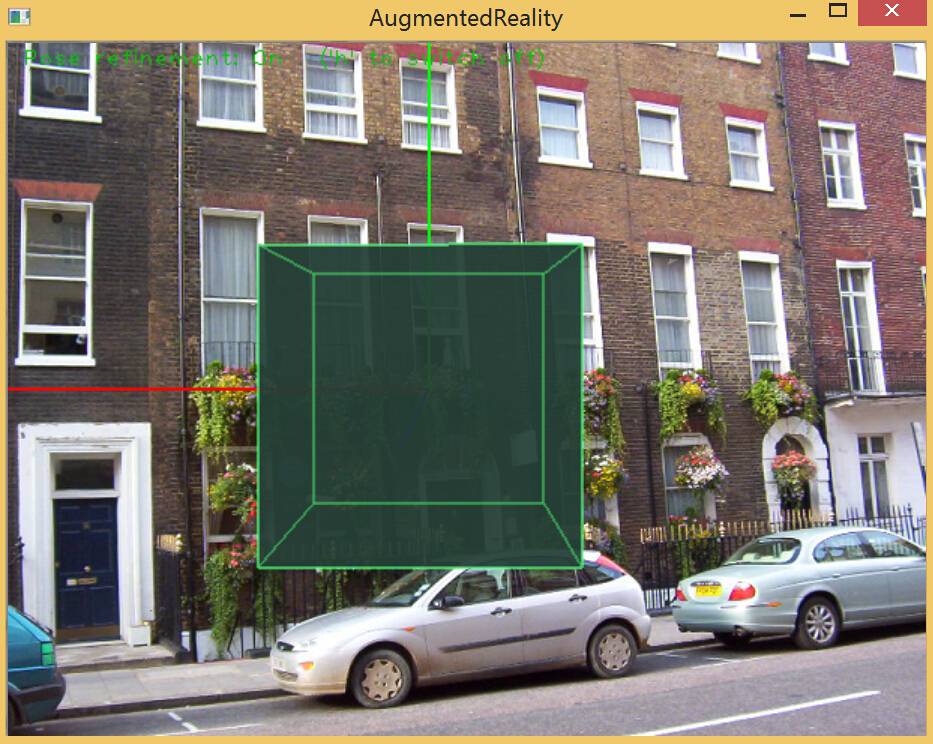

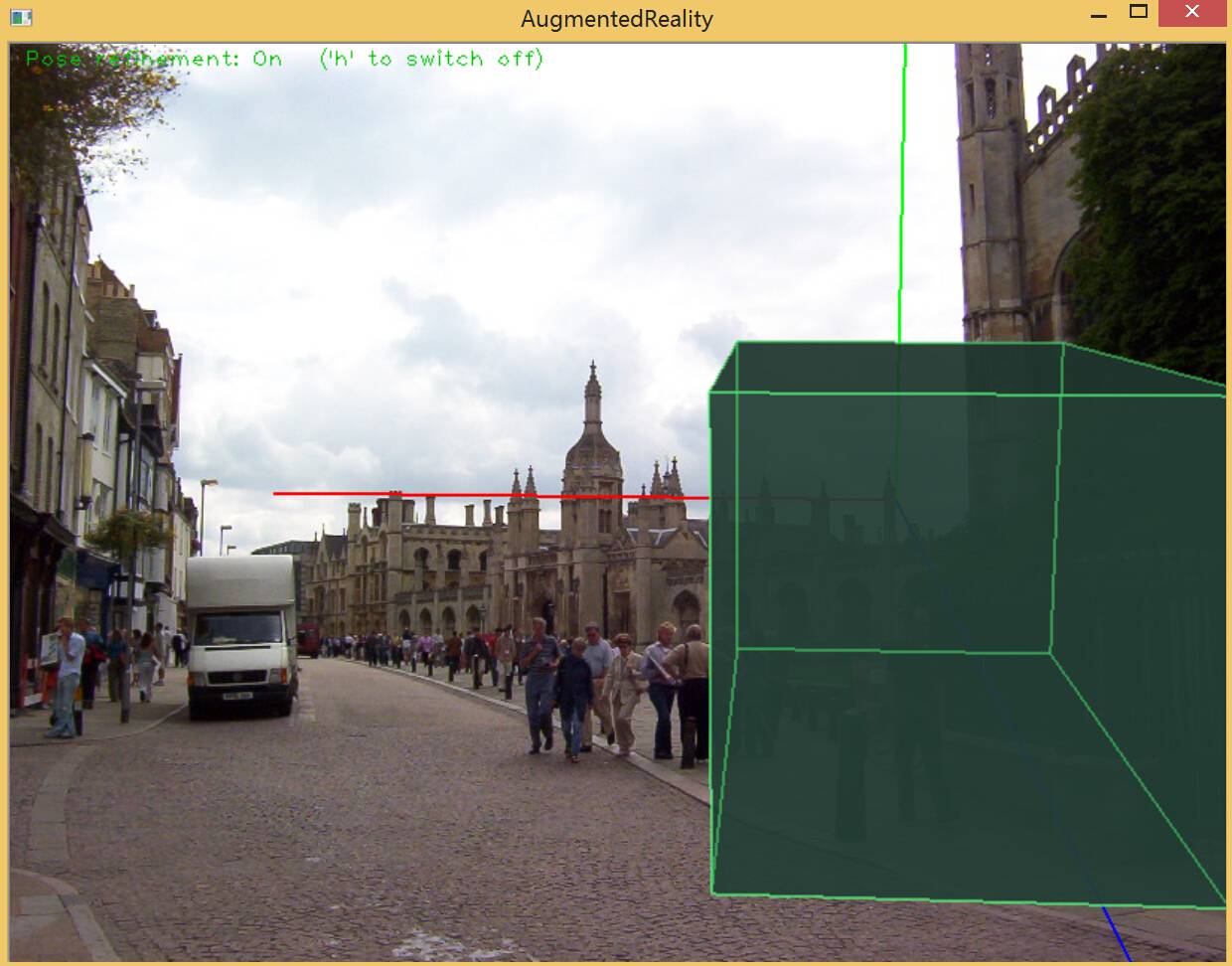

编译现实增强项目并生成可执行文件后,输入图像即可得到OpenGL渲染的3D绘图。

OpenCV2学习笔记(十六)

最后更新于:2022-04-01 06:36:22

##Stitching图像拼接

图像拼接stitching是OpenCV2.4.0出现的一个新模块,所有的相关函数都被封装在Stitcher类当中。关于Stitcher类的详细介绍,可以参考: [http://docs.opencv.org/2.4.2/modules/stitching/doc/high_level.html?highlight=stitcher#stitcher](http://docs.opencv.org/2.4.2/modules/stitching/doc/high_level.html?highlight=stitcher#stitcher)。

这个类当中我们主要用到的成员函数有createDefault,用于创建缺省参数的stitcher;estimateTransform,用于 生成最后的拼接图像;而对于composePanorama和stitch,文档中提示如果对stitching的整过过程不熟悉的话,最好不要使用以上 两个函数,直接使用stitch就行了。整个拼接的算法实现过程十分复杂,其中涉及到图像特征点的提取和匹配、摄像机的校准、图像融合、图像的变形、曝光 补偿等算法的结合。

说得这么复杂,但实际上这些模块的接口调用,OpenCV都为我们搞定了,我们只需要调用createDefault函数生成默认的参数,再使用stitch函数进行拼接就ok了。

图像拼接的实例代码如下,在VS2013平台上运行成功:

~~~

/*M///////////////////////////////////////////////////////////////////////////////////////

//

// IMPORTANT: READ BEFORE DOWNLOADING, COPYING, INSTALLING OR USING.

//

// By downloading, copying, installing or using the software you agree to this license.

// If you do not agree to this license, do not download, install,

// copy or use the software.

//

//

// License Agreement

// For Open Source Computer Vision Library

//

// Copyright (C) 2000-2008, Intel Corporation, all rights reserved.

// Copyright (C) 2009, Willow Garage Inc., all rights reserved.

// Third party copyrights are property of their respective owners.

//

// Redistribution and use in source and binary forms, with or without modification,

// are permitted provided that the following conditions are met:

//

// * Redistribution's of source code must retain the above copyright notice,

// this list of conditions and the following disclaimer.

//

// * Redistribution's in binary form must reproduce the above copyright notice,

// this list of conditions and the following disclaimer in the documentation

// and/or other materials provided with the distribution.

//

// * The name of the copyright holders may not be used to endorse or promote products

// derived from this software without specific prior written permission.

//

// This software is provided by the copyright holders and contributors "as is" and

// any express or implied warranties, including, but not limited to, the implied

// warranties of merchantability and fitness for a particular purpose are disclaimed.

// In no event shall the Intel Corporation or contributors be liable for any direct,

// indirect, incidental, special, exemplary, or consequential damages

// (including, but not limited to, procurement of substitute goods or services;

// loss of use, data, or profits; or business interruption) however caused

// and on any theory of liability, whether in contract, strict liability,

// or tort (including negligence or otherwise) arising in any way out of

// the use of this software, even if advised of the possibility of such damage.

//

//M*/

#include <iostream>

#include <fstream>

#include "opencv2/highgui/highgui.hpp"

#include "opencv2/stitching/stitcher.hpp"

using namespace std;

using namespace cv;

bool try_use_gpu = false;

vector<Mat> imgs;

string result_name = "result.jpg"; // 默认输出文件名及格式

void printUsage();

int parseCmdArgs(int argc, char** argv);

int main(int argc, char* argv[])

{

int retval = parseCmdArgs(argc, argv);

if (retval) return -1;

Mat pano;

Stitcher stitcher = Stitcher::createDefault(try_use_gpu);

Stitcher::Status status = stitcher.stitch(imgs, pano);

if (status != Stitcher::OK)

{

cout << "Can't stitch images, error code = " << status << endl;

return -1;

}

imwrite(result_name, pano);

return 0;

}

void printUsage()

{

cout <<

"Rotation model images stitcher.\n\n"

"stitching img1 img2 [...imgN]\n\n"

"Flags:\n"

" --try_use_gpu (yes|no)\n"

" Try to use GPU. The default value is 'no'. All default values\n"

" are for CPU mode.\n"

" --output <result_img>\n"

" The default is 'result.jpg'.\n";

}

int parseCmdArgs(int argc, char** argv)

{

if (argc == 1)

{

printUsage();

return -1;

}

for (int i = 1; i < argc; ++i)

{

if (string(argv[i]) == "--help" || string(argv[i]) == "/?")

{

printUsage();

return -1;

}

else if (string(argv[i]) == "--try_use_gpu") // 默认不使用gpu加速

{

if (string(argv[i + 1]) == "no")

try_use_gpu = false;

else if (string(argv[i + 1]) == "yes")

try_use_gpu = true;

else

{

cout << "Bad --try_use_gpu flag value\n";

return -1;

}

i++;

}

else if (string(argv[i]) == "--output") // 若定义了输出图像名,则更改result_name

{

result_name = argv[i + 1];

i++;

}

else

{

Mat img = imread(argv[i]);

if (img.empty())

{

cout << "Can't read image '" << argv[i] << "'\n";

return -1;

}

imgs.push_back(img);

}

}

return 0;

}

~~~

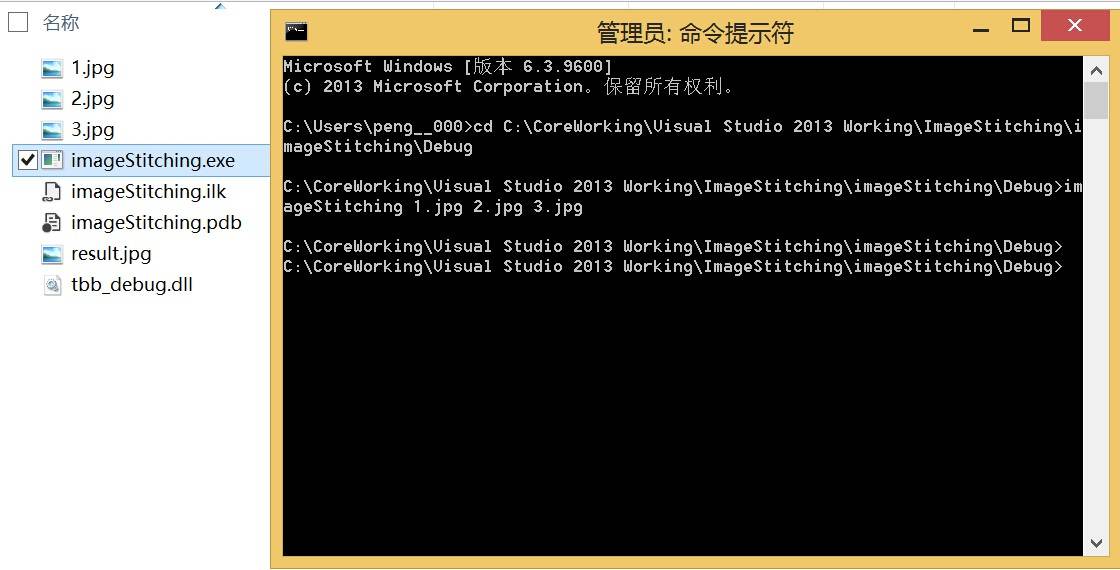

这里在自己的机子上实现简单的图像拼接,程序生成的可执行文件名为imageStitching.exe,如果直接运行程序将直接退出,需要在cmd中进行以下操作:

找到imageStitching.exe所在的目录,在终端里输入imageStitching+**被拼接的图像路径**(若与imageStitching.exe在同个文件夹,直接输入图像的名字和后缀名即可),如这里输入:imageStitching 1.jpg 2.jpg 3.jpg。

若输入:–output 4.jpg,就会把1.jpg、2.jpg和3.jpg 进行拼接,而输出的文件是imageStitching.exe路径下的4.jpg,由于在例程默认输出为result.jpg,可以不用设置output。

由于选取的图像在拍摄时并不平行,能拼接出这种效果的图像已是不错:

1.jpg:

2.jpg:

3.jpg:

拼接输出结果result.jpg:

代码中使用函数:`Stitcher::Status status = stitcher.stitch(imgs, pano);`就能得出一个傻瓜拼接结果…如之前所提到的,这其中涉及到很多算法的实现过程,可以看到图像拼接算法是一个值得深入的领域。更多的算法可参考:

[http://academy.nearsoft.com/project-updates/makingapanoramapicture](http://academy.nearsoft.com/project-updates/makingapanoramapicture)

OpenCV2学习笔记(十五)

最后更新于:2022-04-01 06:36:19

##利用Cmake快速查找OpenCV函数源码

在使用OpenCV时,在对一个函数的调用不是很了解的情况下,通常希望查到该函数的官方声明。而如果想进一步研究OpenCV的函数,则必须深入到源码。在VS中我们可以选中想要查看的OpenCV函数,点击右键-> 转到定义,我们可以很清楚地了解到函数的简单声明,但是并没有给出源代码。这是因为openCV将很多函数被加入了函数库,并被编译成了dll,所以只能看到函数申明,没法看到源代码。

第一个方法:在官网下载OpenCV后需要解压缩,完成后可以找到OpenCV的解压目录打开,在source/modules中存放着所有函数的源码,手动打开即可。相比之下,以下方法更为便捷。

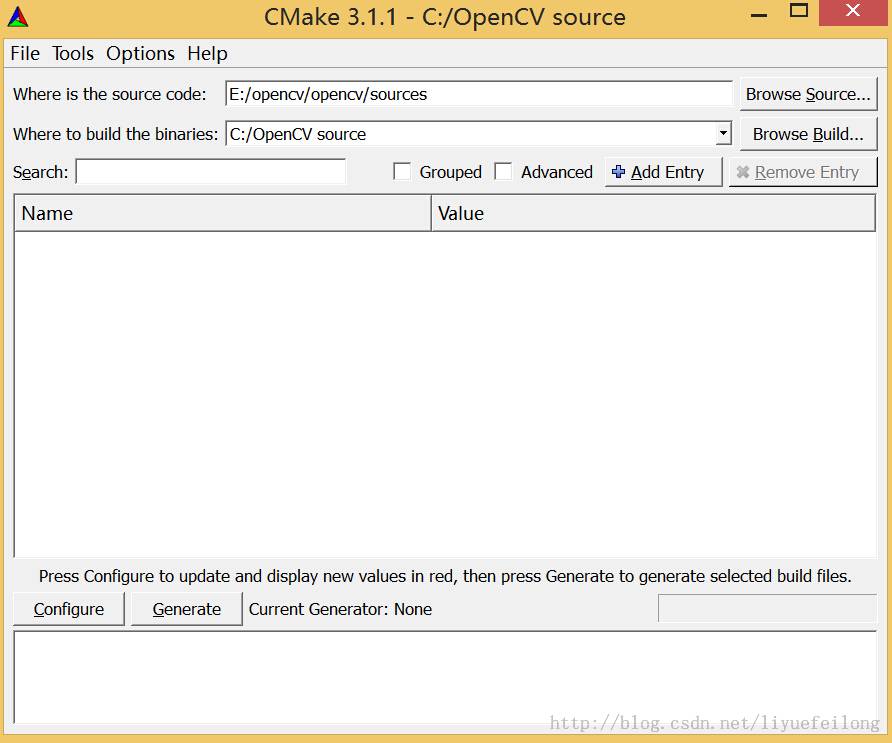

步骤一:我的OpenCV安装(解压)目录是E:/opencv/opencv。首先需要安装Cmake,可以到官网[http://www.cmake.org](http://www.cmake.org/)去下载并按默认设置安装安装即可。

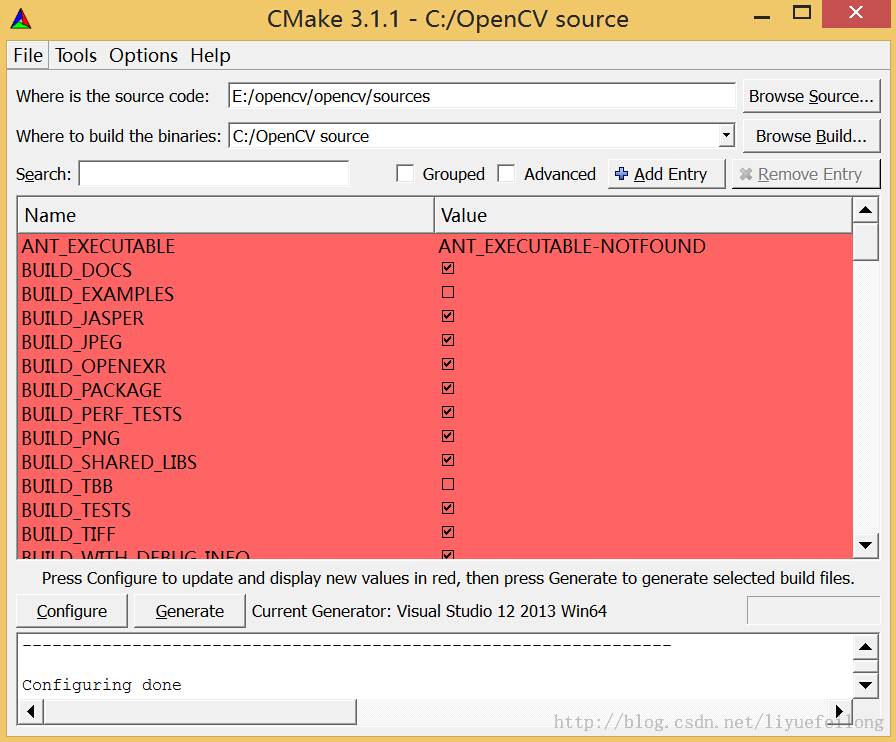

步骤二:打开Cmake,在第一行“Where is the source code”后面的那个“Browse Source...”按钮,选择OpenCV的安装路径。我的Opencv2.0安装路径为E:/opencv/opencv/,这里需要选择source文件夹,因此输入E:/opencv/opencv/source,同理点击第二行的“Browse Build...”按钮并选择生成的源码路径。这里放置在C:/OpenCV sources文件夹中,设定完成后点击左下方的configure。

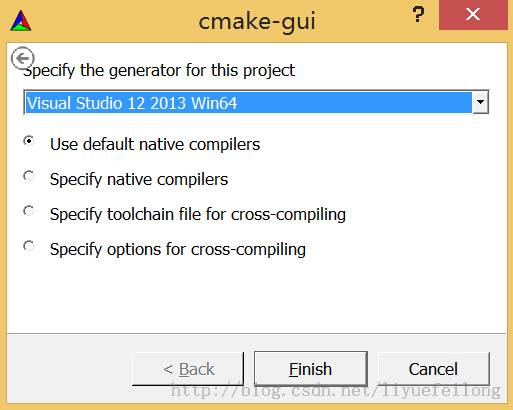

步骤三:在弹出的对话框中选择第一项,并在下拉框中选择编译平台,由于本人电脑上安装的是VS2013 64位版本,因此,就选择Visual Studio 12 2013 Win64,点击Finish。

步骤四:需要一段时间,完成时出现以下界面:

步骤五:再次点击Configure按钮,完成时红色部分消失,为以下状态:

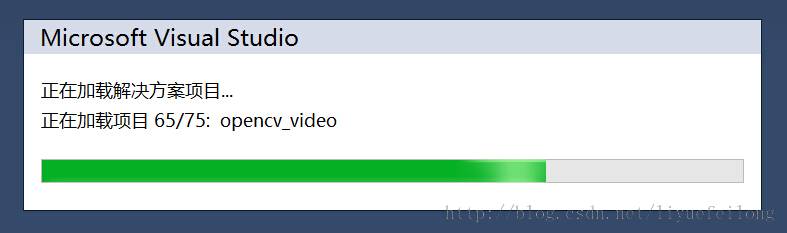

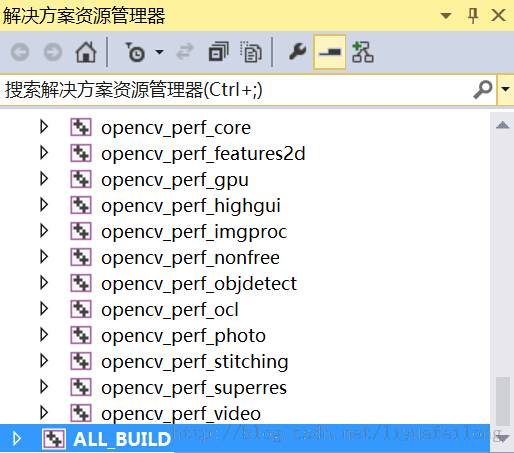

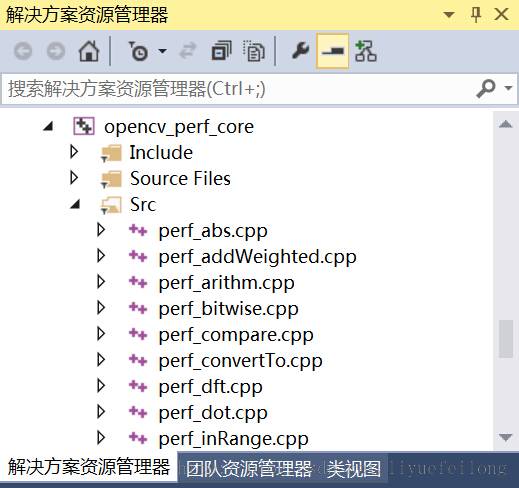

步骤六:点击“Generate”按钮,等到最下方信息显示框显示点击“Generate done”时所有步骤完成!至此,就生成了包含OpenCV函数源代码的Visual Studio工程文件;进入工程文件所在的路径C:/OpenCV source:

可以看到opencv.sln工程了,用VS打开它,可以搜索所有函数的源码。

相比第一种方法,显然这种查阅函数的方法更加便捷~

OpenCV2学习笔记(十四)

最后更新于:2022-04-01 06:36:17

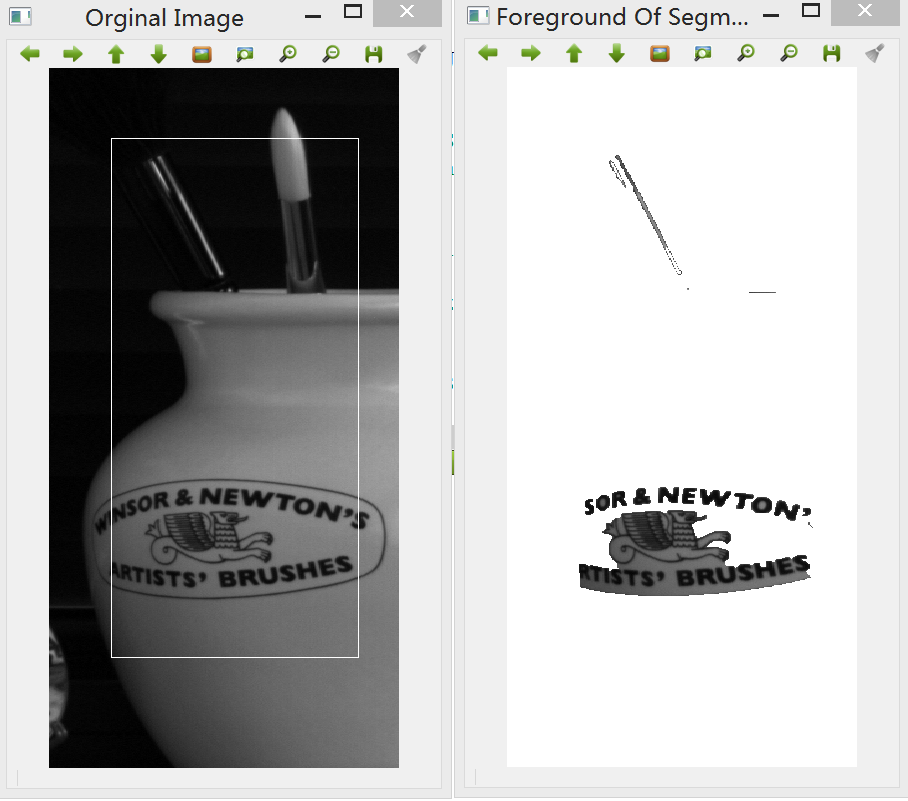

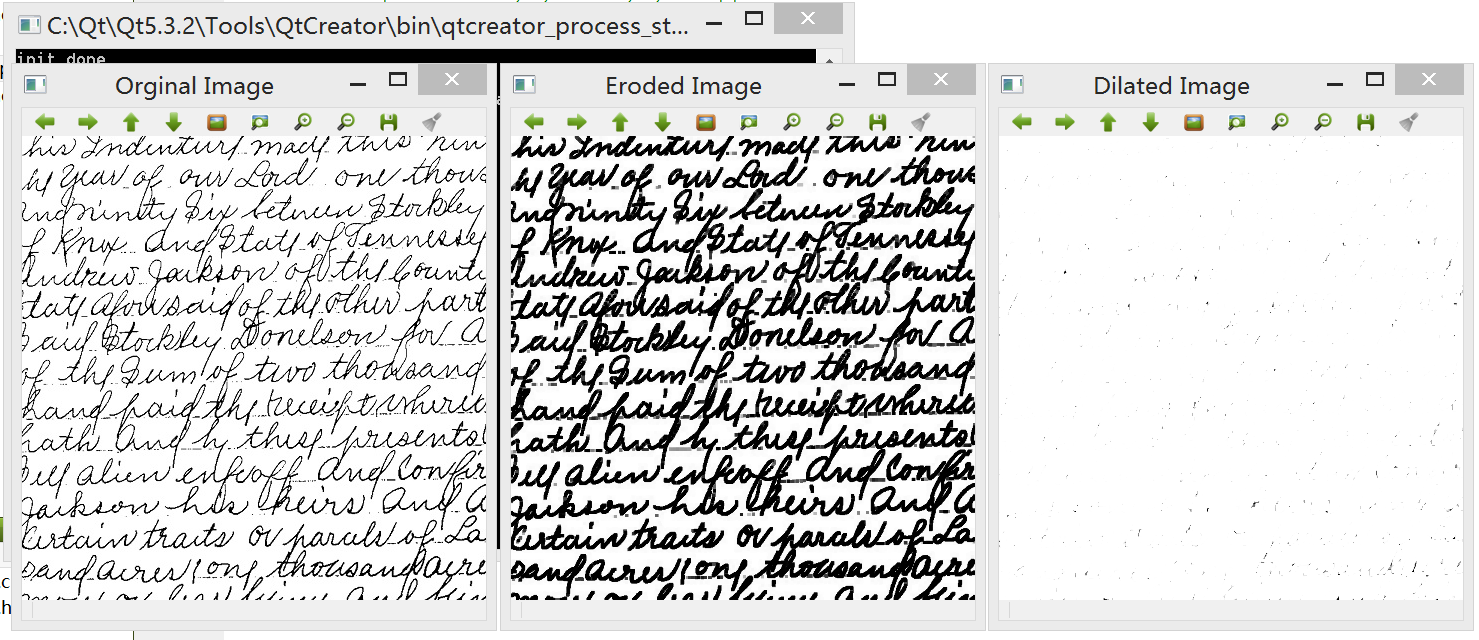

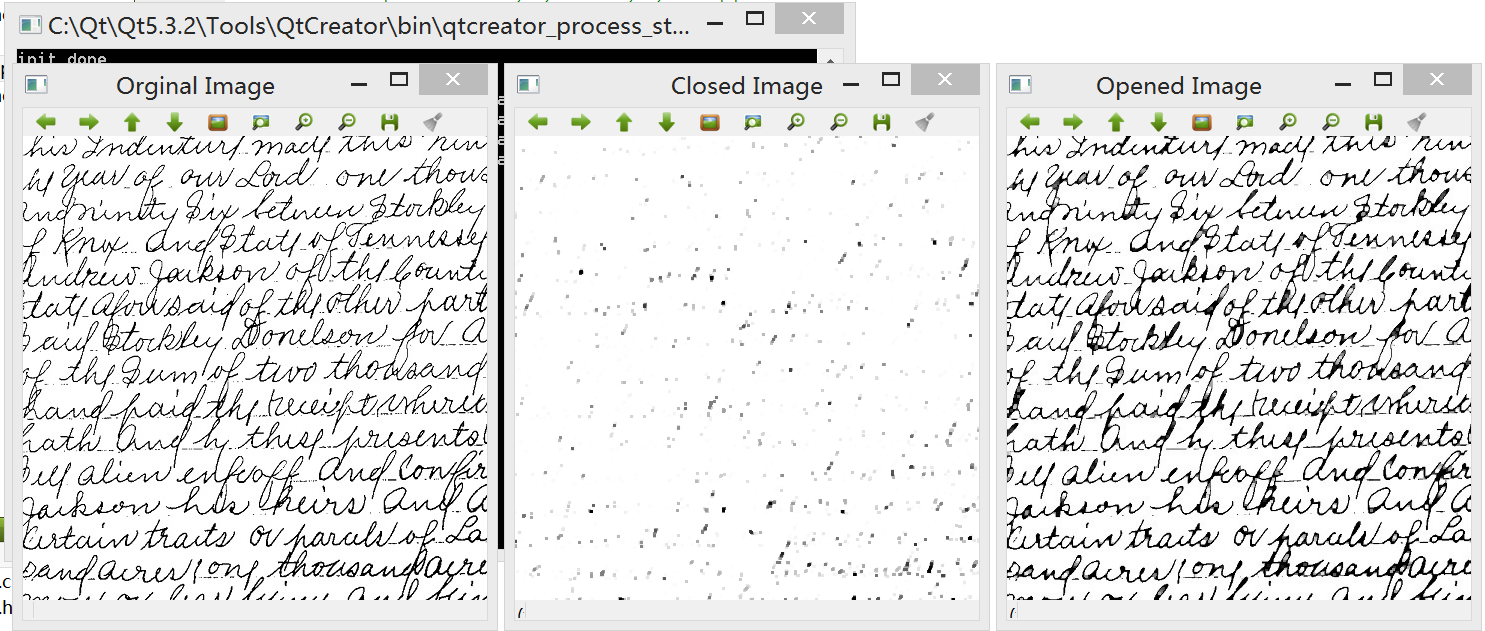

##基于OpenCV的图片卡通化处理

学习OpenCV已有一段时间,除了研究各种算法的内容,在空闲之余,根据书本及资料的引导,尝试结合图像处理算法和日常生活联系起来,首先在台式机上(带摄像头)完成一系列视频流处理功能,开发平台为Qt5.3.2+OpenCV2.4.9。

本次试验实现的功能主要有:

1. 调用摄像头捕获视频流;

2. 将帧图像转换为素描效果图片;

3. 将帧图像卡通化处理;

4. 简单地生成“怪物”形象;

5. 人脸肤色变换。

本节所有的算法均由类cartoon中的函数cartoonTransform()来实现:

~~~

// Frame:输入每一帧图像 output:输出图像

cartoonTransform(cv::Mat &Frame, cv::Mat &output)

~~~

后续将使用更多的OpenCV技巧实现更多功能,并将该应用移植到Android系统上。

一、使用OpenCV访问摄像头

OpenCV提供了一个简便易用的框架以提取视频文件和USB摄像头中的图像帧,如果你只是想读取某个视频,你只需要创建一个cv::VideoCapture实例,然后在循环中提取每一帧。这里需要访问摄像头,因此需要创建一个cv::VideoCapture对象,简单调用对象的open()方法。这里访问摄像头的函数如下,首先在Qt中创建控制台项目,在main函数中添加:

~~~

int cameraNumber = 0; // 设定摄像头编号为0

if(argc > 1)

cameraNumber = atoi(argv[1]);

// 开启摄像头

cv::VideoCapture camera;

camera.open(cameraNumber);

if(!camera.isOpened())

{

qDebug() << "Error: Could not open the camera.";

exit(1);

}

// 调整摄像头的输出分辨率

camera.set(CV_CAP_PROP_FRAME_WIDTH, 640);

camera.set(CV_CAP_PROP_FRAME_HEIGHT, 480);

~~~

在摄像头被初始化后,可以使用C++流运算符将cv::VideoCapture对象转换成cv::Mat对象,这样可以获取视频的每一帧图像。关于视频流读取可参考:[http://blog.csdn.net/liyuefeilong/article/details/44066097](http://blog.csdn.net/liyuefeilong/article/details/44066097)

二、将帧图像转换为素描效果图片

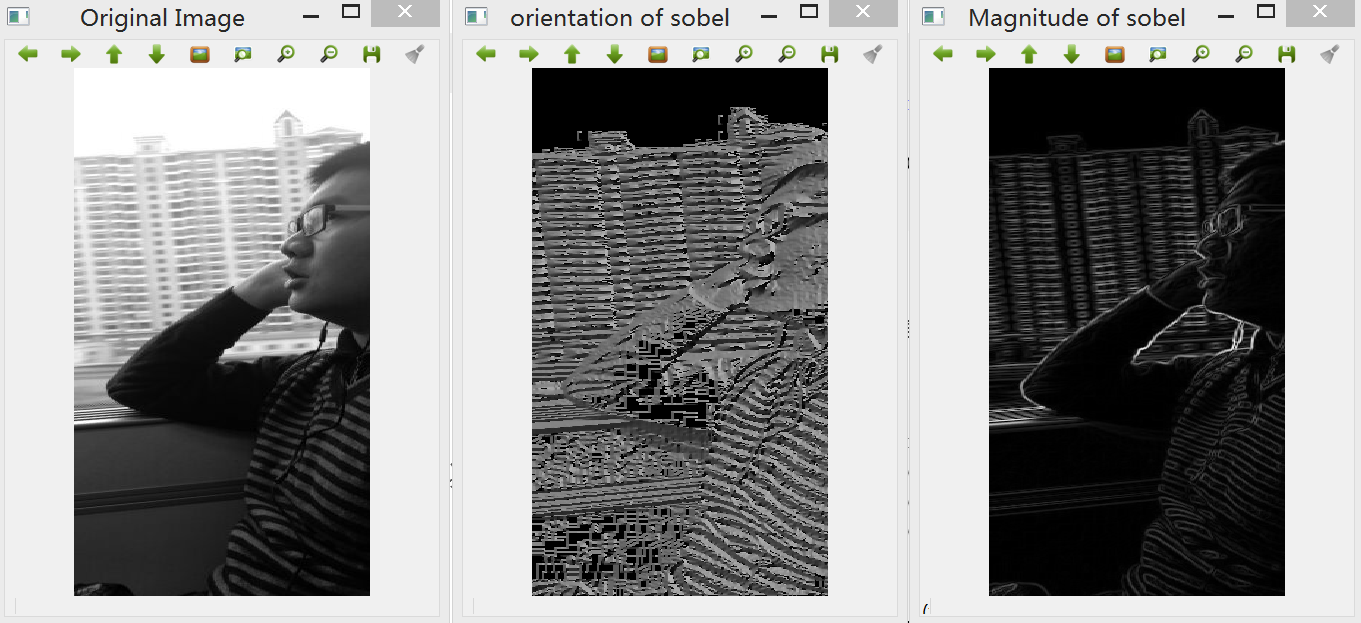

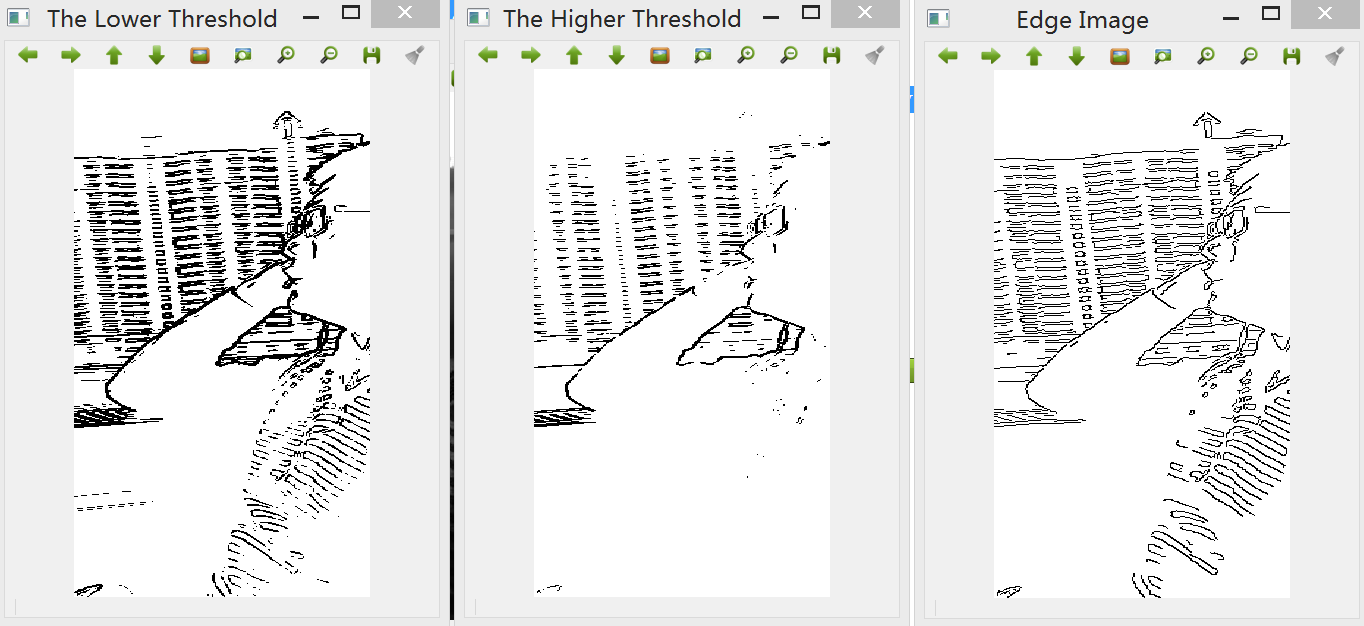

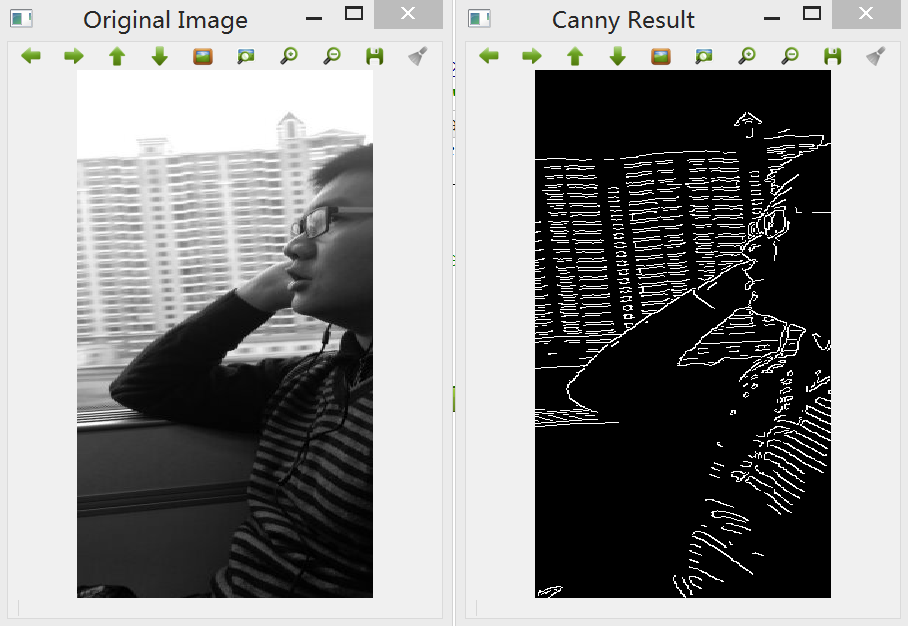

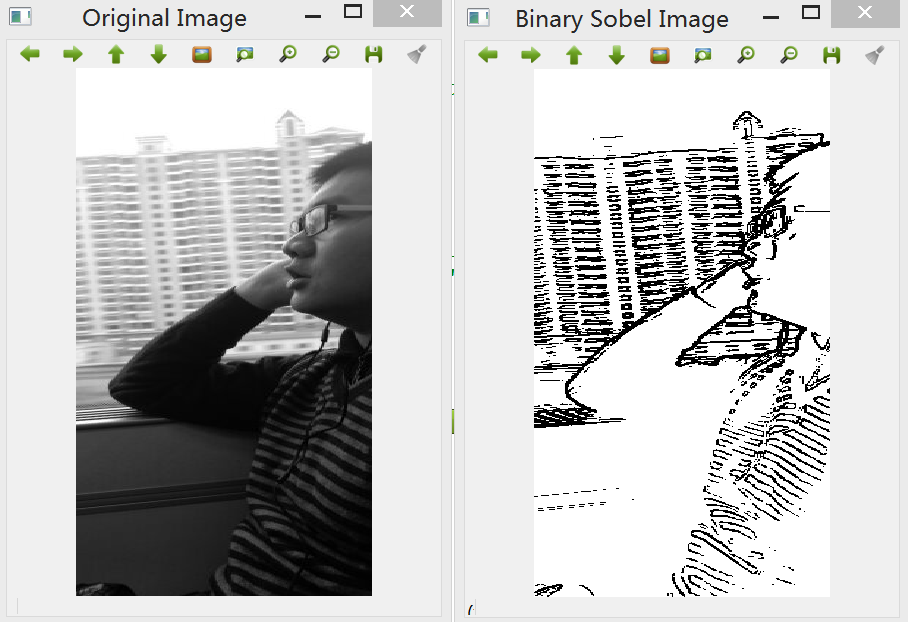

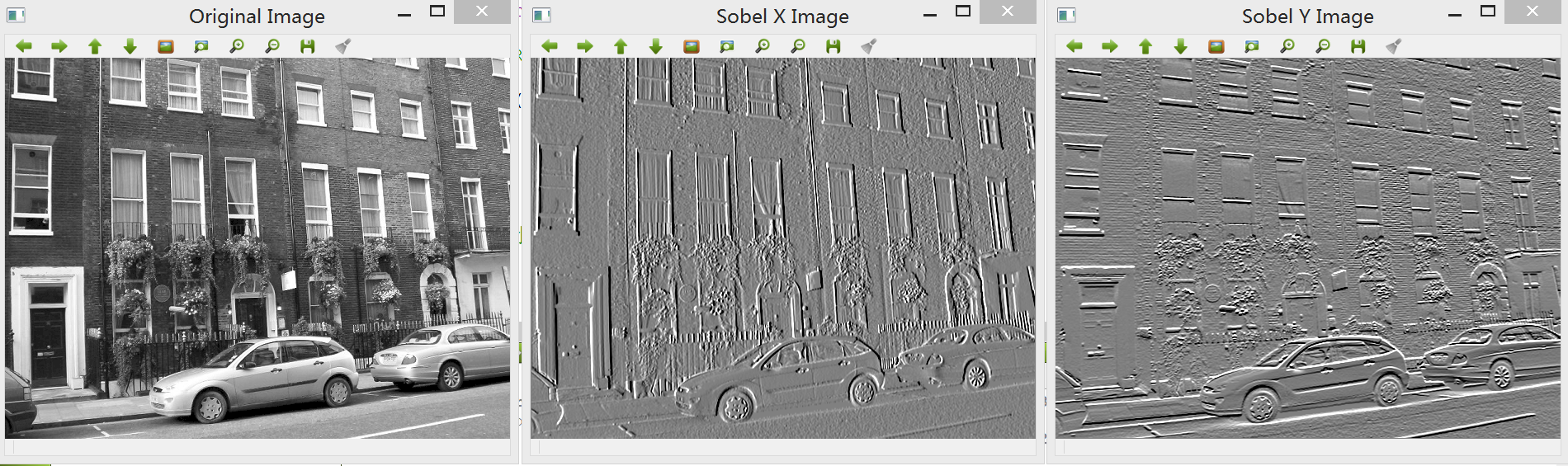

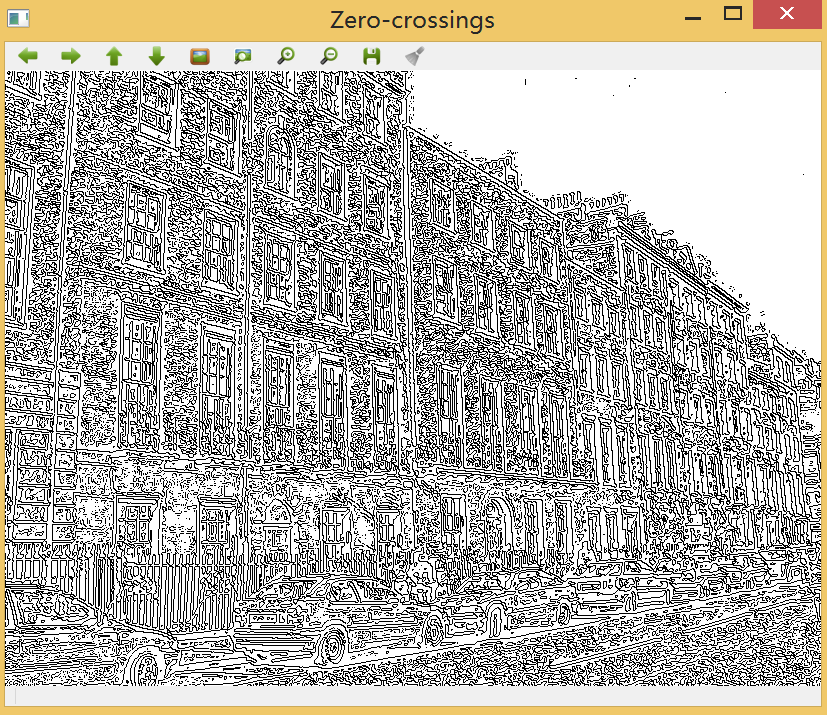

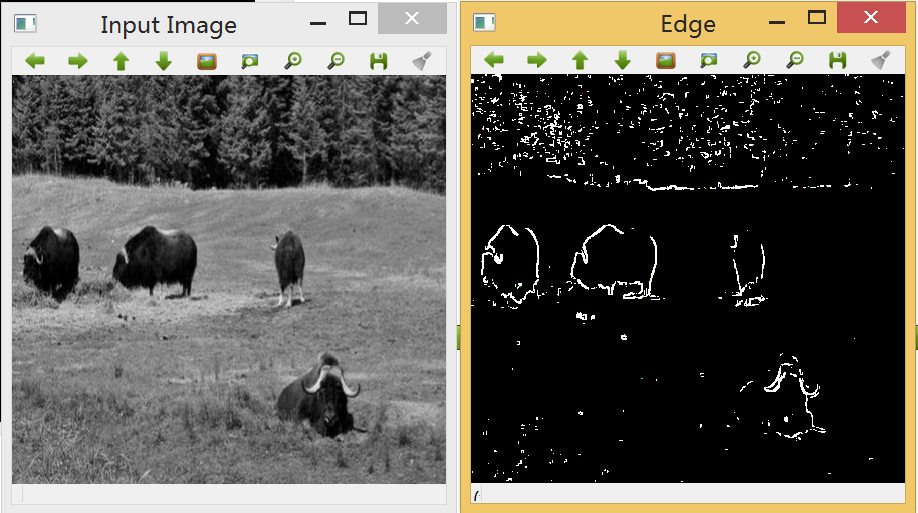

要将一幅图像转换为素描效果图,可以使用不同的边缘检测算法实现,如常用的基于Sobel、Canny、Robert、Prewitt、Laplacian等算子的滤波器均可以实现这一操作,但处理效果各异。

1.Sobel算子:边缘检测中最常用的一种方法,在技术上它是以离散型的差分算子,用来运算图像亮度函数的梯度的近似值,缺点是Sobel算子并没有将图像的主题与背景严格地区分开来,换言之就是Sobel算子并没有基于图像灰度进行处理,由于Sobel算子并没有严格地模拟人的视觉生理特征,所以提取的图像轮廓有时并不能令人满意。

2.Robert算子:根据任一相互垂直方向上的差分都用来估计梯度,Robert算子采用对角方向相邻像素之差。

3.Prewitt算子:该算子与Sobel算子类似,只是权值有所变化,但两者实现起来功能还是有差距的,据经验得知Sobel要比Prewitt更能准确检测图像边缘。

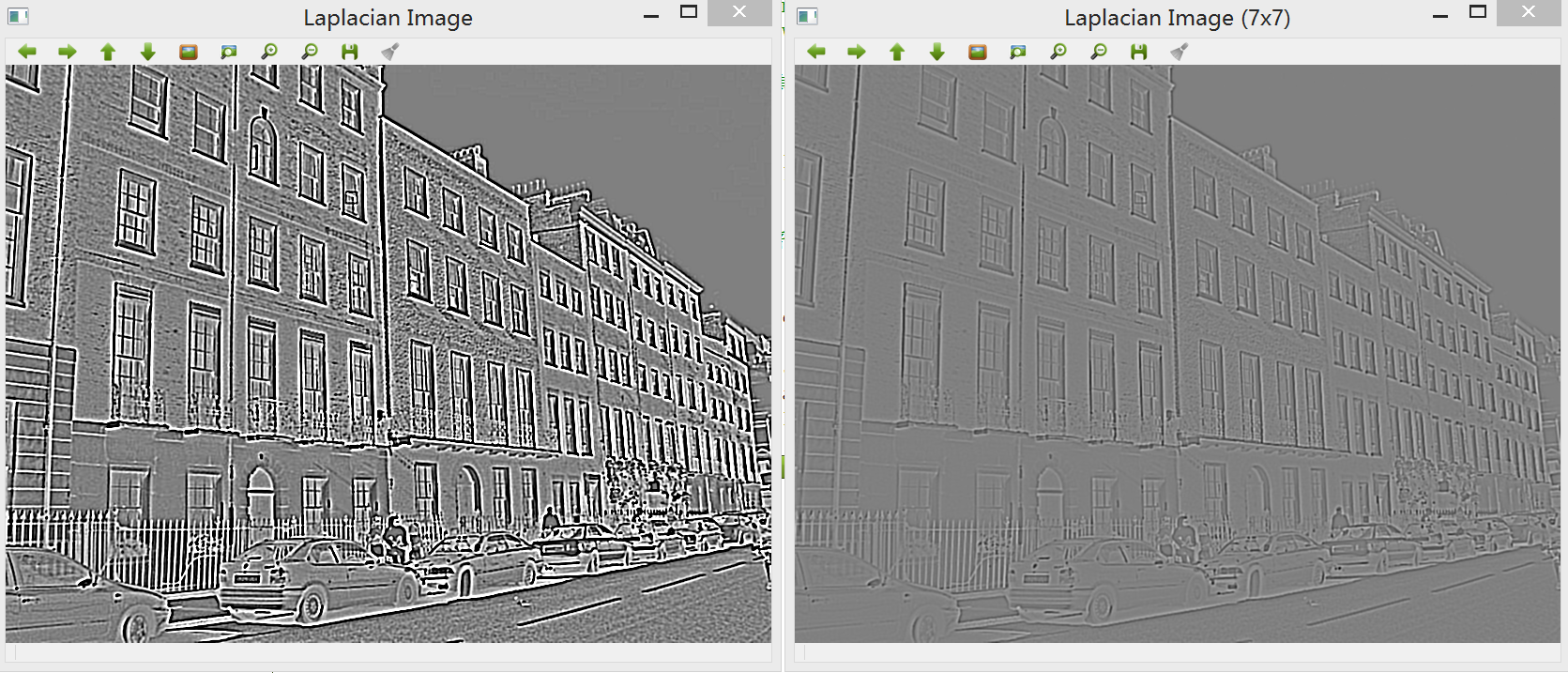

4.Laplacian算子:该算子是一种二阶微分算子,若只考虑边缘点的位置而不考虑周围的灰度差时可用该算子进行检测。对于阶跃状边缘,其二阶导数在边缘点出现零交叉,并且边缘点两旁的像素的二阶导数异号。

5.Canny算子:该算子的基本性能比前面几种要好,但是相对来说算法复杂。Canny算子是一个具有滤波,增强,检测的多阶段的优化算子,在进行处理前,Canny算子先利用高斯平滑滤波器来平滑图像以除去噪声,Canny分割算法采用一阶偏导的有限差分来计算梯度幅值和方向,在处理过程中,Canny算子还将经过一个非极大值抑制的过程,最后Canny算子还采用两个阈值来连接边缘。

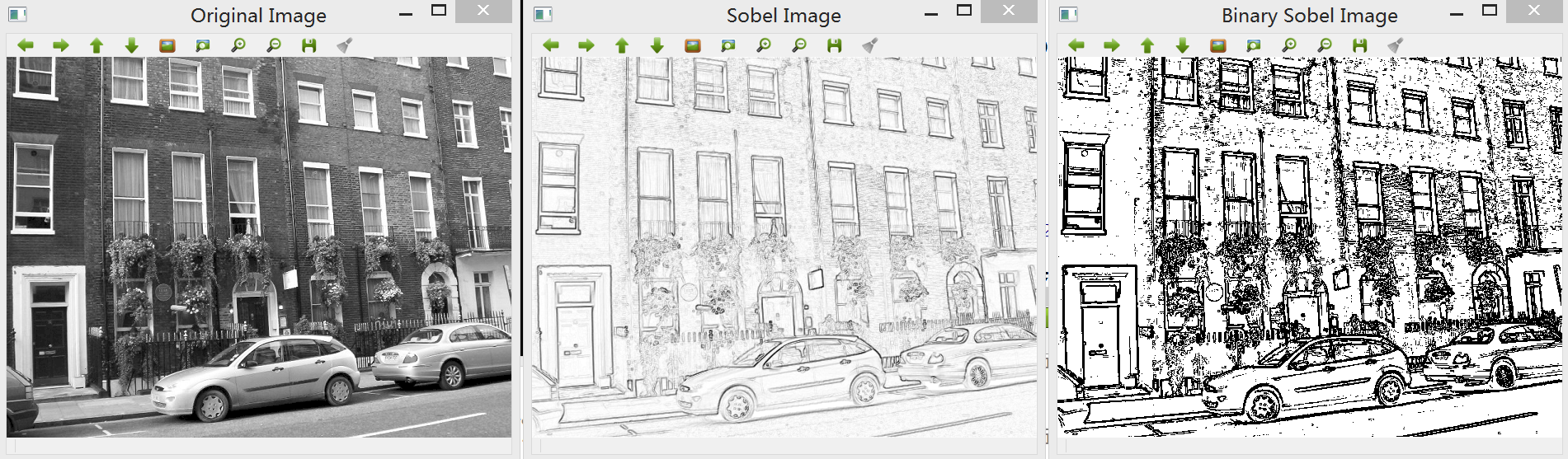

相比Sobel等其他算子,Canny和Laplacian算子能得到更清晰的素描效果,而Laplacian的噪声抑制要优于Canny边缘检测,而事实上素描边缘在不同帧之间经常有剧烈的变化,因此我们选择Laplacian边缘滤波器进行图像处理。

一般在进行Laplacian检测之前,需要对图像进行的预操作有:

1. Laplacian算法只能作用于灰度图像,因此需要将彩色帧图像进行转换;

2. 平滑处理,这是因为图像的平滑处理减少了噪声的影响并且一定成都市抵消了由Laplacian算子的二阶导数引起的噪声影响。因此可使用中值滤波器来去噪。

~~~

void cartoon::cartoonTransform(cv::Mat &Frame, cv::Mat &output)

{

cv::Mat grayImage;

cv::cvtColor(Frame, grayImage, CV_BGR2GRAY);

// 设置中值滤波器参数

cv::medianBlur(grayImage, grayImage, 7);

// Laplacian边缘检测

cv::Mat edge; // 用于存放边缘检测输出结果

cv::Laplacian(grayImage, edge, CV_8U, 5);

// 对边缘检测结果进行二值化

cv::Mat Binaryzation; // 用于存放二值化输出结果

cv::threshold(edge, Binaryzation, 80, 255, cv::THRESH_BINARY_INV);

}

~~~

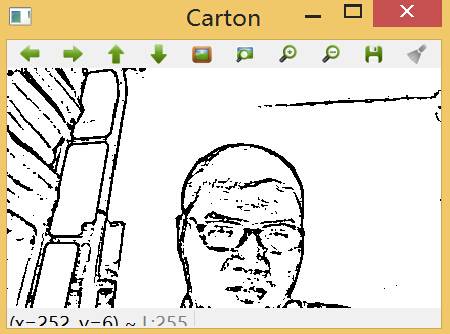

生成的素描效果:

三、将图像卡通化

在项目中调用一些运算量大的算法时,通常需要考虑到效率问题,比如这里将要用到的双边滤波器。这里我们利用双边滤波器的平滑区域及保持边缘锐化的特性,将其运用到卡通图片效果生成中。而考虑到双边滤波器运行效率较低,因此考虑在更低的分辨率中使用,这对效果影响不大,但是运行速度大大加快。

这里使用的策略是将要处理的图像的宽度和高度缩小为原来的1/2,经过双边滤波器处理后,再将其恢复为原来的尺寸。在函数cartoonTransform()中添加以下代码:

~~~

// 采用双边滤波器

// 由于算法复杂,因此需减少图像尺寸

cv::Size size = Frame.size();

cv::Size reduceSize;

reduceSize.width = size.width / 2;

reduceSize.height = size.height / 2;

cv::Mat reduceImage = cv::Mat(reduceSize, CV_8UC3);

cv::resize(Frame, reduceImage, reduceSize);

// 双边滤波器实现过程

cv::Mat tmp = cv::Mat(reduceSize, CV_8UC3);

int repetitions = 7;

for (int i=0 ; i < repetitions; i++)

{

int kernelSize = 9;

double sigmaColor = 9;

double sigmaSpace = 7;

cv::bilateralFilter(reduceImage, tmp, kernelSize, sigmaColor, sigmaSpace);

cv::bilateralFilter(tmp, reduceImage, kernelSize, sigmaColor, sigmaSpace);

}

// 由于图像是缩小后的图像,需要恢复

cv::Mat magnifyImage;

cv::resize(reduceImage, magnifyImage, size);

~~~

为了得到更好的效果,在以上代码中添加以下函数,将恢复尺寸后的图像与上一部分的素描结果相叠加,得到卡通版的图像~~

~~~

cv::Mat dst;

dst.setTo(0);

magnifyImage.copyTo(dst, Binaryzation);

//output = dst; //输出

~~~

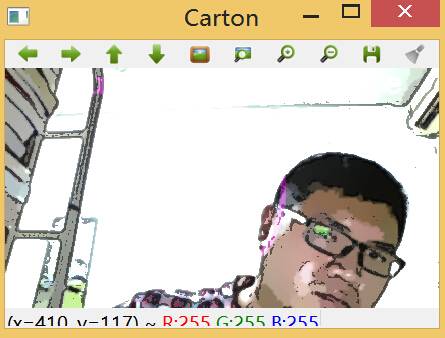

卡通效果,阈值各方面有待优化:

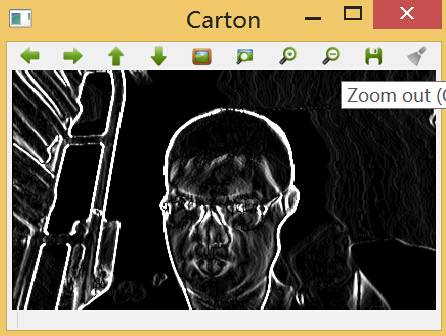

四、简单地生成“怪物”形象

这里是结合了边缘滤波器和中值滤波器的另一个小应用,即通过小的边缘滤波器找到图像中的各处边缘,之后使用中值滤波器来合并这些边缘。具体实现步骤如下:

1. 这里同样需要原图像的灰度图,因此格式转换依然是必要的;

2. 分别沿着x和y方向采用3*3的Scharr梯度滤波器(效果图);

3. 使用截断值很低的阈值进行二值化处理;

4. 最后使用3*3的中值平滑滤波得到“怪物”掩码。

详细代码如下,同样在函数cartoonTransform()中添加:

~~~

// 怪物模式

cv::Mat gray ,maskMonster;

cv::cvtColor(Frame, gray, CV_BGR2GRAY);

// 先对输入帧进行中值滤波

cv::medianBlur(gray, gray, 7);

// Scharr滤波器

cv::Mat edge1, edge2;

cv::Scharr(gray, edge1, CV_8U, 1, 0);

cv::Scharr(gray, edge2, CV_8U, 1, 0, -1);

edge1 += edge2; // 合并x和y方向的边缘

cv::threshold(edge1, maskMonster, 12, 255, cv::THRESH_BINARY_INV);

cv::medianBlur(maskMonster, maskMonster, 3);

output = maskMonster; //输出

~~~

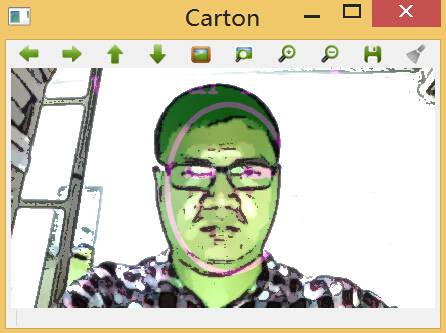

五、人脸肤色变换

皮肤检测算法有很多种,比如基于RGB color space、Ycrcb之cr分量+otsu阈值化、基于混合模型的复杂机器学习算法等。由于这里只是一个轻量级的应用,因此不考虑使用太复杂的算法。考虑到未来要将这些图像处理算法移植到安卓上,而移动设备上的微型摄像头传感器对颜色的反应往往差异很大,而且要在没有标定的情况下对不同肤色的人进行皮肤检测,因此对算法的鲁棒性要求较高。

这里使用了一个技巧,即在图像中规定一个区域,用户需要将脸部放到指定区域中来确定人脸在图像中的位置(事实上有些手机应用也会采取这种方法),对于移动设备来说这不是一件难事。

因此,我们需要规定人脸的区域,同样在函数cartoonTransform()中添加以下代码:

~~~

// 怪物模式

cv::Mat gray ,maskMonster;

cv::cvtColor(Frame, gray, CV_BGR2GRAY);

// 先对输入帧进行中值滤波

cv::medianBlur(gray, gray, 7);

// Scharr滤波器

cv::Mat edge1, edge2;

cv::Scharr(gray, edge1, CV_8U, 1, 0);

cv::Scharr(gray, edge2, CV_8U, 1, 0, -1);

edge1 += edge2; // 合并x和y方向的边缘

cv::threshold(edge1, maskMonster, 12, 255, cv::THRESH_BINARY_INV);

cv::medianBlur(maskMonster, maskMonster, 3);

output = maskMonster; //输出

// 换肤模式

// 绘制脸部区域

cv::Mat faceFrame = cv::Mat::zeros(size, CV_8UC3);

cv::Scalar color = CV_RGB(128, 0, 128); // 颜色

int thickness = 4;

// 使之占整个图像高度的70%

int width = size.width;

int height = size.height;

int faceHeight = height/2 * 70/100;

int faceWidth = faceHeight * 72/100;

cv::ellipse(faceFrame, cv::Point(width/2, height/2), cv::Size(faceWidth, faceHeight),

0, 0, 360, color, thickness, CV_AA);

// imshow("test3", faceFrame);

// 绘制眼睛区域

int eyeHeight = faceHeight * 11/100;

int eyeWidth = faceWidth * 23/100;

int eyeY = faceHeight * 13/100;

int eyeX = faceWidth * 48/100;

cv::Size eyeSize = cv::Size(eyeWidth, eyeHeight);

int eyeAngle = 15; //角度

int eyeYShift = 11;

// 画右眼的上眼皮

cv::ellipse(faceFrame, cv::Point(width/2 - eyeX, height/2 - eyeY),

eyeSize, 0, 180+eyeAngle, 360-eyeAngle, color, thickness, CV_AA);

// 画右眼的下眼皮

cv::ellipse(faceFrame, cv::Point(width/2 - eyeX, height/2 - eyeY - eyeYShift),

eyeSize, 0, 0+eyeAngle, 180-eyeAngle, color, thickness, CV_AA);

// 画左眼的上眼皮

cv::ellipse(faceFrame, cv::Point(width/2 + eyeX, height/2 - eyeY),

eyeSize, 0, 180+eyeAngle, 360-eyeAngle, color, thickness, CV_AA);

// 画左眼的下眼皮

cv::ellipse(faceFrame, cv::Point(width/2 + eyeX, height/2 - eyeY - eyeYShift),

eyeSize, 0, 0+eyeAngle, 180-eyeAngle, color, thickness, CV_AA);

char *Message = "Put your face here";

cv::putText(faceFrame, Message, cv::Point(width * 13/100, height * 10/100),

cv::FONT_HERSHEY_COMPLEX,

1.0f,

color,

2,

CV_AA);

cv::addWeighted(dst, 1.0, faceFrame, 0.7, 0, dst, CV_8UC3);

//output = dst;

~~~

效果:

皮肤变色器的实现基于OpenCV的floodFill()函数,该函数类似于一些绘图软件中的**颜料桶(颜色填充)工具**。 由于规定屏幕中间椭圆区域就是皮肤像素,因此只需要对该区域的像素进行各种颜色的漫水填充即可。

这里处理的图像是彩色图,而对于RGB格式的图像,改变颜色的效果不会太好,因为改变颜色需要脸部图像的亮度变化,而皮肤颜色也不能变化太大。这里使用YCrCb颜色空间来进行处理。在YCrCb颜色空间中,可以直接获得亮度值,而且通常的皮肤颜色取值唯一。

~~~

// 皮肤变色器

cv::Mat YUVImage = cv::Mat(reduceSize, CV_8UC3);

cv::cvtColor(reduceImage, YUVImage, CV_BGR2YCrCb);

int sw = reduceSize.width;

int sh = reduceSize.height;

cv::Mat mask, maskPlusBorder;

maskPlusBorder = cv::Mat::zeros(sh+2, sw+2, CV_8UC1);

mask = maskPlusBorder(cv::Rect(1, 1, sw, sh));

cv::resize(edge, mask, reduceSize);

const int EDGES_THRESHOLD = 80;

cv::threshold(mask, mask, EDGES_THRESHOLD, 255, cv::THRESH_BINARY);

cv::dilate(mask, mask, cv::Mat());

cv::erode(mask, mask, cv::Mat());

// output = mask;

// 创建6个点进行漫水填充算法

cv::Point skinPoint[6];

skinPoint[0] = cv::Point(sw/2, sh/2 - sh/6);

skinPoint[1] = cv::Point(sw/2 - sw/11, sh/2 - sh/6);

skinPoint[2] = cv::Point(sw/2 + sw/11, sh/2 - sh/6);

skinPoint[3] = cv::Point(sw/2, sh/2 + sh/6);

skinPoint[4] = cv::Point(sw/2 - sw/9, sh/2 + sh/6);

skinPoint[5] = cv::Point(sw/2 + sw/9, sh/2 + sh/6);

// 设定漫水填充算法的上下限

const int MIN_Y = 60;

const int MAX_Y = 80;

const int MIN_Cr = 25;

const int MAX_Cr = 15;

const int MIN_Cb = 20;

const int MAX_Cb = 15;

cv::Scalar Min = cv::Scalar(MIN_Y, MIN_Cr, MIN_Cb);

cv::Scalar Max = cv::Scalar(MAX_Y, MAX_Cr, MAX_Cb);

// 调用漫水填充算法

const int CONNECTED_COMPONENTS = 4;

const int flag = CONNECTED_COMPONENTS | cv::FLOODFILL_FIXED_RANGE \

| cv::FLOODFILL_MASK_ONLY;

cv::Mat edgeMask = mask.clone();

//

for(int i = 0; i < 6; i++)

{

cv::floodFill(YUVImage, maskPlusBorder, skinPoint[i], cv::Scalar(), NULL,

Min, Max, flag);

}

cv::Mat BGRImage;

cv::cvtColor(YUVImage, BGRImage, CV_YCrCb2BGR);

mask -= edgeMask;

int Red = 0;

int Green = 70;

int Blue = 0;

cv::Scalar color2 = CV_RGB(Red, Green, Blue); // 颜色

cv::add(BGRImage, color2, BGRImage, mask);

cv::Mat tt;

cv::resize(BGRImage, tt, size);

cv::add(dst, tt ,dst);

output = dst; // 换肤结果

~~~

由于在脸部区域中要对许多像素使用漫水填充算法,因此为了保证人脸图像的各种颜色和阴影都能得到处理,这里设置了前额、鼻子和脸颊6个点,他们的定位依赖于先前规定的脸部轮廓坐标。输出效果如下:

脸部不在识别区域内时:

脸部进入识别区域内时:

以上实现了几种图片卡通化效果,接着在学有余力时要对各种算法的效果进行优化,同时加入GUI界面,并将应用移植到移动设备上。

参考资料:《深入理解OpenCV:实用计算机视觉项目解析》

完整代码:

cartoon.h:

~~~

#ifndef CARTOON_H

#define CARTOON_H

#include <opencv2/core/core.hpp>

#include <opencv2/imgproc/imgproc.hpp>

#include <opencv2/highgui/highgui.hpp>

class cartoon

{

public:

void cartoonTransform(cv::Mat &Frame, cv::Mat &output);

};

#endif // CARTOON_H

~~~

cartoon.cpp:

~~~

#include "cartoon.h"

void cartoon::cartoonTransform(cv::Mat &Frame, cv::Mat &output)

{

cv::Mat grayImage;

cv::cvtColor(Frame, grayImage, CV_BGR2GRAY);

// 设置中值滤波器参数

cv::medianBlur(grayImage, grayImage, 7);

// Laplacian边缘检测

cv::Mat edge; // 用于存放边缘检测输出结果

cv::Laplacian(grayImage, edge, CV_8U, 5);

// 对边缘检测结果进行二值化

cv::Mat Binaryzation; // 用于存放二值化输出结果

cv::threshold(edge, Binaryzation, 80, 255, cv::THRESH_BINARY_INV);

// 以下操作生成彩色图像和卡通效果

// 采用双边滤波器

// 由于算法复杂,因此需减少图像尺寸

cv::Size size = Frame.size();

cv::Size reduceSize;

reduceSize.width = size.width / 2;

reduceSize.height = size.height / 2;

cv::Mat reduceImage = cv::Mat(reduceSize, CV_8UC3);

cv::resize(Frame, reduceImage, reduceSize);

// 双边滤波器实现过程

cv::Mat tmp = cv::Mat(reduceSize, CV_8UC3);

int repetitions = 7;

for (int i=0 ; i < repetitions; i++)

{

int kernelSize = 9;

double sigmaColor = 9;

double sigmaSpace = 7;

cv::bilateralFilter(reduceImage, tmp, kernelSize, sigmaColor, sigmaSpace);

cv::bilateralFilter(tmp, reduceImage, kernelSize, sigmaColor, sigmaSpace);

}

// 由于图像是缩小后的图像,需要恢复

cv::Mat magnifyImage;

cv::resize(reduceImage, magnifyImage, size);

cv::Mat dst;

dst.setTo(0);

magnifyImage.copyTo(dst, Binaryzation);

//output = dst; //输出

// 怪物模式

cv::Mat gray ,maskMonster;

cv::cvtColor(Frame, gray, CV_BGR2GRAY);

// 先对输入帧进行中值滤波

cv::medianBlur(gray, gray, 7);

// Scharr滤波器

cv::Mat edge1, edge2;

cv::Scharr(gray, edge1, CV_8U, 1, 0);

cv::Scharr(gray, edge2, CV_8U, 1, 0, -1);

edge1 += edge2; // 合并x和y方向的边缘

cv::threshold(edge1, maskMonster, 12, 255, cv::THRESH_BINARY_INV);

cv::medianBlur(maskMonster, maskMonster, 3);

output = maskMonster; //输出

// 换肤模式

// 绘制脸部区域

cv::Mat faceFrame = cv::Mat::zeros(size, CV_8UC3);

cv::Scalar color = CV_RGB(128, 0, 128); // 颜色

int thickness = 4;

// 使之占整个图像高度的70%

int width = size.width;

int height = size.height;

int faceHeight = height/2 * 70/100;

int faceWidth = faceHeight * 72/100;

cv::ellipse(faceFrame, cv::Point(width/2, height/2), cv::Size(faceWidth, faceHeight),

0, 0, 360, color, thickness, CV_AA);

// imshow("test3", faceFrame);

// 绘制眼睛区域

int eyeHeight = faceHeight * 11/100;

int eyeWidth = faceWidth * 23/100;

int eyeY = faceHeight * 13/100;

int eyeX = faceWidth * 48/100;

cv::Size eyeSize = cv::Size(eyeWidth, eyeHeight);

int eyeAngle = 15; //角度

int eyeYShift = 11;

// 画右眼的上眼皮

cv::ellipse(faceFrame, cv::Point(width/2 - eyeX, height/2 - eyeY),

eyeSize, 0, 180+eyeAngle, 360-eyeAngle, color, thickness, CV_AA);

// 画右眼的下眼皮

cv::ellipse(faceFrame, cv::Point(width/2 - eyeX, height/2 - eyeY - eyeYShift),

eyeSize, 0, 0+eyeAngle, 180-eyeAngle, color, thickness, CV_AA);

// 画左眼的上眼皮

cv::ellipse(faceFrame, cv::Point(width/2 + eyeX, height/2 - eyeY),

eyeSize, 0, 180+eyeAngle, 360-eyeAngle, color, thickness, CV_AA);

// 画左眼的下眼皮

cv::ellipse(faceFrame, cv::Point(width/2 + eyeX, height/2 - eyeY - eyeYShift),

eyeSize, 0, 0+eyeAngle, 180-eyeAngle, color, thickness, CV_AA);

char *Message = "Put your face here";

cv::putText(faceFrame, Message, cv::Point(width * 13/100, height * 10/100),

cv::FONT_HERSHEY_COMPLEX,

1.0f,

color,

2,

CV_AA);

cv::addWeighted(dst, 1.0, faceFrame, 0.7, 0, dst, CV_8UC3);

//output = dst;

// 皮肤变色器

cv::Mat YUVImage = cv::Mat(reduceSize, CV_8UC3);

cv::cvtColor(reduceImage, YUVImage, CV_BGR2YCrCb);

int sw = reduceSize.width;

int sh = reduceSize.height;

cv::Mat mask, maskPlusBorder;

maskPlusBorder = cv::Mat::zeros(sh+2, sw+2, CV_8UC1);

mask = maskPlusBorder(cv::Rect(1, 1, sw, sh));

cv::resize(edge, mask, reduceSize);

const int EDGES_THRESHOLD = 80;

cv::threshold(mask, mask, EDGES_THRESHOLD, 255, cv::THRESH_BINARY);

cv::dilate(mask, mask, cv::Mat());

cv::erode(mask, mask, cv::Mat());

// output = mask;

// 创建6个点进行漫水填充算法

cv::Point skinPoint[6];

skinPoint[0] = cv::Point(sw/2, sh/2 - sh/6);

skinPoint[1] = cv::Point(sw/2 - sw/11, sh/2 - sh/6);

skinPoint[2] = cv::Point(sw/2 + sw/11, sh/2 - sh/6);

skinPoint[3] = cv::Point(sw/2, sh/2 + sh/6);

skinPoint[4] = cv::Point(sw/2 - sw/9, sh/2 + sh/6);

skinPoint[5] = cv::Point(sw/2 + sw/9, sh/2 + sh/6);

// 设定漫水填充算法的上下限

const int MIN_Y = 60;

const int MAX_Y = 80;

const int MIN_Cr = 25;

const int MAX_Cr = 15;

const int MIN_Cb = 20;

const int MAX_Cb = 15;

cv::Scalar Min = cv::Scalar(MIN_Y, MIN_Cr, MIN_Cb);

cv::Scalar Max = cv::Scalar(MAX_Y, MAX_Cr, MAX_Cb);

// 调用漫水填充算法

const int CONNECTED_COMPONENTS = 4;

const int flag = CONNECTED_COMPONENTS | cv::FLOODFILL_FIXED_RANGE \

| cv::FLOODFILL_MASK_ONLY;

cv::Mat edgeMask = mask.clone();

//

for(int i = 0; i < 6; i++)

{

cv::floodFill(YUVImage, maskPlusBorder, skinPoint[i], cv::Scalar(), NULL,

Min, Max, flag);

}

cv::Mat BGRImage;

cv::cvtColor(YUVImage, BGRImage, CV_YCrCb2BGR);

mask -= edgeMask;

int Red = 0;

int Green = 70;

int Blue = 0;

cv::Scalar color2 = CV_RGB(Red, Green, Blue); // 颜色

cv::add(BGRImage, color2, BGRImage, mask);

cv::Mat tt;

cv::resize(BGRImage, tt, size);

cv::add(dst, tt ,dst);

output = dst; // 换肤结果

}

~~~

main函数:

~~~

#include "cartoon.h"

#include <QApplication>

#include <QDebug>

#include <opencv2/video/video.hpp>

int main(int argc, char *argv[])

{

QApplication a(argc, argv);

cartoon photo;

int cameraNumber = 0;

if(argc > 1)

cameraNumber = atoi(argv[1]);

// 开启摄像头

cv::VideoCapture camera;

camera.open(cameraNumber);

if(!camera.isOpened())

{

qDebug() << "Error: Could not open the camera.";

exit(1);

}

// 调整摄像头的分辨率

camera.set(CV_CAP_PROP_FRAME_WIDTH, 640);

camera.set(CV_CAP_PROP_FRAME_HEIGHT, 480);

while (1)

{

cv::Mat Frame;

camera >> Frame;

if(!Frame.data)

{

qDebug() << "Couldn't capture camera frame.";

exit(1);

}

// 创建一个用于存放输出图像的数据结构

cv::Mat output(Frame.size(), CV_8UC3);

photo.cartoonTransform(Frame, output);

// 使用图像处理技术将获取的帧经过处理后输入到output中

cv::imshow("Original", Frame);

cv::imshow("Carton", output);

char keypress = cv::waitKey(20);

if(keypress == 27)

{

break;

}

}

return a.exec();

}

~~~

OpenCV2学习笔记(十三)

最后更新于:2022-04-01 06:36:15

##基于SURF特征的图像匹配

SURF算法是著名的尺度不变特征检测器SIFT(Scale-Invariant Features Transform)的高效变种,它为每个检测到的特征定义了位置和尺度,其中尺度的值可用于定义围绕特征点的窗口大小,使得每个特征点都与众不同。这里便是使用SURF算法提取两幅图像中的特征点描述子,并调用OpenCV中的函数进行匹配,最后输出一个可视化的结果,开发平台为Qt5.3.2+OpenCV2.4.9。以下给出图像匹配的实现步骤:

一、输入两幅图像,使用OpenCV中的cv::FeatureDetector接口实现SURF特征检测,在实际调试中改变阈值可获得不一样的检测结果:

~~~

// 设置两个用于存放特征点的向量

std::vector<cv::KeyPoint> keypoint1;

std::vector<cv::KeyPoint> keypoint2;

// 构造SURF特征检测器

cv::SurfFeatureDetector surf(3000); // 阈值

// 对两幅图分别检测SURF特征

surf.detect(image1,keypoint1);

surf.detect(image2,keypoint2);

~~~

二、OpenCV 2.0版本中引入一个通用类,用于提取不同的特征点描述子。在这里构造一个SURF描述子提取器,输出的结果是一个矩阵,它的行数与特征点向量中的元素个数相同。每行都是一个N维描述子的向量。**在SURF算法中,默认的描述子维度为64,该向量描绘了特征点周围的强度样式。**两个特征点越相似,它们的特征向量也就越接近,因此这些描述子在图像匹配中十分有用:

~~~

cv::SurfDescriptorExtractor surfDesc;

// 对两幅图像提取SURF描述子

cv::Mat descriptor1, descriptor2;

surfDesc.compute(image1,keypoint1,descriptor1);

surfDesc.compute(image2,keypoint2,descriptor2);

~~~

提取出两幅图像各自的特征点描述子后,需要进行比较(匹配)。可以调用OpenCV中的类cv::BruteForceMatcher构造一个匹配器。cv::BruteForceMatcher是类cv::DescriptorMatcher的一个子类,定义了不同的匹配策略的共同接口,结果返回一个cv::DMatch向量,它将被用于表示一对匹配的描述子。(关于cv::BruteForceMatcher 请参考:[http://blog.csdn.net/panda1234lee/article/details/11094483?utm_source=tuicool](http://blog.csdn.net/panda1234lee/article/details/11094483?utm_source=tuicool))

三、在一批特征点匹配结果中筛选出评分(或者称距离)最理想的25个匹配结果,这通过std::nth_element实现。

~~~

void nth_element(_RandomAccessIterator _first, _RandomAccessIterator _nth, _RandomAccessIterator _last)

~~~

该函数的作用为将迭代器指向的从_first 到 _last 之间的元素进行二分排序,以_nth 为分界,前面都比 _Nth 小(大),后面都比之大(小),因此适用于找出前n个最大(最小)的元素。

四、最后一步,将匹配的结果可视化。OpenCV提供一个绘制函数以产生由两幅输入图像拼接而成的图像,而匹配的点由直线相连:

~~~

// 以下操作将匹配结果可视化

cv::Mat imageMatches;

cv::drawMatches(image1,keypoint1, // 第一张图片和检测到的特征点

image2,keypoint2, // 第二张图片和检测到的特征点

matches, // 输出的匹配结果

imageMatches, // 生成的图像

cv::Scalar(128,128,128)); // 画直线的颜色

~~~

**要注意SIFT、SURF的函数在OpenCV的nonfree模块中而不是features2d,cv::BruteForceMatcher类存放在legacy模块中**,因此函数中需要包含头文件:

~~~

#include <opencv2/legacy/legacy.hpp>

#include <opencv2/nonfree/nonfree.hpp>

~~~

完整代码如下:

~~~

#include <QCoreApplication>

#include <opencv2/core/core.hpp>

#include <opencv2/highgui/highgui.hpp>

#include <opencv2/legacy/legacy.hpp>

#include <opencv2/nonfree/nonfree.hpp>

#include <QDebug>

int main(int argc, char *argv[])

{

QCoreApplication a(argc, argv);

// 以下两图比之

// 输入两张要匹配的图

cv::Mat image1= cv::imread("c:/Fig12.18(a1).jpg",0);

cv::Mat image2= cv::imread("c:/Fig12.18(a2).jpg",0);

if (!image1.data || !image2.data)

qDebug() << "Error!";

cv::namedWindow("Right Image");

cv::imshow("Right Image", image1);

cv::namedWindow("Left Image");

cv::imshow("Left Image", image2);

// 存放特征点的向量

std::vector<cv::KeyPoint> keypoint1;

std::vector<cv::KeyPoint> keypoint2;

// 构造SURF特征检测器

cv::SurfFeatureDetector surf(3000); // 阈值

// 对两幅图分别检测SURF特征

surf.detect(image1,keypoint1);

surf.detect(image2,keypoint2);

// 输出带有详细特征点信息的两幅图像

cv::Mat imageSURF;

cv::drawKeypoints(image1,keypoint1,

imageSURF,

cv::Scalar(255,255,255),

cv::DrawMatchesFlags::DRAW_RICH_KEYPOINTS);

cv::namedWindow("Right SURF Features");

cv::imshow("Right SURF Features", imageSURF);

cv::drawKeypoints(image2,keypoint2,

imageSURF,

cv::Scalar(255,255,255),

cv::DrawMatchesFlags::DRAW_RICH_KEYPOINTS);

cv::namedWindow("Left SURF Features");

cv::imshow("Left SURF Features", imageSURF);

// 构造SURF描述子提取器

cv::SurfDescriptorExtractor surfDesc;

// 对两幅图像提取SURF描述子

cv::Mat descriptor1, descriptor2;

surfDesc.compute(image1,keypoint1,descriptor1);

surfDesc.compute(image2,keypoint2,descriptor2);

// 构造匹配器

cv::BruteForceMatcher< cv::L2<float> > matcher;

// 将两张图片的描述子进行匹配,只选择25个最佳匹配

std::vector<cv::DMatch> matches;

matcher.match(descriptor1, descriptor2, matches);

std::nth_element(matches.begin(), // 初始位置

matches.begin()+24, // 排序元素的位置

matches.end()); // 终止位置

// 移除25位后的所有元素

matches.erase(matches.begin()+25, matches.end());

// 以下操作将匹配结果可视化

cv::Mat imageMatches;

cv::drawMatches(image1,keypoint1, // 第一张图片和检测到的特征点

image2,keypoint2, // 第二张图片和检测到的特征点

matches, // 输出的匹配结果

imageMatches, // 生成的图像

cv::Scalar(128,128,128)); // 画直线的颜色

cv::namedWindow("Matches"); //, CV_WINDOW_NORMAL);

cv::imshow("Matches",imageMatches);

return a.exec();

}

~~~

效果一,由于原图中飞机的边缘有锯齿状,因此只需观察拐角处,匹配效果良好:

效果二,不涉及图像的旋转和变形,只是将一幅图像进行缩放后进行匹配,得出的效果自然是很好:

效果三,用两个不同的角度拍摄的图像进行匹配,其中部分特征点匹配有偏差,总体效果良好,在调试过程中还可以通过参数调整获取更好的匹配效果。

**附注**:另一种匹配方法是使用 cv::FlannBasedMatcher 接口以及函数 FLANN 实现快速高效匹配(快速最近邻逼近搜索函数库(Fast Approximate Nearest Neighbor Search Library))。网上有源代码例程如下:

~~~

#include <stdio.h>

#include <iostream>

#include "opencv2/core/core.hpp"

#include <opencv2/highgui/highgui.hpp>

#include <opencv2/legacy/legacy.hpp>

#include "opencv2/features2d/features2d.hpp"

#include "opencv2/highgui/highgui.hpp"

using namespace cv;

void readme();

/** @function main */

int main( int argc, char** argv )

{

if( argc != 3 )

{ readme(); return -1; }

Mat img_1 = imread( argv[1], CV_LOAD_IMAGE_GRAYSCALE );

Mat img_2 = imread( argv[2], CV_LOAD_IMAGE_GRAYSCALE );

if( !img_1.data || !img_2.data )

{ std::cout<< " --(!) Error reading images " << std::endl; return -1; }

//-- Step 1: Detect the keypoints using SURF Detector

int minHessian = 400;

SurfFeatureDetector detector( minHessian );

std::vector<KeyPoint> keypoints_1, keypoints_2;

detector.detect( img_1, keypoints_1 );

detector.detect( img_2, keypoints_2 );

//-- Step 2: Calculate descriptors (feature vectors)

SurfDescriptorExtractor extractor;

Mat descriptors_1, descriptors_2;

extractor.compute( img_1, keypoints_1, descriptors_1 );

extractor.compute( img_2, keypoints_2, descriptors_2 );

//-- Step 3: Matching descriptor vectors using FLANN matcher

FlannBasedMatcher matcher;

std::vector< DMatch > matches;

matcher.match( descriptors_1, descriptors_2, matches );

double max_dist = 0; double min_dist = 100;

//-- Quick calculation of max and min distances between keypoints

for( int i = 0; i < descriptors_1.rows; i++ )

{ double dist = matches[i].distance;

if( dist < min_dist ) min_dist = dist;

if( dist > max_dist ) max_dist = dist;

}

printf("-- Max dist : %f \n", max_dist );

printf("-- Min dist : %f \n", min_dist );

//-- Draw only "good" matches (i.e. whose distance is less than 2*min_dist )

//-- PS.- radiusMatch can also be used here.

std::vector< DMatch > good_matches;

for( int i = 0; i < descriptors_1.rows; i++ )

{ if( matches[i].distance < 2*min_dist )

{ good_matches.push_back( matches[i]); }

}

//-- Draw only "good" matches

Mat img_matches;

drawMatches( img_1, keypoints_1, img_2, keypoints_2,

good_matches, img_matches, Scalar::all(-1), Scalar::all(-1),

vector<char>(), DrawMatchesFlags::NOT_DRAW_SINGLE_POINTS );

//-- Show detected matches

imshow( "Good Matches", img_matches );

for( int i = 0; i < good_matches.size(); i++ )

{ printf( "-- Good Match [%d] Keypoint 1: %d -- Keypoint 2: %d \n", i, good_matches[i].queryIdx, good_matches[i].trainIdx ); }

waitKey(0);

return 0;

}

/** @function readme */

void readme()

{ std::cout << " Usage: ./SURF_FlannMatcher <img1> <img2>" << std::endl; }

~~~

以上只是记录这种方法的实现例程,并没有验证代码的正确性。

参考资料:

[http://blog.sina.com.cn/s/blog_a98e39a201017pgn.html](http://blog.sina.com.cn/s/blog_a98e39a201017pgn.html)

[http://www.cnblogs.com/tornadomeet/archive/2012/08/17/2644903.html](http://www.cnblogs.com/tornadomeet/archive/2012/08/17/2644903.html) (SURF算法的理论介绍)

[http://blog.csdn.net/liyuefeilong/article/details/44166069](http://blog.csdn.net/liyuefeilong/article/details/44166069)

[http://www.opencv.org.cn/opencvdoc/2.3.2/html/doc/tutorials/features2d/feature_flann_matcher/feature_flann_matcher.html](http://www.opencv.org.cn/opencvdoc/2.3.2/html/doc/tutorials/features2d/feature_flann_matcher/feature_flann_matcher.html)

OpenCV2学习笔记(十二)

最后更新于:2022-04-01 06:36:12

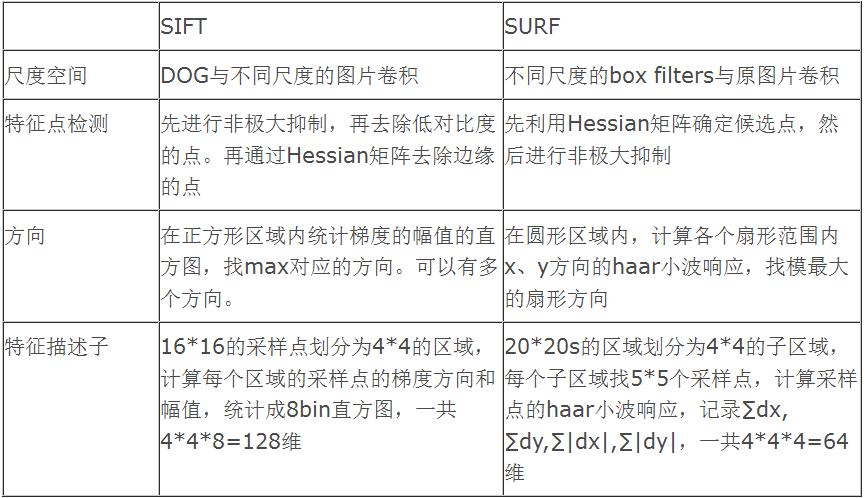

##特征提取算法SIFT与SURF

当尝试在不同图像之间进行特征匹配时,通常会遇到图像的大小、方向等参数发生改变的问题,简而言之,就是尺度变化的问题。每幅图像在拍摄时与目标物体的距离是不同的,因此要识别的目标物体在图像中自然会存在不同的尺寸。

因此,计算机视觉中引入尺度不变的特征,主要的思想是每个检测到的特征点都伴随对应的尺度因子。1999年David Lowe提出了著名的尺度不变特征检测器SIFT(Scale Invariant Feature Transform)算法,它具有尺度,旋转,仿射,视角,光照不变性。而加速鲁棒特性特征SURF(Speeded Up Robust Features)算法是SIFT的高效变种。这两个算法申请了专利保护,其专利的拥有者为英属哥伦比亚大学。

关于SIFT和SURF的特征介绍,已经有很多的blog对其进行简介了,见参考的blog。由于还没有将2004年那篇原文精细看完,因此这里只能粗浅地分析两种算法,并描述在OpenCV中如何实现这两种算法的特征检测。

**一、基本概念**

1.1 算法背景

尺度不变特征转换SIFT是一种著名的计算机视觉的算法,主要用来检测图像中的局部特征,通过在图像中寻找极值点特征,并提取出其这些特征点的位置、尺度和旋转不变量等信息。

其应用范围包含物体辨识、机器人地图感知与导航、影像缝合、3D模型建立、手势辨识、影像追踪和动作比对。

局部影像特征的描述与侦测可以帮助辨识物体,SIFT 特征是基于物体上的一些局部外观的兴趣点而与影像的大小和旋转无关。对于光线、噪声、些微视角改变的容忍度也相当高。基于这些特性,它们是高度显著而且相对容易撷取,在母数庞大的特征数据库中,很容易辨识物体而且鲜有误认。使用 SIFT特征描述对于部分物体遮蔽的侦测率也相当高,甚至只需要3个以上的SIFT物体特征就足以计算出位置与方位。在现今的电脑硬件速度下和小型的特征数据库条件下,辨识速度可接近即时运算。SIFT特征的信息量大,适合在海量数据库中快速准确匹配。(来自百度百科的解释)

1.2 SIFT算法的主要优点

1\. SIFT特征是图像的局部特征,其对旋转、尺度缩放、亮度变化保持不变性,对视角变化、仿射变换、噪声也保持一定程度的稳定性;

2\. 独特性(Distinctiveness)好,信息量丰富,适用于在海量特征数据库中进行快速、准确的匹配;

3\. 多量性,即使少数的几个物体也可以产生大量的SIFT特征向量;

4\. 高速性,经优化的SIFT匹配算法甚至可以达到实时的要求;

5\. 可扩展性,可以很方便的与其他形式的特征向量进行联合。

1.3 SIFT算法的适用环境

目标的自身状态、场景所处的环境和成像器材的成像特性等因素影响图像配准/目标识别跟踪的性能。而SIFT算法在一定程度上可解决:

1\. 目标的旋转、缩放、平移(RST)

2\. 图像仿射/投影变换(视点viewpoint)

3\. 光照影响(illumination)

4\. 目标遮挡(occlusion)

5\. 杂物场景(clutter)

6\. 噪声

SIFT算法的实质是在不同的尺度空间上查找关键点(特征点),并计算出关键点的方向。SIFT所查找到的关键点是一些十分突出,不会因光照,仿射变换和噪音等因素而变化的点,如角点、边缘点、暗区的亮点及亮区的暗点等。

1.4 算法的基本步骤

Lowe将SIFT算法分解为如下四步:

1\. 尺度空间极值检测:搜索所有尺度上的图像位置。通过高斯微分函数来识别潜在的对于尺度和旋转不变的兴趣点。

2\. 关键点定位:在每个候选的位置上,通过一个拟合精细的模型来确定位置和尺度。关键点的选择依据于它们的稳定程度。

3\. 方向确定:基于图像局部的梯度方向,分配给每个关键点位置一个或多个方向。所有后面的对图像数据的操作都相对于关键点的方向、尺度和位置进行变换,从而提供对于这些变换的不变性。

4\. 特征点描述:在每个关键点周围的邻域内,在选定的尺度上测量图像局部的梯度。这些梯度被变换成一种表示,这种表示允许比较大的局部形状的变形和光照变化。

1.5 SIFT算法的缺点

SIFT算法十分强大,精度很高,Mikolajczyk和Schmid曾经针对不同的场景,对光照变化、图像几何变形、分辨率差异、旋转、模糊和图像压缩等6种情况,就多种最具代表性的描述子(如SIFT,矩不变量,互相关等10种描述子)进行了实验和性能比较,结果表明,在以上各种情况下,SIFT描述子的性能最好。但算法的高深同样带来了一些缺点,如:

1\. 实时性不高。

2\. 有时特征点较少。

3\. 对边缘光滑或经过平滑的图像无法准确提取特征点。

针对这些问题,一些改进算法应运而生,SURF就是广为人知的其中一种算法。

2.1 SURF算法介绍

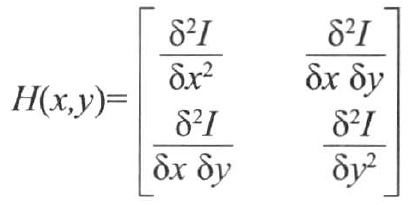

SURF算法是SIFT算法的高效变种,在满足一定效果的情况下完成两幅图像中物体的匹配,并基本实现了实时处理。SURF也检测空间域和尺度域上的局部极大值作为特征,但是使用的是Hessian行列式响应而不是Laplacian行列式。

SURF的实现如下,首先对每个像素计算Hessian矩阵以得到特征,该矩阵测量一个函数的局部曲率,定义如下:

该矩阵的行列式给出曲率的强度,定义角点为具有较高局部曲率的像素点(即在多个方向都具有高曲率)。由于该函数是由二阶导数组成,因此可以使用不同的 尺度的Laplacian Gaussian核进行计算,因此Hessian变成了三个变量的函数。当Hessian的值同时在空间域和尺度域上均达到局部极大值时(需要运行3*3*3的非极大值抑制),可以认为找到了尺度不变的特征。

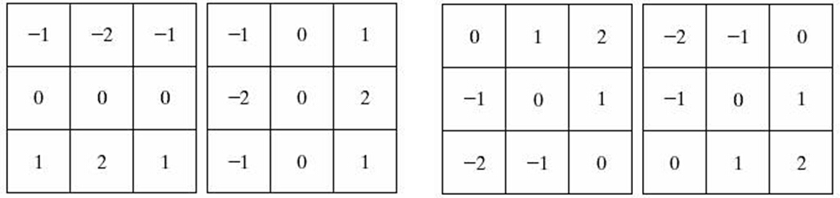

所有这些不同尺度的运算都很耗时,而SURF算法的目的是尽可能高效。因此会使用近似的高斯核,仅涉及少量整数加法,结构如下图所示:

左侧的核用于估计混合二阶导数,右侧的核则用于估算垂直方向的二阶导数,而其旋转版本则用于估计水平方向的二阶导数。

一旦识别了局部极大值,每个特征点的精确位置可以通过空间域及尺度域上进行插值获取,结果是一组具有亚像素精确度的特征点,以及一个对应的尺度值。

2.2 性能比较

无需赘述,A comparison of SIFT, PCA-SIFT and SURF 一文给出了SIFT和SURF的性能比较,对原图像进行尺度、旋转、模糊、亮度变化、仿射变换等变化后,再与原图像进行匹配,统计匹配的效果,源图片来源于Graffiti dataset。

这里使用的开发平台是Qt5.3.2+OpenCV2.4.9。SURF、SIFT特征在OpenCV中的实现均使用了cv::FeatureDetector接口,OpenCV中的opencv_nonfree模块包含了SURF和SIFT的相关函数,因此在使用时注意添加相关的头文件。在这里,特征点的计算基于浮点核,因此这两种算法相比其他算法在空间和尺度检测上更加精确,但相对耗时。

至于理论部分有待进一步学习。

**二、实现SIFT特征检测算法**

直接在Qt中创建一个控制台项目,在main函数中添加:

~~~

#include <QCoreApplication>

#include <opencv2/core/core.hpp>

#include <opencv2/highgui/highgui.hpp>

#include <opencv2/features2d/features2d.hpp>

#include <opencv2/nonfree/nonfree.hpp>

#include <QDebug>

int main(int argc, char *argv[])

{

QCoreApplication a(argc, argv);

// 读入图像

cv::Mat image= cv::imread("c:/018.jpg",0);

cv::namedWindow("Original Image");

cv::imshow("Original Image", image);

// 特征点的向量

std::vector<cv::KeyPoint>keypoints;

// 构造SIFT特征检测器

cv::SiftFeatureDetector sift(

0.03, // 特征的阈值

10.); // 用于降低

// 检测SIFT特征值

sift.detect(image,keypoints);

cv::drawKeypoints(image, // 原始图像

keypoints, // 特征点的向量

featureImage, // 生成图像

cv::Scalar(255,255,255), // 特征点的颜色

cv::DrawMatchesFlags::DRAW_RICH_KEYPOINTS); // 标志位

cv::namedWindow("SIFT Features");

cv::imshow("SIFT Features",featureImage);

return a.exec();

}

~~~

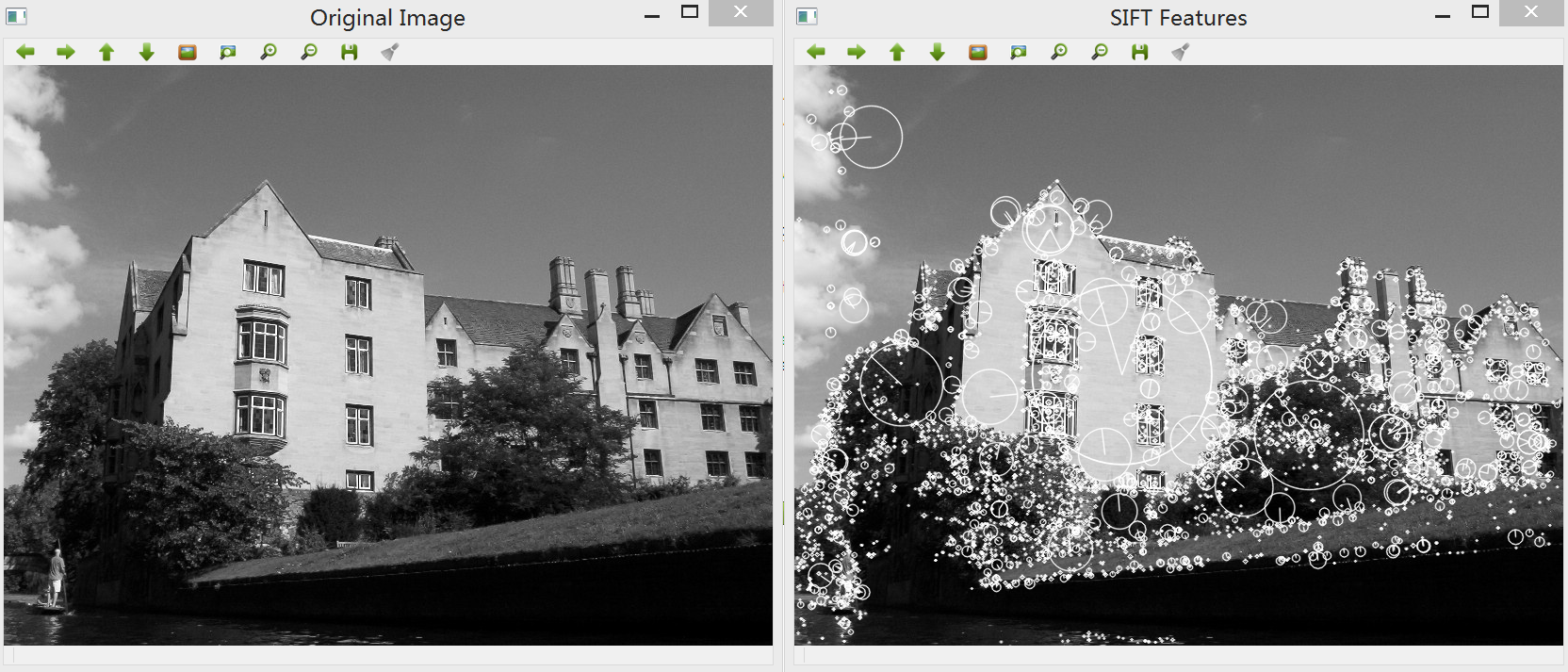

效果如下,在函数cv::drawKeypoints中我们使用cv::DrawMatchesFlags::DRAW_RICH_KEYPOINTS作为标志位,这样唉使用DRAW_RICH_KEYPOINTS之后每个关键点上圆圈的尺寸与特征的尺度成正比:

**三、实现SURF特征检测算法**

~~~

#include <QCoreApplication>

#include <opencv2/core/core.hpp>

#include <opencv2/highgui/highgui.hpp>

#include <opencv2/features2d/features2d.hpp>

#include <opencv2/nonfree/nonfree.hpp>

#include <QDebug>

int main(int argc, char *argv[])

{

QCoreApplication a(argc, argv);

// 读入图像

cv::Mat image= cv::imread("c:/018.jpg",0);

cv::namedWindow("Original Image");

cv::imshow("Original Image", image);

// 特征点的向量

std::vector<cv::KeyPoint>keypoints;

// 构造SURF特征检测器

cv::SurfFeatureDetector surf(2500);

// 检测SURF特征

surf.detect(image,keypoints);

cv::Mat featureImage;

cv::drawKeypoints(image, // 原始图像

keypoints, // 特征点的向量

featureImage, // 生成图像

cv::Scalar(255,255,255), // 特征点的颜色

cv::DrawMatchesFlags::DRAW_RICH_KEYPOINTS); // 标志位

cv::namedWindow("SURF Features");

cv::imshow("SURF Features",featureImage);

return a.exec();

}

~~~

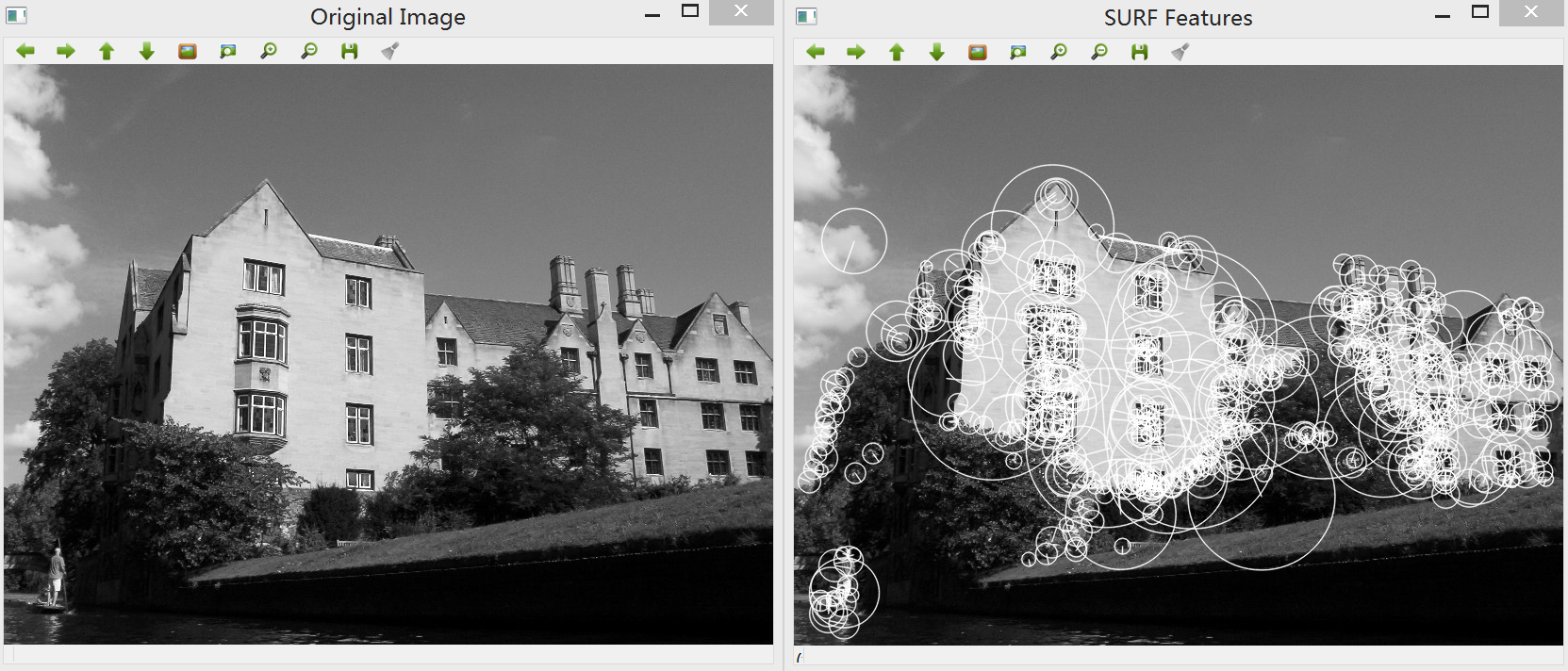

效果:

从两种算法的输出结果可以看出,SURF与SIFT描述子的区别主要是速度及精度。SURF描述子大部分基于强度的差值,计算更加快捷,而SIFT描述子通常在搜索正确的特征点时更加精确。

参考资料:

David G.Lowe Object Recognition from Local Scale-Invariant Features. 1999.

David G.Lowe Distinctive Image Features from Scale-Invariant Keypoints. January 5, 2004.

SIFT官网的Rob Hess [hess@eecs.oregonstate.edu](mailto:hess@eecs.oregonstate.edu) SIFT源码

参考博客:

[http://blog.csdn.net/zddblog/article/details/7521424](http://blog.csdn.net/zddblog/article/details/7521424) (个人认为是目前最详尽的SIFT介绍)

[http://underthehood.blog.51cto.com/2531780/658350](http://underthehood.blog.51cto.com/2531780/658350)

[http://blog.csdn.net/xiaowei_cqu/article/details/8069548](http://blog.csdn.net/xiaowei_cqu/article/details/8069548)

[http://www.cnblogs.com/tornadomeet/archive/2012/08/16/2643168.html](http://www.cnblogs.com/tornadomeet/archive/2012/08/16/2643168.html)

OpenCV2学习笔记(十一)

最后更新于:2022-04-01 06:36:10

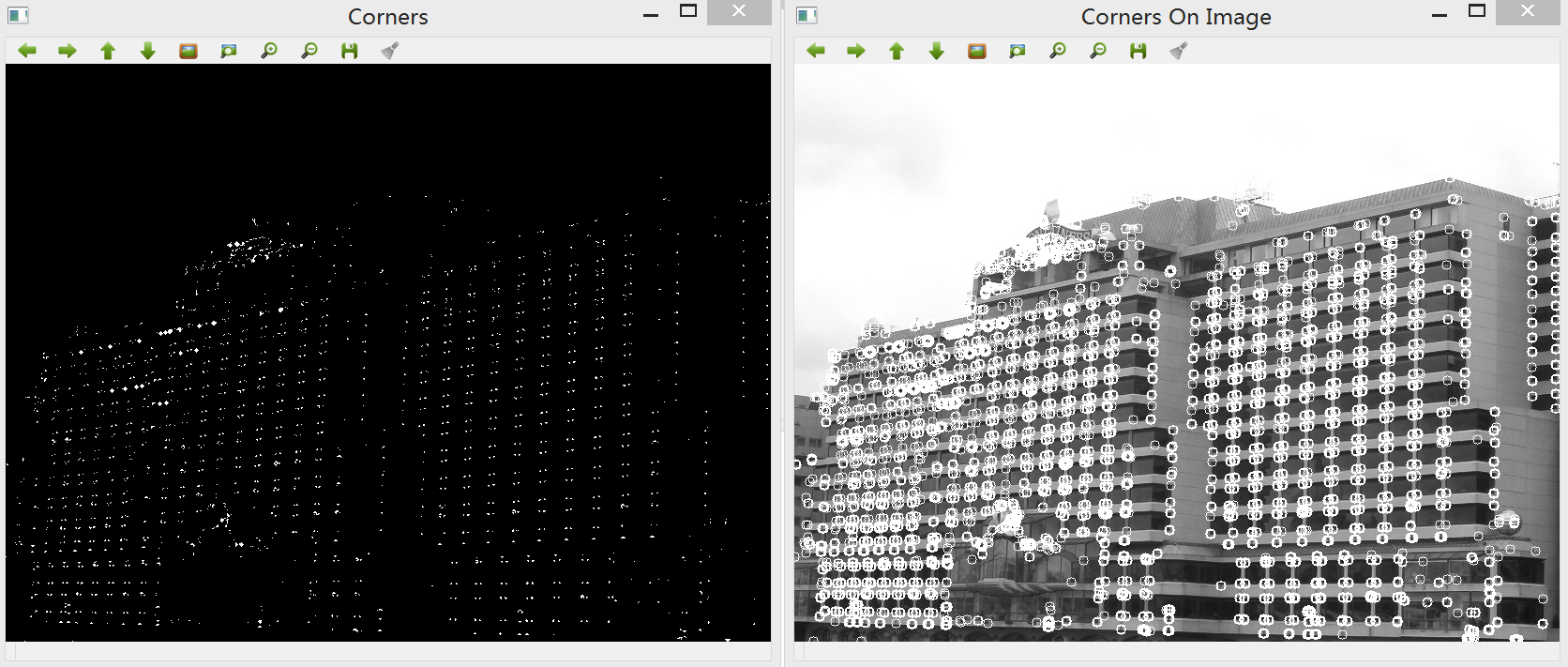

##特征点检测之FAST算法

在上一节中,记录了Harris算子检测图像特征点的定义和基于OpenCV的实现方法,它基于两个正交方向上的强度变化率。本节记录另一种特征点检测算子FAST(Features from Accelerated Segment Test),它依赖少数像素的比较来确定是否接受一个特征点,其检测效率要好于Harris。

与Harris算法相同,FAST特征算法需要定义什么是特征点。这次的定义基于假定特征点周围的图像强度,通过检查候选像素的周围一圈像素来决定是否接受这一个特征点。与中心点差异较大的像素如果组成连续的圆弧,并且弧长大于圆周长的3/4,则可判断为特征点。

在此基础上,算法还使用了额外的技巧进行加速。首先测试一个圆圈上被90度分隔的四个点(如顶部、底部,左侧和右侧四个点),如果要满足FAST的定义条件,四个点中至少要有三个点必须同时大于或小于中心像素。如果条件不成立,则该点可以直接被移除而不需要进一步的验证。在实践中,大部分的像素点可以通过这个测试进行移除,因此该算法非常高效。

和Harris方法相同的是,可以在找到的角点上执行非极大值抑制,因此需要指定角点强度的测量方法。

这里可以使用OpenCV 2的通用接口来创建任意的特征检测器,比如FAST检测器的使用方法如下:

~~~

// 创建特征点的向量

std::vector<cv::KeyPoint>keypoints;

// 构造FAST特征检测器

cv::FastFeatureDetector fast(75);

// 进行检测

fast.detect(image, keypoints);

~~~

同时,为了方便标记特征点,OpenCV提供了通用的特征点绘制函数cv::drawKeypoints,其调用方法如下:

~~~

// 通用的特征点绘制函数

cv::drawKeypoints(image, // 输入图像

keypoints, // 特征点向量

image, // 输出图像

cv::Scalar(255,255,255), // 特征点颜色

cv::DrawMatchesFlags::DRAW_OVER_OUTIMG); // 绘制标记

~~~

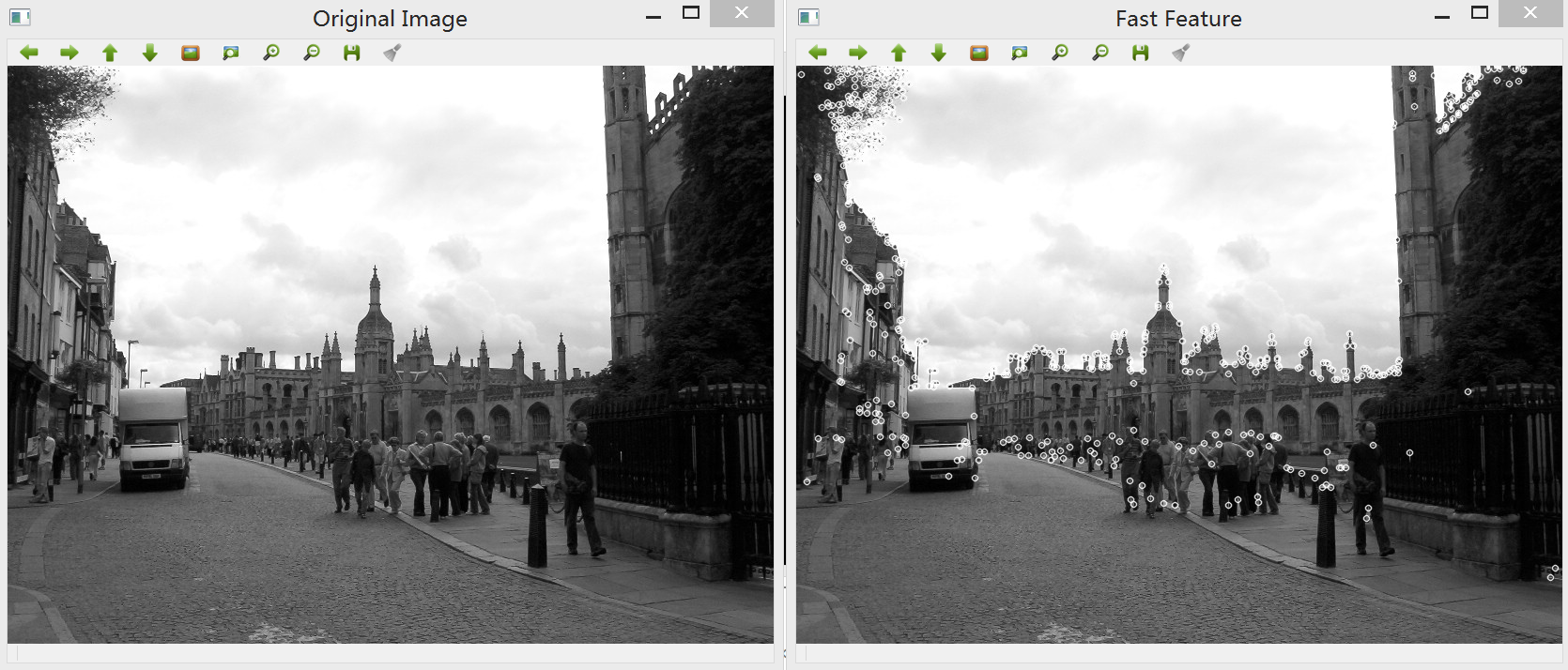

通过指定选中的绘制标记,可以看到输出图像中特征点均得到了绘制:

完整的实现代码如下,只需修改main函数:

~~~

#include <QCoreApplication>

#include <opencv2/core/core.hpp>

#include <opencv2/imgproc/imgproc.hpp>

#include <opencv2/highgui/highgui.hpp>

#include <opencv2/features2d/features2d.hpp>

int main(int argc, char *argv[])

{

QCoreApplication a(argc, argv);

// 输入图像

cv::Mat image = cv::imread("c:/031.jpg", 0);

cv::namedWindow("Original Image");

cv::imshow("Original Image", image);

// 特征点的向量

std::vector<cv::KeyPoint>keypoints;

// 构造FAST特征检测器

cv::FastFeatureDetector fast(75);

// 进行检测

fast.detect(image, keypoints);

// 通用的特征点绘制函数

cv::drawKeypoints(image, // 输入图像

keypoints, // 特征点向量

image, // 输出图像

cv::Scalar(255, 255, 255), // 特征点颜色

cv::DrawMatchesFlags::DRAW_OVER_OUTIMG); // 绘制标记

cv::namedWindow("Fast Feature");

cv::imshow("Fast Feature", image);

return a.exec();

}

~~~

FAST算法可以获得非常快速的特征点检测,在需要考虑运行速度的时候可以选用,比如在高帧率的视频序列中进行视觉跟踪。

关于FAST特征算法的详细描述,可参考以下论文:

The article by E.Rosten, T.Drummond, Machine Learning for High-speed Corner Detection, In European Conference on Computer Vision, pp.430-443, 2006

OpenCV2学习笔记(十)

最后更新于:2022-04-01 06:36:08

##特征点检测之Harris法

在计算机视觉中,特征点的概念被大量用于解决物体识别、图像匹配、视觉跟踪、三维重建等问题,比如图像中物体的角点,它们是在图像中可被轻易而精确地定位的二维特征。顾名思义,特征点检测的思想是无需观察整幅图像,而是通过选择某些特殊点,然后对它们执行局部分析。如果能检测到足够多的这种点,同时它们的区分度很高,并且可以精确定位稳定的特征,那么这个方法就很有效。这里主要使用Harris特征检测器检测图像角点。开发平台为Qt5.3.2+OpenCV2.4.9。

在此之前,先给出OpenCV中cv::cornerHarris函数的调用方式:

~~~

cv::cornerHarris(image, // 输入图像

cornerStrength, // 输出为表示角点强度的32位浮点图像

3, // 导数平滑的相邻像素的尺寸

3, // 梯度计算的滤波器孔径大小

0.01); // Harris参数

~~~

描述Harris算子的经典论文可参考:

The article by C.Harris, M.J. Stephens, A Combined Corner and Edge Detector, Alvey Vision Conference, pp.147-152, 1988

The article by J. Shi and C. Tomasi, Good features to track, Int. Conference on Computer Vision and Pattern Recognition, pp. 593-600, 1994

The article by K. Mikolajczyk and C. Schmid, Scale and Affine invariant interest point detectors, International Journal of Computer Vision, vol 60, no 1, pp. 63-86, 2004

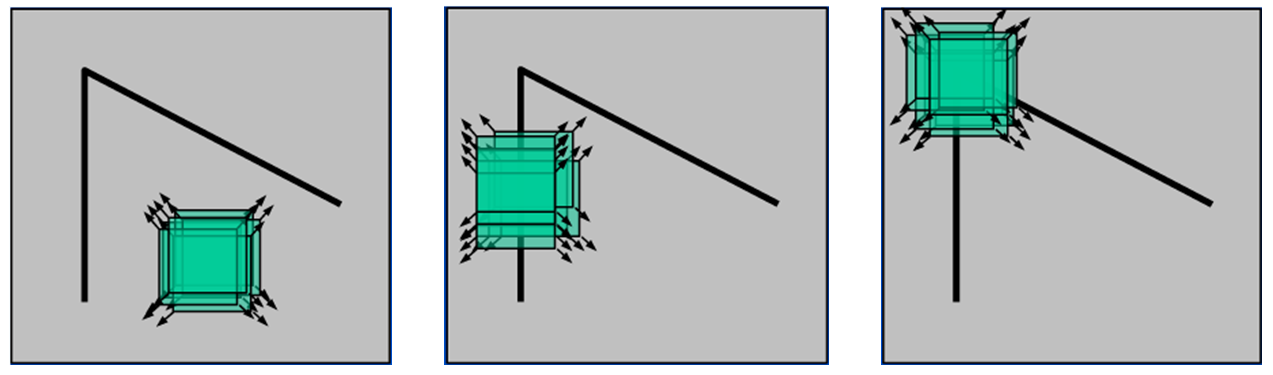

在第一篇论文中提到,Harris角点检测最直观的解释是在任意两个相互垂直的方向上,都有较大变化的点。为了定义一幅图像中的角点,Harris观察一个假定的特征点周围小窗口内的方向性强度平均变化。

如图所示,假设一个小窗口在图像上移动,在平滑区域如左图所示,窗口在各个方向上均没有变化。对于中间图,小窗口在边缘的方向上移动时也没有变化。而知道小窗口移动到右图的角点处,窗口在各个方向上均有明显的变化。Harris角点检测正是利用了这个直观的物理现象,通过窗口在各个方向上的变化程度,决定是否存在着角点。这里我们考虑偏移量(u,v),则将图像窗口平移(u,v)产生的E(u,v)可表示为:

由以下公式可得到E(u,v):

对于局部微小的移动,E(u,v)可近似表达为:

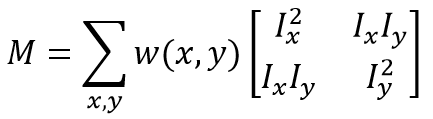

其中M的详细表达式为:

E(u,v)的椭圆形式如下:

**E(u,v)是一个协方差矩阵,表现的是所有方向上强度的变化率。**该定义涉及图像的一阶导数,这通常是Sobel算子的计算结果。而在OpenCV中cv::cornerHarris函数的第四个参数对应的正是用于计算Sobel滤波器的孔径(aperture)。协方差的两个特征值给出了最大平均强度变化以及垂直方向上的平均强度变化,如果这两个特征值均较低,就认为当前是同质区域;如果其中一个特征值较高,另外一个较低,则认为当前位于边缘上;最后,若两个特征值均较高,则判定当前位于角点处。

因此,定义角点响应函数R,其中k为函数cv::cornerHarris中的最后一个参数;之后,对R进行阈值处理,设定若R大于阈值threshold,则提取出局部极大值:

Harris角点的更多的理论部分可见:

[http://blog.csdn.net/lu597203933/article/details/15088485](http://blog.csdn.net/lu597203933/article/details/15088485)

[http://blog.csdn.net/xiaowei_cqu/article/details/7805206](http://blog.csdn.net/xiaowei_cqu/article/details/7805206)。

**下面记录一下harris角点检测的几种方案。**

一、基本的Harris角点检测实现

~~~

#include <QCoreApplication>

#include <opencv2/core/core.hpp>

#include <opencv2/imgproc/imgproc.hpp>

#include <opencv2/highgui/highgui.hpp>

int main(int argc, char *argv[])

{

QCoreApplication a(argc, argv);

// Harris法的简单实现

cv::Mat image = cv::imread("c:/031.jpg", 0);

cv::Mat cornerStrength;

cv::cornerHarris(image,

cornerStrength, // 输出为表示角点强度的32位浮点图像

3, // 导数平滑的相邻像素的尺寸

3, // 梯度计算的滤波器孔径大小

0.01); // Harris的相关参数

// 要在窗口输出,需要转化为CV_8U格式,阈值化即可

// 角点强度的阈值

cv::Mat harrisCorner;

double threshold = 0.0001;

cv::threshold(cornerStrength,

harrisCorner,

threshold,

255,

cv::THRESH_BINARY_INV); // 输出为翻转的二值图像

cv::namedWindow("Original Image");

cv::imshow("Original Image", image);

cv::namedWindow("Harris Corner");

cv::imshow("Harris Corner", harrisCorner);

return a.exec();

}

~~~

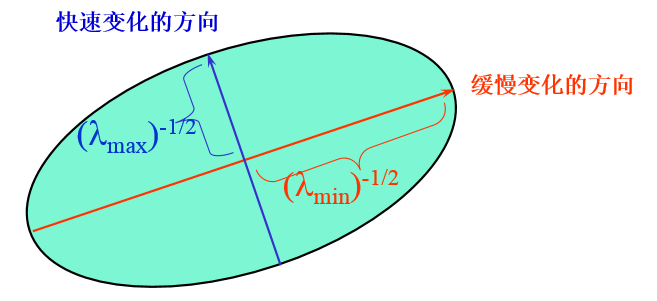

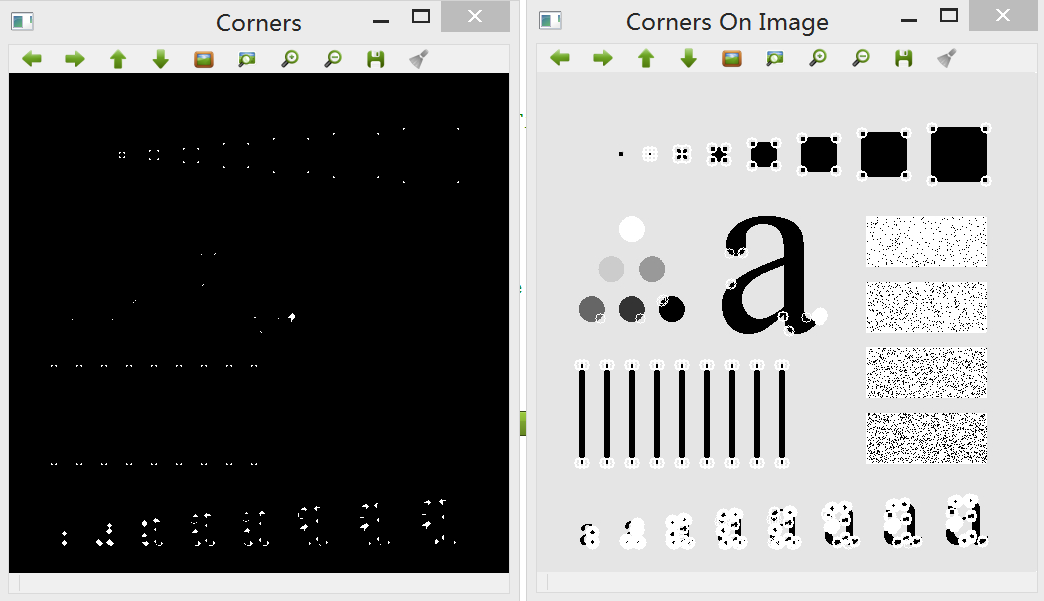

得到的结果为二值图像,可以看到图像中角点的位置包含许多圆圈,这与精确定位特征点的目标相悖:

**二、改进的Harris角点检测实现(Shi-Tomasi算法)**

这里通过封装自定义类来改进角点检测的效果。定义一个类HarrisDetector(其中已封装了Harris参数和相关函数):

~~~

#ifndef HARRISDETECTOR_H

#define HARRISDETECTOR_H

#include <opencv2/core/core.hpp>

#include <opencv2/imgproc/imgproc.hpp>

#include <opencv2/highgui/highgui.hpp>

class HarrisDetector

{

private:

// 表示图像角点强度的32位浮点图像

cv::Mat cornerStrength;

// 将输出图像阈值化后的32位浮点图像

cv::Mat cornerThreshold;

// 局部极大值图像

cv::Mat localMax;

// 以下三个为cornerHarris函数的必要参数

// 导数平滑的相邻像素的尺寸

int neighbourhoodPixelSize;

// 滤波器的孔径大小

int aperture;

// Harris参数

double k;

// 阈值计算的最大强度

double maxStrength;

// 计算得到的阈值

double threshold;

// 非极大值抑制的相邻像素的尺寸

int noneighbourhoodPixelSize;

// 非极大值抑制的核

cv::Mat kernel;

public:

// 初始化参数

HarrisDetector():neighbourhoodPixelSize(3),

aperture(3),

k(0.01),

maxStrength(0.0),

threshold(0.01),

noneighbourhoodPixelSize(3)

{

setLocalMaxWindowSize(noneighbourhoodPixelSize);

}

// 创建非极大值抑制的核

void setLocalMaxWindowSize(int size);

// 计算Harris角点

void detect(const cv::Mat &image);

// 由Harris的值获取角点图

cv::Mat getCornerMap(double qualityLevel);

// 由Harris的值获取特征点

void getCorners(std::vector<cv::Point> &points, double qualityLevel);

// 由角点图获取特征点

void getCorners(std::vector<cv::Point> &points, const cv::Mat& cornerMap);

// 在特征点的位置绘制图

void drawOnImage(cv::Mat &image,

const std::vector<cv::Point> &points,

cv::Scalar color = cv::Scalar(255, 255, 255),

int radius = 4, int thickness = 2);

};

#endif // HARRISDETECTOR_H

~~~

接着,在harrisdetector.cpp中定义各个函数和初始化的参数:

~~~

#include "harrisdetector.h"

// 创建非极大值抑制的核

void HarrisDetector::setLocalMaxWindowSize(int size)

{

noneighbourhoodPixelSize = size;

kernel.create(noneighbourhoodPixelSize, noneighbourhoodPixelSize, CV_8U);

}

// 计算Harris角点

void HarrisDetector::detect(const cv::Mat &image)

{

// Harris计算

cv::cornerHarris(image,cornerStrength,

neighbourhoodPixelSize,

aperture,

k);

// 内部阈值计算

double minStrength; // 未使用

cv::minMaxLoc(cornerStrength,

&minStrength,

&maxStrength);

// 局部极大值检测

cv::Mat dilate; // 临时图像

cv::dilate(cornerStrength, dilate, cv::Mat());

cv::compare(cornerStrength, dilate, localMax, cv::CMP_EQ);

}

// 由Harris的值获取角点图

cv::Mat HarrisDetector::getCornerMap(double qualityLevel)

{

cv::Mat cornerMap;

// 对角点图像进行阈值化

threshold = qualityLevel * maxStrength;

cv::threshold(cornerStrength, cornerThreshold,

threshold,255,cv::THRESH_BINARY);

// 转换为8位图像

cornerThreshold.convertTo(cornerMap, CV_8U);

// 非极大值抑制

cv::bitwise_and(cornerMap, localMax, cornerMap);

return cornerMap;

}

// 由Harris的值获取特征点

void HarrisDetector::getCorners(std::vector<cv::Point> &points, double qualityLevel)

{

// 得到角点图

cv::Mat cornerMap = getCornerMap(qualityLevel);

getCorners(points, cornerMap);

}

// 由角点图获取特征点

void HarrisDetector::getCorners(std::vector<cv::Point> &points, const cv::Mat& cornerMap)

{

// 遍历像素得到所有特征

for( int y = 0; y < cornerMap.rows; y++ )

{

const uchar* rowPtr = cornerMap.ptr<uchar>(y);

for( int x = 0; x < cornerMap.cols; x++ )

{

// 如果是特征点

if (rowPtr[x])

{

points.push_back(cv::Point(x,y));

}

}

}

}

// 在特征点的位置绘制图

void HarrisDetector::drawOnImage(cv::Mat &image,

const std::vector<cv::Point> &points,

cv::Scalar color,

int radius, int thickness)

{

std::vector<cv::Point>::const_iterator it = points.begin();

// 对于所有角点,绘制白色圆圈

while(it != points.end())

{

cv::circle(image, *it, radius, color, thickness);

++ it;

}

}

~~~

最后,使用该类的步骤如下,直接修改main函数:

~~~

#include <QCoreApplication>

#include <opencv2/core/core.hpp>

#include <opencv2/imgproc/imgproc.hpp>

#include <opencv2/highgui/highgui.hpp>

#include <QDebug>

#include "harrisdetector.h"

int main(int argc, char *argv[])

{

QCoreApplication a(argc, argv);

cv::Mat image = cv::imread("c:/031.jpg", 0);

// 创建Harris对象

HarrisDetector harris;

// 计算Harris的值

harris.detect(image);

// 检测Harris的角点

std::vector<cv::Point>pts;

harris.getCorners(pts, 0.1);

// 绘制角点图

harris.drawOnImage(image, pts);

cv::namedWindow("Harris Corners Final");

return a.exec();

}

~~~

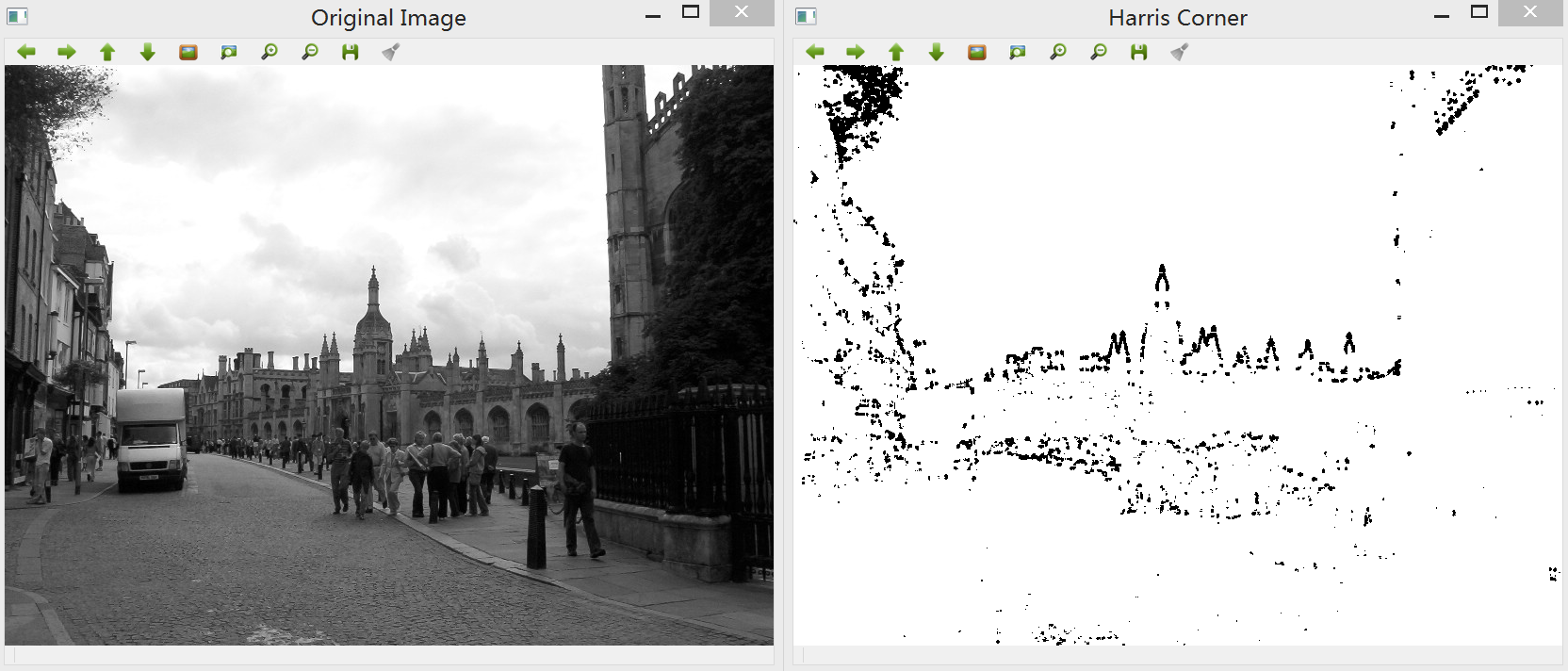

生成的图像:

这里为了改进特征点检测结果,添加了额外的非极大值抑制步骤,目的是移除彼此相邻的Harris角点。这就要求Harris角点不只需要得分高于给定阈值,它还必须是局部极大值。在检测中使用了一个技巧,即将Harris得分的图像进行膨胀:

~~~

cv::dilate(cornerStrength, dilate, cv::Mat());

~~~

这是由于膨胀运算替换每个像素值为相邻范围内的最大值,因此只有局部极大值的点才会保留原样,并通过以下函数进行测试:

~~~

cv::compare(cornerStrength, dilate, localMax, cv::CMP_EQ);

~~~

其中,localMax矩阵仅在局部极大值的位置为真,因此又可以在getCornerMap函数中用它来抑制所有非极大值的特征(基于cv::bitwise_and函数)。

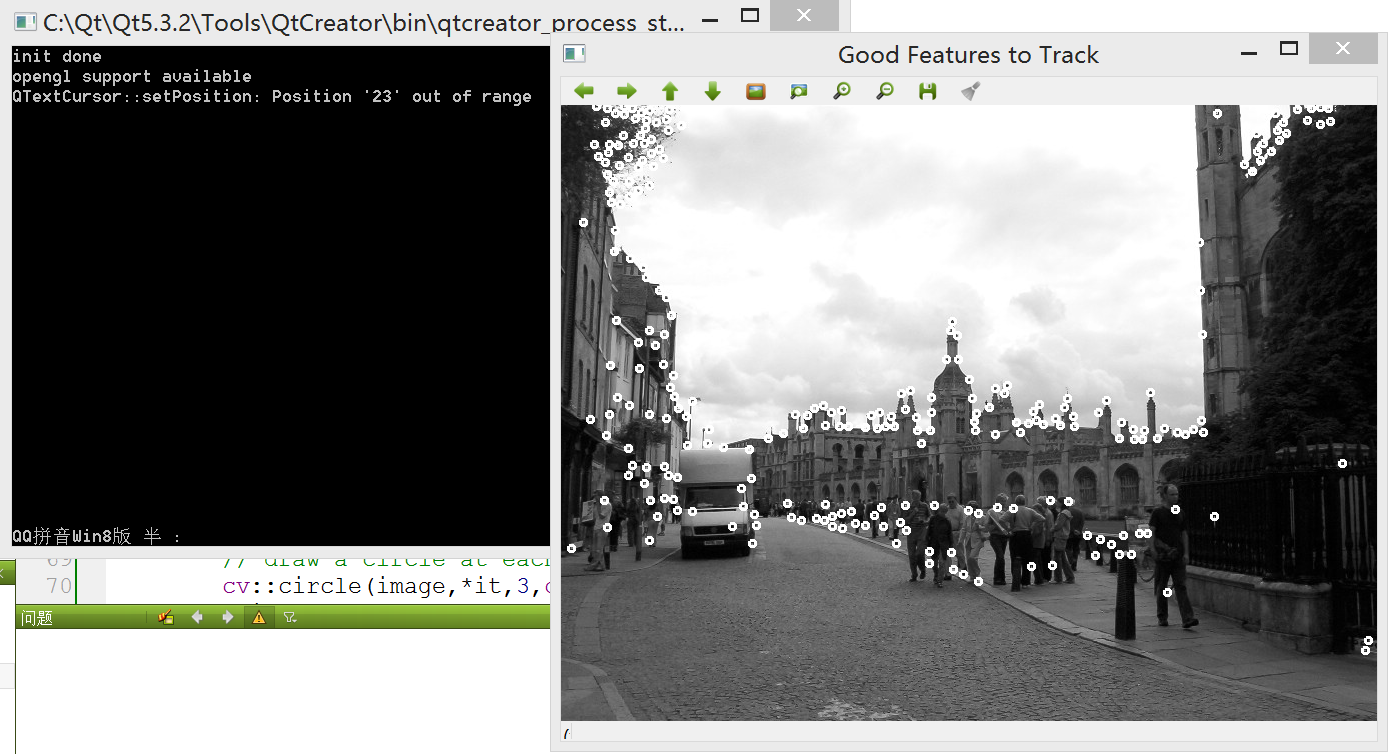

**三、引入适合跟踪的优质特征的Harris检测实现**

在浮点处理器的帮助下,为了避免特征值分解而引入的数学上的简化变得微不足道,因此Harris检测可以基于计算而得的特征值。原则上这个修改不会显著影响检测的结果,但是能够避免使用任意的k参数。

以上第二中方法引入了局部极大值的条件,改善了部分效果。然而,特征点倾向于图像中不均匀分布、普遍集中在纹理丰富的部分。这里记录一种新的解决方案:

该方案利用两个特征点之间的最小距离,从Harris得分最高的点开始,仅接受离开有效特征点距离大于特定值的那些点。在OpenCV中提供cv::goodFeaturesToTrack实现这一方法,它检测到的特征能用于视觉跟踪应用中的优质特征集合。其调用方式如下:

~~~

// 计算适合跟踪的优质特征

std::vector<cv::Point2f> corners;

cv::goodFeaturesToTrack(image,corners,

250, // 返回的最大特征点的数目

0.01, // 质量等级

8); // 两点之间的最小允许距离

~~~

除了质量等级阈值、特征点之间的最小允许距离,该函数还需要指定返回的最大特征点数目,这是因为特征点是按照强度进行排序的。以下给出该方法的实现代码,直接在main函数中添加:

~~~

// 输入图像

cv::Mat image= cv::imread("c:/031.jpg",0);

// 计算适合跟踪的优质特征

std::vector<cv::Point2f> corners;

cv::goodFeaturesToTrack(image,corners,

250, // 返回的最大特征点的数目

0.01, // 质量等级

8); // 两点之间的最小允许距离

// 遍历所有特征点并画圆圈

std::vector<cv::Point2f>::const_iterator it= corners.begin();

while (it!=corners.end())

{

cv::circle(image, *it, 3, cv::Scalar(255,255,255), 2);

++it;

}

// 显示输出结果

cv::namedWindow("Good Features to Track");

cv::imshow("Good Features to Track",image);

~~~

返回生成的结果:

可以看到,该方法显著改进了特征点的分布情况,但是这样也增加了检测的复杂度,因为要求特征点要安装Harris的得分进行排序。该函数也可以指定一个可选的参数,使得按照经典的焦点分数定义进行计算。

其中,cv::goodFeaturesToTrack函数拥有一个封装类cv::GoodFeatureToTrackDetector,它继承自cv::FeaturesDetector类。其用法与以上的Harris类相类似:

~~~

// 特征点向量

std::vector<cv::KeyPoint> keypoints;

cv::goodFeaturesToTrackDetector gftt(

250, // 返回的最大特征点的数目

0.01, // 质量等级

8); // 两点之间的最小允许距离

// 使用FeatureDetector的函数进行检测

gftt.detect(image, keypoints);

~~~

结果与先前得到的结果是一样的,因为它们调用的是同一个函数。

本节的代码下载地址:[http://download.csdn.net/detail/liyuefeilong/8483013](http://download.csdn.net/detail/liyuefeilong/8483013)

关于Harris的理论研究有待进一步研究……

OpenCV2学习笔记(九)

最后更新于:2022-04-01 06:36:05

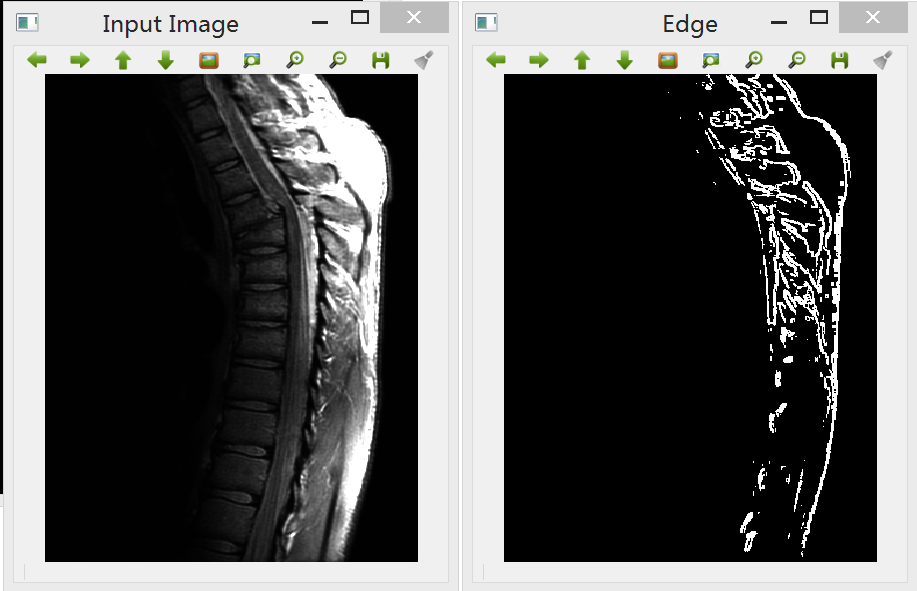

##视频流读取与处理

由于项目需要,计划实现九路视频拼接,因此必须熟悉OpenCV对视频序列的处理。视频信号处理是图像处理的一个延伸,所谓的视频序列是由按一定顺序进行排放的图像组成,即帧(Frame)。在这里,主要记录下如何使用Qt+OpenCV读取视频中的每一帧,之后,在这基础上将一些图像处理的算法运用到每一帧上(如使用Canny算子检测视频中的边缘)。

一. 读取视频序列

OpenCV提供了一个简便易用的框架以提取视频文件和USB摄像头中的图像帧,如果只是单单想读取某个视频,你只需要创建一个cv::VideoCapture实例,然后在循环中提取每一帧。新建一个Qt控制台项目,直接在main函数添加:

~~~

#include <QCoreApplication>

#include <opencv2/core/core.hpp>

#include <opencv2/imgproc/imgproc.hpp>

#include <opencv2/highgui/highgui.hpp>

#include <QDebug>

int main(int argc, char *argv[])

{

QCoreApplication a(argc, argv);

// 读取视频流

cv::VideoCapture capture("e:/BrokeGirls.mkv");

// 检测视频是否读取成功

if (!capture.isOpened())

{

qDebug() << "No Input Image";

return 1;

}

// 获取图像帧率

double rate= capture.get(CV_CAP_PROP_FPS);

bool stop(false);

cv::Mat frame; // 当前视频帧

cv::namedWindow("Extracted Frame");

// 每一帧之间的延迟

int delay= 1000/rate;

// 遍历每一帧

while (!stop)

{

// 尝试读取下一帧

if (!capture.read(frame))

break;

cv::imshow("Extracted Frame",frame);

// 引入延迟

if (cv::waitKey(delay)>=0)

stop= true;

}

return a.exec();

}

~~~

(注意:要正确打开视频文件,计算机中必须安装有对应的解码器,否则cv::VideoCapture无法理解视频格式!)运行后,将出现一个窗口,播放选定的视频(需要在创建cv::VideoCapture对象时指定视频的文件名)。

二. 处理视频帧

为了对视频的每一帧进行处理,这里创建自己的类VideoProcessor,其中封装了OpenCV的视频获取框架,该类允许我们指定每帧调用的处理函数。

首先,我们希望指定一个回调处理函数,每一帧中都将调用它。该函数接受一个cv::Mat对象,并输出处理后的cv::Mat对象,其函数签名如下:

~~~

void processFrame(cv::Mat& img, cv::Mat& out);

~~~

作为这样一个处理函数的例子,以下的Canny函数计算图像的边缘,使用时直接添加在mian文件中即可:

~~~

// 对视频的每帧做Canny算子边缘检测

void canny(cv::Mat& img, cv::Mat& out)

{

// 先要把每帧图像转化为灰度图

cv::cvtColor(img,out,CV_BGR2GRAY);

// 调用Canny函数

cv::Canny(out,out,100,200);

// 对像素进行翻转

cv::threshold(out,out,128,255,cv::THRESH_BINARY_INV);

}

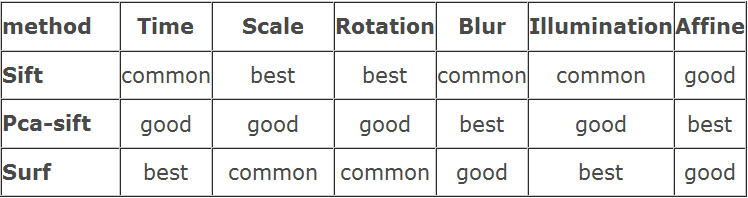

~~~